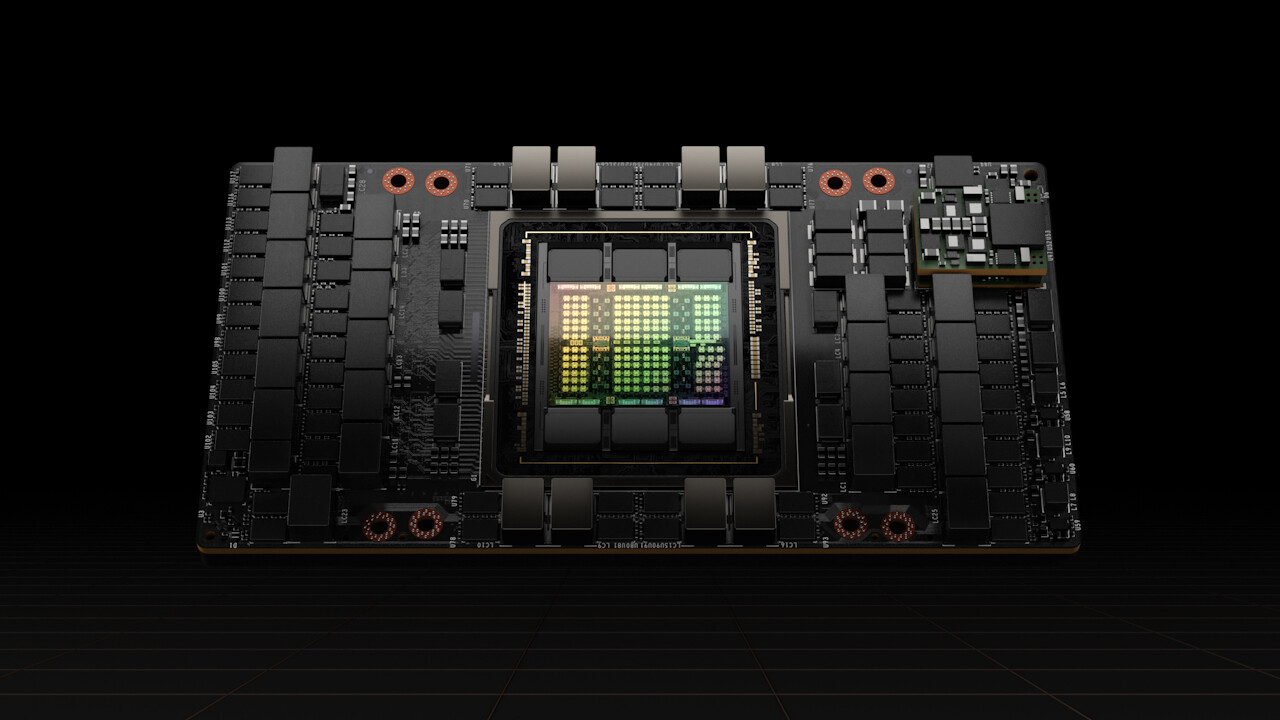

Nvidia H20: AI-Beschleuniger für China kostet deutlich weniger

In China nimmt Nvidia für den in der Leistung reduzierten AI-Beschleuniger H20 jetzt Vorbestellungen zu deutlich niedrigeren Preisen als beim H100 oder künftigen GH200 an. Für den rund halben Preis im Vergleich zum Modell für den Westen, das keine Beschränkungen aufweist, gibt es jedoch deutlich weniger als die halbe Leistung.

Der AI-Beschleuniger H20 ist das Resultat der US-Handelsrestriktionen gegenüber China und nicht der erste Versuch seitens Nvidia, mit beschnittenen AI-Beschleunigern dennoch auf dem chinesischen Markt präsent zu bleiben. Zunächst hatte Nvidia mit H800 und A800 als Alternativen zum vollwertigen H100 und A100 auf die Wirtschaftssanktionen reagiert. Als aber auch diese Modelle auf die Schwarze Liste der US-Regierung kamen, hatte Nvidia Ende 2023 mit H20 sowie L20 und L2 weitere Konfigurationen in der Hinterhand, die mit abermals weniger KI-Leistung gen Osten exportiert werden konnten.

Nvidia H20 ab 12.000 US-Dollar

Wie die South China Morning Post mit Verweis auf Industriekreise berichtet, könne der H20-Beschleuniger jetzt zu Preisen von umgerechnet 12.000 bis 15.000 US-Dollar vorbestellt werden und soll im zweiten Quartal dieses Jahres ausgeliefert werden. Zum Vergleich: Für den H100 wird ein Preis von rund 30.000 US-Dollar genannt. Aufgrund der hohen Nachfrage sollen auf dem Graumarkt teilweise auch Preise von bis zu 40.000 US-Dollar erzielt werden. Hierzulande muss bei einer H100-PCIe-Karte mit 35.000 Euro gerechnet werden.

H20-Server für knapp 200.000 US-Dollar

Ein High-End-Server mit acht H20-Karten liegt der chinesischen Zeitung zufolge bei rund 196.000 US-Dollar. Schaut man sich hingegen auf dem westlichen Markt bei einem Anbieter wie Lambda für einen H100-Server um, liegt der Preis je nach CPU- und RAM-Bestückung bei rund 350.000 US-Dollar vor Steuern. In Deutschland gibt es entsprechende Systeme für leicht über 360.000 Euro inklusive Mehrwertsteuer.

Sowohl für den AI-Beschleuniger selbst als auch für einen vollständigen Server müssen chinesische Interessenten somit deutlich weniger als westliche Konzerne zahlen. Zwischen H20 und H100 klafft allerdings auch eine große Lücke hinsichtlich der gebotenen Leistung, die das übersteigt, was Nvidia im Gegenzug beim Preis nachlässt.

Modelle für den Westen sind deutlich schneller

Im Vergleich zwischen H20 und H100 als SXM-Modul für einen HGX-Server mag der H20 auf den ersten Blick zwar mehr Speicher und eine höhere Speicherbandbreite bieten, nämlich 96 GB vs. 80 GB und 4,0 TB/s vs. 3,35 TB/s, aber bei der Rechenleistung zieht der H100 unabhängig von der gewählten Genauigkeit eindeutig davon. Bei INT8 und FP8 Tensor Core gibt es zum Beispiel lediglich noch 296 TFLOPS statt 3.958 TFLOPS (mit Sparsity-Beschleunigung). Bei TF32 Tensor Core stehen 74 TFLOPS ursprünglich 989 TFLOPS gegenüber. Und bei FP32 und FP64 sind es gar nur 44 TFLOPS und 1 TFLOPS anstelle von 67 TFLOPS und 34 TFLOPS. Es ist demnach nicht so, dass die China-Konfiguration für den rund halben Preis noch die halbe Leistung, sondern signifikant weniger bietet.

Und wer bei Nvidia mehr Speicher respektive Speicherbandbreite benötigt, hat diese Optionen auch im Westen. Beim H100 NVL mit zwei GPUs gibt es gleich 188 GB und 7,8 TB/s, also 94 GB und 3,9 TB/s pro GPU, und beim GH200 mit angedockter Arm-CPU gönnt Nvidia einer einzelnen GPU gleich 141 GB mit 5 TB/s. Weder H100 NVL noch GH200 bietet Nvidia in für den chinesischen Markt angepassten Konfigurationen an.