Google Ironwood (TPU v7p): Neuer KI-Chip für FP8 mit 192 GByte HBM3 und ~1.000 Watt

Google hat mit Ironwood alias v7p die siebte Generation einer eigenen TPU vorgestellt. Sie ist aber eher der Nachfolger der TPU v5p statt von Trillium alias v6e, wenngleich das Unternehmen diese für einige fragwürdige Vergleiche heranzieht. Die Einsatzgebiete der e- und p-Lösungen sind jedoch mitunter extrem unterschiedlich.

Abermals deutlich schneller

Für die eigenen Cloud-Systeme entwickelt Google schon seit Jahren eigene Chips. Die TPUs sind seit 2017 ein integraler Bestandteil davon. Die neueste Lösung liefert in neuen Tests wie mit FP8-Genauigkeit nun die 3.600-fache Leistung der ersten Lösung, die auch für Kunden zur Verfügung stand: TPU v2. FP8-Unterstützung gab es damals noch nicht, die Vergleiche sind deshalb ähnlich skeptisch zu nehmen, wie Nvidias Aussagen zu den Leistungsgewinnen über Generationen hinweg.

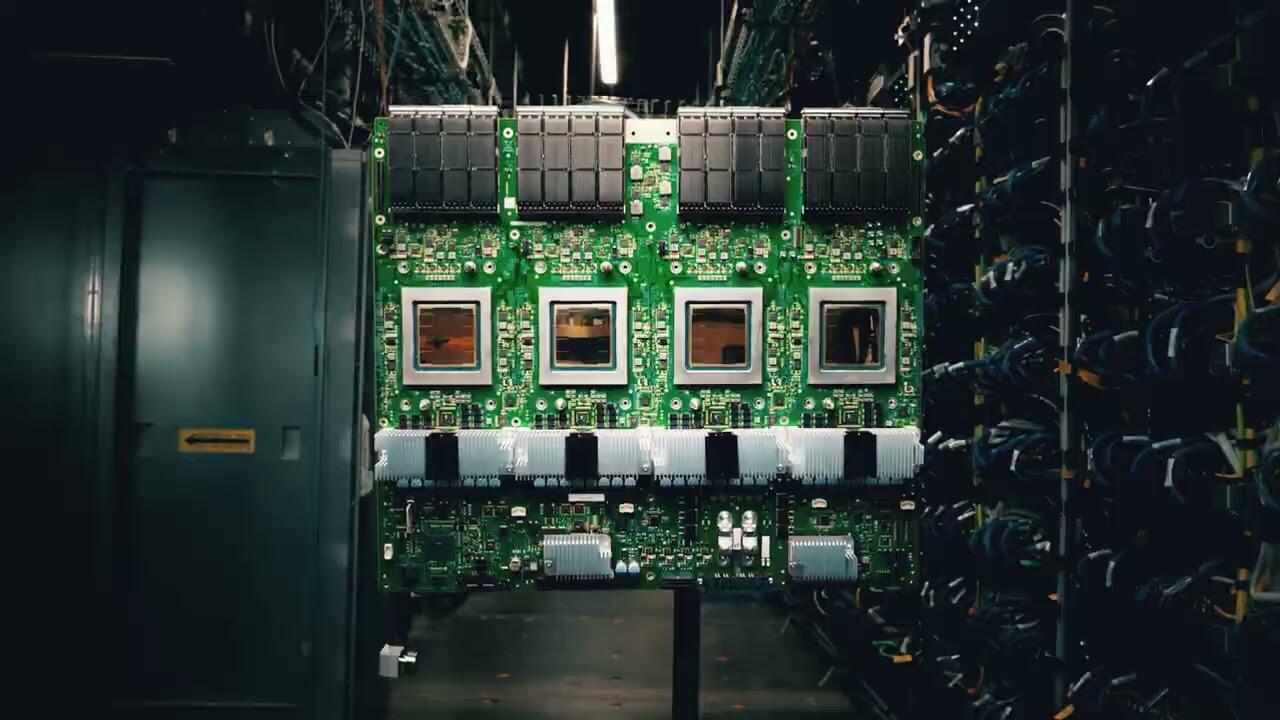

Google setzt auf Chiplets

Wie das Bild der Chips verdeutlicht, setzt auch Google nicht mehr auf ein monolithisches Design. Erkennbar sind folglich zwei Chips in der Mitte des Packages, flankiert von acht HBM-Bausteinen. Die TPU ist für Inferencing (die Arbeit mit trainierten AI-Modellen) ausgelegt, Training kann der Chips aber auch. Bei Large Language Modells (LLMs) oder der AI-Bilderstellung spielt die Skalierung eine große Rolle, durch das FP8-Format soll dies dabei auch möglichst effizient ablaufen.

Da der Chip aber eine Nummer größer ist, gilt dies trotz vermuteter 3-nm-Fertigung höchstwahrscheinlich auch für den Verbrauch. Anhand der bereitgestellten Daten lässt sich auf eine TDP von knapp 1.000 Watt schließen, v5p als eigentlicher Vorgänger brachte es auf 540 Watt.

Da Google zum Auftakt mit technischen Daten geizt, sind die Werte zum Teil aus Aussagen wie „1,5x von Trillium“ und anderen hochgerechnet.

| v5e | v5p | Trillium (v6e) | Ironwood (v7p) | |

|---|---|---|---|---|

| Bfloat16 | 197 TFLOPS | 459 TFLOPS | 918 TFLOPS | 2.307 TFLOPS |

| Int8/FP8 | nicht verfügbar | 393 TOPS/459 TFLOPS | 1.836 TOPS/? | ?/4.614 TFLOPS |

| High Bandwidth Memory (HBM) | 16 GByte | 95 GByte | 32 GByte | 192 GB |

| Speicherbandbreite | 820 GByte/s | 2.765 GByte/s | 1.640 GByte/s | 7.372 GByte/s |

| Chip-zu-Chip-Verbindung | 1.600 GBit/s | 4.800 GBit/s | 3.584 GBit/s | 5.378 GBit/s |

| Chips pro Pod | 256 | 8.960 | 256 | 9.216 |

Von v5p auf v7p ist der Zuwachs kleiner

Die weiteren Vergleiche von Ironwood (v7p) mit Trillium (v6e) stehen dabei im Gegensatz zu dem, was Google auch als Schaubild mitliefert. Denn dass die p-Lösung unter anderem beim HBM-Ausbau punkten kann, den Google mit dem Faktor 6 beziffert, ist gar nicht neu. Solche Unterschiede gab es zwischen p- und e-Varianten auch in der Vergangenheit – v5e hatte beispielsweise nur 16 GB HBM, v5p schon 95 GByte. Wird die TPU v5p als Vergleich herangezogen, ist der Ausbau lediglich verdoppelt worden.

Auch die Speicherbandbreite steigt nur von Ironwood zu Trillium um den Faktor 4,5, gegenüber v5p ist der Anstieg deutlich geringer, wenngleich aber immer noch markant. Die TPU v5p setzte aber auch noch auf HBM2e, hier dürfte vor allem der Umstieg auf HBM3(e?) mit eben auch die größere Kapazität für diese Zuwächse sorgen. Auch die ausgewiesenen TFLOPS gehen in diese Richtung: Bei v5p mussten diese für FP8 hochgerechnet werden, erst bei v7p wird der Standard über zusätzliche TensorCores und SparseCores unterstützt – das erklärt den massiven Sprung.

Verfügbar sollen die ersten Systeme später in diesem Jahr werden. Behält Google die hohe Schlagzahl bei, wird spätestens in einem Jahr ein weiterer Ableger folgen.