RTX-3000-Technik im Detail: RTX, 8K DLSS, FE-Kühler und Specs

2/2Schnellere RT-Kerne beherrschen Motion Blur

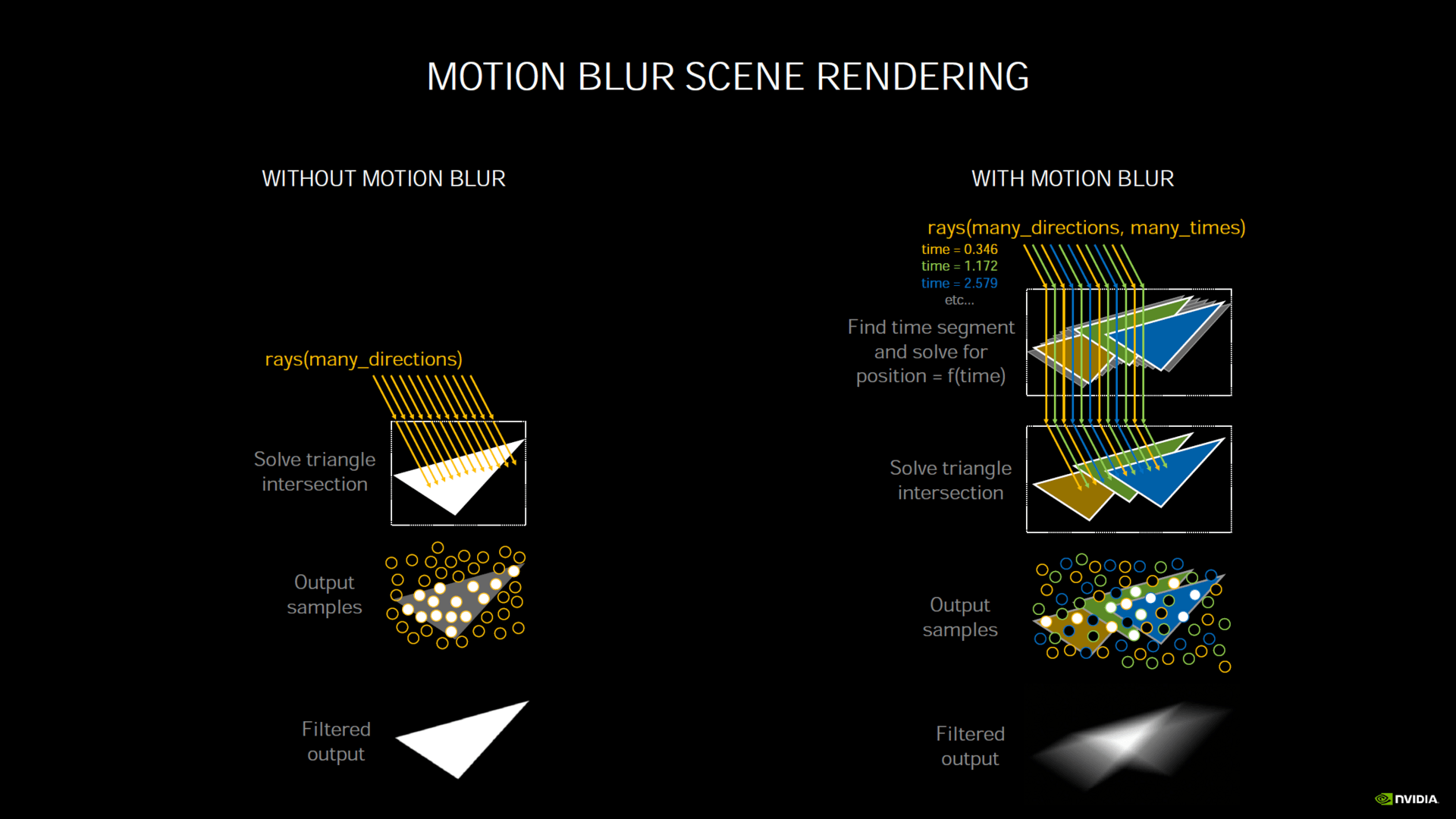

Losgelöst von den klassischen Shadern verspricht Nvidia auch für die Raytracing-Kerne einen satten Leistungsschub. Die Schnittstellenprüfung (Ray Traversal) sollen sie sogar doppelt so schnell beherrschen. Das war laut Nvidia die größte Schwachstelle von Turings RT-Kernen. Darüber hinaus kann die zweite Generation der RT-Kerne nun Raytracing mit Motion Blur berechnen, was bei Turing effektiv nicht möglich gewesen ist. Nvidia empfahl oft, Raytracing und Motion Blur nicht parallel zu aktivieren. RT-Kerne in Ampere sollen das jetzt mit einer um den Faktor 8 angehobenen Geschwindigkeit ermöglichen.

Das Problem bei Raytracing mit Motion Blur ist, dass ein Dreieck keine feste Position hat, stattdessen ist die Position zeitabhängig. Das Dreieck hat zu jeder Zeit eine andere Position, jeder abgeschossene Strahl sucht sich jedoch irgendeine Zeit aus und bei mehreren Strahlen gibt es immer mehrere Zeitpunkte. Um eine Raytracing-Berechnung mit Bewegungsunschärfe zu erhalten, müssen sie in einen Zusammenhang gebracht werden – ein Vorgang, den Turing nicht beschleunigen konnte, Ampere jetzt aber schon.

Nicht nur Spiele, sondern auch Anwendungen können davon profitieren. Für den freien Raytracing-Renderer Blender nennt Nvidia einen Leistungsschub um den Faktor 5 beim Rendern einer Szene mit Motion Blur, ohne Motion Blur werden durch die Bank Leistungszuwächse von 70 bis 130 Prozent in Aussicht gestellt.

Weniger, aber deutlich stärkere Tensor-Kerne in Ampere

Auf Turing verfügt jeder SM über 8 Tensor-Kerne. Bei Ampere sind es sowohl bei der professionellen GA100-GPU als auch bei den Gaming-Ablegern nur noch deren 4, die KI-Leistung ist aber trotzdem doppelt so hoch. Jeder Tensor-Kern ist damit 4 Mal so leistungsfähig wie auf Turing. Das hat zur Folge, dass selbst die GeForce RTX 3070 eine massiv höhere „KI-Leistung“ bietet als die GeForce RTX 2080 Ti.

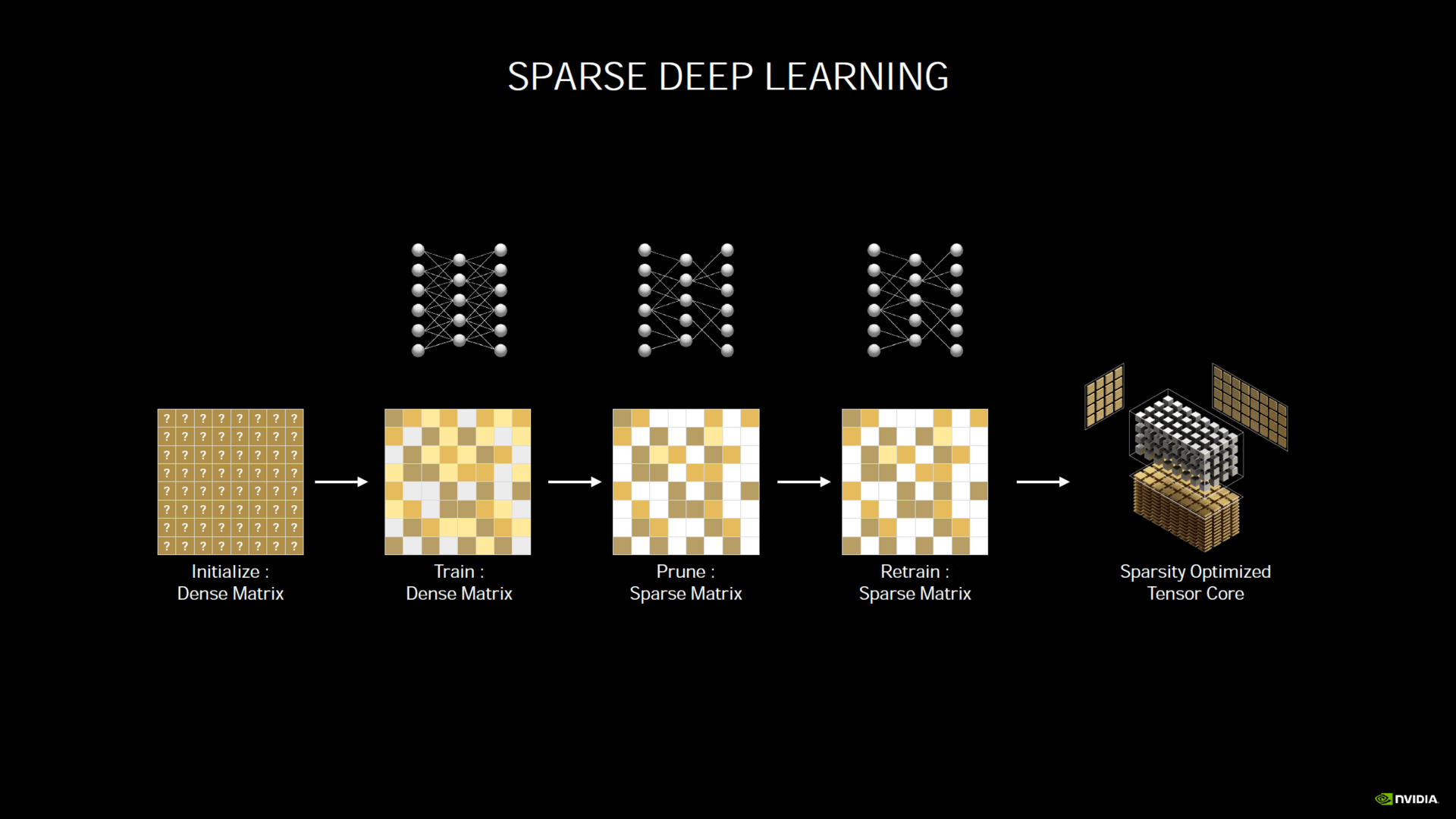

Vom professionellen Ampere ebenfalls übernommen wurde das „Sparsity“-Feature. Dieses basiert darauf, dass viele Matrizen in neuronalen Netzen spärlich sind (also viele Nullen beinhalten). Parameter, deren Wert 0 ist, sind für das neuronale Netz irrelevant und verbrauchen daher nur unnötig Speicherplatz und Rechenkapazität. Die Tensor-Kerne können automatisch 50 Prozent der Parameter eines bereits trainierten neuronalen Netzes verwerfen/ignorieren und die Inferenz somit um den Faktor 2 beschleunigen.

DLSS für 8K und Creative Apps

Nvidia bewirbt die GeForce RTX 3090 als „8K DLSS Grafikkarte“. Anspuchslose Titel kann die Grafikkarte nativ in dieser Auflösung berechnen, die meisten Spiele werden aber nicht schnell genug laufen. Doch DLSS, das mit GeForce RTX eingeführte und auf den Tensor-Kernen berechnete KI-Upscaling, soll es möglich machen. Der Fortschritt fand in diesem Fall aber nicht nur in der Ampere-GPU statt.

Nvidia hat das neuronale Netzwerk von DLSS für die 8K-Auflösung mit dem Ziel trainiert, eine bessere Grafik als mit nativem Ultra HD zu erreichen. Die Grafikkarte rendert bei 8K DLSS mit einer Auflösung von 2.560 × 1.440 und das neuronale Netzwerk rechnet die Auflösung dann um den Faktor 9 hoch. Das ist bis dato der mit Abstand größte Faktor, den DLSS hochrechnet – DLSS bei Ultra HD ist nur Faktor 4. Inwieweit das Bild mit nativem 8K vergleichbar ist, wird die Redaktion beizeiten testen. Falls das neuronale Netz den deutlich höheren Faktor genauso gut verkraftet wie einen geringeren, könnte das Endergebnis durchaus vergleichbar mit nativem 8K sein – DLSS 2.0 hatte zuletzt gravierende Fortschritte gemacht.

Mit GeForce RTX 3000 hält nicht nur 8K DLSS in Spielen, sondern generell DLSS in Anwendungen Einzug. Schon bisher konnten Programme wie Maya mit Arnold oder Blender die Tensor-Kerne für Denoising in der Vorschau nutzen, in Zukunft soll die Vorschau aber auch mit DLSS beschleunigt werden können. Den Anfang wird D5 Render machen. Zu weiteren Programmen macht Nvidia auch auf Nachfrage noch keine Angaben. DLSS in Anwendungen kommt für beide Generationen GeForce RTX.

Abseits von DLSS sollen die meisten, bisher von GeForce RTX profitierenden Anwendungen zum Start von GeForce RTX 3000 bereits kompatibel sein, so der Hersteller zum Tech Day. Neue Funktionen werden aber erst nach etwaigen Updates (der verwendeten CUDA-Version) unterstützt.

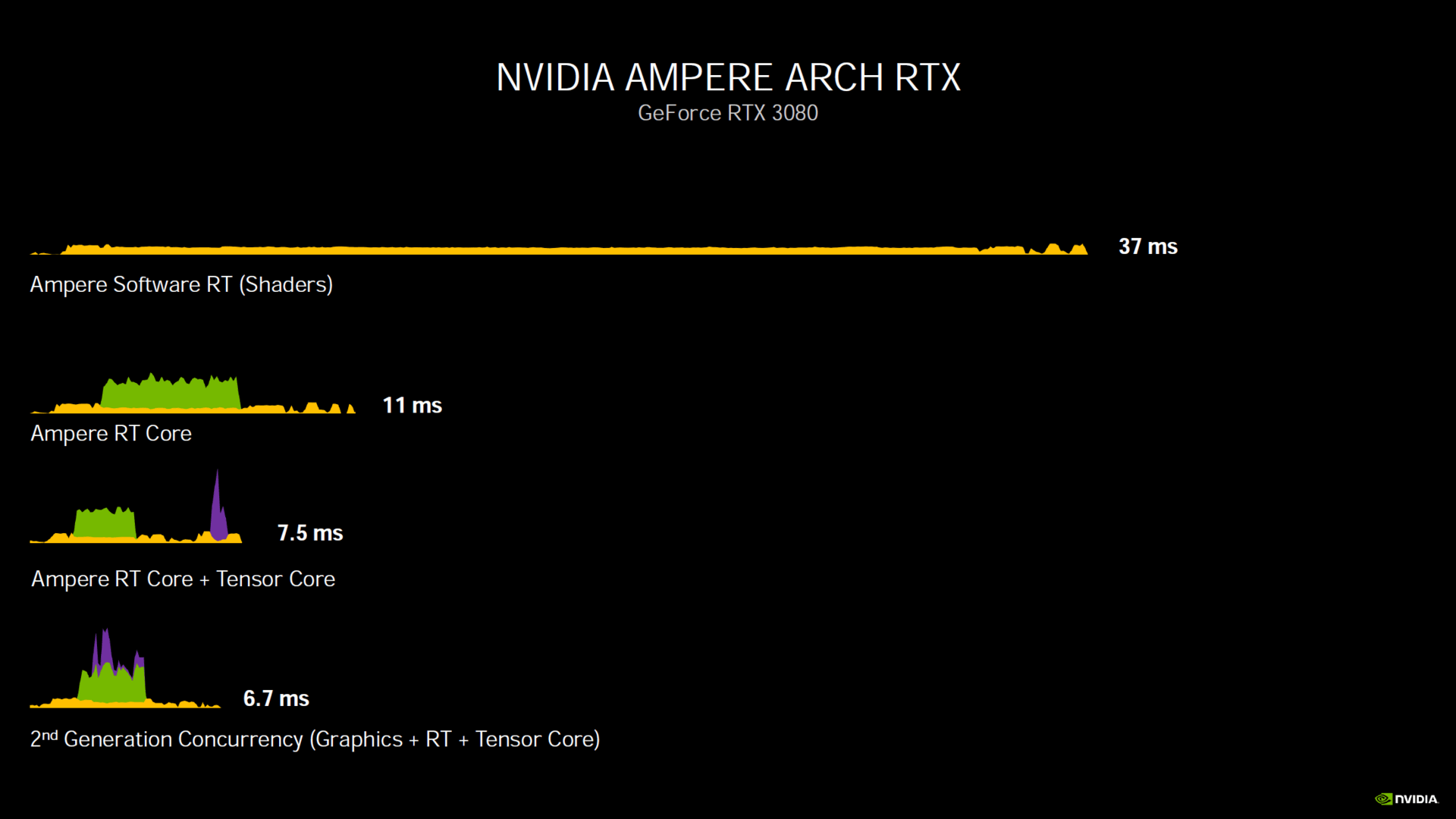

Ampere kann Shading, Raytracing und KI gleichzeitig

Turing konnte entweder gleichzeitig die FP32-ALUs und die Raytracing-Kerne nutzen oder die FP32-ALUs und die Tensor-Kerne. Alle drei Einheiten gleichzeitig konnten dagegen nicht betrieben werden. Ampere kann das jetzt. Das geschieht jedoch nicht automatisch, dafür muss das Spiel angepasst werden.

Ein Beispiel zeigt die Vorteile

Wolfenstein: Youngblood wird als einer der ersten Titel solch eine Anpassung erhalten. Wie sie sich auswirken soll, stellt Nvidia anhand eigener Messwerte in Aussicht.

Nvidia beginnt mit einem in der Praxis wenig relevanten Fall: Der Berechnung eines Frames mit Software-Raytracing, also alleine auf den Shadereinheiten ohne RT-Kerne. Die GeForce RTX 2080 schafft das in 51 Millisekunden (19,6 FPS). Mit den RT-Kernen ist das Bild in 19 ms (52,6 FPS) fertig, da ALUs und RT-Kerne parallel rechnen. Kommt nun noch DLSS oben drauf, liegt der Wert bei 13 ms (76,9 FPS).

Auf einer GeForce RTX 3080 ist derselbe Frame bei „Software-Raytracing“ in 37 ms (27 FPS) fertig. Mit den Hardware-Einheiten sind es 11 ms (90,9 FPS) und mit DLSS 7,5 ms (133,3 FPS) – wenn DLSS ebenfalls asynchron angewandt wird. Wird DLSS gleichzeitig mit den zwei anderen Berechnungen angegangen, ist das Frame nach 6,7 ms (149,3 FPS) fertiggestellt.

| Software RT | Hardware RT | DLSS | DLSS synchron | |

|---|---|---|---|---|

| GeForce RTX 2080 | 51 ms (19,6 FPS) | 19 ms (52,6 FPS) | 13 ms (76,9 FPS) | Nicht möglich |

| GeForce RTX 3080 | 37 ms (27,0 FPS) | 11 ms (90,9 FPS) | 7,5 ms (133,3 FPS) | 6,7 ms (149,3 FPS) |

| Differenz | +38 % | +73 % | +73 % | +94 % (zu normalem DLSS) |

Shader, RT- und Tensor-Kerne parallel rechnen lassen zu können, bringt in diesem Beispiel also einen weiteren Leistungsschub von 21 Prozentpunkten. In dem von Nvidia präsentierten Szenario liegt die GeForce RTX 3080 am Ende 94 Prozent vor der GeForce RTX 2080.

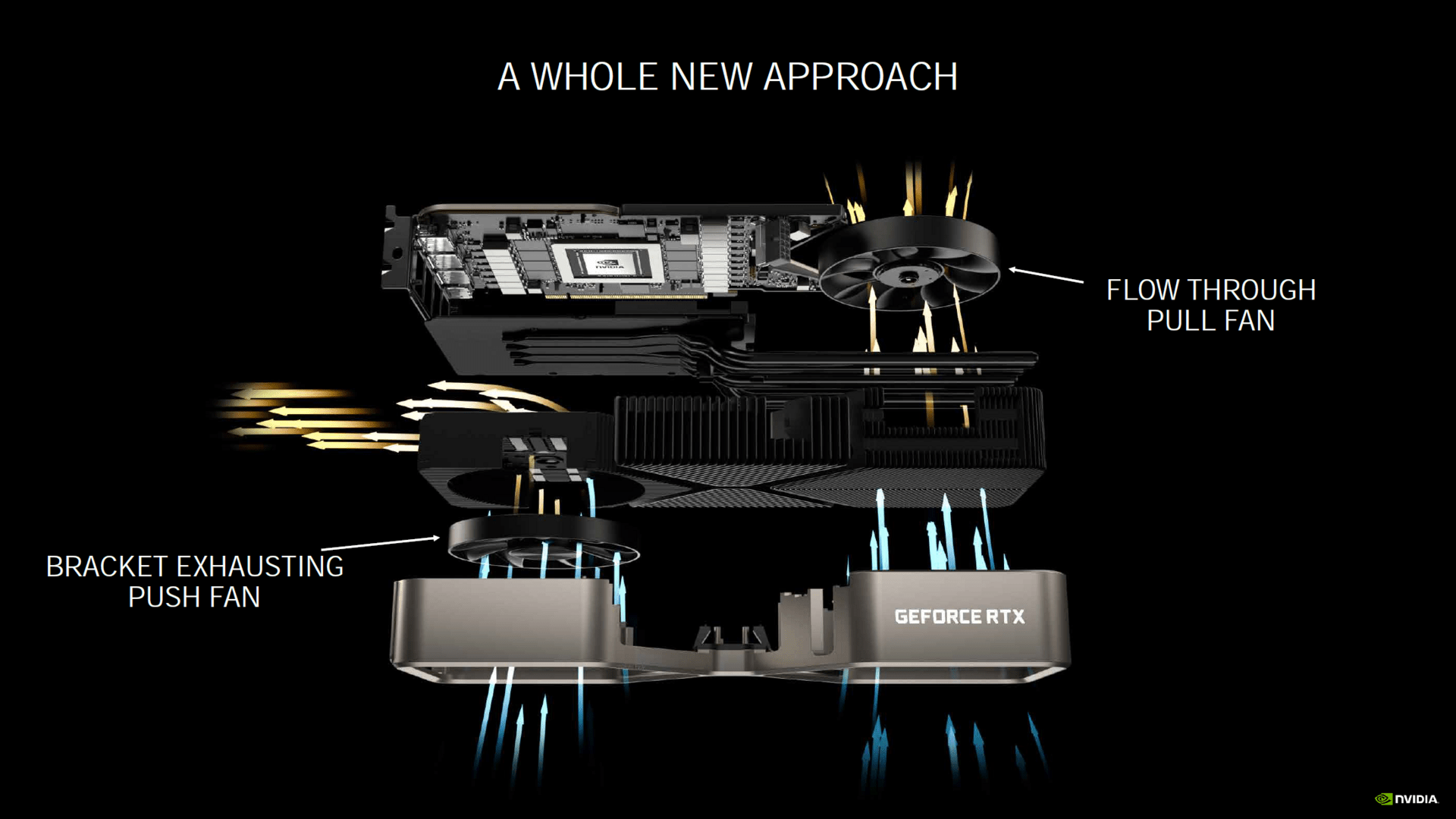

Neue Details zur Founders Edition

Nvidia hat zum Tech Day auch ein paar neue Informationen zum Kühler der Founders Edition bekanntgegeben. Das kurze PCB der Founders Edition ist demnach aus der Motivation heraus entstanden, mehr Raum für den Kühler zu schaffen. Ein anderer Grund waren die kürzeren Signalwege, die für GDDR6X, PCIe 4.0 und HDMI 2.1 von Vorteil sind.

Kühler und leiser zugleich

Viele Details zum Kühler hat ComputerBase bereits im Artikel Nvidia GeForce RTX 3000: Der innovative Kühler der Founders Edition zusammengetragen. Nvidia hat mittlerweile aber konkrete Zahlen zu dessen Leistungsfähigkeit veröffentlicht.

Demzufolge soll der neue Founders-Edition-Kühler die Grafikkarten nicht nur kühler halten, sondern zugleich leiser agieren. Nvidia gibt an, dass der Kühler der GeForce RTX 3080 Founders Edition bei identischer Leistungsaufnahme von 320 Watt bei gleicher Lautstärke 20 Grad kühler oder bei gleicher Temperatur 10 dB leiser arbeitet als das Pendant auf der GeForce RTX 2080 FE. Wird die GeForce RTX 2080 FE mit den Werkseinstellungen von 225 Watt betrieben, fallen die Unterschiede geringer aus, bleiben aber immer noch vorhanden: 78°C bei 30 dB auf der RTX 3080 stehen 81°C bei 32 dB auf der RTX 2080 gegenüber.

Der Kühler der GeForce RTX 3090 FE funktioniert genauso wie das Pendant der GeForce RTX 3080 FE, ist aber deutlich größer (3 Slots anstatt 2 Slots und länger). Bei 350 Watt ist die GeForce RTX 3090 bei gleicher Temperatur 20 Dezibel leiser oder bei gleicher Lautstärke 30 Grad kühler als die GeForce RTX 2080 Ti FE. Doch auch hier gilt, dass der Kühler der GeForce RTX 2080 Ti FE eben keine 350 Watt abführen muss, die Unterschiede werden in der Praxis also deutlich geringer sein – konkrete Zahlen nennt Nvidia nicht.

Bekannte Spezifikationen im Überblick

So viel zu den Architektur-Änderungen bei Ampere. Mit den neuen Informationen hat sich das Bild über die GeForce-RTX-3000-Serie weiter gefestigt. Mit dem neuen Wissen hat die Redaktion die Tabelle mit den Spezifikationen der GeForce RTX 3090, GeForce RTX 3080 sowie GeForce RTX 3070 korrigiert und vervollständigt.

| RTX 3090 | RTX 3080 | RTX 3070 | RTX 2080 Ti | |

|---|---|---|---|---|

| Architektur | Ampere | Turing | ||

| GPU | GA102 | GA104 | TU102 | |

| Prozess | Samsung 8 nm Custom-Prozess | 12 nm TSMC | ||

| Chipgröße | 628 mm | 393 mm² | 754 mm² | |

| Transistoren | 28 Mrd. | 17,4 Mrd. | 18,6 Mrd. | |

| GPC | 7 | 6 | 6 | 6 |

| SM | 82 | 68 | 46 | 68 |

| FP32-ALUs pro SM | 128 | 64 | ||

| FP32-ALUs | 10.496 | 8.704 | 5.888 | 4.352 |

| RT-Kerne | 82 2nd Gen | 68 2nd Gen | 46 2nd Gen | 68 1st Gen |

| RT-Kerne + ALUs synchron | Ja | Nein | ||

| Tensor-Kerne | 328 3rd Gen | 272 3rd Gen | 184 3rd Gen | 544 2nd Gen |

| Basis-Takt | 1.400 MHz | 1.450 MHz | 1.500 MHz | 1.350 MHz |

| Boost-Takt | 1.700 MHz | 1.710 MHz | 1.730 MHz | 1.545 MHz |

| FP32-Leistung | 35,7 TFLOPS | 29,8 TFLOPS | 20,4 TFLOPS | 13,4 TFLOPS |

| FP16-Leistung | 35,7 TFLOPS | 28,8 TFLOPS | 20,4 TFLOPS | 26,9 TFLOPS |

| FP16-Leistung über Tensor | 143 TFLOPS 285 TFLOPS (Sparsity) |

119 TFLOPS 238 TFLOPS (Sparsity) |

82 TFLOPS 163 TFLOPS (Sparsity) |

107,6 TFLOPS |

| Textureinheiten | 328 | 272 | 184 | 272 |

| ROPs | 112 | 96 | 96 | 88 |

| Speicher | 24 GB GDDR6X | 10 GB GDDR6X | 8 GB GDDR6 | 11 GB GDDR6 |

| Speicher-Geschwindigkeit | 19,5 Gbps | 19,0 Gbps | 14,0 Gbps | 14,0 Gbps |

| Speicher-Interface | 384 Bit | 320 Bit | 256 Bit | 352 Bit |

| Speicher-Bandbreite | 936 GB/s | 760 GB/s | 448 GB/s | 616 GB/s |

| L2-Cache | 6 MB | 5 MB | 4 MB | 6 MB |

| TDP | 350 Watt | 320 Watt | 220 Watt | 250 Watt |

| Slot-Anbindung | PCIe 4.0 | PCIe 4.0 | PCIe 4.0 | PCIe 3.0 |

| UVP | 1.499 Euro | 699 Euro | 499 Euro | 1.259 Euro |

Preise und Termine

Die GeForce RTX 3080 macht den Anfang und wird ab dem 17. September für 699 Euro im Handel stehen. Am 24. September folgt die GeForce RTX 3090, die 1.499 Euro kosten wird. Die GeForce RTX 3070 wird es im Laufe des Oktobers ab 499 Euro zu kaufen geben. Wann das Test-Embargo fällt, hat Nvidia nicht öffentlich gemacht.

ComputerBase hat die Informationen von Nvidia vorab erhalten. Die Informationen wurden unter NDA zur Verfügung gestellt. Die einzige Vorgabe war der frühstmögliche Veröffentlichungszeitpunkt. Eine Einflussnahme des Herstellers auf den Bericht fand nicht statt, eine Verpflichtung zur Veröffentlichung bestand nicht.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.