v_ossi

Commodore

- Registriert

- Juni 2011

- Beiträge

- 4.784

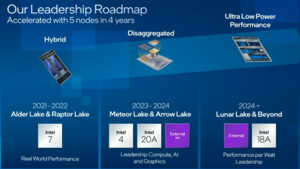

Sehe ich eigentlich kein Problem drin.new-user schrieb:Lunar Lake wird nicht die Mainstream Plattform und Arrow Lake ist das deutlich schwächer aufgestellt.

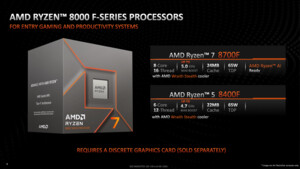

Die APUs müssen halt alles abdecken, darum sind NPU und GPU Leistung wichtig.

Wer sich nen Arrow Lake Desktop hinstellt und ne große NPU braucht, kann sich eine GPU dazustecken und muss keine brachliegende NPU Fläche auf der CPU mit bezahlen.