.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.626

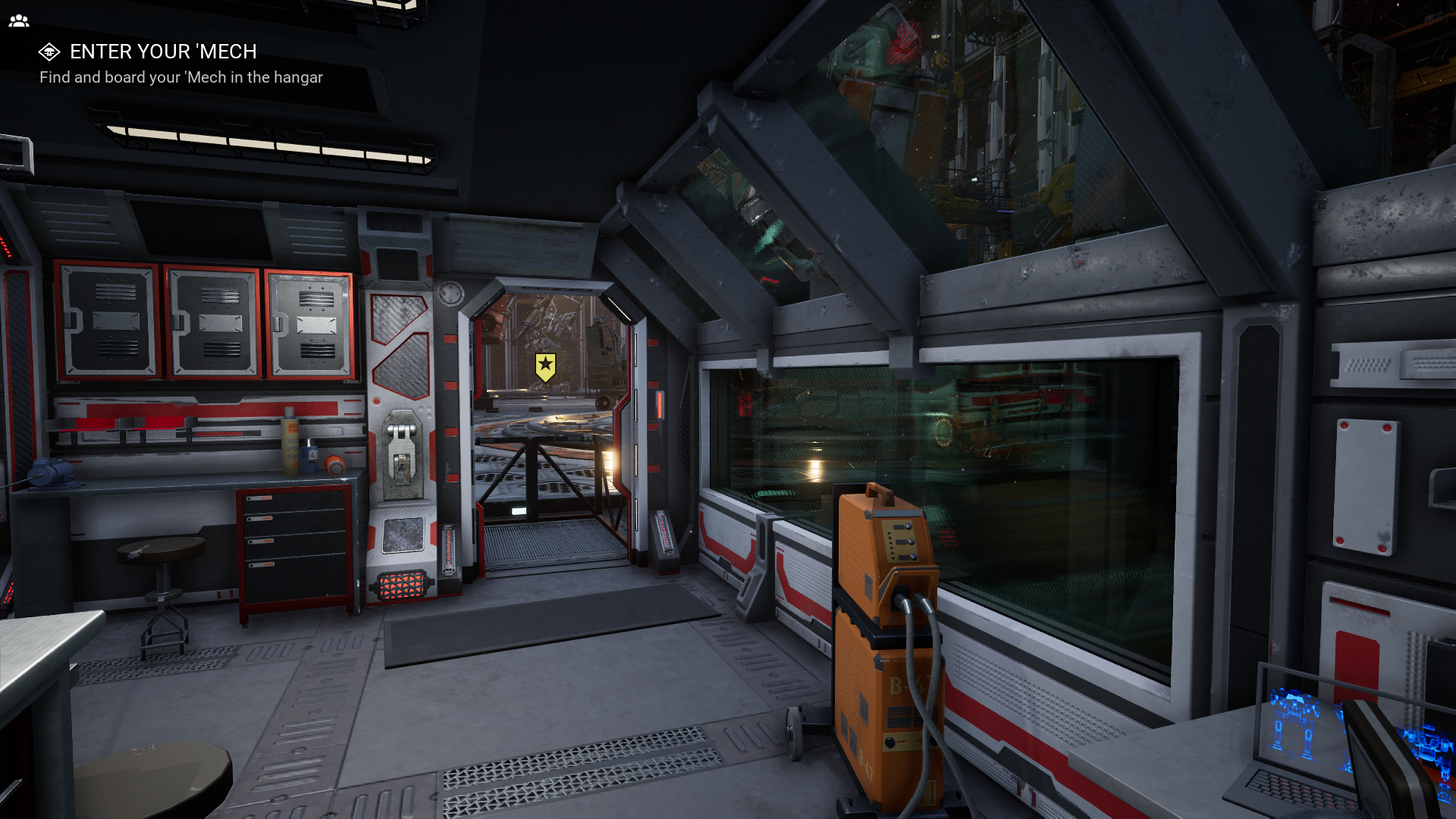

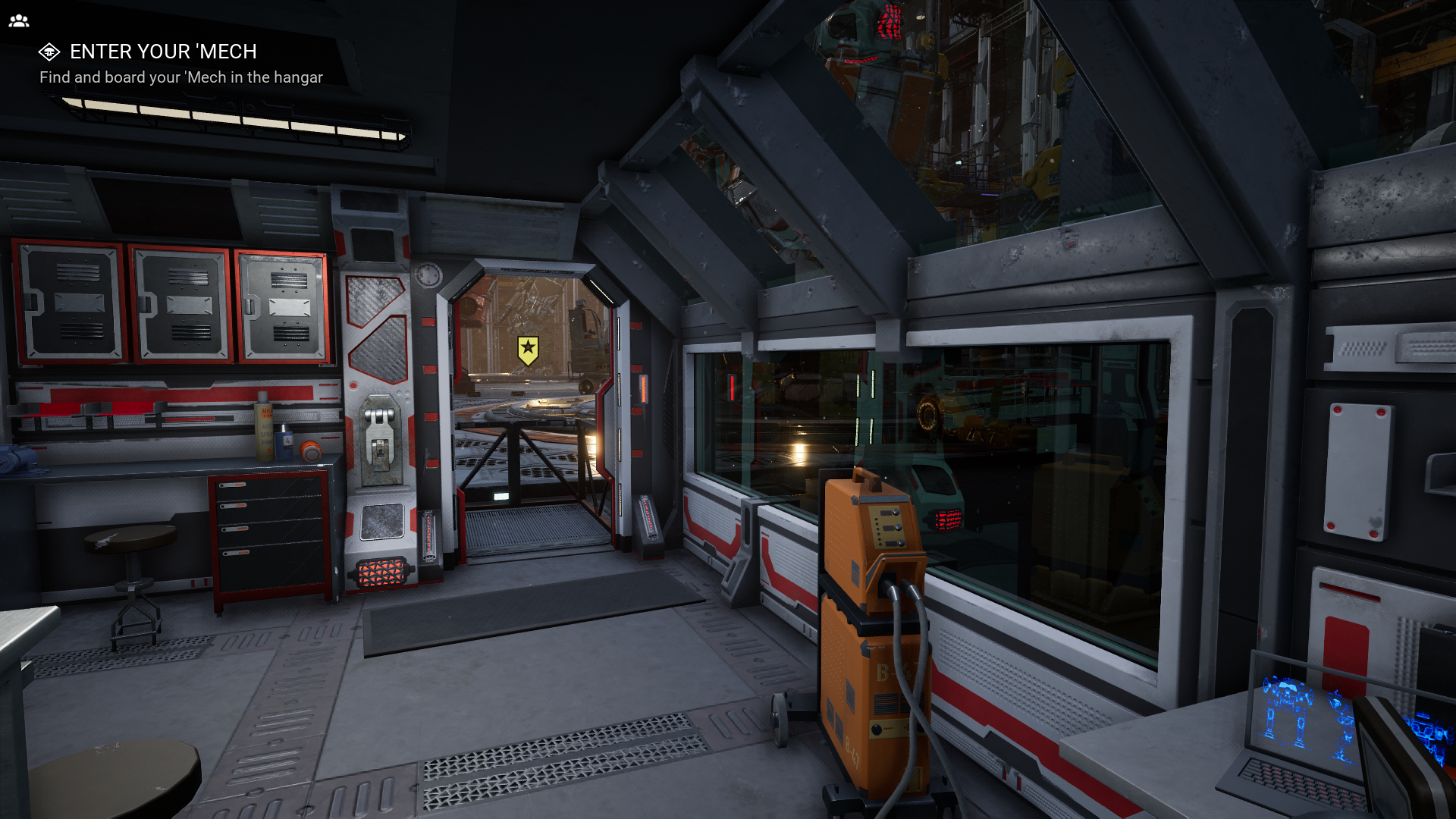

Man kann Raytracing auch ganz subtil einsetzen, wie in Mechwarrior 5 (Integration ist gestern neu dazugekommen und erhebt noch keinen Anspruch auf besondere Qualität/Vollständigkeit).

Da wird einfach die Beleuchtung genauer berechnet- Schatten höher aufgelöst bzw. contact Shadows werden berechnet und die Reflexionen haben keine Fehler mehr und sind nicht mehr blickwinkelabhängig.

Off

On

Off

On

Dieser Ansatz ist doch in ordnung. Fügt sich optimal ins Gesamtbild ein und kostet, was ich bis jetzt gesehen habe, mit DLSS kaum bis keine Leistung...

Raytracing ist ja kein "Effekt", sondern einfach nur eine (rechenaufwändige) Art physikalisch korrekt zu rendern.

LG

Zero

Da wird einfach die Beleuchtung genauer berechnet- Schatten höher aufgelöst bzw. contact Shadows werden berechnet und die Reflexionen haben keine Fehler mehr und sind nicht mehr blickwinkelabhängig.

Off

On

Off

On

Dieser Ansatz ist doch in ordnung. Fügt sich optimal ins Gesamtbild ein und kostet, was ich bis jetzt gesehen habe, mit DLSS kaum bis keine Leistung...

Raytracing ist ja kein "Effekt", sondern einfach nur eine (rechenaufwändige) Art physikalisch korrekt zu rendern.

LG

Zero

Zuletzt bearbeitet: