GeForce GTX 1080 im Test: Ein Paukenschlag in 16 nm mit 1,8 GHz und GDDR5X

Die GeForce GTX 1080: Das neue Nvidia-Flaggschiff

Nvidias CEO Jen Hsun Huang hat zur Vorstellung der ersten Grafikkarten mit GPU der Generation Pascal im Mai abermals nicht mit Superlativen gegeizt: GeForce GTX 1080 sowie GeForce GTX 1070 sollen alle Vorgänger inklusive der GeForce GTX Titan X in jeglicher Hinsicht weit übertreffen. Keine unüblichen Versprechen bei einer Produktvorstellung.

Im Test muss sich die GeForce GTX 1080 Founders Edition jetzt in der Praxis beweisen. Das Hauptaugenmerk liegt neben klassischen Benchmarks in einem neuen Testparcours auf zahlreichen weitere Testreihen: Energieeffizienz, Lautstärke, DirectX 12 und neue Funktionen von Pascal stehen auf dem Prüfstand.

Kurzzusammenfassung: Die GeForce GTX 1080 ist zweifelsohne die neue Oberliga. Und das gilt auch für den Preis. 789 Euro verlangt Nvidia für das Referenzdesign mit neuem Namen.

Update: Mittlerweile ist der Test der noch schnelleren Nvidia GeForce GTX 1080 Ti Founders Edition auf Computerbase erschienen.

Die Pascal-Architektur

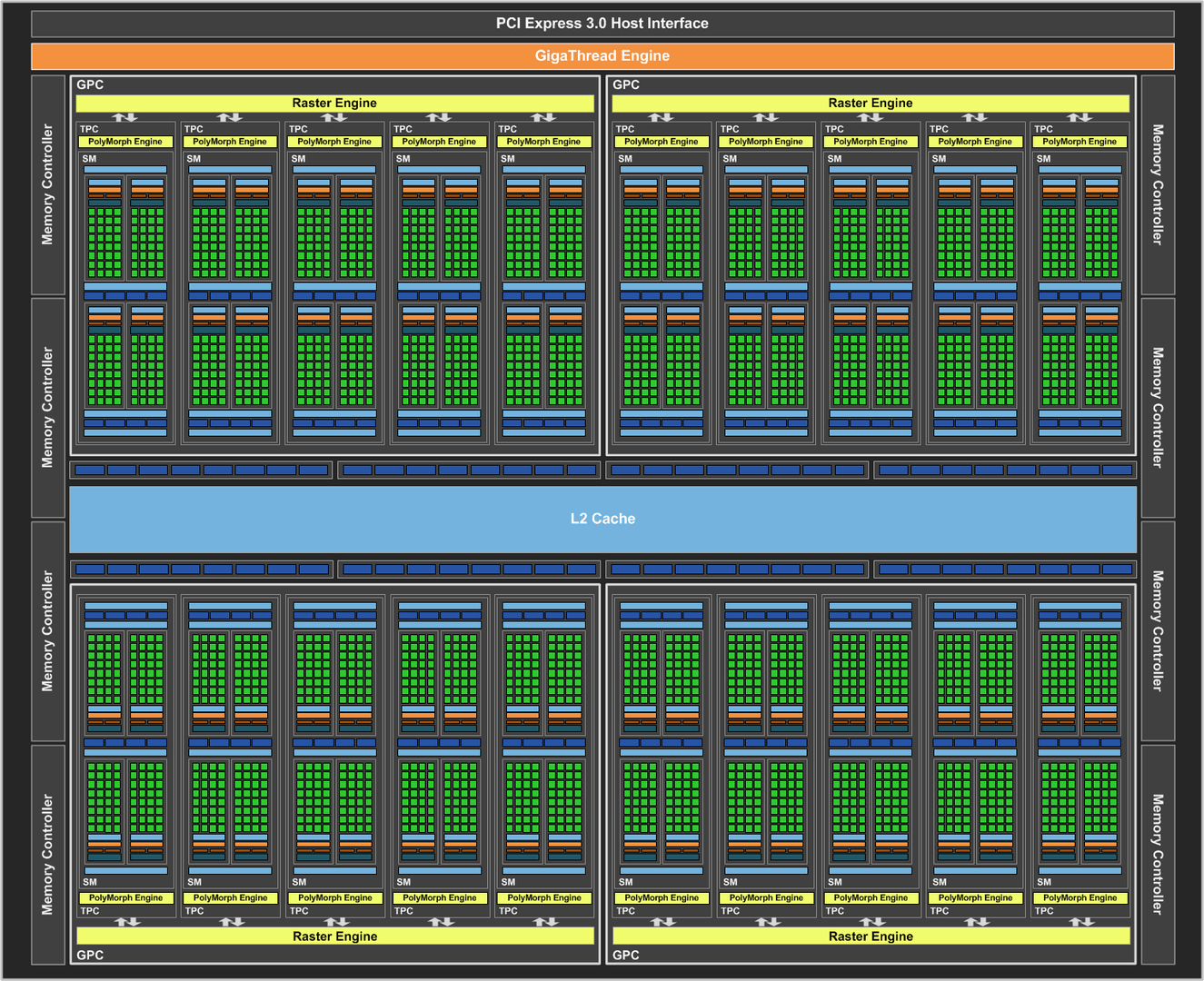

Der GP100 auf der Tesla P100 war Anfang April die erste offiziell von Nvidia vorgestellte Pascal-GPU, auf der GeForce GTX 1080 sowie der GeForce GTX 1070 kommt jetzt der kleinere Bruder GP104 zum Einsatz. Das Vorgehen ist aus vergangenen Generationen bekannt, dieses Mal unterscheiden sich der große und der kleine Chip aber deutlich voneinander.

GP104 im Vergleich zu Maxwell und GP100

Auch der GP104 wird im 16-nm-FinFET-Verfahren von TSMC gefertigt (16nmFF+). Die GPU ist 314 mm² groß und beherbergt 7,2 Milliarden Transistoren. Damit fällt die Packdichte sehr ähnlich zum GP100 aus, der 610 mm² für 15,3 Milliarden Transistoren benötigt. Im Vergleich zu den GPUs im alten 28-nm-Prozess ist die Packdichte um rund 75 Prozent gestiegen.

| Chip | GP104 | GM204 | GM200 |

|---|---|---|---|

| z.B. auf | GTX 1080 / 1070 | GTX 980 / 970 | GTX 980 Ti |

| Transistoren | ca. 7,2 Mrd. | ca. 5,2 Mrd. | ca. 8,0 Mrd. |

| Fertigung | 16 nm FinFET TSMC | 28 nm HP TSMC | 28 nm HP TSMC |

| Chipgröße | 314 mm² | 398 mm² | 601 mm² |

| Packdichte* | 22,9 | 13,1 | 13,3 |

| * In Millionen Transistoren pro mm² | |||

Die Shader wurden von Maxwell übernommen

Während Maxwell gegenüber Kepler große Änderungen bei den Shadereinheiten mitgebracht hat, bleiben die ALUs bei Pascal unangetastet. Wie Jonah Alben, Senior Vice President of GPU Engineering bei Nvidia, bestätigt, ist der Datendurchsatz dieser Einheiten damit pro Takt unverändert geblieben.

| GP104 | GM204 | GK104 | |

|---|---|---|---|

| Graphics Processor Cluster (GPC) | 4 | 4 | 4 |

| Streaming Multiprocessors (SMM) pro GPC | 5 | 4 | 2 |

| Shader pro SSM | 128 | 128 | 192 |

| TMUs pro SSM | 8 | 8 | 16 |

| Polymorph-Engine pro SSM (Version) | 1 (4.0) | 1 (3.0) | 1 (2.0) |

| Shader gesamt | 2.560 | 2.048 | 1.536 |

| TMUs gesamt | 160 | 128 | 128 |

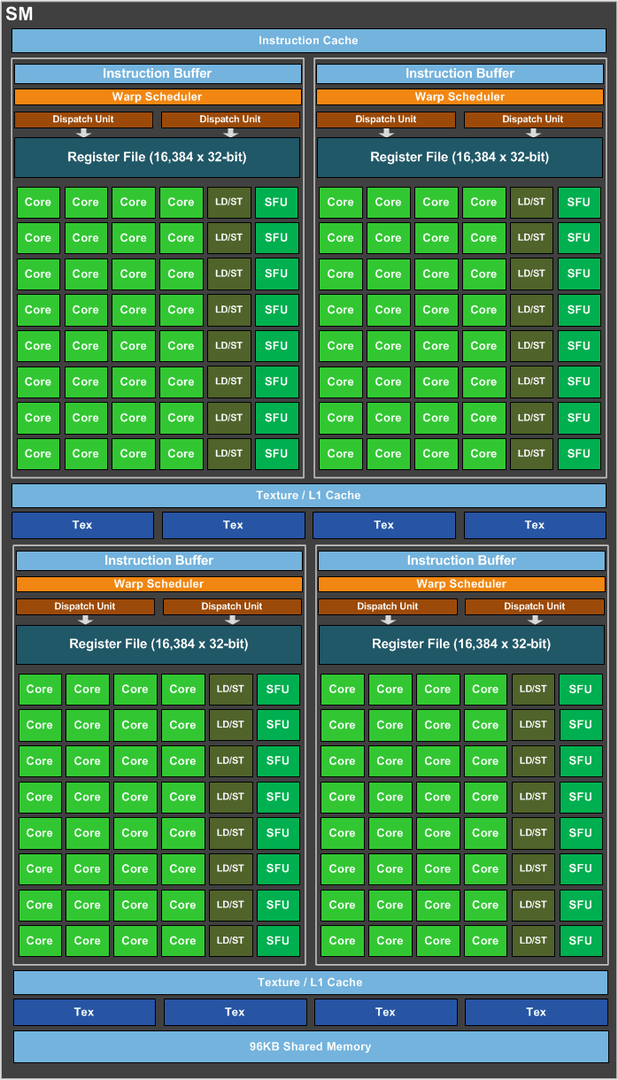

Auch der GP104 setzt sich wie der GM204 aus vier Graphics Processor Cluster (GPC) zusammen, die wiederum die einzelnen Elemente enthalten. Allerdings gibt es pro GPC fünf Streaming Multiprocessors (SMs) anstatt deren vier bei Maxwell. Ihr Aufbau ist wiederum quasi identisch. Jeder SM besteht auf dem GP104 aus 128 Shadereinheiten, acht Texture Mapping Units, zwei separaten Texture/L1-Caches, einem 256 KB großen Registerspeicher sowie einem 96 Kilobyte großen Shadered Memory. Damit kommt man bei dem GP104 auf 2.560 Shader- sowie 160 Textureinheiten.

| GP104 | GM204 | GK104 | |

|---|---|---|---|

| ROP-Cluster | 8 | 4 | 4 |

| ROPs pro Cluster | 8 | 16 | 8 |

| ROPs gesamt | 64 | 64 | 32 |

| Speichercontroller | 8 × 32 Bit | 8 × 32 Bit | 4 × 64 Bit |

| Speicherinterface | 256 Bit | 256 Bit | 256 Bit |

Pascal ist Maxwell für FinFET mit extremen Taktraten und ein wenig Tuning

Auch an den restlichen Einheiten wie den Instruction Buffern sowie den Warp Schedulern hat es keine Unterschiede gegeben. Das gilt nicht ganz für die Polymorph-Engine, die nun in der Version 4.0 anstatt 3.0 vorliegt. Die genaueren Auswirkungen dieser Anpassung werden später beschrieben. Mit acht ROP-Partitions zu je acht ROPs (64 ROPs insgesamt) sowie einem zwei Megabyte großen L2-Cache (256 KB pro ROP-Partition) bleibt auf dem GP104 auch dies identisch zum GM204. Eine minimale Änderung hat es bei der Konfiguration des Speicherinterfaces gegeben. GP104 setzt wie GM204 auf ein 256-Bit-Interface, das wie bei Maxwell aus acht 32-Bit-Controllern besteht.

| GP104 | GM204 | GK104 | |

|---|---|---|---|

| L1-Cache je SMM | 48 KB | 48 KB | kein separater L1 |

| L2-Cache je GPU | 2.048 KB | 2.084 KB | 512 KB |

GP104 und GP100 unterscheiden sich in der Konfiguration

Abseits der Fertigungstechnologie finden sich im Vergleich von GP104 zu GP100 damit sogar mehr Unterschiede, die über die massiv geringere Double-Precision-Leistung (1:32 bei GP104 gegenüber 1:2 bei GP100) und den Wegfall von Half Precision (FP16) hinaus gehen. Während GP104 auf den Maxwell-Aufbau einer SM und damit auf 128 ALUs setzt, geht GP100 einen anderen Weg und halbiert die Anzahl der ALUs pro SM. Mit 64 ALUs pro SM liegt diese GPU auf demselben Niveau wie AMDs Graphics-Core-Next-Architektur. Warum Nvidia diesen Schritt gegangen ist, wollte der Hersteller nicht verraten.