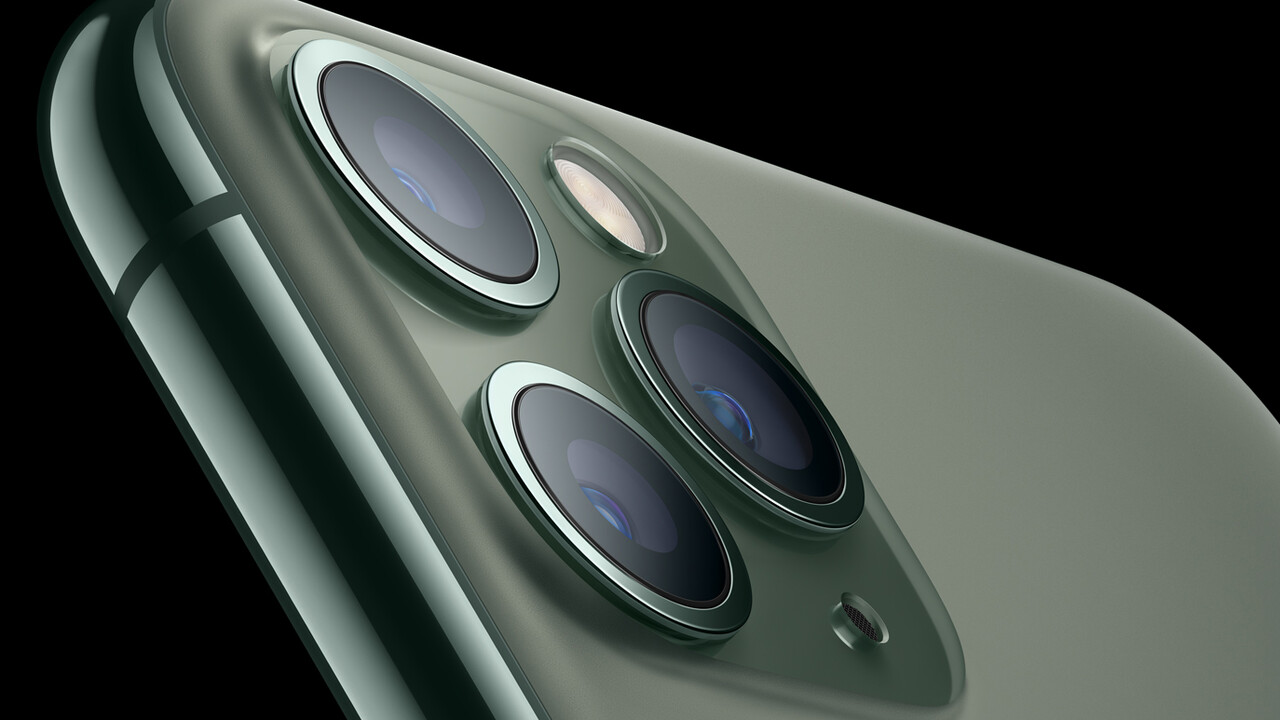

iPhone 11 (Pro): Deep-Fusion-Fotos kommen mit der nächsten iOS-13-Beta

Apples neue Bildverarbeitung mit dem Namen Deep Fusion wird Bestandteil der nächsten iOS-13-Beta. Deep Fusion soll vor allem bei mittleren Lichtbedingungen im Innenbereich oder bei Aufnahmen kurz nach Sonnenuntergang für bessere Fotos sorgen, indem Pixel für Pixel ein vom Prozessor zusammengesetztes Bild entsteht.

Apple hatte Deep Fusion im Rahmen der Keynote zu iPhone 11 und iPhone 11 Pro (Max) in Aussicht gestellt. Das Feature ist bisher nicht in iOS 13 sowie die späteren Updates integriert und soll mit einem später für das Jahr geplanten Update nachgereicht werden. Experimentierfreudige Anwender und Entwickler können Deep Fusion bereits mit der kommenden Developer Beta testen, die ursprünglich im Laufe des gestrigen Tages von Apple hätte veröffentlicht werden sollen. Das Unternehmen hat sich aber kurzfristig für einen späteren Release entschieden, der US-Medien wie TechCrunch zufolge keinen konkreten Termin mehr hat und in „wird kommen“ verändert wurde.

Deep Fusion nur für das iPhone 11 (Pro)

Deep Fusion ist ein neuer Prozess der Bildverarbeitung, der Apples Smart HDR nicht ersetzen wird, sondern für andere Lichtbedingungen ausgelegt ist und dort für bessere Fotos sorgen soll. Deep Fusion funktioniert ausschließlich auf dem neuen iPhone 11 und iPhone 11 Pro (Max) mit Apples A13-Bionic-Prozessor. Ältere Smartphones sind außen vor.

Pixel für Pixel zum finalen Foto

Die neue Bildverarbeitung funktioniert folgendermaßen: Die iPhone-Kamera schießt mit Deep Fusion zunächst ein Fotos mit negativem Lichtwert (EV, Exposure Value), um aus diesem schnellen Frame insbesondere viel Schärfe zu extrahieren. Auf diesen Frame folgen drei Aufnahmen mit normalem Lichtwert sowie eine Langzeitaufnahme. Der unterbelichtete Frame und die Kombination der vier weiteren Frames werden zu jeweils einem 12-Megapixel-Foto kombiniert, sodass insgesamt 24 Megapixel an Bildinformationen vorliegen.

Das Endresultat wiederum ist ein aus den insgesamt 24 Megapixeln generiertes 12-Megapixel-Foto, dessen Bildinformationen zuvor Pixel für Pixel vier unterschiedliche neuronale Netzwerke von Apple durchlaufen haben, um Optimierungen in Bereichen wie Himmel, Hauttönen, Kleidung oder Blattwerk vorzunehmen. Apple verspricht sich durch diese Maßnahme bessere Übergänge bei unterschiedlichen Hauttönen, mehr Details in Kleidung und einen höheren Detailgrad an den Kanten sich bewegender Objekte.

Deep Fusion arbeitet automatisch

Deep Fusion ist kein neuer Fotomodus und kann durch den Anwender weder aktiviert noch deaktiviert werden. Der gesamte Vorgang geschieht automatisch im Hintergrund. Apple will Anwendern den Vorgang des Schießens eines bestmöglichen Fotos so weit wie möglich abnehmen und das Smartphone die Entscheidungen vornehmen lassen.

Smart HDR, Deep Fusion und Nachtmodus

Deep Fusion soll sich auf der Hauptkamera mit Weitwinkelobjektiv automatisch im Bereich ab 10 Lux aktivieren, also oberhalb des Bereiches, in dem automatisch der Nachtmodus aktiv wird. Für helle bis mittelhelle Szenen bleibt hingegen das bekannte Smart HDR die automatische Bildverarbeitung der Wahl. Auf dem Teleobjektiv wird hauptsächlich Deep Fusion zum Einsatz kommen, Smart HDR nur bei sehr heller Szenerie. Und auf dem Ultraweitwinkel wird ausschließlich Smart HDR verwendet, da hier keine Unterstützung für Deep Fusion oder den neuen Nachtmodus vorliegt.

Apple stellt Deep Fusion ab sofort mit dem Update auf iOS 13.2 für jedermann zur Verfügung. Parallel dazu sind iPadOS 13.2 und tvOS 13.2 veröffentlicht worden.