Im Test vor 15 Jahren: Als ATi und Nvidia bei der Qualität mogelten

tl;dr: Vor 15 Jahren widmete sich ComputerBase der anisotropen Filterung bei ATi und Nvidia (Test). Zwischen den beiden Herstellern gab es deutliche Unterschiede hinsichtlich der Qualität der Filterung. Problematisch war dabei, dass sich viele der eingebauten Geschwindigkeitsoptimierungen nicht deaktivieren ließen.

Ein Filter für unscharfe Texturen

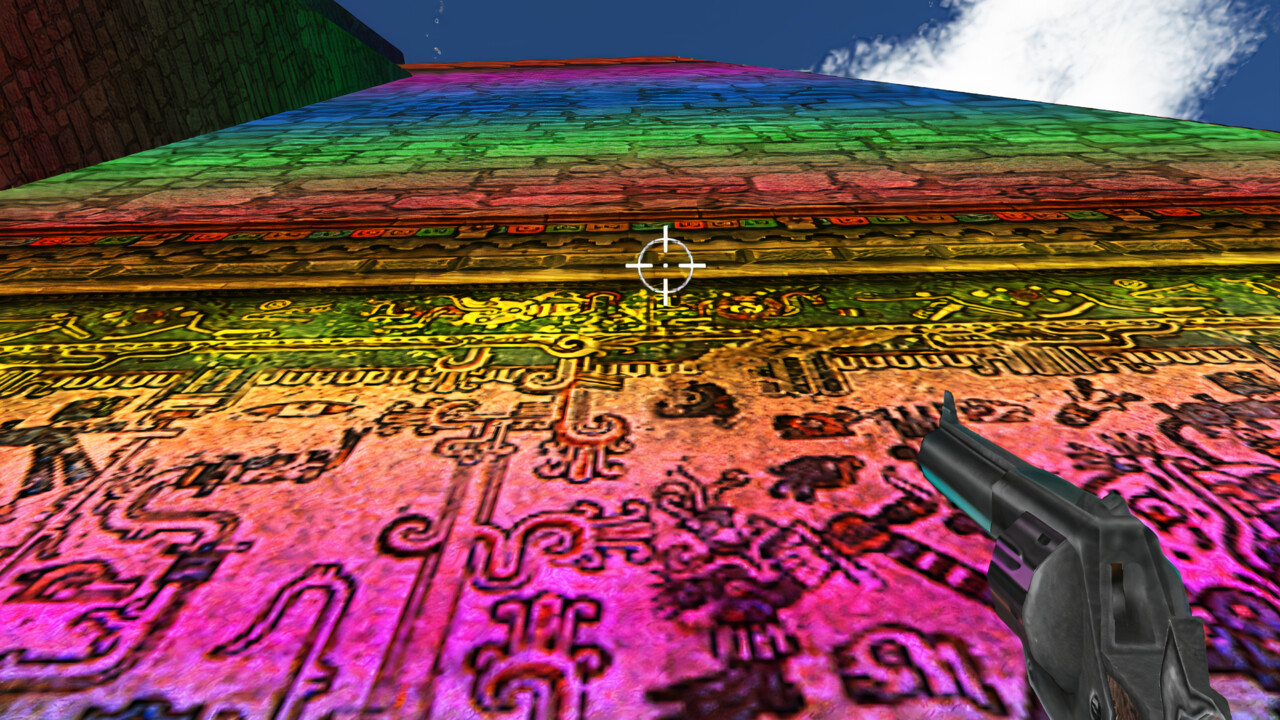

Anisotrope Filterung ermöglichte es, weit entfernte Texturen in Spielen scharf darzustellen. Damit sollte der Filter die Bildqualität wahrnehmbar verbessern. Aufgrund der hohen Leistungseinbußen entwickelten sowohl ATi als auch Nvidia Optimierungen. Diese senkten die Qualität der anisotropen Filterung, konnten aber schneller berechnet werden. Ein Problem war, dass sich die Optimierungen nur teilweise abschalten ließen und somit die Grafikqualität älterer Grafikkarten, bei denen dies noch möglich war, nicht mehr erreichen ließ. Zudem gab es deutliche Unterschiede zwischen ATi- und Nvidia-Grafikkarten.

Unübersichtliche Optimierungen

Bei ATi konnte im Catalyst Control Center nur zentral die Optimierungsfunktion „Catalyst A.I.“ in drei Stufen verstellt werden. Dahinter verbarg sich eine Erkennung der Dateinamen von Spielen, die dann mit im Vorhinein von ATi definierten Profilen gestartet wurden. So wurde je nach Spiel beispielsweise das Anti-Aliasing deaktiviert, der Textur-Cache optimiert oder gar die Shader ausgetauscht. Falls Catalyst A.I. deaktiviert wurde, wurden laut ATi keinerlei Optimierungen vorgenommen. In den Stufen Standard und Advanced wurde bei bestimmten Applikationen, die für Probleme in diesem Zusammenhang bekannt waren, das Anti-Aliasing deaktiviert. Zusätzlich wurden in diesen Stufen bei allen Applikationen bei Nutzung von anisotroper Filterung die einzelnen MipMap-Level analysiert und statt eines trilinearen ein „brilinearer“ Filter benutzt, sofern dies ohne Qualitätsverlust möglich war. Der Unterschied zwischen Standard und Advanced war, dass die höhere Stufe den brilinearen Filter früher einsetzte.

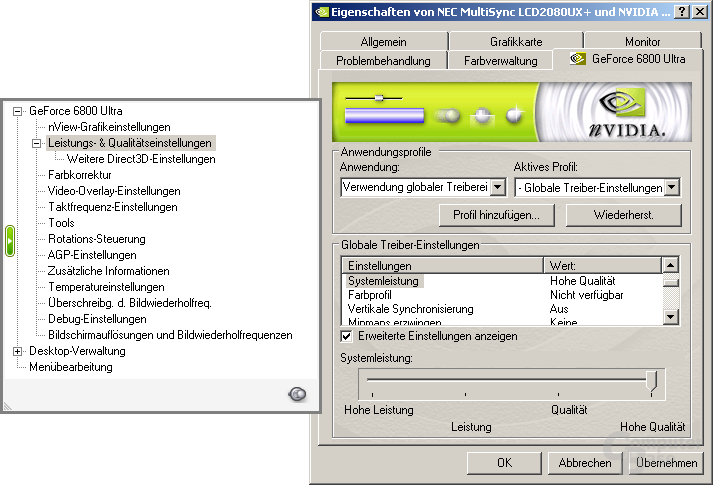

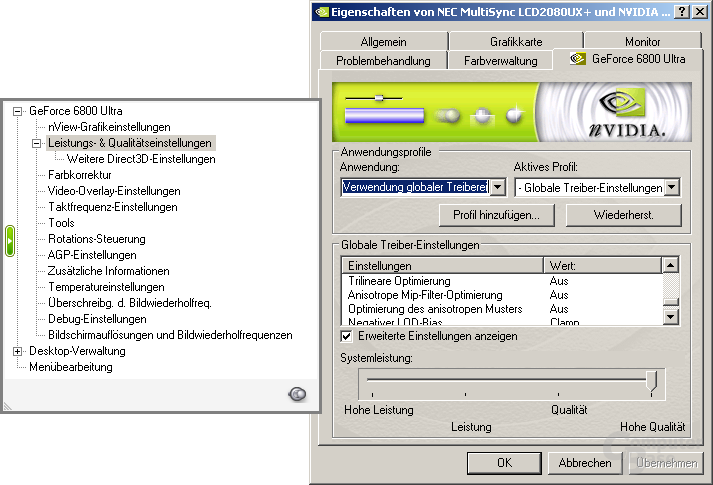

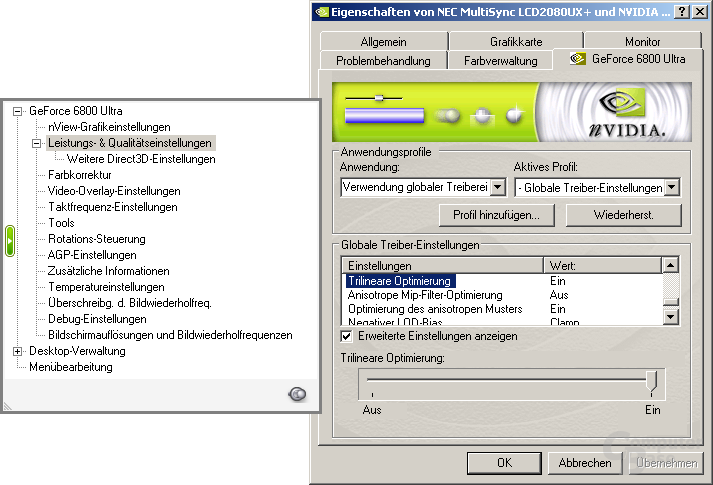

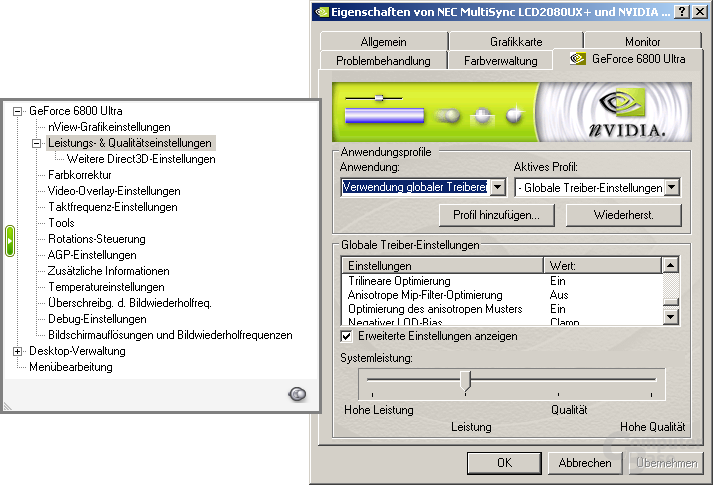

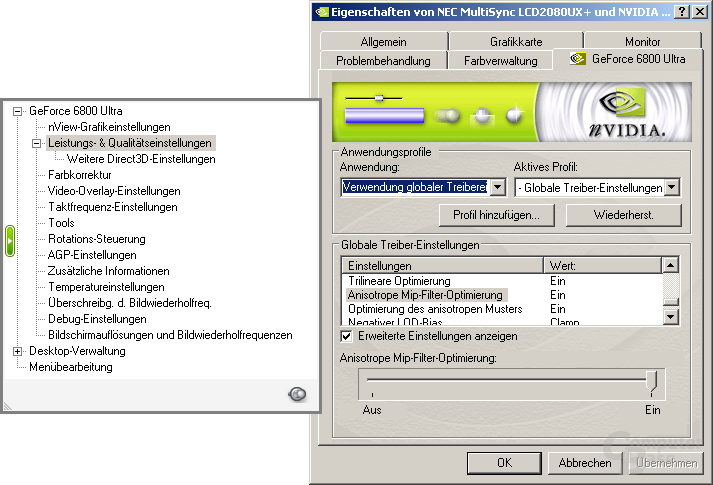

Bei Nvidia war die Situation etwas unübersichtlicher. Zum einen konnte unter dem Menüpunkt Systemleistung zwischen „Hohe Leistung“, „Leistung“, „Qualität“ und „Hohe Qualität“ gewählt werden. Zum anderen konnten unabhängig davon die Optionen „Trilineare Optimierung“, „Anisotrope Mip-Filter-Optimierung“ und „Optimierung des anisotropen Musters“ aktiviert werden. Standardmäßig wurde der Treiber mit der Einstellung Qualität und aktivierter trilinearer Optimierung sowie der Optimierung des anisotropen Musters ausgeliefert.

Deutliche Unterschiede bei Optik und Leistung

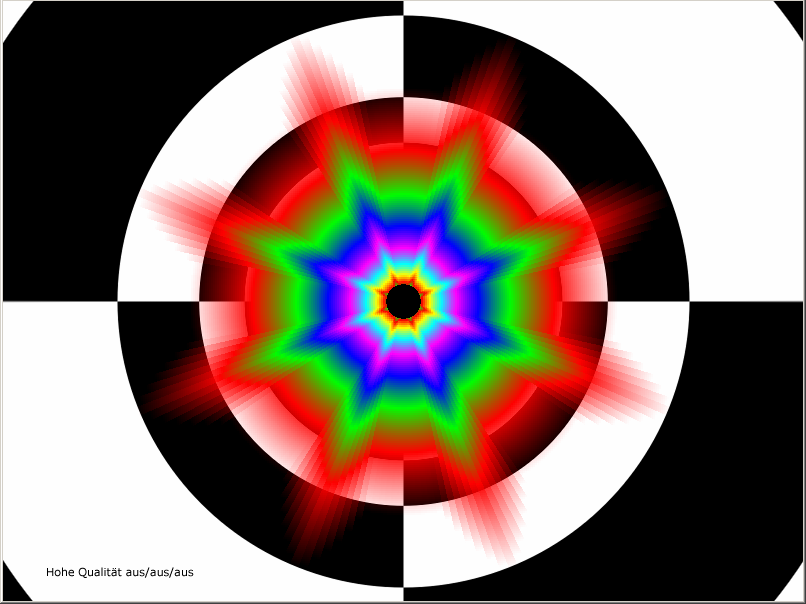

Optisch gab es auffällige Unterschiede zwischen den Optimierungsstufen. Insbesondere Nvidia machte hier einen negativen Eindruck. Während die Einstellung hohe Qualität ihrem Namen gerecht wurde, konnten schon bei den Standardeinstellungen visuelle Einbußen wahrgenommen werden. Bei Bewegungen war im Spiel ein unangenehmes Texturflackern wahrzunehmen. Wenn die Qualität auf Leistung gestellt wurde, wurde die gleiche (hochaufgelöste) MipMap bei höherer Distanz noch eingesetzt. Daraus folgte, dass das Bild schärfer wirkte, die Texturen aber noch sichtbarer flackerten. Wenn auf hohe Leistung geschaltet wurde, waren zusätzlich mehrere „Bugwellen“ sichtbar. Diese kamen durch den Übergang zwischen den MipMap-Levels zustande und wurden vor dem Spieler hergeschoben.

Anders sah es bei ATi aus. Zwischen allen drei Qualitätsstufen konnten weder im Spiel noch auf einem Screenshot sichtbare Unterschiede dargestellt werden. Erst beim Einsatz eines Programms, das die Unterschiede zwischen Bildern anzeigt, konnte ComputerBase minimale Differenzen feststellen. Die Leistungsunterschiede waren hingegen bedeutend. In 1.280 × 1.024 Bildpunkten konnten bei Nvidia bis 23 Prozent (6 Prozent von der Standardeinstellung) und bei ATi 10 Prozent (3 Prozent von der Standardeinstellung) Leistung gewonnen werden. In 1.600 × 1.200 Pixeln waren es bei Nvidia 27 respektive 8 Prozent und bei ATi 19 respektive 5 Prozent.

Damit blieb nach dem Test ein vielschichtiges Fazit. ATis Optimierungen konnten durchgehend überzeugen: Die Leistung stieg erheblich bei einem nicht wahrnehmbarem optischem Unterschied. Auf der anderen Seite standen die unübersichtlichen Einstellungsmöglichkeiten bei Nvidia, die zudem im Fall der beiden Leistungsprofile auch optisch nicht überzeugen konnten.

Im Jahr 2020 sind viele der damals aufgezeigten Techniken und ihre Kritikpunkte Geschichte. Zwischen den Herstellern gibt es generell bei gleichen Grafikeinstellungen qualitativ keine Unterschiede mehr. Die optisch abenteuerlichen Texturfilterungen gehören ebenfalls der Vergangenheit an.

In der Kategorie „Im Test vor 15 Jahren“ wirft die Redaktion seit Juli 2017 jeden Samstag einen Blick in das Test-Archiv. Die letzten 20 Artikel, die in dieser Reihe erschienen sind, führen wir nachfolgend auf:

- Längere Laufzeit mit Centrino Hardware Control

- Die Logitech MX518 war für viele die perfekte Maus

- Radeon X800 (XL) von günstig bis gut

- Der nForce 4 SLI machte Intel den Sockel streitig

- Pentium D und XE 840 waren die ersten Dual‑Core‑CPUs

- ATis absolut abstruses Radeon-X800-Angebot

- Razer Viper und Diamondback gegen Logitechs MX510

- Passive Grafikkarten-Kühler von Flop bis Top

- Das größte Problem der Radeon X850 XT hieß XL

- Spiele profitierten nicht von Windows XP 64 Bit

- ATis Radeon X800 nahm die GeForce 6600 GT ins Visier

- Die Pentium 4 der 600-Serie boten Features satt

- Gigabyte brachte zwei GeForce 6600 GT auf ein PCB

- Ein WLAN-Audioplayer zum günstigen Preis

- Die ersten 120-mm-Kühler kühlten gut und leise

- Auch DDR2 brachte erst einmal kaum Vorteile

- Ein klobiger PDA ohne MPEG-Unterstützung

- ATi Radeon X850 XT Platinum Edition beließ alles beim Alten

- SLI-Premiere mit Nvidia GeForce 6600 und 6800

- Die GeForce 6800 GT mit DDR1 von Asus

- Der erste Lasernager hieß Logitech MX1000

Noch mehr Inhalte dieser Art und viele weitere Berichte und Anekdoten finden sich in der Retro-Ecke im Forum von ComputerBase.