Im Test vor 15 Jahren: Filmwiedergabe auf GPUs von ATi versus Nvidia

Vor 15 Jahren ging ComputerBase der Frage nach, welche Grafikkarte sich am besten für die Filmwiedergabe eignete (Test). Ältere ATi- und Nvidia-Modelle machten eine schlechte Figur und ließen kaum Spaß aufkommen, doch die aktuelle Generation wollte davon nichts mehr wissen.

Avivo HD und PureVideo HD

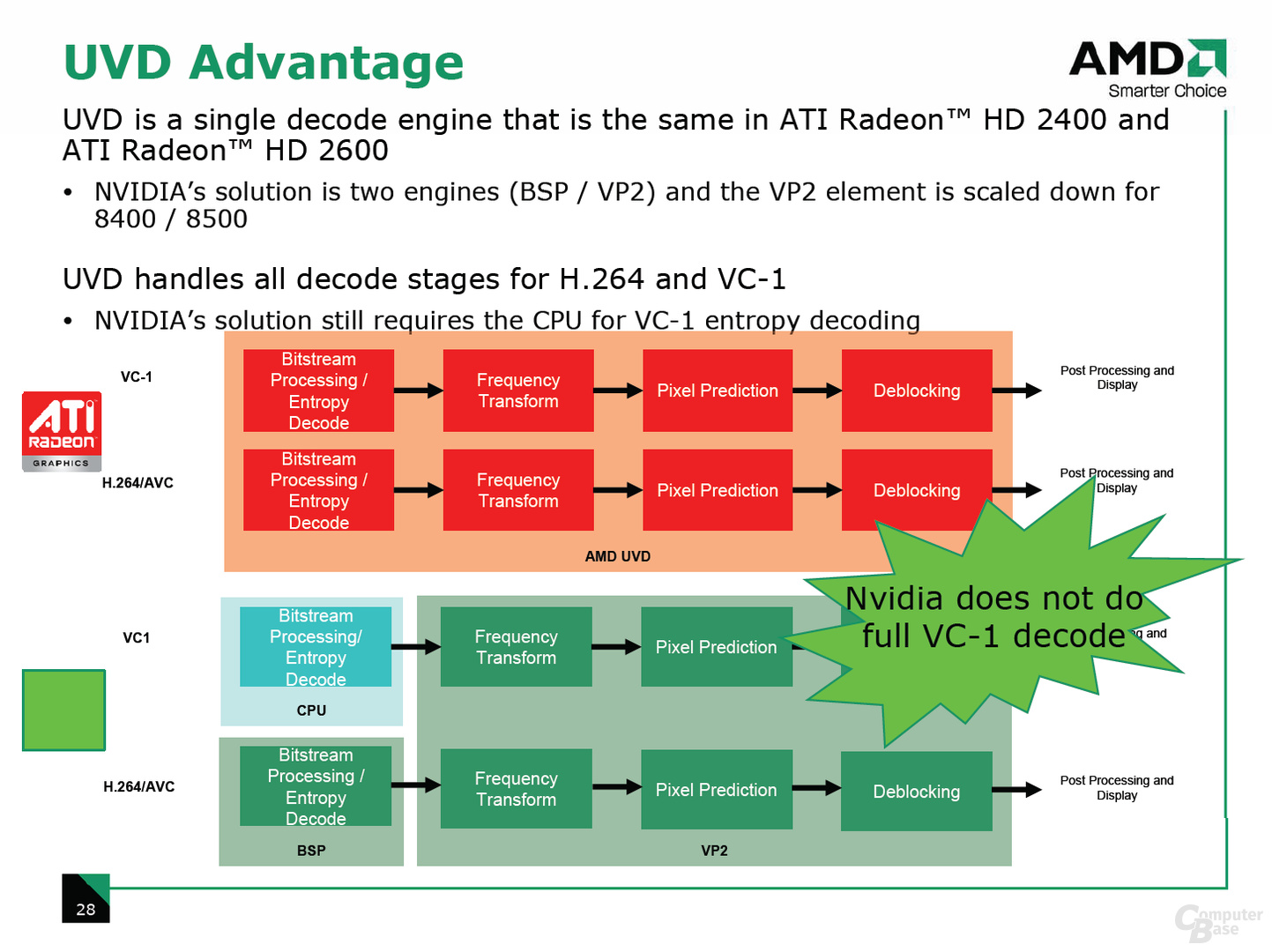

Für die Filmwiedergabe gab es im Jahr 2007 drei relevante Codecs: MPEG-2, H.264 und VC-1. Nahezu jede Grafikkarte war in der Lage, den verbreiteten MPEG-2-Standard in Hardware zu dekodieren, und auch CPUs waren oft ausreichend schnell. Anders sah es bei dem aufwändigen H.264-Codec aus, der vier Beschleunigungsstufen definierte: „CAVLC/CABAC Entropy Decode“, „Frequency Transform“, „Pixel Prediction“ und „Inloop Deblocking“. Jeder dieser Schritte ist ein Teil der Dekodierungspipeline, die bei VC-1 abgesehen vom ersten Schritt nahezu identisch aussah.

Abhängig von der Grafikkarte konnten diese Schritte direkt auf der GPU ausgeführt oder mussten dem Hauptprozessor überlassen werden. Diese Fähigkeiten wurden bei ATi unter dem Namen Avivo (HD) vermarktet. So unterstützten die Radeon-X1000-Serie und die Radeon X2900 XT die H.264-Dekodierung der letzten drei Stufen über die ALUs, der erste Schritt wurde von der CPU ausgeführt. Anders sah es bei den moderneren Radeon HD 2600 und 2400 mit RV630/RV610-GPUs aus. Diese besaßen eine separate Einheit für Videobeschleunigung, „Unified Video Decoder“ (UVD) genannt. Der UVD konnte alle vier Stufen von sowohl H.264 als auch VC1 in Hardware beschleunigen. Die GeForce-7000- und -8000-Serien teilten sich die gleiche Videobeschleunigungseinheit, der Teil des Nvidia-PureVideo-HD-Pakets war. Dieser war in der Lage, die letzten drei Phasen von sowohl H.264 als auch VC1 zu beschleunigen. Der aufwändige erste Schritt entfiel auf den Hauptprozessor. Die GeForce 8600 und 8500 verfügten über die zweite Generation des Videoprozessors, der H.264 (aber nicht VC1) in allen vier Stufen beschleunigen konnte.

Die Krux mit HDCP

Ein weiterer wichtiger Bestandteil der Filmwiedergabe war der Kopierschutz HDCP. Dieser wurde bereits von älteren Grafikkarten unterstützt, hatte jedoch einige Fallstricke. Um HDCP zu nutzen, musste nicht nur die GPU HDCP unterstützten, sondern auch der entsprechende DVI- oder HDMI-Anschluss der Grafikkarte. Das stellten AMD und Nvidia den Boardpartnern aber frei, mit der Ausnahme von moderneren Modellen der Radeon-HD-2000-Serie und einigen GeForce-Exemplaren. Zudem kam das Problem mit Single- und Dual-Link-DVI dazu: Wer einen hochauflösenden Monitor mit Full HD oder höher besaß und ihn via Dual-Link-DVI betrieb, konnte eventuell kein HDCP-geschütztes Material ansehen, da viele Grafikkarten HDCP via Dual-Link-DVI nicht unterstützten.

Bildqualität und CPU-Auslastung

Der HD-HQV-Benchmark testete die Bildqualität der Grafikkarten in verschiedenen Szenarien, beispielsweise die Rauschreduzierung oder die Treppchenbildung. Am unteren Ende des Benchmarks platzierte sich die GeForce 7950, die keine der beiden Funktionen bot und auch subjektiv eine unterirdische Bildqualität in Filmen aufwies. Besonders positiv heraus stachen die GeForce 8600 und 8800, wobei letztere dank eines neuen Treibers ein besseres Postprocessing in Filmen anwendete und daher eine ungewohnt gute Bildqualität bot. Die Radeon-HD-2000-Modelle hatten ein gutes Bild und platzierten sich damit in der Mitte des Testfeldes, leicht hinter den beiden GeForce mit ausgefeiltem Postprocessing.

Als zweiten Messwert erhob ComputerBase die CPU-Auslastung während der Filmwiedergabe. Abhängig vom Codec ergab sich hier das erwartete Bild. Die Radeon-X1000-Serie und die HD 2900 ohne separate Videobeschleunigungseinheit sorgten für eine relativ hohe CPU-Last, ebenso die GeForce 8800 und 7950 mit der ersten Generation des Nvidia-Videoprozessors. Deutlich besser sah es bei den kleineren GPUs mit modernen Videodekodern aus: Radeon HD 2600 und 2400 sowie GeForce 8600 und 8500 lagen im Test weit vorne.

Fazit

Insgesamt kamen aus dem Test zwei klare Sieger hervor: Die Radeon HD 2600 und die GeForce 8600. Beide boten eine ausgezeichnete Bildqualität und eine garantierte HDCP-Unterstützung (auch bei Dual-Link-DVI) und sorgten für eine geringe CPU-Auslastung bei der Filmwiedergabe.

In der Kategorie „Im Test vor 15 Jahren“ wirft die Redaktion seit Juli 2017 jeden Samstag einen Blick in das Test-Archiv. Die letzten 20 Artikel, die in dieser Reihe erschienen sind, führen wir nachfolgend auf:

- Teufel und Logitech im 5.1-Schlagabtausch

- Scythes Katana 2 war der Kühlerkönig der Mittelklasse

- Ein nahezu unhörbarer Gaming-PC für 3.100 Euro

- Corsairs Voyager GT war der beste USB-Stick für 100 Euro

- HD 2000 mit RV610 & RV630 überzeugte mehr als mit R600

- DDR3 feierte mit dem Intel P35 bei Asus Premiere

- ATi CrossFire lag 80 Prozent voraus – gemessen in dB(A)

- Halo 2 war auf dem PC trotz Vista ein Flop

- Router, Switch und NAS in einem von Asus

- Xigmatek mischte für 25 Euro mit Direct-Touch den Markt auf

- Die beste Gaming-Maus war Razers Death Adder

- Gegen die 8800 halfen der HD 2900 XT auch keine 5D-ALUs

- GeForce 8800 Ultra

- Die PlayStation 3 war viel mehr als eine Spielkonsole

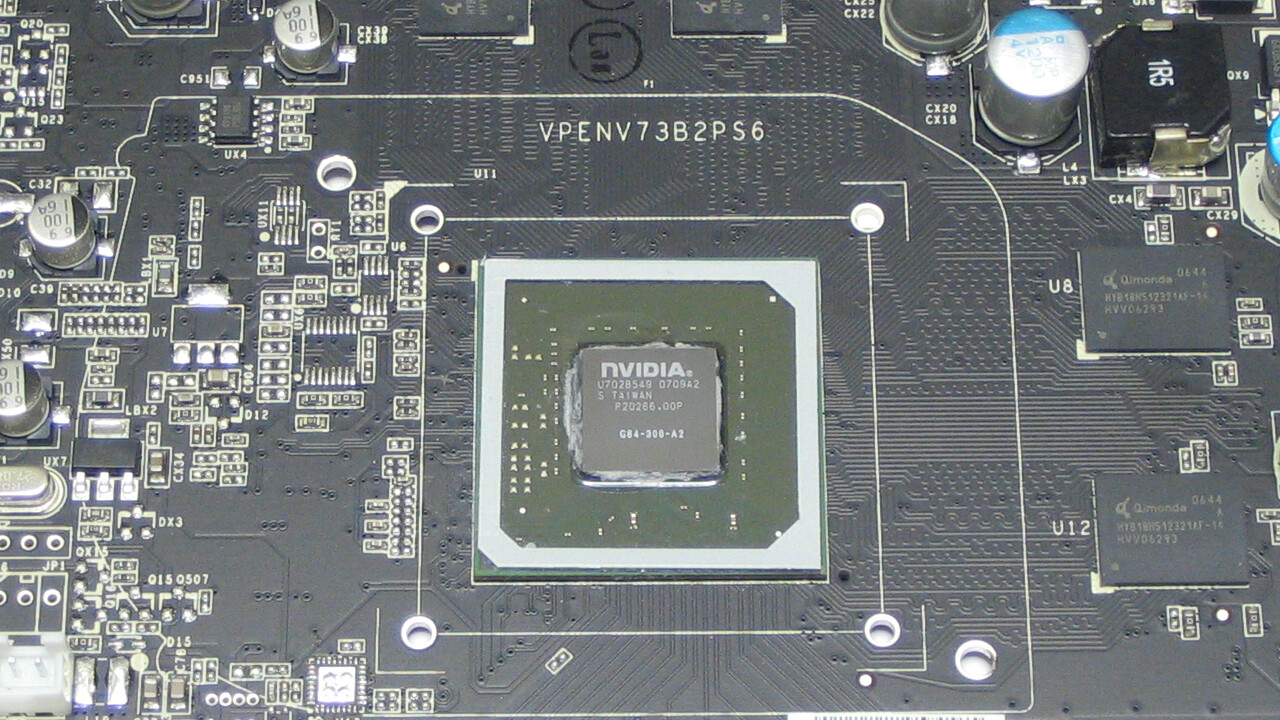

- Die G84-GPU der GeForce 8600 GTS kam in 80 nm

- Fünf GeForce 8800 GTS 320 mit G80-GPU am Limit

- Windows ReadyBoost machte USB-Sticks zum Turbolader

- Intels Core 2 Extreme QX6800 hatte vier 2,93-GHz-Kerne

- Das NZXT Zero hatte die beste Kühlung für 140 Euro

- Wassergekühlter Arbeitsspeicher von OCZ

Noch mehr Inhalte dieser Art und viele weitere Berichte und Anekdoten finden sich in der Retro-Ecke im Forum von ComputerBase.