GH200 Grace Hopper Superchip: Nvidia setzt als erster Anbieter auf HBM3e mit 5 TB/s

Wenn man sich eines von Nvidia-CEO Jensen Huangs Keynote zur SIGGRAPH 2023 merken sollte, dann laut seiner Aussage: „The future is accelerated computing“ und selbstverständlich das Mantra „the more you buy, the more you save“. Das folgte auf die Ankündigung eines neuen und schnelleren GH200 Grace Hopper Superchips mit HBM3e.

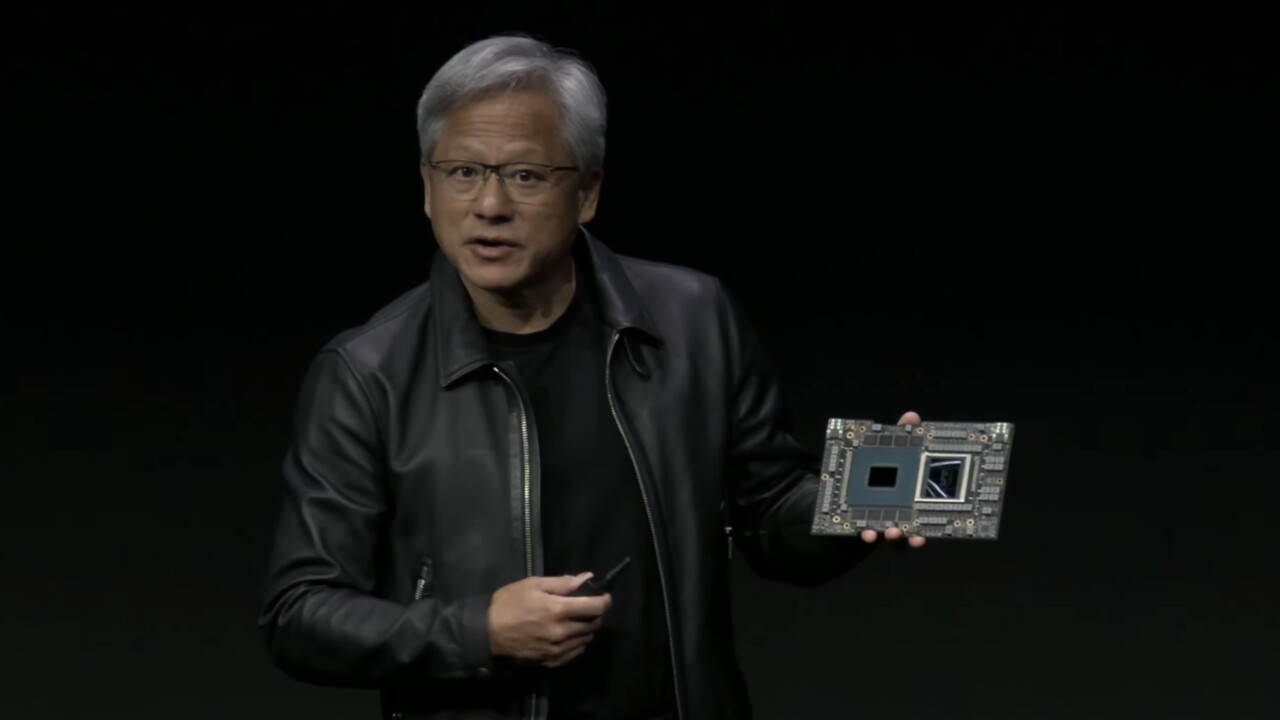

Der Grace Hopper Superchip ist eine erstmals zur GTC im Frühjahr 2022 gezeigte Kombination aus Arm-Neoverse-V2-CPU und Hopper-GPU, die über einen Chip-2-Chip-Interconnect mit 900 GB/s auf einer Platine miteinander verknüpft werden, anstatt „langsames“ PCIe zu nutzen. Während die CPU mit ihren 72 Kernen des Typs Arm Neoverse V2 auf 480 GB LPDDR5X mit ECC-Support bei 546 GB/s zurückgreift, setzte die GPU bis dato auf 96 GB HBM3 mit einer Speicherbandbreite von 3 TB/s.

Upgrade für den Grace Hopper Superchip

Zur SIGGRAPH hatte Nvidia eine aufgebohrte Variante des Grace Hopper Superchips im Gepäck, die auf den Namen GH200 respektive „GH200 Grace Hopper Platform“ hört und die auch im KI-Supercomputer DGX GH200 zum Einsatz kommt, der zur Fachmesse DGX GH200 SuperPod genannt wurde.

141 GB HBM3e mit 5 TB/s pro GPU

Die Neuauflage des GH200 Grace Hopper Superchips zeichnet sich durch einen Wechsel von HBM3 zu HBM3e aus. Laut Nvidia handelt es sich um den weltweit ersten Prozessor, der HBM3e nutzt. Nvidia gibt die Speicherbandbreite des neuen Modells mit 5 TB/s an. Die neue Lösung ist demnach zwei Drittel schneller als die bisherige GPU mit HBM3, die auf 3 TB/s kam. Der neue GH200 Grace Hopper Superchip bietet aber auch mehr Speicher, nämlich 141 GB HBM3e statt 96 GB HBM3. Der Speicher könnte von SK Hynix stammen, bestätigt ist dies aber noch nicht. HBM3e von SK Hynix soll 2024 an den Start gehen, Nvidia nennt für den GH200 Grace Hopper Superchip das zweite Quartal 2024.

Als Modul mit zwei GPUs und 10 TB/s

Der GH200 Grace Hopper Superchip lässt sich in zweifacher Ausführung in einem relativ flachen Rack zu einem kohärenten Modul zusammenschalten, bei dem die beiden Superchips über einen NVLink-Interconnect mit 6 TB/s verbunden werden. Geboten werden dann 144 Neoverse-V2-Kerne bei der CPU, „eine“ GPU mit insgesamt 282 GB HBM3e mit einer Speicherbandbreite von 10 TB/s und 8 PFLOPS Rechenleistung.

Supercomputer mit 2.500 GH200

Das „the more you buy, the more you save“ kommt zustande, wenn dieses einzelne System mit einem Modul auf zwei GPUs weiter nach oben skaliert wird, einmal mit demselben Budget und einmal mit derselben Leistung eines reinen CPU-Supercomputers. Zum Vergleich herangezogen wurde ein Supercomputer mit 8.800 CPUs des Typs Intel Xeon Platinum 8480+ alias Sapphire Rapids. Dieser Aufbau koste laut Nvidia 100 Millionen US-Dollar, verbrauche 5 MW und liefere eine normierte KI-Leistung von 1x.

Kommt das reine CPU-Setup noch auf 20 Server-Regale, sind es beim selben Budget von 100 Millionen US-Dollar nur noch 10,5 für die Technik von Nvidia. Für das Geld bekomme man 2.500 GH200, die aber nur noch 3 MW verbrauchen, dabei aber die 12-fache KI-Leistung etwa für Stable Diffusion XL liefern.

Wechselt man hingegen von ISO-Budget auf ISO-Leistung, reiche bei Nvidia ein Server-Regal mit 210 GH200, die 8 Millionen US-Dollar kosten, nur noch 260 KW verbrauchen und ebenfalls 1x KI-Leistung erreichen. Und genau deshalb solle man sich laut Huang merken: „The future is accelerated computing.“