HBM3E: SK Hynix folgt Micron mit schnellerem HBM

SK Hynix nennt die nächste Stufe seines HBM3-Speichers HBM3E. Der gestapelte DRAM soll es auf 1,15 TB/s pro Stapel bringen. Damit mag er der schnellste „HBM3E“ sein, doch Micron hat schon schnelleren „HBM3 Gen2“ mit 1,2 TB/s vorgestellt.

Next Gen HBM3 hat verschiedene Namen

Wie so oft liegt der Teufel im Detail respektive im Namen. Die nächste Generation von HBM3 heißt bei SK Hynix HBM3E, wobei das „E“ für „Extension“, also eine Erweiterung steht. Jetzt rühmt sich SK Hynix mit dem „weltweit leistungsstärksten HBM3E“, der Daten mit bis zu 1,15 TB/s verarbeitet.

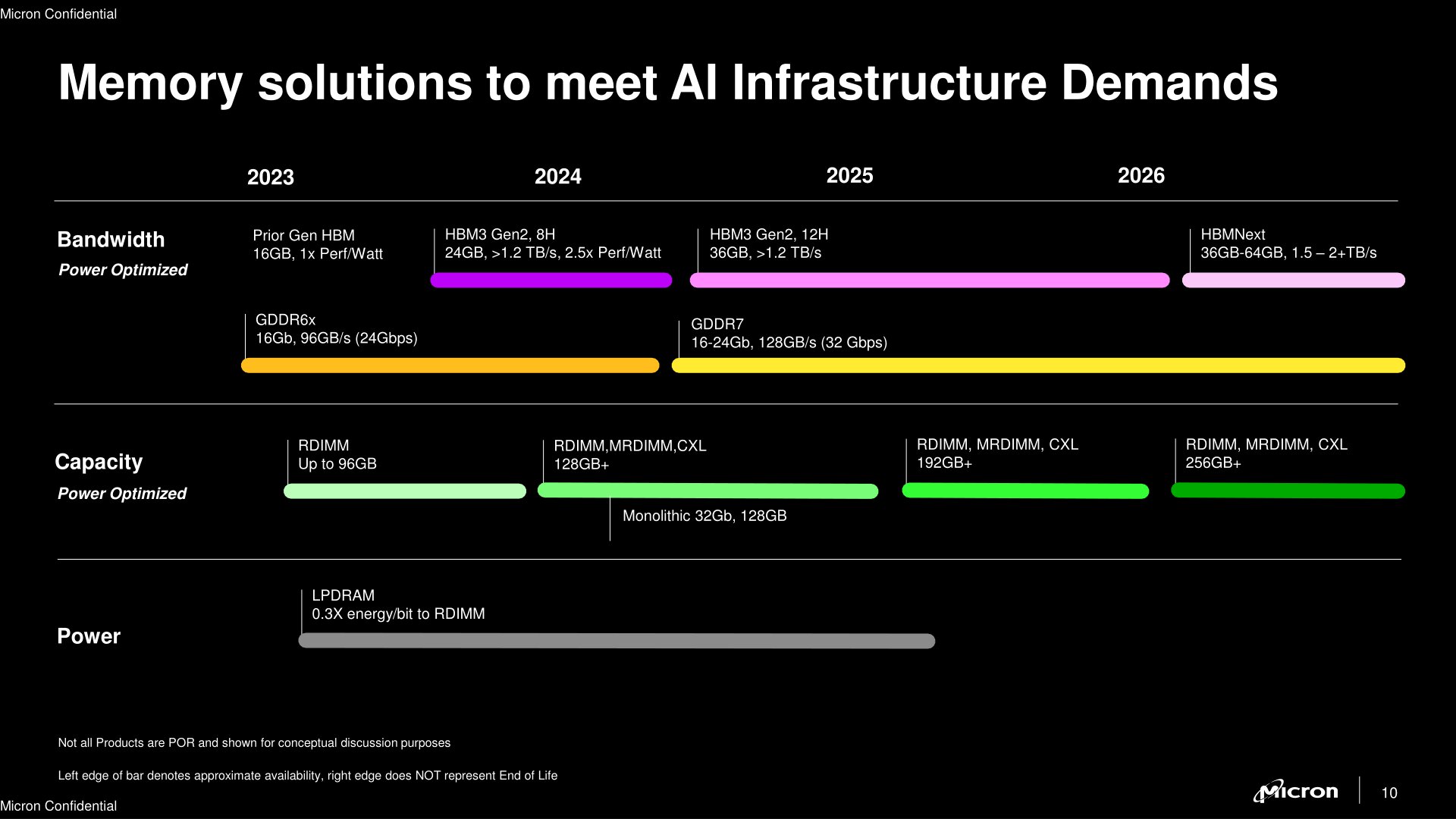

Gelogen ist das nicht, doch gibt es unter anderem Namen noch etwas schnelleren HBM3. Micron hat nämlich vor knapp einem Monat seinen ersten High Bandwidth Memory vorgestellt, der es sogar auf rund 1,2 TB/s bringen soll. Doch nennt Micron diesen nicht HBM3E, sondern „HBM3 Gen2“.

SK Hynix macht kaum Angaben zu seinem HBM3E, doch ergibt sich ausgehend von 1,15 TB/s eine Datenrate pro Pin von 9 Gbit/s, bei Micron sind es 9,2 Gbit/s. Im Vorfeld hatte SK Hynix für seinen HBM3E sogar geringere Transferraten genannt. Dass Micron nun für Zugzwang sorgt, wäre ein denkbares Szenario. Unterm Strich ist der Geschwindigkeitsunterschied mit 1.152 GB/s gegenüber 1.178 GB/s aber ohnehin gering.

Zur Speicherkapazität des HBM3E macht SK Hynix keine Angaben, allerdings ist pro Stack von 24 GB auszugehen, da bei Nvidias „GH200 Grace Hopper Superchip“ sechs Stacks von SK Hynix zum Einsatz kommen, bei denen netto 141 GB von 144 GB nutzbar sind.

| max. Durchsatz pro Pin | max. Durchsatz pro Stack | max. Kapazität pro Stack | |

|---|---|---|---|

| HBM1 | 1,0 Gb/s | 128 GB/s | 1 GB |

| HBM2 | 2,0 Gb/s | 256 GB/s | 8 GB |

| HBM2E | 3,6 Gb/s | 461 GB/s | 16 GB |

| HBM3 | 6,4 Gb/s | 819 GB/s | 24 GB |

| HBM3E | 9,0 Gb/s | 1.152 GB/s | 24 GB |

| HBM3 Gen2 | 9,2 Gb/s | 1.178 GB/s | 36 GB |

Wie bei Micron wird die Massenfertigung aber erst im ersten Halbjahr 2024 beginnen. Zu den Abnehmern zählen Anbieter von Rechenbeschleunigern für Supercomputer. Nvidias GH200 soll passend dazu im Laufe des zweiten Quartals 2024 in die Produktion starten.

Mehr schneller Speicher für KI

Die Forschung an und mit Künstlicher Intelligenz (KI) verlangt nach hoher Rechenleistung. Ebenso groß ist der Bedarf an großem und schnellem Speicher, der auch mit HBM gedeckt werden soll. Supercomputer werden jetzt primär mit GPU-basierten Beschleunigern bestückt, die ihrerseits wiederum immer mehr mit HBM versehen sind.