MichaelBer

Banned

- Registriert

- Mai 2023

- Beiträge

- 274

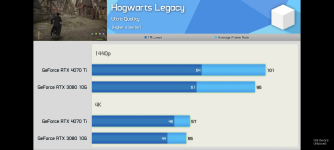

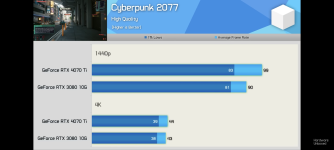

Ich versteh zu wenig von der Technik.

Aber in dem Überlick Bild von dem Video heißt es "Same VRAM, half the bus"

Was bedeutet das für die Praxis?

Hat die 4070 da in irgendwelchen Scenarien in der Praxis merkliche Nachteile?

Aber in dem Überlick Bild von dem Video heißt es "Same VRAM, half the bus"

Was bedeutet das für die Praxis?

Hat die 4070 da in irgendwelchen Scenarien in der Praxis merkliche Nachteile?

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.