Anscheinend ist es schon anderen aufgefallen. Siehe z.B. hier:

http://www.overclock.net/t/1507897/samsung-840-evo-read-speed-drops-on-old-written-data-in-the-drive

Auch meine Samsung 840 evo 1 TB zeigt das dort gezeigte Verhalten.

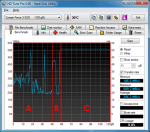

Mache ich einen Read mit HD Tune (so eingestellt, dass wirklich alles gelesen wird) geht die Leserate teilweise auf 65 MB/s runter.

Um zu checken, ob das evtl. nur leere Bereiche sind oder so, habe ich jetzt noch direkt Files gelesen, die schon auf der SSD drauf sind.

Genutzt dafür:

http://thesz.diecru.eu/content/parkdale.php

Das Tool macht genau das was man so will und man kann auch mit und ohne Pufferung lesen u.a..

Einfach ein File anwählen Read drücken und warten.

Hier zeigt es sich, dass z.B. eine 70 GB großes VirtualBox-Image mit 420 MB/s gelesen wird. Das scheint mir okay.

Ein paar älteren Dateien in der Größe von 2 GB werden allerdings nur mit 80 MB/s gelesen.

Das sind Dateien, die ich praktisch als allererstes auf die SSD kopiert habe (von einer Platte, die ersetzt wurde).

Die haben eine Größe von 2 GB je Datei. Ich überlege gerade, ob ich die mir einem Imagingtool eingespielt habe. Weiß es leider nicht mehr genau.

Insofern zeigt das Lesen von Dateien das gleiche Verhalten wie das blockweise Lesen der gesamten SSD. Es liegt also nicht an der Testmethode.

CrystalDiskInfo mal unten, das zeigt keine Auffälligkeiten. Die SSD ist fast neu und eher wenig benutzt.

Es ist auch nicht die Bootplatte und es lief keine Software von der SSD.

Kein aktiver on-access virenscanner.

Ich habe noch 2 Crucial SSDs drin (C300, M4) die zeigen das Verhalten nicht.

Ist das jetzt ein Defekt oder die Performance, die man erwarten darf?

Wenn es wirklich "normales Verhalten" ist, dann sag ich schönen Dank und sehr schade, dass die M550 noch nicht draußen war, als ich die Samsung gekauft habe.

Und jetzt spiele ich mir den Gedanken die SSD mal defragmentieren zu lassen ...

http://www.overclock.net/t/1507897/samsung-840-evo-read-speed-drops-on-old-written-data-in-the-drive

Auch meine Samsung 840 evo 1 TB zeigt das dort gezeigte Verhalten.

Mache ich einen Read mit HD Tune (so eingestellt, dass wirklich alles gelesen wird) geht die Leserate teilweise auf 65 MB/s runter.

Um zu checken, ob das evtl. nur leere Bereiche sind oder so, habe ich jetzt noch direkt Files gelesen, die schon auf der SSD drauf sind.

Genutzt dafür:

http://thesz.diecru.eu/content/parkdale.php

Das Tool macht genau das was man so will und man kann auch mit und ohne Pufferung lesen u.a..

Einfach ein File anwählen Read drücken und warten.

Hier zeigt es sich, dass z.B. eine 70 GB großes VirtualBox-Image mit 420 MB/s gelesen wird. Das scheint mir okay.

Ein paar älteren Dateien in der Größe von 2 GB werden allerdings nur mit 80 MB/s gelesen.

Das sind Dateien, die ich praktisch als allererstes auf die SSD kopiert habe (von einer Platte, die ersetzt wurde).

Die haben eine Größe von 2 GB je Datei. Ich überlege gerade, ob ich die mir einem Imagingtool eingespielt habe. Weiß es leider nicht mehr genau.

Insofern zeigt das Lesen von Dateien das gleiche Verhalten wie das blockweise Lesen der gesamten SSD. Es liegt also nicht an der Testmethode.

CrystalDiskInfo mal unten, das zeigt keine Auffälligkeiten. Die SSD ist fast neu und eher wenig benutzt.

Es ist auch nicht die Bootplatte und es lief keine Software von der SSD.

Kein aktiver on-access virenscanner.

Ich habe noch 2 Crucial SSDs drin (C300, M4) die zeigen das Verhalten nicht.

Ist das jetzt ein Defekt oder die Performance, die man erwarten darf?

Wenn es wirklich "normales Verhalten" ist, dann sag ich schönen Dank und sehr schade, dass die M550 noch nicht draußen war, als ich die Samsung gekauft habe.

Und jetzt spiele ich mir den Gedanken die SSD mal defragmentieren zu lassen ...