Welche Kuriositäten, Leistungen und Durchbrüche gab es in den letzten Jahrzehnten in der Computertechnik?

Vieles

Einiges davon werde ich euch hier erzählen und ich freue mich auf eure Geschichten und Anekdoten

Inhaltsangabe

Update 1: optische Medien (09.01.2022)

Update 2: chemisch/optische Medien (15.01.2022)

Vieles

Einiges davon werde ich euch hier erzählen und ich freue mich auf eure Geschichten und Anekdoten

Inhaltsangabe

- Apollo Programm

- Vorwort zur V2

- Steuerung der V2

- Maus

- Touchscreen

- Heimnetzwerk

- optische Medien

- chemisch/optische Medien

Update 1: optische Medien (09.01.2022)

Update 2: chemisch/optische Medien (15.01.2022)

Nehmen wir eines der größten Programme, das Weltweit angestoßen wurde: das Apollo Programm. [/ANAME

Während die Bordeigenen Rechner bessere Taschenrechner waren, strotzte die Saturn V nur vor Weltrekorden. Sie zählt immer noch zu den leistungsstärkten Raketen, die jemals von Menschenhand geschaffen wurde. Dabei war sie so fragil, dass sie im Liegen, nur durch das Eigengewicht, zusammengedrückt worden wäre. Also montierte man die Saturn im Stehen, Stück für Stück.

Bei der Zündung jedoch, entfaltete sie ihr volles Potential: man müsste 30 Atomkraftwerke zusammenschalten, um auf dieselbe Leistung zu kommen.

Die Saturn V von Apollo 10 während des Rollouts (Bild: NASA)

Und da der Mond nicht vor der Haustür fliegt, musste eine Lichtsekunde an Distanz überwunden werden, um die ersten Menschen auf unserem Trabanten abzusetzen.

Michael Collins muss sich komisch vorgekommen sein, als erster Mensch, so weit entfernt, alleine in dieser Blechbüchse zu sitzen und km, um km zurückzulegen, während Buzz Aldrin und Neil Armstrong von der Mondoberfläche zurückschauten.

Während in das gesamte Apollo Programm umgerechnet 95 Milliarden € flossen (Stand Dezember 2021), wurde die meiste Arbeit der West Area Computing Group durch vorwiegend schwarze Frauen erledigt. Computer? Fehlanzeige, Köpfchen war gefragt. Die IBM 7090 und 7094-11 wurden zwar genutzt, ersetzten aber erst langsam die „colored computer“ (siehe Film Hidden Figures).

229.000 Berechnungen pro Sekunde konnte dieses Wunderwerk verarbeiten, angetrieben durch 50.000 Transistoren war es der Wegbereiter in eine neue Zukunft. Dabei kostete der 7090 gerade einmal 11,6 Mio. €, gegen die Gesamtkosten Cent Beträge.

Möglich wurde dies auch viel durch deutsche Technik. So startete das erste künstliche Objekt in den Weltraum von Peenemünde aus.

V1 in Peenemünde, im Hintergrund die V2 (Bild: andi_sco)

V2 in Peenemünde (Bild: andi_sco)

Später gelang den Amerikanern mit einer erbeuteten V2 das erste Foto aus dem Weltraum:

(Bild: White Sands APL)

Wernher von Braun, der Chefkonstrukteur der V1 und V2 wechselte nach dem Krieg in die USA und trieb mit seinem Ehrgeiz die Entwicklung weiter voran. Sein Gegenspieler in der Sowjetunion, Koroljow setzte weniger auf das Wissen aus Deutschland als auf eigenes.

Doch selbst die V2 (oder Aggregat 4) brauchte einen einfachen, Analogen Computer, der von Dr. Hoelzer entwickelt wurde.

Die Rakete wurde durch insgesamt 6 Ruder gesteuert, 4 im Bereich der Brennkammer, zwei als Segel außen.

Zwei Signale zur Steuerung kamen von außerhalb der Rakete, man nutzte dazu Funk im 5 und im 7 kHz Bereich. Der Dipolmast als Sender, wurde so aufgestellt, dass die V2 genau auf ihn zuhielt. Da sich beide Funkfeuer in der „Mitte“ aufhoben, wusste die Rakete wo die Zielrichtung liegt. Denn sobald ein Signal stärker als das andere war, musste nur der Kurs nachgeregelt werden, bis sich die Wellen wieder aufhoben.

DIe Rakete ist erst zu weit links, und wird, gesteuert durch das Funksignal korrekt ausgerichtet. Quelle: andi_sco

Um die Brenndauer und damit die Geschwindigkeit zu regeln, wurden zwei weitere Funkfrequenzen genutzt. Sobald durch den Dopplereffekt das empfangene Signal stark anstieg, wurde der Schub reduziert und erst nachdem derselbe Effekt beim zweiten Signal erreicht war, wurde der Brennschluss eingeleitet.

Ferner wurden Kreiselinstrumente genutzt, 3 Stück an der Zahl. Da jeder von ihnen bestrebt ist, seine ursprüngliche Lage wieder herzustellen, konnte man dieses Moment in elektrische Signale umwandeln. Eine direkte Übertragung hätte zu einer Taumelbewegung geführt, also musste man sie dämpfen und verzögern. Dies geschah in dem man einen Widerstand und einen Kondensator in Reihe schaltete. Der Kondensator verzögert, bis das Signal weitergeleitet werden kann.

Dies regelten z.B. die 4 Flossen in der Brennkammer, während die zwei außen angebrachten dafür sorgten, dass es zu keiner Drehbewegung kam.

Deswegen ist das Aggregat 4 auch im Mosaikmuster zu bewundern, optisch war eine Drehung auch aus großer Entfernung sichtbar.

Weitere Quellen:

( Die A-4 (V2) Rakete Teil 1 (bernd-leitenberger.de) )

( Von der Raketensteuerung zum Analogrechner Helmut Hoelzers PeenemŸnder Arbeiten und ihr Erbe (analogmuseum.org) )

Fun Fact: da man kaum die Flugbahn nachverfolgen konnte, heuerte man Agenten in England an. Diese wurden von der englischen Abwehr entdeckt und umgedreht, fort an lieferten Sie falsche Zielkoordinaten an Ihre Auftraggeber und die V2 landeten in unwichtigen Gebieten.

Steve Jobs hat am Palo Alto Research Center (PARC) eines der großartigsten Eingabegeräte der letzten hundert Jahre entdeckt, die Rede ist von der Maus.

Gesteuert wird sie über die Hand und ihre Bewegung wird von einer Kugel an zwei Sensoren übertragen, die die X- und Y-Achse auslesen. Für einen Fanatiker, wie Jobs es einer war, war dies die perfekte Eingabemethode.

Denn bisher funktionierte alles über die Tastatur, ein freies Arbeiten war somit erschwert. Touchscreens waren selten, umständlich und teuer (hp nutzte bereits 1983 eine ähnliche Technik, HP 150), von Sprachsteuerung noch lange keine Rede.

Somit war die Maus vorerst perfekt. Markieren, verschieben, zeichnen – alles mit einem Gerät.

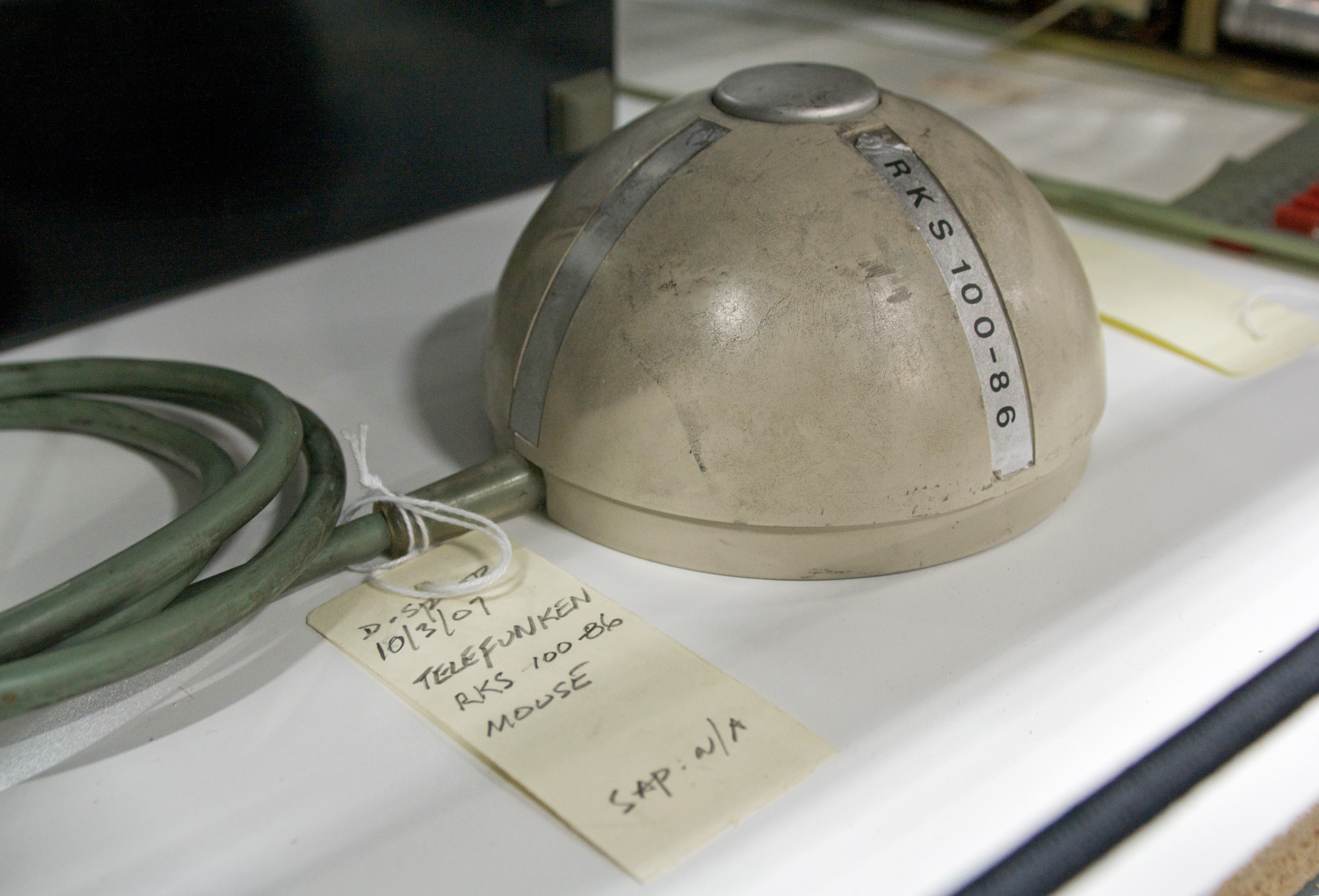

Doch auch wenn Apple und Microsoft durch Xerox inspiriert wurden, erfunden hat es ein anderer Weltkonzern: Telefunken.

Ja, Telefunken.

Vorgestellt wurde das Gerät mit der kryptischen Bezeichnung RKS 100-86 am 02.10.1968.

RKS bedeutet einfach RollKugelSteuerung und diese fand ihren Einsatz am Großrechner TR 440, dem Leistungsstärksten Rechner in Europa.

Die RKS 100-86 (Bild: Marcin Wichary)

Doch das Design war so fortschrittlich, so der Zukunft zugewandt das vom Patentamt ein klares NÖ kam. Nicht schutzwürdig genug.

Würden sich heute die Mitarbeiter, ohne Maus, durch Skizzen, Texte und Bilder wühlen, die Tischkanten dieser Welt hätten so manchen Zahnarztbesuch angeregt.

Touchscreens begleiten uns spätestens mit den Smartphones auf Schritt und Tritt.

Doch der Weg dahin war kein einfacher.

So nutzte hp z.B. Anfangs Lichtschranken, um die Position des Fingers zu bestimmen, heute funktioniert es direkt über den Bildschirm.

Wobei Google es zwischenzeitlich mit RADAR probiert hat, um Gesten zu erleichtern – aber auch das ist schon wieder Geschichte, Rüstungsbeschränkungen sei Dank hust.

Anfangs waren die Touchscreens Druckempfindlich (Resistiv), das heißt, dass im Bildschirm zwei elektrisch leitfähige Schichten verbaut sind.

Dabei liegt die Spannung zuerst an der unteren an, während die obere Spannungsfrei ist. Drückt man nun auf den Bildschirm berühren sich die Schichten und die obere leitet die Spannung zu ihren Rändern.

Wenn 5V anliegen und der Bildschirm eine Breite von 100mm hat, messen wir links 1V und rechts 4V an der oberen. Das bedeutet, das der Punkt 20mm von links und 80mm von rechts entfernt ist. Dadurch haben wir den Wert auf der X Koordinate.

Jetzt werden die 5V an die obere Schicht angelegt und das Gerät liest die Spannung oben und unten an der unteren Schicht ab. Messen wir 2V oben und 3V unten, ist bei einer Bildschirmhöhe von 100mm die Y Koordinate von oben 40mm und von unten 60mm entfernt.

Daraus errechnet das Gerät jetzt die Position.

Gerade bei mobilen Navis und z.B. dem Nokia N95 fand dies Verwendung.

Auch die sogenannten Lichtgriffel waren eine Möglichkeit, direkt mit dem Bildschirm zu interagieren.

Aber wie sagte schon Steve Jobs: „Es war der Stift, John. Ich habe den Newton abgeschossen wegen des Stifts. Wenn man einen Stift hält, werden auf einmal alle 5 Finger einer Hand nutzlos.“ (aus dem Film „Steve Jobs“).

Druckempfindliche Bildschirme gab es noch nicht, also musste man die Finger Position anders bestimmen: mit der Lichtschranke

HP gehörte hier zu den ersten, die es nutzten.

Dabei werden zwei Lichtschrankensysteme vor dem Monitor angebracht und ständig ausgelesen. Wird durch einen Finger oder einen Stift nun jeweils eine auf der X- und eine auf der Y-Achse unterbrochen, weiß der Computer anhand der Koordinaten, wo sich der Finger befindet und löst in diesem Bereich eine Interaktion aus.

HP verwendete 13 Lichtschranken für die Y-Achse und weitere 20 für die X-Achse, damit erreichte man eine Auflösung von 5mm:

HP 150 (Bild: Wikipedia)

Quelle: andi_sco

Heute kommunizieren die Geräte hauptsächlich über Funk miteinander. Entweder über W-LAN oder über den dänischen König Harald Blauzahn – besser bekannt als Bluetooth.

Doch es gibt seit Jahren noch zwei andere Möglichkeiten, einmal das altehrwürdige LAN-Kabel und über das Stromnetz.

Letzteres ist dabei nicht mal eine Erfindung von devolo oder der Jahrtausendwende. Bereits 1987 zeigte der WDR Computer Club, wie es funktionierte. Mit einem Power Line Modem (PLM-) 9600 konnte man über den Hausstrom miteinander Daten austauschen.

Dabei wurde auf die Trägerfrequenz von 50 Hz eine Zusatzfrequenz von z.B.: 100 kHz aufgetastet. Diese fungiert dann als Information. Ist sie aktiv, wird es als 0 ausgelesen, ist sie inaktiv, wird es als 1 ausgelesen.

Quelle: andi_sco

Update 1 (09.01.2022)

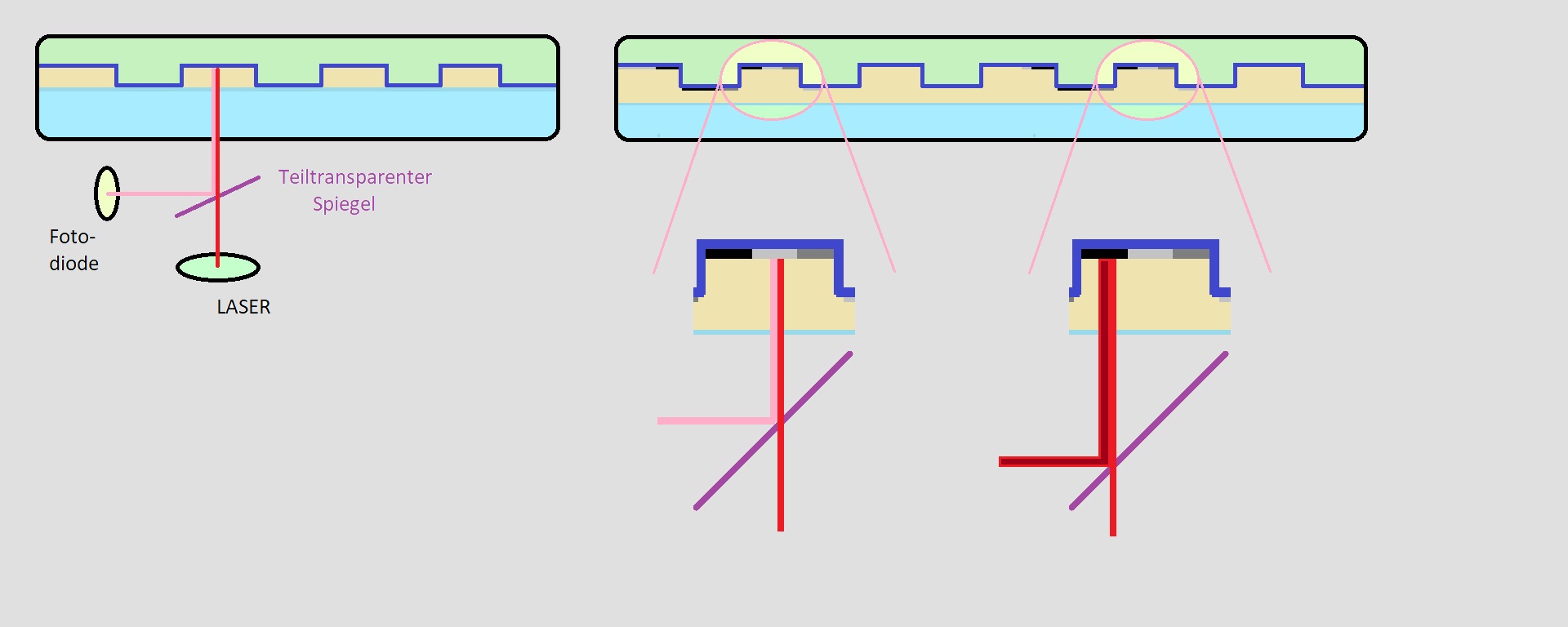

Die CD war das erste optische Medium, das im Heim-Bereich eine große Verbreitung erfuhr. Endlich war es möglich, ganze Videosequenzen mit in die Story einzubauen und auch die Texturen und Welten konnten größer werden.

Ein Nachfolger stand auch bald fest: DVD

Doch was sollte danach kommen? Auch wenn opulente Shooter wie Star Trek Elite Force II zwei CDs benötigten und auch das ältere X-Wing Alliance 2 Scheiben brauchte, wird die Zukunft wesentlich mehr an Speicherplatz belegen.

Die CD, als einschichtige Variante, endete mit 700 MB. Um die Datenmenge zu erhöhen, musste man also entweder die Pits und Lands enger gestalten oder, wie es TDK plante, Graustufen einführen.

Dadurch verdreifachte man die Kapazität und erhöhte gleichzeitig die Transferleistung: Multilevel Funktion nennt es TDK.

Bei der ersten Vorstellung, Anfang November 2000 waren spezielle Rohlinge nötig, doch nach kurzer Zeit war man so weit, CD-RW Rohlinge nutzen zu können.

Ein weiterer Vorteil war, das existierende Technik einfach ergänzt werden konnte. Eine teure Umrüstung im Bereich Laser und Optik war nicht nötig und die geplanten CD-RW Medien erfolgreich etabliert.

Doch es sollte nicht sein, die DVD war schon auf dem Vormarsch und auch ihr Nachfolger FMD wurde 2 Jahre vor der TDK Technik vorgestellt.

F

M

D

Bitte was?

Fluorescent

Multilayer

Disc

Update 2 (15.01.2022)

Am 14.11.2000 stellte die Firma Constellation 3D FMT vor. Ausgeschrieben bedeutet es Fluorescent-Multilayer Techonologie. Im Gegensatz zur CD wird nicht nur eine, sondern wie bei DVDs mindestens eine zusätzliche Schicht verwendet, um Daten zu sichern. Bis zu zehn Datenebenen waren geplant, die rechnerisch gewaltige 140 GB an Kapazität boten.

Eine verlockende Technologie, die im Bereich Filme neue Qualitätsmaßstäbe erlaubt hätte.

Die Firma dahinter war aber nicht minder spannend, denn sie sprang von einem Verlust zum nächsten. So war Constellation 3D seit Ende der 90er an der NASDAQ gelistet und steigerte ihren Marktwert rasch, und allein auf der Grundlage von ein paar Vorführungen im engen Kreis.

Bereits einen Monat nach dem Börsengang wurde die Firma von Latin Venture übernommen, die sich danach in C3D Inc. Umbenannte.

Ein Hochrangiger General der israelischen Armee wurde zum Vorsitzenden ernannt, in seinem vorherigen Umfeld war er für den Bereich Forschung tätig. Sein Name: Itzhak Yaakov.

Noch im Jahr 2000 meldete man Verluste von 20 Mio. $ an, im Gegenzug sollte mit der Firma Lite-On ein Partner für die Fertigung existieren.

Die Firma geriet aber immer mehr in den Abwärtsstrudel, so wurde Yaakov nach seinem Ausscheiden wegen Spionage verhaftet und sie selbst schlitterte immer schneller Richtung Insolvenz.

C3D war von 2002 bis 2006 in Insolvenz, während bereits 2003 die Firma D Data Inc. das gesamte Patentportfolio aufkaufte. Aufgrund von Problemen, bei der Fertigung der einzelnen Schichten reduzierte man diese auf 6 und versprach eine Abwärtskompatibilität mit DVD Playern.

Man benannte die Datenträger von FMD in DMD (Digitale Multilayer Disk) um und reduzierte die Speichergröße auf 32 GB.

Hier kam weiterhin ein roter Laser zum Einsatz, der auch für herkömmliche DVDs und Player verwendet wurde, es mussten jedoch einige Modifikationen erfolgen, um die DMD lesen zu können.

Eine metallische Schicht entfiel und die Scheiben waren Transparent.

Im Gegensatz zum Laser bei den anderen Datenträgern, führte die Erhitzung hierbei zu einer chemischen Veränderung des Materials, die diesen beeinflusste, was wiederum von einer Optik erfasst werden kann.

InPhase - optische Medien

Eine Ausgliederung der Bell Labs, die InPhase Technologies suchte ebenfalls einen Weg, auf der Größe normaler Medien mehrere hundert Gigabyte bis in den Terabyte Bereich zu speichern.

2008 präsentierte man sein erstes Schreib-/Lesegerät, den tapestry 300r. Die Medien waren einmal beschreibbar und erlaubten eine Kapazität von 300 GB, bei 20 MB/s Lesefähigkeit. Megabyte, keine Gigabyte! Mehr als 4h hätte ein einziger, konstanter Lesezyklus also gedauert.

18.000 US $ kostete im Jahr der Vorstellung das Gerät, pro Medium wurden dann 180 US $ fällig. Heute sind das ca. 20.420,00 € und 204,20 €.

Eine 250 GB Festplatte aus 2004 lieferte im Durchschnitt 47 MB/s an Lesegeschwindigkeit und 27 MB/s beim Schreiben (Test: Hitachi Deskstar 7K250).

Keine guten Vorzeichen für InPhase.

Auch wenn man neue Geräte im zwei Jahres Rhythmus und demnächst mit 1.600 GB Kapazität, und 120 GB/s (ja, Gigabyte!) beim Lesen plante, wurde aus den ganzen Versprechungen nicht viel.

Man kaufte im Jahr 2010 zwar noch Technik für die holographischen Medien von Hitachi Maxell ab, geriet man im Jahr darauf in die Insolvenz.

Akonia Holographics, heute eine Tochter von Apple Inc., erwarb 2012 das gesamte Geistige Eigentum und einiges an Ausrüstung.

Das war es für heute und demnächst geht es mit IBMs neuer Schallplatte weiter

Das soll es fürs erste gewesen sein.

Ich wünsche euch erholsame Feiertage und viel Spaß beim Geschenke auspacken

Euer Andi

Während die Bordeigenen Rechner bessere Taschenrechner waren, strotzte die Saturn V nur vor Weltrekorden. Sie zählt immer noch zu den leistungsstärkten Raketen, die jemals von Menschenhand geschaffen wurde. Dabei war sie so fragil, dass sie im Liegen, nur durch das Eigengewicht, zusammengedrückt worden wäre. Also montierte man die Saturn im Stehen, Stück für Stück.

Bei der Zündung jedoch, entfaltete sie ihr volles Potential: man müsste 30 Atomkraftwerke zusammenschalten, um auf dieselbe Leistung zu kommen.

Die Saturn V von Apollo 10 während des Rollouts (Bild: NASA)

Und da der Mond nicht vor der Haustür fliegt, musste eine Lichtsekunde an Distanz überwunden werden, um die ersten Menschen auf unserem Trabanten abzusetzen.

Michael Collins muss sich komisch vorgekommen sein, als erster Mensch, so weit entfernt, alleine in dieser Blechbüchse zu sitzen und km, um km zurückzulegen, während Buzz Aldrin und Neil Armstrong von der Mondoberfläche zurückschauten.

Während in das gesamte Apollo Programm umgerechnet 95 Milliarden € flossen (Stand Dezember 2021), wurde die meiste Arbeit der West Area Computing Group durch vorwiegend schwarze Frauen erledigt. Computer? Fehlanzeige, Köpfchen war gefragt. Die IBM 7090 und 7094-11 wurden zwar genutzt, ersetzten aber erst langsam die „colored computer“ (siehe Film Hidden Figures).

229.000 Berechnungen pro Sekunde konnte dieses Wunderwerk verarbeiten, angetrieben durch 50.000 Transistoren war es der Wegbereiter in eine neue Zukunft. Dabei kostete der 7090 gerade einmal 11,6 Mio. €, gegen die Gesamtkosten Cent Beträge.

Vorwort zur V2

Die Entwicklung der Raketen war ein langer und beschwerlicher Weg, der viel neue Technik forderte und förderte. Der Hauptteil dieser Entwicklung fand in Peenemünde statt.

Eigentlich gehört dies zu den größten Meilensteinen, die in Deutschland jemals entwickelt wurden, bei all der Euphorie sollten wir aber nie vergessen, welche Opfer dafür gebracht wurden.

Eigentlich gehört dies zu den größten Meilensteinen, die in Deutschland jemals entwickelt wurden, bei all der Euphorie sollten wir aber nie vergessen, welche Opfer dafür gebracht wurden.

Möglich wurde dies auch viel durch deutsche Technik. So startete das erste künstliche Objekt in den Weltraum von Peenemünde aus.

V1 in Peenemünde, im Hintergrund die V2 (Bild: andi_sco)

V2 in Peenemünde (Bild: andi_sco)

Später gelang den Amerikanern mit einer erbeuteten V2 das erste Foto aus dem Weltraum:

(Bild: White Sands APL)

Wernher von Braun, der Chefkonstrukteur der V1 und V2 wechselte nach dem Krieg in die USA und trieb mit seinem Ehrgeiz die Entwicklung weiter voran. Sein Gegenspieler in der Sowjetunion, Koroljow setzte weniger auf das Wissen aus Deutschland als auf eigenes.

Die Steuerung

Doch selbst die V2 (oder Aggregat 4) brauchte einen einfachen, Analogen Computer, der von Dr. Hoelzer entwickelt wurde.

Die Rakete wurde durch insgesamt 6 Ruder gesteuert, 4 im Bereich der Brennkammer, zwei als Segel außen.

Zwei Signale zur Steuerung kamen von außerhalb der Rakete, man nutzte dazu Funk im 5 und im 7 kHz Bereich. Der Dipolmast als Sender, wurde so aufgestellt, dass die V2 genau auf ihn zuhielt. Da sich beide Funkfeuer in der „Mitte“ aufhoben, wusste die Rakete wo die Zielrichtung liegt. Denn sobald ein Signal stärker als das andere war, musste nur der Kurs nachgeregelt werden, bis sich die Wellen wieder aufhoben.

DIe Rakete ist erst zu weit links, und wird, gesteuert durch das Funksignal korrekt ausgerichtet. Quelle: andi_sco

Um die Brenndauer und damit die Geschwindigkeit zu regeln, wurden zwei weitere Funkfrequenzen genutzt. Sobald durch den Dopplereffekt das empfangene Signal stark anstieg, wurde der Schub reduziert und erst nachdem derselbe Effekt beim zweiten Signal erreicht war, wurde der Brennschluss eingeleitet.

Ferner wurden Kreiselinstrumente genutzt, 3 Stück an der Zahl. Da jeder von ihnen bestrebt ist, seine ursprüngliche Lage wieder herzustellen, konnte man dieses Moment in elektrische Signale umwandeln. Eine direkte Übertragung hätte zu einer Taumelbewegung geführt, also musste man sie dämpfen und verzögern. Dies geschah in dem man einen Widerstand und einen Kondensator in Reihe schaltete. Der Kondensator verzögert, bis das Signal weitergeleitet werden kann.

Dies regelten z.B. die 4 Flossen in der Brennkammer, während die zwei außen angebrachten dafür sorgten, dass es zu keiner Drehbewegung kam.

Deswegen ist das Aggregat 4 auch im Mosaikmuster zu bewundern, optisch war eine Drehung auch aus großer Entfernung sichtbar.

Weitere Quellen:

( Die A-4 (V2) Rakete Teil 1 (bernd-leitenberger.de) )

( Von der Raketensteuerung zum Analogrechner Helmut Hoelzers PeenemŸnder Arbeiten und ihr Erbe (analogmuseum.org) )

Fun Fact: da man kaum die Flugbahn nachverfolgen konnte, heuerte man Agenten in England an. Diese wurden von der englischen Abwehr entdeckt und umgedreht, fort an lieferten Sie falsche Zielkoordinaten an Ihre Auftraggeber und die V2 landeten in unwichtigen Gebieten.

Nach einem Exkurs in die Luft, kommen wir auf den Boden der Tatsachen zurück

Steve Jobs hat am Palo Alto Research Center (PARC) eines der großartigsten Eingabegeräte der letzten hundert Jahre entdeckt, die Rede ist von der Maus.

Gesteuert wird sie über die Hand und ihre Bewegung wird von einer Kugel an zwei Sensoren übertragen, die die X- und Y-Achse auslesen. Für einen Fanatiker, wie Jobs es einer war, war dies die perfekte Eingabemethode.

Denn bisher funktionierte alles über die Tastatur, ein freies Arbeiten war somit erschwert. Touchscreens waren selten, umständlich und teuer (hp nutzte bereits 1983 eine ähnliche Technik, HP 150), von Sprachsteuerung noch lange keine Rede.

Somit war die Maus vorerst perfekt. Markieren, verschieben, zeichnen – alles mit einem Gerät.

Doch auch wenn Apple und Microsoft durch Xerox inspiriert wurden, erfunden hat es ein anderer Weltkonzern: Telefunken.

Ja, Telefunken.

Vorgestellt wurde das Gerät mit der kryptischen Bezeichnung RKS 100-86 am 02.10.1968.

RKS bedeutet einfach RollKugelSteuerung und diese fand ihren Einsatz am Großrechner TR 440, dem Leistungsstärksten Rechner in Europa.

Die RKS 100-86 (Bild: Marcin Wichary)

Doch das Design war so fortschrittlich, so der Zukunft zugewandt das vom Patentamt ein klares NÖ kam. Nicht schutzwürdig genug.

Würden sich heute die Mitarbeiter, ohne Maus, durch Skizzen, Texte und Bilder wühlen, die Tischkanten dieser Welt hätten so manchen Zahnarztbesuch angeregt.

Ein weitere Eingabemöglichkeit sind die Touchscreens

Touchscreens begleiten uns spätestens mit den Smartphones auf Schritt und Tritt.

Doch der Weg dahin war kein einfacher.

So nutzte hp z.B. Anfangs Lichtschranken, um die Position des Fingers zu bestimmen, heute funktioniert es direkt über den Bildschirm.

Wobei Google es zwischenzeitlich mit RADAR probiert hat, um Gesten zu erleichtern – aber auch das ist schon wieder Geschichte, Rüstungsbeschränkungen sei Dank hust.

Anfangs waren die Touchscreens Druckempfindlich (Resistiv), das heißt, dass im Bildschirm zwei elektrisch leitfähige Schichten verbaut sind.

Dabei liegt die Spannung zuerst an der unteren an, während die obere Spannungsfrei ist. Drückt man nun auf den Bildschirm berühren sich die Schichten und die obere leitet die Spannung zu ihren Rändern.

Wenn 5V anliegen und der Bildschirm eine Breite von 100mm hat, messen wir links 1V und rechts 4V an der oberen. Das bedeutet, das der Punkt 20mm von links und 80mm von rechts entfernt ist. Dadurch haben wir den Wert auf der X Koordinate.

Jetzt werden die 5V an die obere Schicht angelegt und das Gerät liest die Spannung oben und unten an der unteren Schicht ab. Messen wir 2V oben und 3V unten, ist bei einer Bildschirmhöhe von 100mm die Y Koordinate von oben 40mm und von unten 60mm entfernt.

Daraus errechnet das Gerät jetzt die Position.

Gerade bei mobilen Navis und z.B. dem Nokia N95 fand dies Verwendung.

Auch die sogenannten Lichtgriffel waren eine Möglichkeit, direkt mit dem Bildschirm zu interagieren.

Aber wie sagte schon Steve Jobs: „Es war der Stift, John. Ich habe den Newton abgeschossen wegen des Stifts. Wenn man einen Stift hält, werden auf einmal alle 5 Finger einer Hand nutzlos.“ (aus dem Film „Steve Jobs“).

Druckempfindliche Bildschirme gab es noch nicht, also musste man die Finger Position anders bestimmen: mit der Lichtschranke

HP gehörte hier zu den ersten, die es nutzten.

Dabei werden zwei Lichtschrankensysteme vor dem Monitor angebracht und ständig ausgelesen. Wird durch einen Finger oder einen Stift nun jeweils eine auf der X- und eine auf der Y-Achse unterbrochen, weiß der Computer anhand der Koordinaten, wo sich der Finger befindet und löst in diesem Bereich eine Interaktion aus.

HP verwendete 13 Lichtschranken für die Y-Achse und weitere 20 für die X-Achse, damit erreichte man eine Auflösung von 5mm:

HP 150 (Bild: Wikipedia)

Quelle: andi_sco

Nach dem Ausblick zur Nutzerinteraktion, kommen wir nun zur Kommunikation zwischen Rechnern.

Heute kommunizieren die Geräte hauptsächlich über Funk miteinander. Entweder über W-LAN oder über den dänischen König Harald Blauzahn – besser bekannt als Bluetooth.

Doch es gibt seit Jahren noch zwei andere Möglichkeiten, einmal das altehrwürdige LAN-Kabel und über das Stromnetz.

Letzteres ist dabei nicht mal eine Erfindung von devolo oder der Jahrtausendwende. Bereits 1987 zeigte der WDR Computer Club, wie es funktionierte. Mit einem Power Line Modem (PLM-) 9600 konnte man über den Hausstrom miteinander Daten austauschen.

Dabei wurde auf die Trägerfrequenz von 50 Hz eine Zusatzfrequenz von z.B.: 100 kHz aufgetastet. Diese fungiert dann als Information. Ist sie aktiv, wird es als 0 ausgelesen, ist sie inaktiv, wird es als 1 ausgelesen.

Quelle: andi_sco

Update 1 (09.01.2022)

Optische Medien

Die CD war das erste optische Medium, das im Heim-Bereich eine große Verbreitung erfuhr. Endlich war es möglich, ganze Videosequenzen mit in die Story einzubauen und auch die Texturen und Welten konnten größer werden.

Ein Nachfolger stand auch bald fest: DVD

Doch was sollte danach kommen? Auch wenn opulente Shooter wie Star Trek Elite Force II zwei CDs benötigten und auch das ältere X-Wing Alliance 2 Scheiben brauchte, wird die Zukunft wesentlich mehr an Speicherplatz belegen.

Die CD, als einschichtige Variante, endete mit 700 MB. Um die Datenmenge zu erhöhen, musste man also entweder die Pits und Lands enger gestalten oder, wie es TDK plante, Graustufen einführen.

Dadurch verdreifachte man die Kapazität und erhöhte gleichzeitig die Transferleistung: Multilevel Funktion nennt es TDK.

Bei der ersten Vorstellung, Anfang November 2000 waren spezielle Rohlinge nötig, doch nach kurzer Zeit war man so weit, CD-RW Rohlinge nutzen zu können.

Ein weiterer Vorteil war, das existierende Technik einfach ergänzt werden konnte. Eine teure Umrüstung im Bereich Laser und Optik war nicht nötig und die geplanten CD-RW Medien erfolgreich etabliert.

Doch es sollte nicht sein, die DVD war schon auf dem Vormarsch und auch ihr Nachfolger FMD wurde 2 Jahre vor der TDK Technik vorgestellt.

F

M

D

Bitte was?

Fluorescent

Multilayer

Disc

Update 2 (15.01.2022)

FMD - chemisch/optische Medien

Am 14.11.2000 stellte die Firma Constellation 3D FMT vor. Ausgeschrieben bedeutet es Fluorescent-Multilayer Techonologie. Im Gegensatz zur CD wird nicht nur eine, sondern wie bei DVDs mindestens eine zusätzliche Schicht verwendet, um Daten zu sichern. Bis zu zehn Datenebenen waren geplant, die rechnerisch gewaltige 140 GB an Kapazität boten.

Eine verlockende Technologie, die im Bereich Filme neue Qualitätsmaßstäbe erlaubt hätte.

Die Firma dahinter war aber nicht minder spannend, denn sie sprang von einem Verlust zum nächsten. So war Constellation 3D seit Ende der 90er an der NASDAQ gelistet und steigerte ihren Marktwert rasch, und allein auf der Grundlage von ein paar Vorführungen im engen Kreis.

Bereits einen Monat nach dem Börsengang wurde die Firma von Latin Venture übernommen, die sich danach in C3D Inc. Umbenannte.

Ein Hochrangiger General der israelischen Armee wurde zum Vorsitzenden ernannt, in seinem vorherigen Umfeld war er für den Bereich Forschung tätig. Sein Name: Itzhak Yaakov.

Noch im Jahr 2000 meldete man Verluste von 20 Mio. $ an, im Gegenzug sollte mit der Firma Lite-On ein Partner für die Fertigung existieren.

Die Firma geriet aber immer mehr in den Abwärtsstrudel, so wurde Yaakov nach seinem Ausscheiden wegen Spionage verhaftet und sie selbst schlitterte immer schneller Richtung Insolvenz.

C3D war von 2002 bis 2006 in Insolvenz, während bereits 2003 die Firma D Data Inc. das gesamte Patentportfolio aufkaufte. Aufgrund von Problemen, bei der Fertigung der einzelnen Schichten reduzierte man diese auf 6 und versprach eine Abwärtskompatibilität mit DVD Playern.

Man benannte die Datenträger von FMD in DMD (Digitale Multilayer Disk) um und reduzierte die Speichergröße auf 32 GB.

Hier kam weiterhin ein roter Laser zum Einsatz, der auch für herkömmliche DVDs und Player verwendet wurde, es mussten jedoch einige Modifikationen erfolgen, um die DMD lesen zu können.

Eine metallische Schicht entfiel und die Scheiben waren Transparent.

Im Gegensatz zum Laser bei den anderen Datenträgern, führte die Erhitzung hierbei zu einer chemischen Veränderung des Materials, die diesen beeinflusste, was wiederum von einer Optik erfasst werden kann.

InPhase - optische Medien

Eine Ausgliederung der Bell Labs, die InPhase Technologies suchte ebenfalls einen Weg, auf der Größe normaler Medien mehrere hundert Gigabyte bis in den Terabyte Bereich zu speichern.

2008 präsentierte man sein erstes Schreib-/Lesegerät, den tapestry 300r. Die Medien waren einmal beschreibbar und erlaubten eine Kapazität von 300 GB, bei 20 MB/s Lesefähigkeit. Megabyte, keine Gigabyte! Mehr als 4h hätte ein einziger, konstanter Lesezyklus also gedauert.

18.000 US $ kostete im Jahr der Vorstellung das Gerät, pro Medium wurden dann 180 US $ fällig. Heute sind das ca. 20.420,00 € und 204,20 €.

Eine 250 GB Festplatte aus 2004 lieferte im Durchschnitt 47 MB/s an Lesegeschwindigkeit und 27 MB/s beim Schreiben (Test: Hitachi Deskstar 7K250).

Keine guten Vorzeichen für InPhase.

Auch wenn man neue Geräte im zwei Jahres Rhythmus und demnächst mit 1.600 GB Kapazität, und 120 GB/s (ja, Gigabyte!) beim Lesen plante, wurde aus den ganzen Versprechungen nicht viel.

Man kaufte im Jahr 2010 zwar noch Technik für die holographischen Medien von Hitachi Maxell ab, geriet man im Jahr darauf in die Insolvenz.

Akonia Holographics, heute eine Tochter von Apple Inc., erwarb 2012 das gesamte Geistige Eigentum und einiges an Ausrüstung.

Das war es für heute und demnächst geht es mit IBMs neuer Schallplatte weiter

Das soll es fürs erste gewesen sein.

Ich wünsche euch erholsame Feiertage und viel Spaß beim Geschenke auspacken

Euer Andi

Zuletzt bearbeitet: