solte das system wirklich in der umsetzung funktionieren wäre es für mich ein starker kaufgrund und wechselgrund, beim nächst möglichen aufrüstung in kombination mit einem i5.

ATI und NVIDIA ermöglichen es beide ja auch schon teilw. zu stromsparzwecken, aber bei ati dann leider auch nur in kombination mit bestimmten karten ... intel könnte die boards billiger herstellen und man kann in alle richtungen aufrüsten und variieren ... man ist absolut nichtmehr an die entscheidung gebunden ein sli oder crossfire board kaufen zu wollen und kann sich mehr optionen offen halten ...

ich denke die vergangenheit wie nvidia mit intel rummgesprungen ist mit dem sli hat intel zu diesem schritt bewegt und das wird nvidia im mainboard segment sehr wehtun ... einzig und allein der 9300 chipsatz für mobile geräte ist z.z. interessant nurnoch von nvidia ... und ich denke das wird intel zukünftig auch ändern wollen ... auch wenn erst schätze ich ende 2009/anfang 2010.

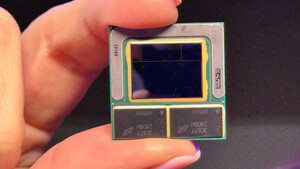

bin echt gespannt ob sich der chip mit der technik festigt ... und er tatsächlich kommen sollte

ATI und NVIDIA ermöglichen es beide ja auch schon teilw. zu stromsparzwecken, aber bei ati dann leider auch nur in kombination mit bestimmten karten ... intel könnte die boards billiger herstellen und man kann in alle richtungen aufrüsten und variieren ... man ist absolut nichtmehr an die entscheidung gebunden ein sli oder crossfire board kaufen zu wollen und kann sich mehr optionen offen halten ...

ich denke die vergangenheit wie nvidia mit intel rummgesprungen ist mit dem sli hat intel zu diesem schritt bewegt und das wird nvidia im mainboard segment sehr wehtun ... einzig und allein der 9300 chipsatz für mobile geräte ist z.z. interessant nurnoch von nvidia ... und ich denke das wird intel zukünftig auch ändern wollen ... auch wenn erst schätze ich ende 2009/anfang 2010.

bin echt gespannt ob sich der chip mit der technik festigt ... und er tatsächlich kommen sollte