Don-DCH

Captain

- Registriert

- Aug. 2009

- Beiträge

- 3.287

Guten Abend,

ich habe mich heute mit Unraid, Docke rund Nginx Proxy Manager beschäftigt.

In vielen teilen bin ich weiter gekommen. Nur beim NPM (Nginx Proxy Manager) stehe ich gerade auf dem Schlauch, daher auch der entsprechende Thread.

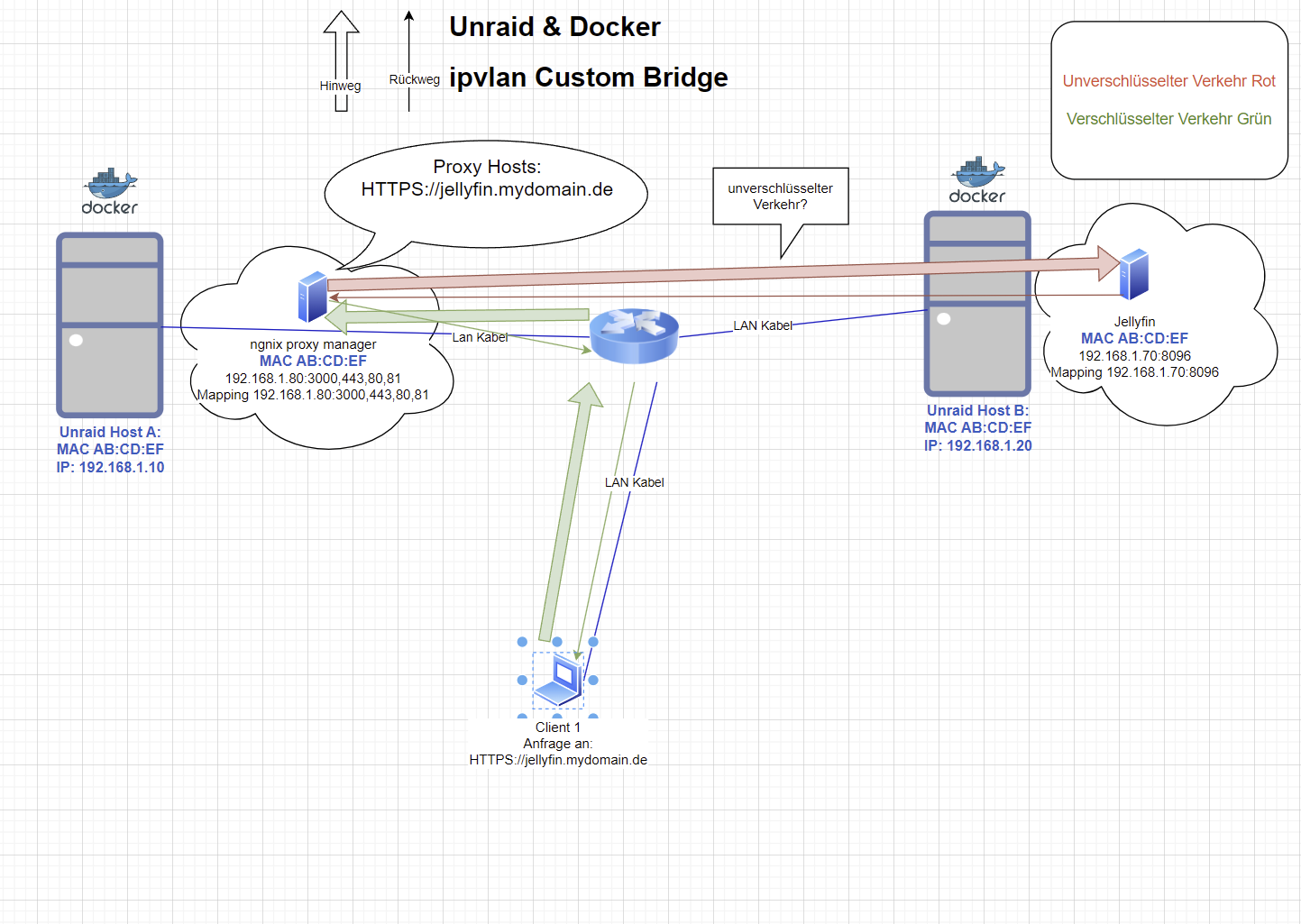

Ausgangssituation

2 Unraid Server nachfolgend Server A und B genannt mit folgenden IPs:

Server A: 192.168.1.10

Server B: 192.168.1.20

Auf Server A läuft Unraid und der NPM (sagen wir mal Custom Bridged mit der IP 192.168.1.80) sowie ein paar Docker Container.

Auf Server B läuft ebenfalls Unraid und kein NPM aber ebenfalls einige Docker Container

Im NPM selbst habe ich ein SSL Zertifikat eingebunden über DNS Challange.

Auf Server B exisiert Beispielsweise ein Container mit Jellyfin.

Dieser hat die IP 192.168.1.70 mit Port 8096 http

Wenn ich jetzt auf Server A unter NPM einen Proxy eintrag gemacht habe:

HTTPS://jellyfin.mydomain.de --> 192.168.1.70:8096

Wie verhält es sich dann, wenn ein Client im Browser HTTPS://jellyfin.mydomain.de aufruft?

Es wird eine gesicherte Verbindung zu dem NPM über den Netzwerkswitch weitergeleitet.

Der NPM schickt die Anfrage UNVERSCHLÜSSELT über HTTP Port 8096 weiter über die Netzwerkinfrastruktur und sämtliche Switche bis er beim Server B angekommen ist, ist das richtig?

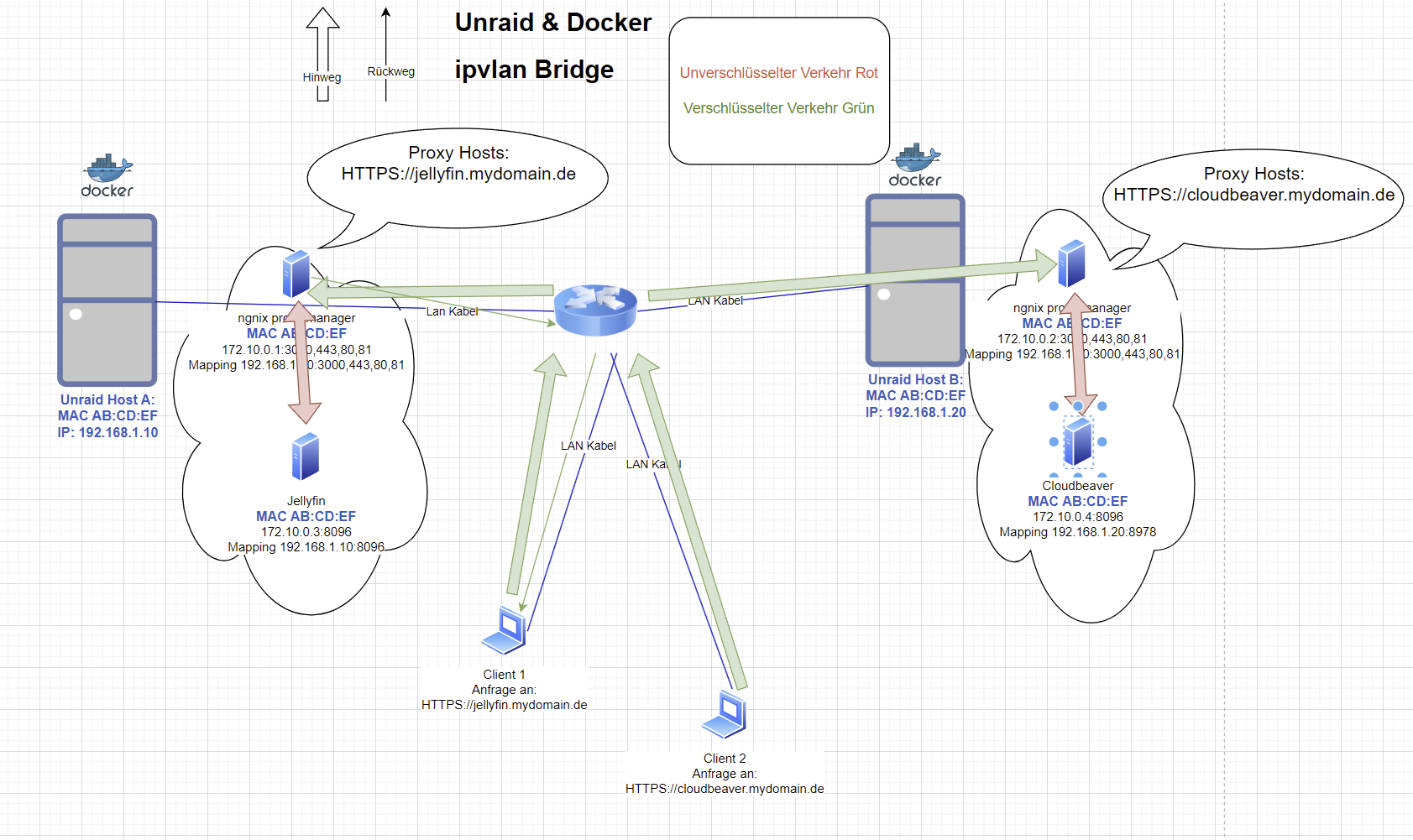

Um jetzt quasi Dauerhaft eine verschlüsselte Verbindung zu haben benötigt man auf beiden Servern NPM und erstellt da den Proxy Host Eintrag auf dem Server, auf dem auch der Zielcontainer ist, wäre das richtig?

Oder ist es sogar so, das man mit Docker Custom Bridge das nicht machen kann, da immer über den Netzwerk Switch oder Router läuft., da ja die einzelnen Docker unter Custom Bridge Abgeschottet sind und so die Container nicht miteinander "reden können"

So das man im Prinzip statt Custom Bridge die Docker Einstellung Bridge benötigt, da es hier dann ein Subnetz wäre? (Zweites Bild)

Ich hoffe sehr, das man meine Frage und Gedankengänge versteht.

Ich habe etwas in Draw.io vorbereitet um das ganze hoffentlich noch verständlicher zu machen.

Zweites Bild:

Viele Grüße und einen schönen Abend zusammen

ich habe mich heute mit Unraid, Docke rund Nginx Proxy Manager beschäftigt.

In vielen teilen bin ich weiter gekommen. Nur beim NPM (Nginx Proxy Manager) stehe ich gerade auf dem Schlauch, daher auch der entsprechende Thread.

Ausgangssituation

2 Unraid Server nachfolgend Server A und B genannt mit folgenden IPs:

Server A: 192.168.1.10

Server B: 192.168.1.20

Auf Server A läuft Unraid und der NPM (sagen wir mal Custom Bridged mit der IP 192.168.1.80) sowie ein paar Docker Container.

Auf Server B läuft ebenfalls Unraid und kein NPM aber ebenfalls einige Docker Container

Im NPM selbst habe ich ein SSL Zertifikat eingebunden über DNS Challange.

Auf Server B exisiert Beispielsweise ein Container mit Jellyfin.

Dieser hat die IP 192.168.1.70 mit Port 8096 http

Wenn ich jetzt auf Server A unter NPM einen Proxy eintrag gemacht habe:

HTTPS://jellyfin.mydomain.de --> 192.168.1.70:8096

Wie verhält es sich dann, wenn ein Client im Browser HTTPS://jellyfin.mydomain.de aufruft?

Es wird eine gesicherte Verbindung zu dem NPM über den Netzwerkswitch weitergeleitet.

Der NPM schickt die Anfrage UNVERSCHLÜSSELT über HTTP Port 8096 weiter über die Netzwerkinfrastruktur und sämtliche Switche bis er beim Server B angekommen ist, ist das richtig?

Um jetzt quasi Dauerhaft eine verschlüsselte Verbindung zu haben benötigt man auf beiden Servern NPM und erstellt da den Proxy Host Eintrag auf dem Server, auf dem auch der Zielcontainer ist, wäre das richtig?

Oder ist es sogar so, das man mit Docker Custom Bridge das nicht machen kann, da immer über den Netzwerk Switch oder Router läuft., da ja die einzelnen Docker unter Custom Bridge Abgeschottet sind und so die Container nicht miteinander "reden können"

So das man im Prinzip statt Custom Bridge die Docker Einstellung Bridge benötigt, da es hier dann ein Subnetz wäre? (Zweites Bild)

Ich hoffe sehr, das man meine Frage und Gedankengänge versteht.

Ich habe etwas in Draw.io vorbereitet um das ganze hoffentlich noch verständlicher zu machen.

Zweites Bild:

Viele Grüße und einen schönen Abend zusammen