alles muss versteckt sein.

Oder, wie Goliath auszog, die Welt zu erobern.

Mittlerweile sind mehrere Monate ins Land gezogen und Intels Grafikkarten-Portfolio ist vollständig veröffentlicht worden. So kamen jetzt die Arc A580 auf den Markt, mit reichlich Verspätung und einer starken Konkurrenz seitens AMD und nVidia.

Und, oh Wunder, auch die kleinste Arc in Form der A310 ist jetzt auf dem deutschen Markt erhältlich.

Für günstige hust 120€ inkl. Versand konnte ich nicht nein sagen.

Beim ersten Blick stellt sich hier die Frage: wofür?

Und beim zweiten: echt jetzt?

Warum diese provokativen Worte? Weil wir hier von 75* W TDP und einer Low-Profile-Karte mit zwei Slots Bauhöhe sprechen.

Und in diesem Bereich tummeln sich schon die neuen Radeon iGPUs aus dem Hause AMD. Also schauen wir mal, ob diese Karte doch irgendwie eine Daseinsberechtigung hat.

*den 30 W Wert bei Geizhals kann man ignorieren

Die Arc ähnelt in der Rechenleistung einer Radeon 680M, wie sie z.B. im Ryzen 7 6800H Verwendung findet. Nur bei der Texel Leistung (@ heimlicher CB-User: Rasterleistung) kann sie sich mit großem Abstand an die Spitze setzen, 50% beträgt dieser, und auch der Vorsprung bei der Speicherbandbreite von 60% ist nicht zu verachten, kann die RDNA2 Architektur es hier doch nicht durch den Infinity Cache ausgleichen. Ob die Arc Karten einen so großen L3 Cache von 16 MB wie die DG1 aka Xe GPUs haben, konnte ich leider nicht in Erfahrung bringen.

Dieser existiert schlicht nicht in den mobilen Ablegern, was aber kein Nachteil sein muss (siehe Test im Lenovo).

Während man also die Xbox Series S in den TFLOPs schlagen kann, liegen die Series X und Playstation 5 uneinholbar vorne.

Vorteil der Arc ist hier klar die Lautstärke, die trotz nur zwei 50mm Lüfter auch unter Last sehr leise agieren. Die anvisierten 75 W TDP dürften auch mit dem Overclocking von 250 MHz auf der GPU in keinem Szenario erreicht werden, denn selbst die A380 trägt das 75 W Siegel. Beide Daten sind dabei aus der Intel eigenen Datenbank entnommen.

Damit kann der Angriff auf die beiden Platzhirsche beginnen, die Treiber haben in den letzten Monaten ja auch immer wieder Fortschritte erlebt und selbst die angestaubte DG1 von Gunnir verrichtet wieder ihren Dienst, als wäre nichts gewesen.

Zur Erinnerung: diese Karte hatte ich letztes Jahr vorgestellt und nachdem ich einen Beta Treiber installiert hatte, wollte dieses gute Stück nichts mehr machen. Windows Neuinstallation könnte helfen? Fehlanzeige. Zur Strafe verschwand sie in der Schublade.

Nachdem ich gebeten wurde, diese auch mal mit einem Core 2 Duo auszuprobieren (kleiner Spoiler: funktioniert nicht und ist damit auch keine Hilfe für neue Videoformate) setzte der Basteldrang wieder ein, aber noch blieb die Karte im Schrank. Erst mit erscheinen der A310 wurde auch die DG1 reaktiviert.

Und wie durch ein Wunder funktionieren, beide Karten auf Anhieb – fast. Denn während zumindest die Gunnir letztes Jahr noch in BOINC einen Marathon vollzog, war dieses Jahr Sense, Ende im Gelände, ist nicht.

Naja, man kann nicht alles haben.

Während die Treiber hier (noch) laufen, treiben mich die Intel „eigenen“ bei der Vega M wiederum in den Wahnsinn, aber das ist eine andere Geschichte.

Hardware:

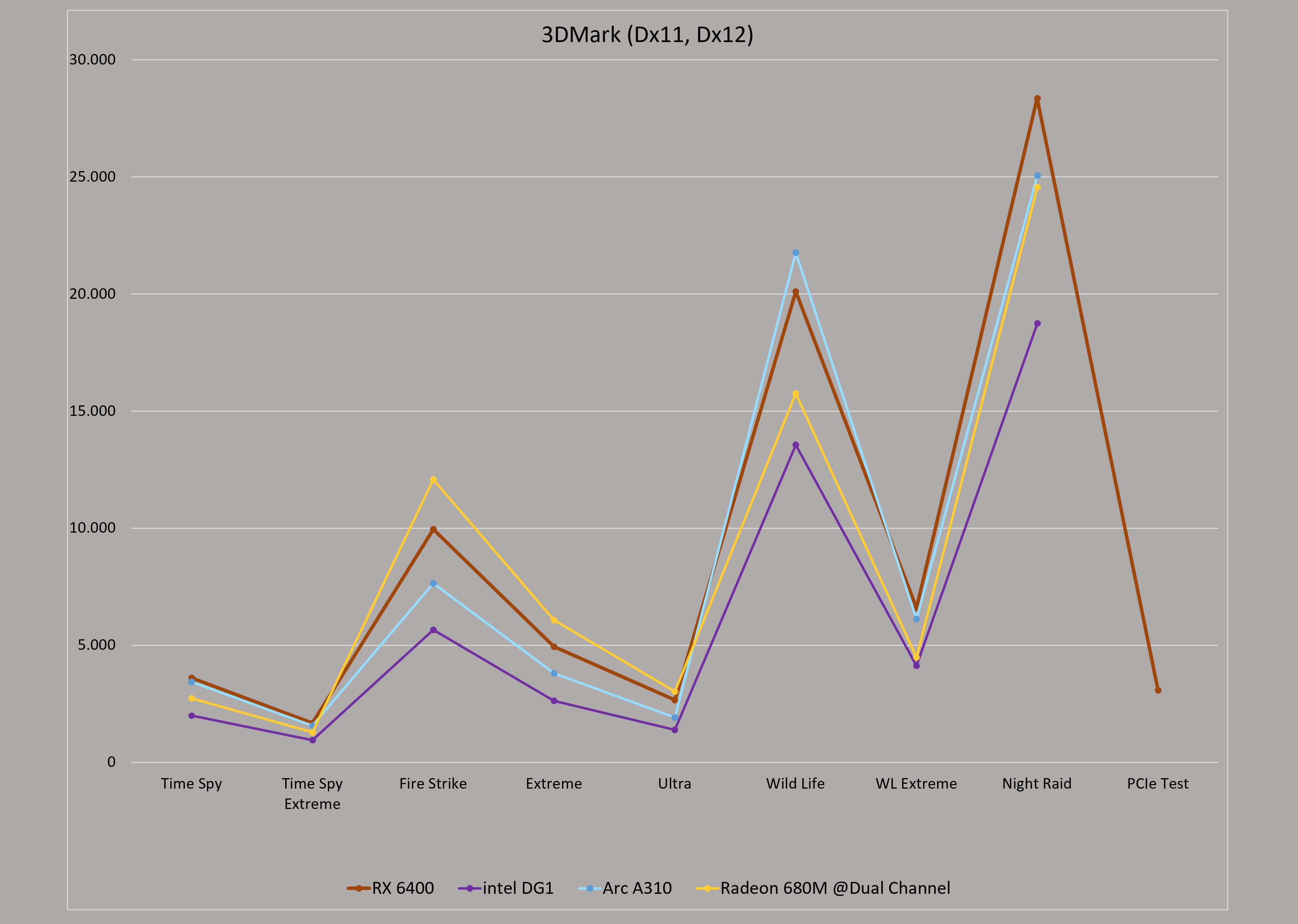

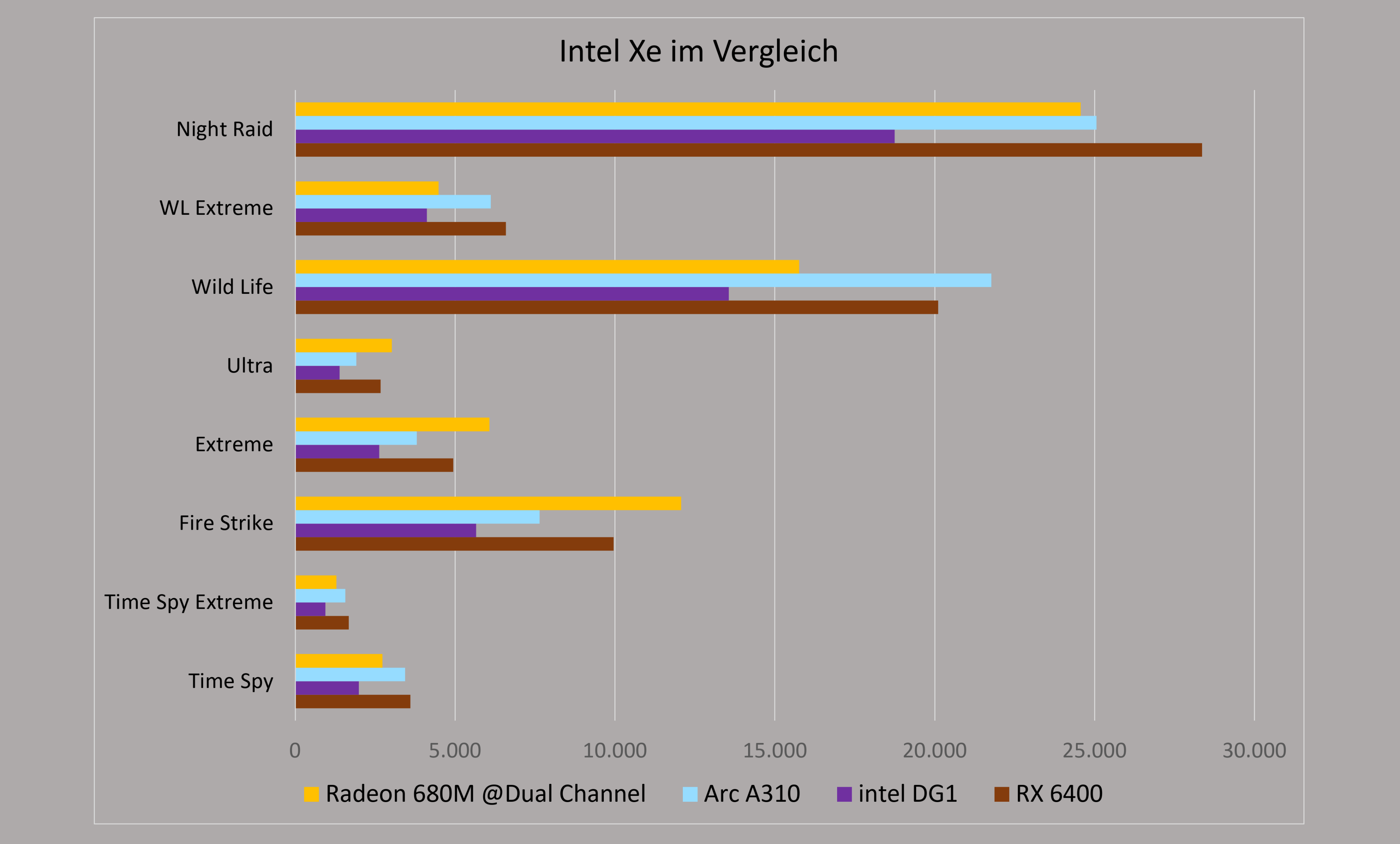

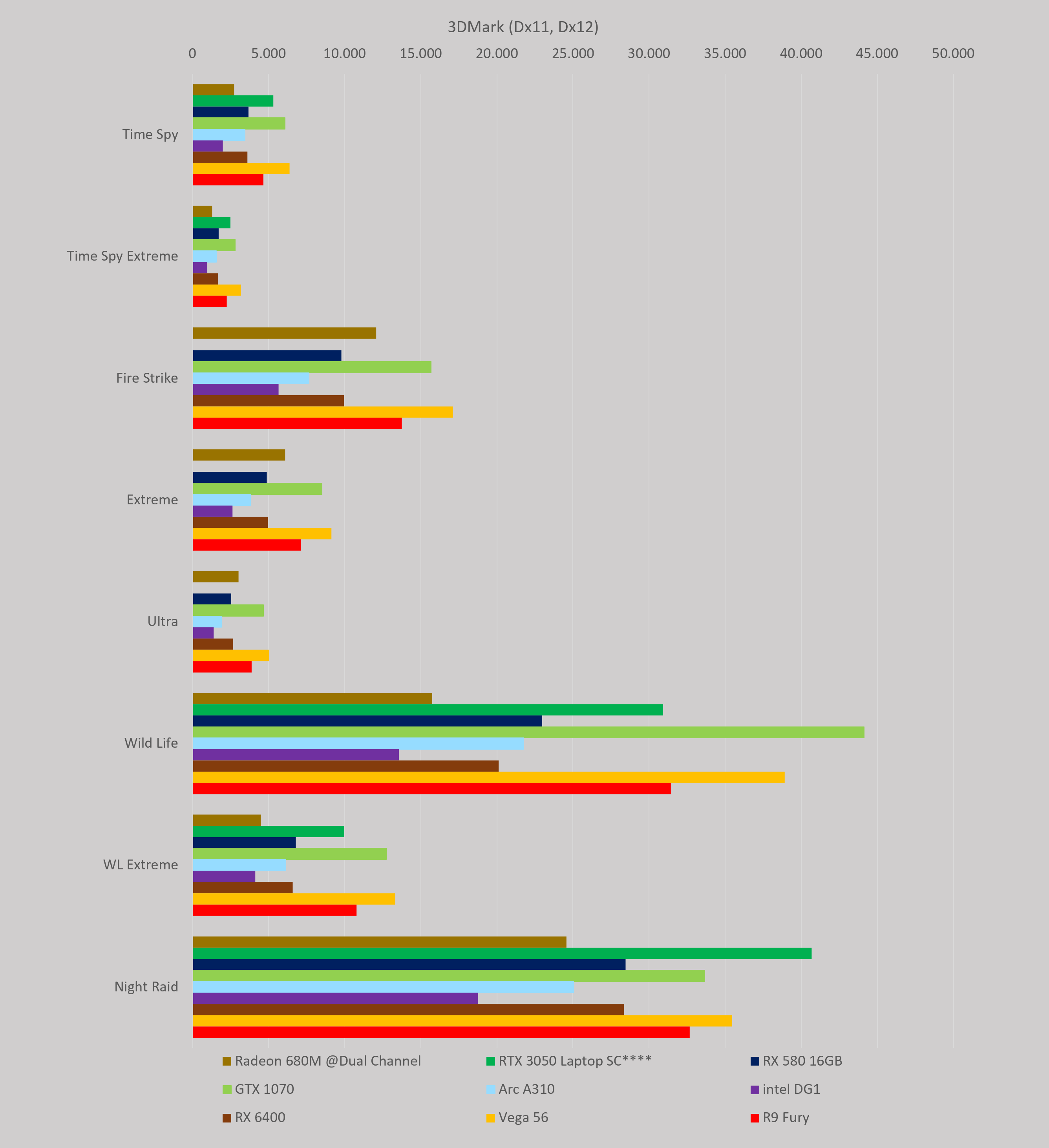

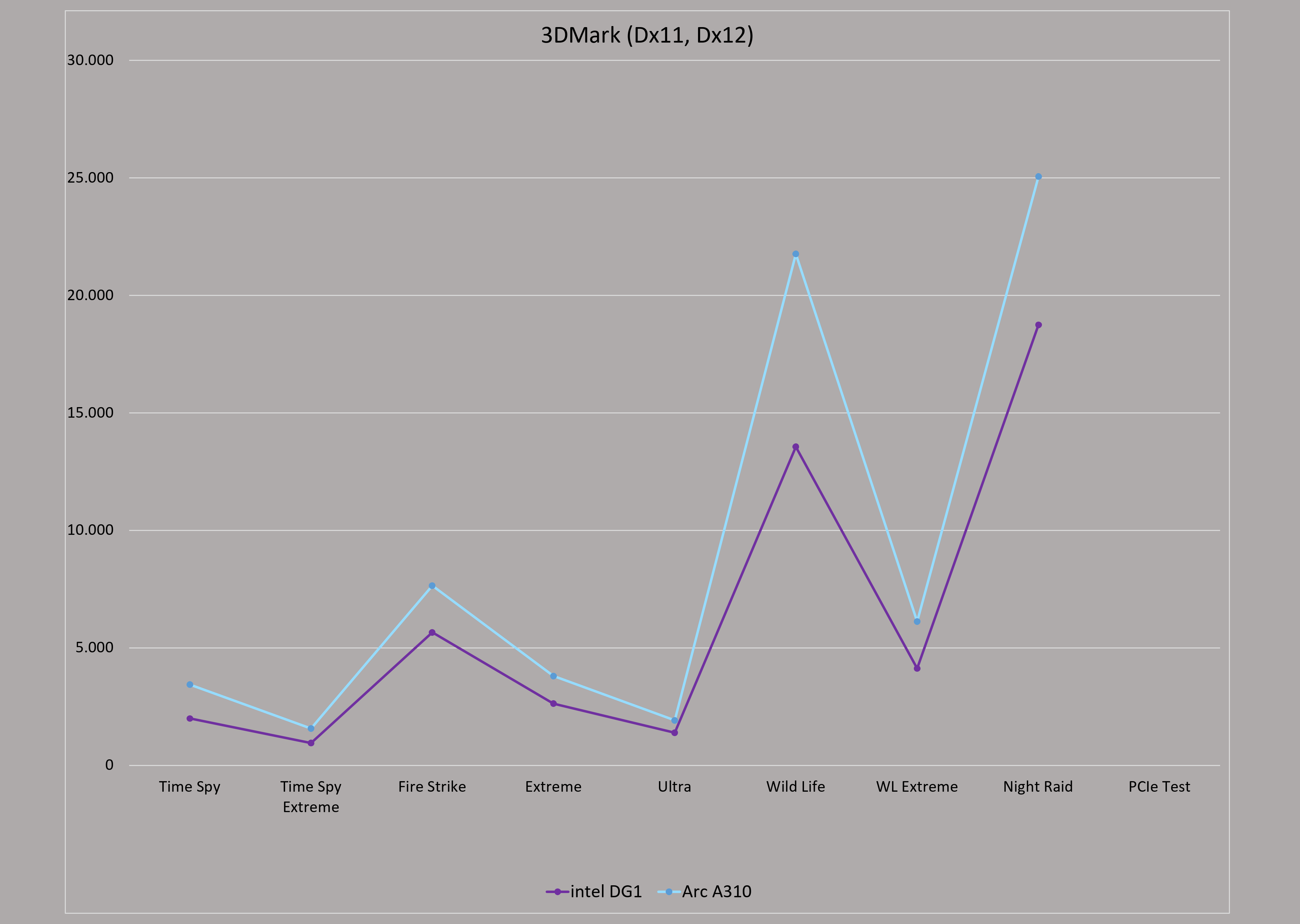

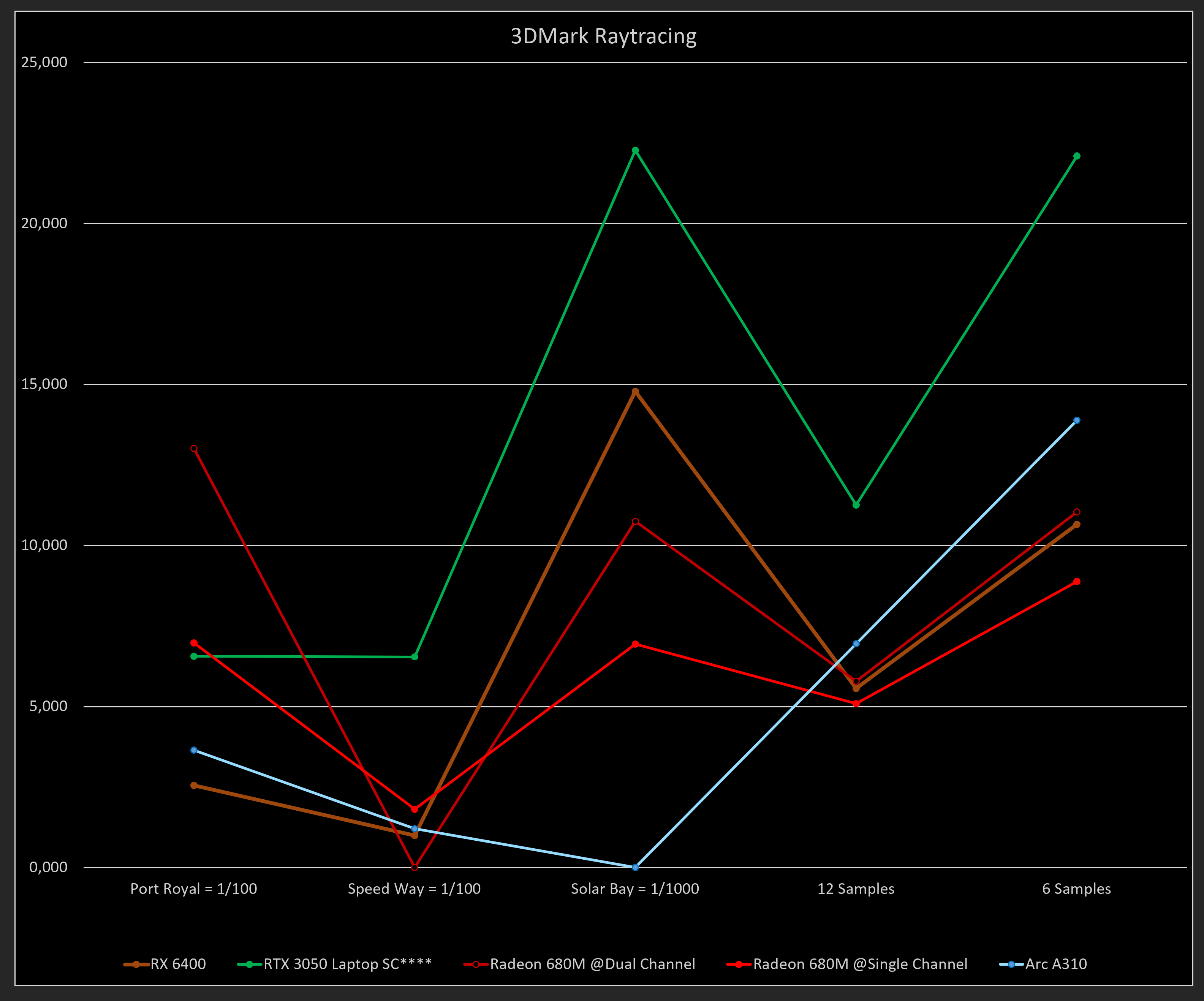

In den Benchmarks zeigt sich dann auch ein sehr gemischtes Gefühl. Im 3DMark ist man mal in Schlagdistanz zur RX 6400, mal überholt man diese und mal wird man selbst von der iGPU Radeon 680M geschlagen.

In den Raytracing Benchmarks liegt man immer vor der kleinen RX 6400, außer in Solar Bay, dieser wollte partout nicht starten. Während also dieser Vulkan-API Benchmark nicht läuft, liegt man in den anderen beiden Vulkan Benchmarks Wild Life und Wild Life Extreme auf Augenhöhe – mhh.

So nebenbei läuft die 680M nicht mit Speed Way, während sich die RX 6400 noch durchkämpft. Beide basieren auf der RDNA 2 Architektur, beide nutzen 12 Cus.

AMD und UL, warum?

Inhaltsangabe

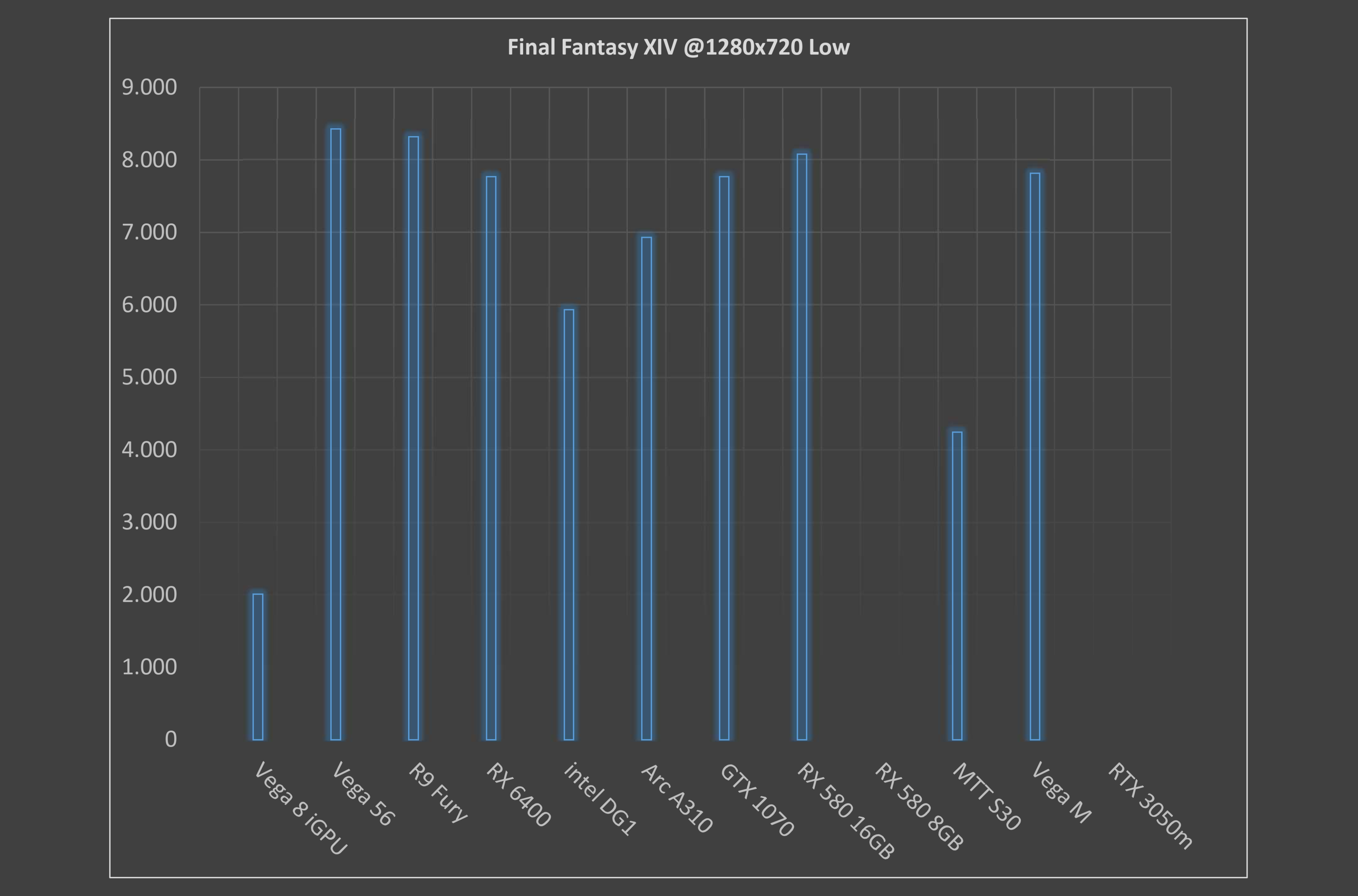

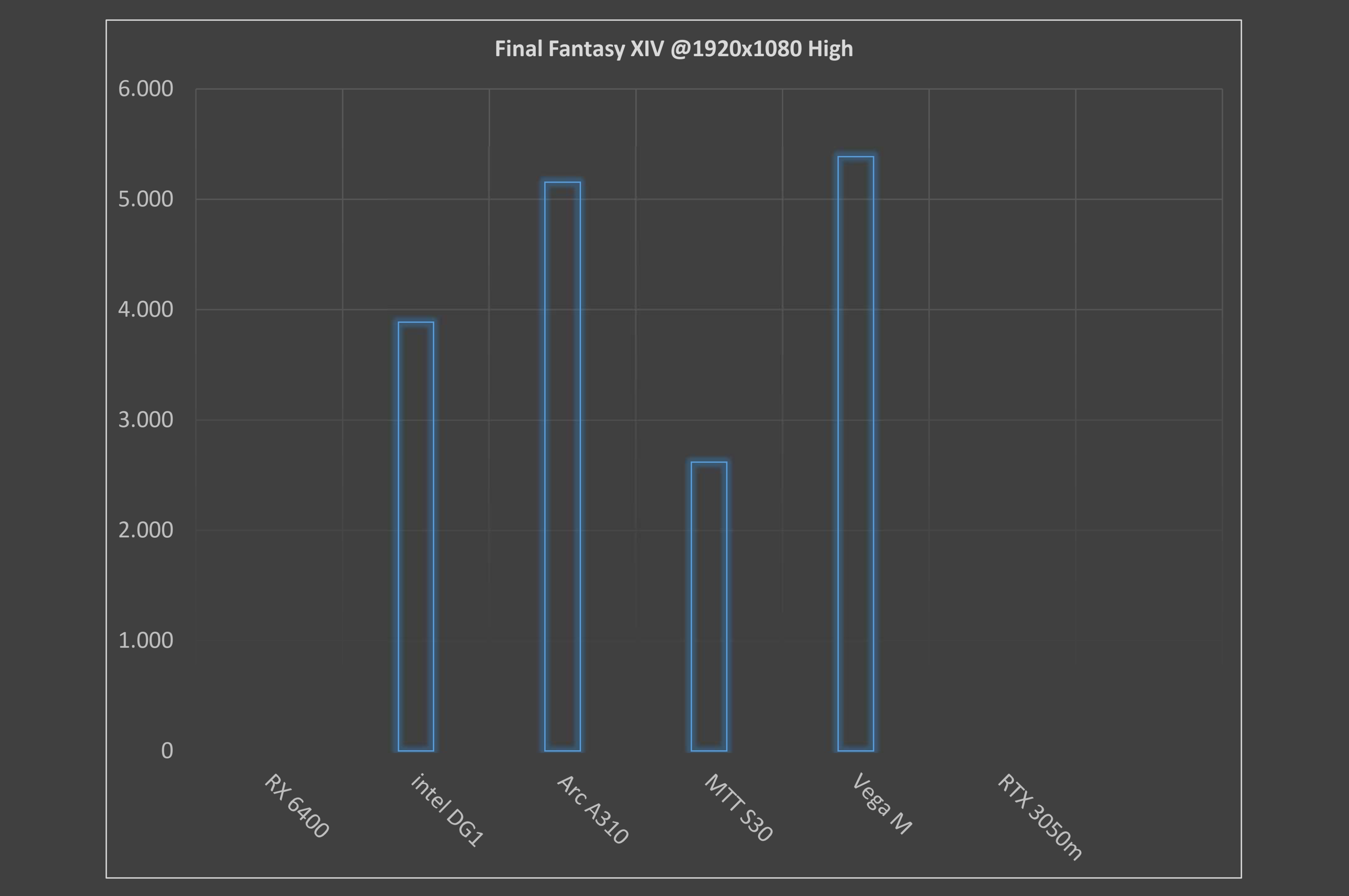

Im älteren Final Fantasy XIV sind die Voraussetzungen zwar geringer, aber auch hier gibt man sich der RX 6400 klar geschlagen und liegt auch hinter der Vega M.

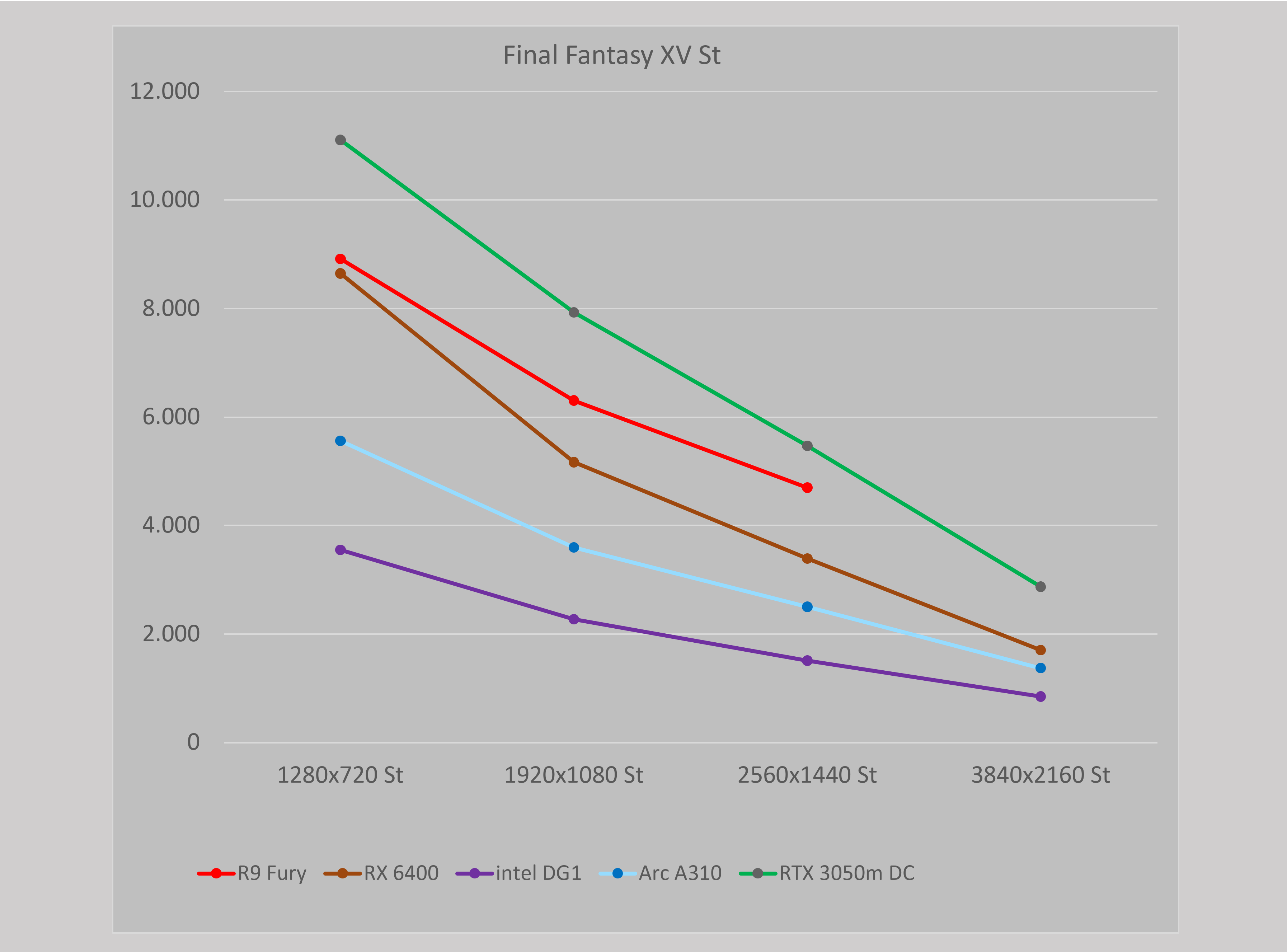

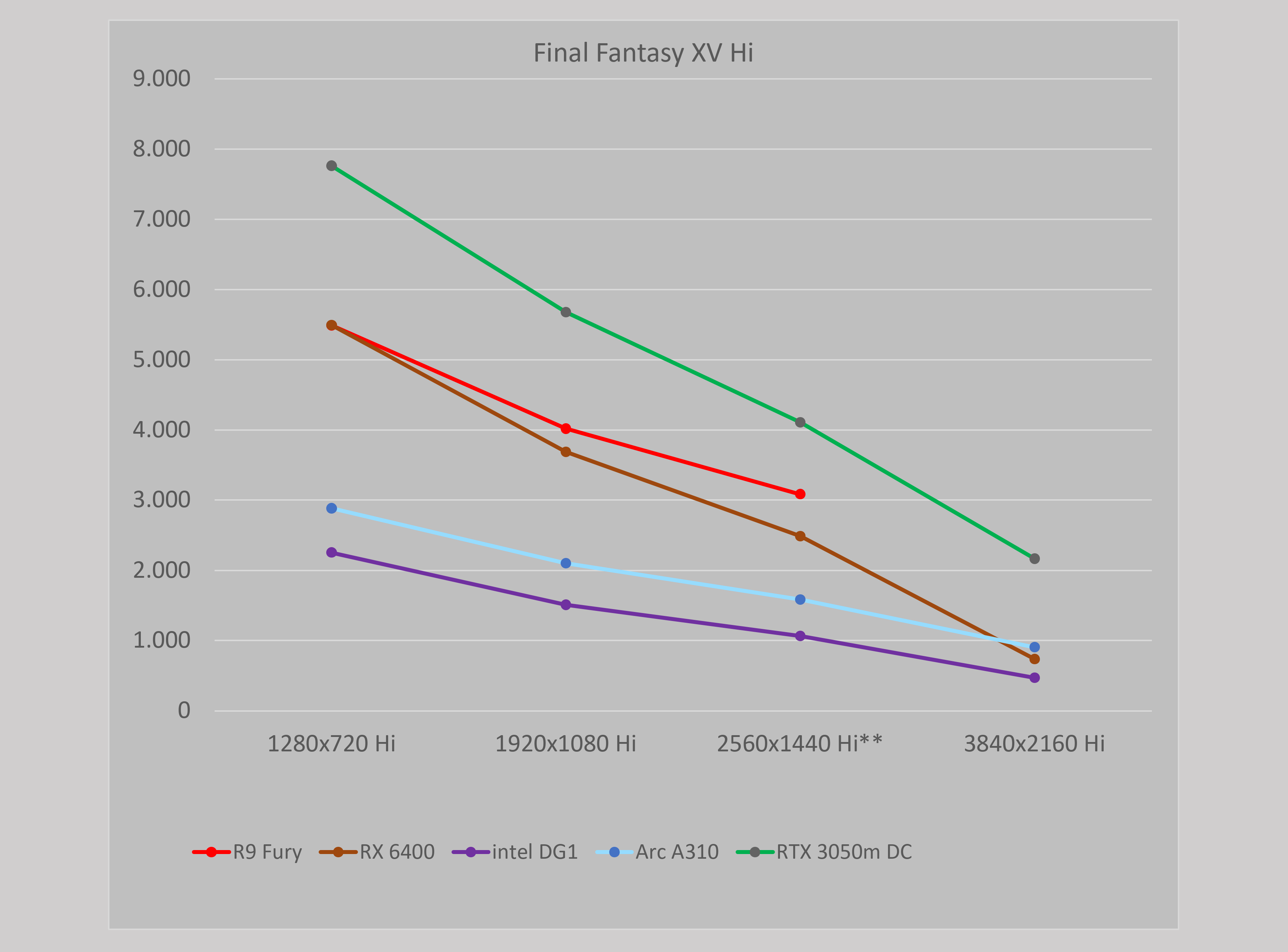

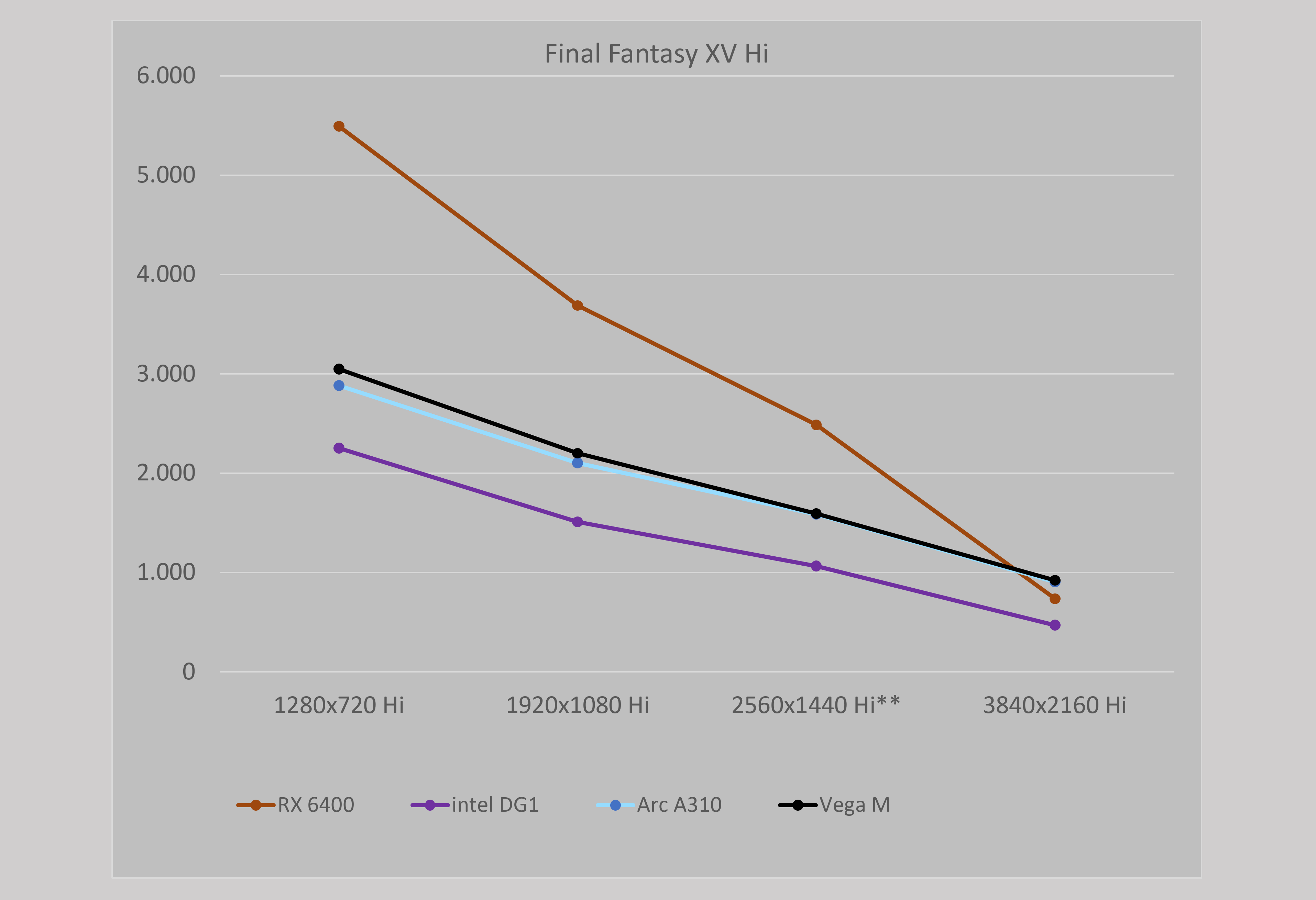

Inhaltsangabe

Final Fantasy XV sieht die Karte in der Einstellung High in allen vier Auflösungen knapp auf Augenhöhe mit der Vega M, die noch einen alten Polaris 22 Chip mit 20 Cus und 4 GB HBM2 nutzt.

Inhaltsangabe

Inhaltsangabe

Hier liegt die Radeon 680M im Ryzen 7 teils noch vor der diskreten Variante RX 6400 - die iGPU kann sich stärker beim RAM bedienen und ist nicht durch die 4 GB der 6400 begrenzt.

Inhaltsangabe

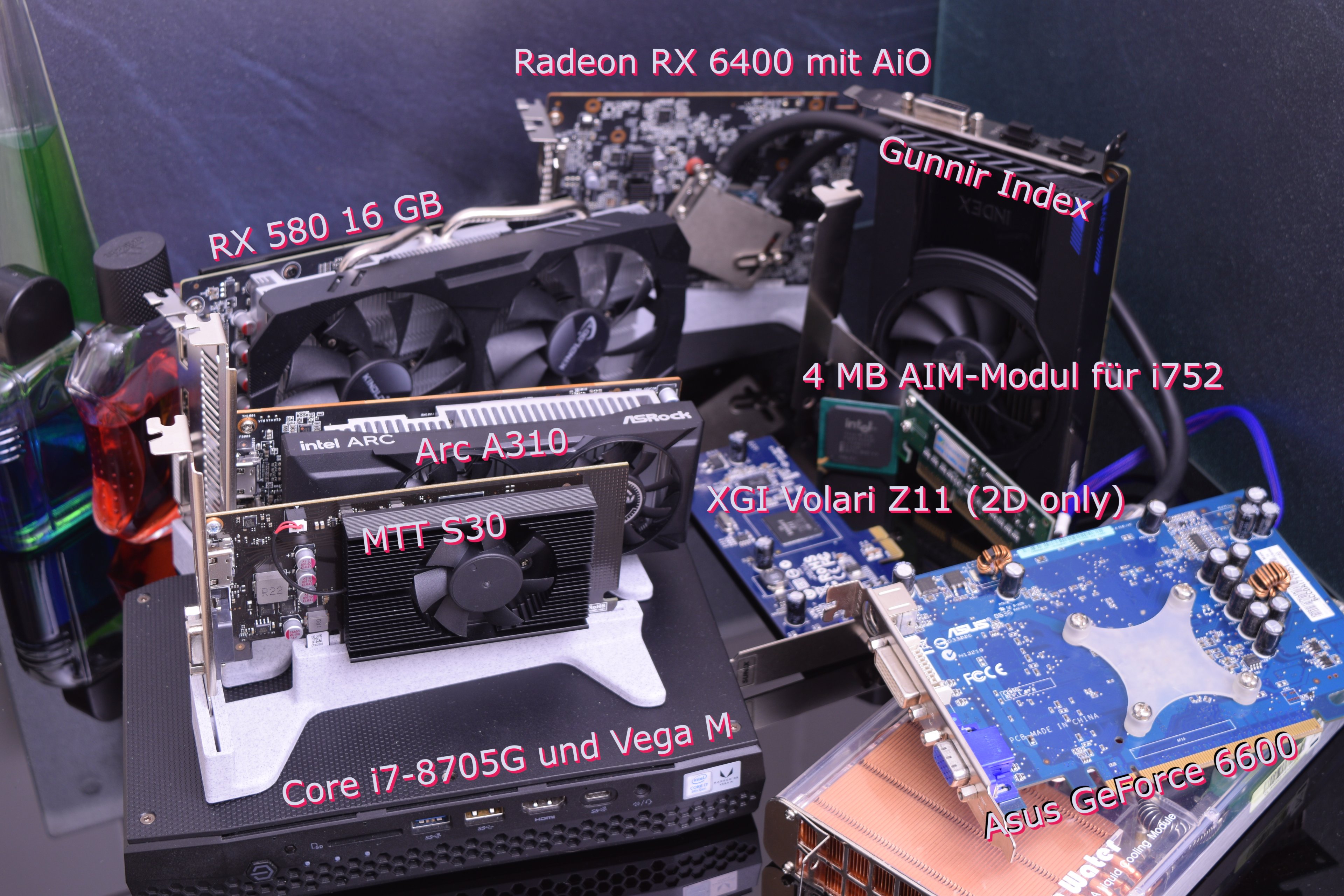

In meinem Kuriositätenkabinett haben sich mittlerweile einige Karten angesammelt. Die A310 gehört mit ihrer Ausstattung und Leistung sicherlich auch dazu. Einerseits bietet man moderne Hardware, Stichwort AV1, andererseits bietet man Leistung, die teilweise sogar von einer Vega M, einem alten Polaris Chip, überboten wird.

Ich sehe kein vernünftiges Arbeitsgebiet für diese Arc Variante. Entweder man greift zur stärkeren A380, die es auch als Low Profile Variante gibt oder man nutzt gleich die Radeon RX 6400, die wenigstenes auch Single Slot Variante erhältlich ist.

Solange es keine AMD APUs mit RDNA2 und mehr als 12 CUs im Desktop gibt, hat sie wenigstens noch ein kleines Einsatzgebiet. Als reines Wiedergabemedium überzeugt sie in meinen Augen nicht, dafür ist sie mit 110 - 120€ einfach zu teuer.

Wo seht Ihr das Einsatzgebiet? Als Zusatzkarte, um AV1 etc. zu kodieren/dekodieren?

---

Gunnir Index aka Intel DG1 und A310

---

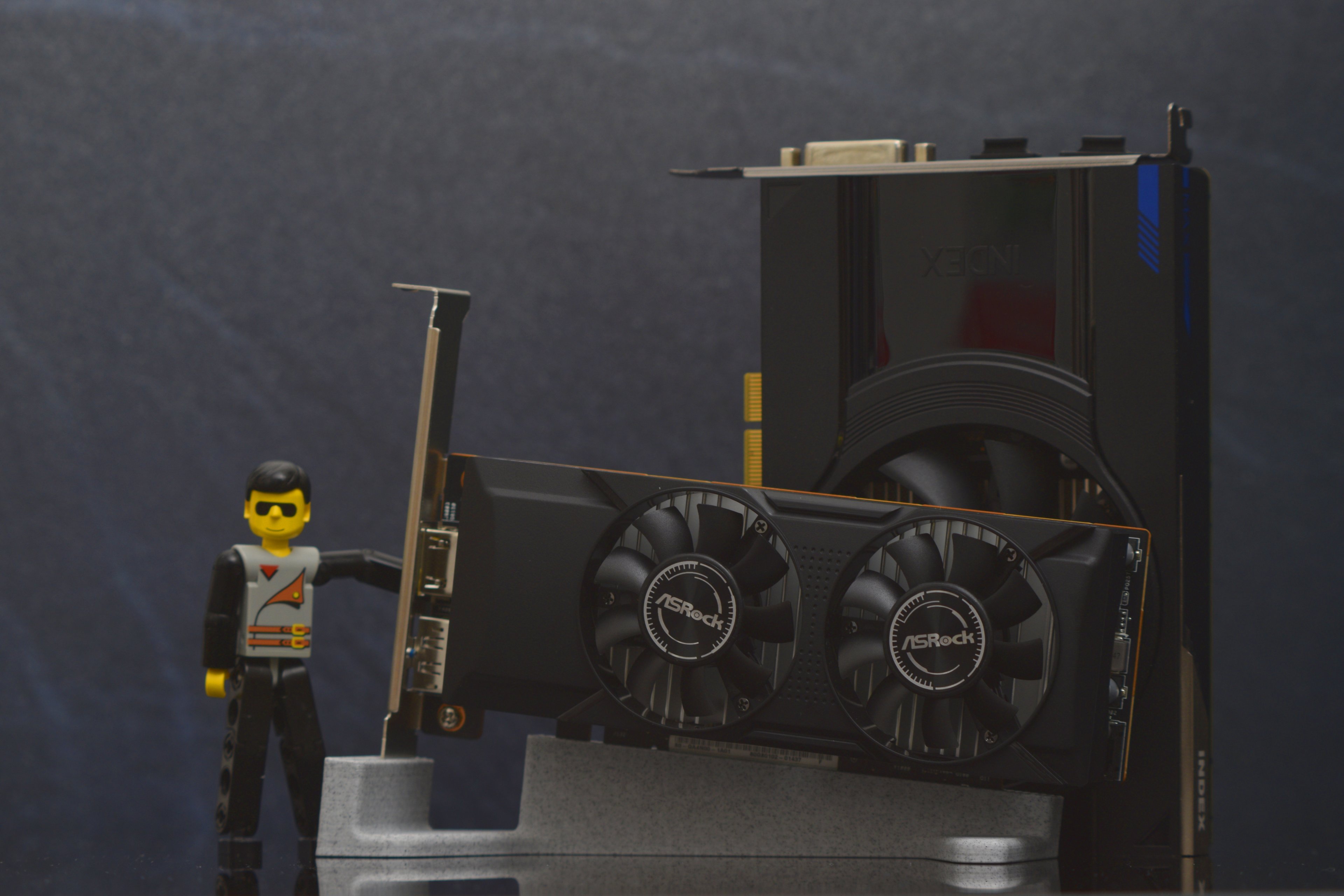

Während die Arc neben der RX 580 16 GB klein wirkt

wird dieses noch von der MTT S30 getoppt

---

Diverse Kuriositäten.

Während die Gunnir immerhin noch einen DVI bereitstellt, ist es bei der MTT S30 sogar VGA, was dem Anwender geboten wird.

Oder, wie Goliath auszog, die Welt zu erobern.

Arc A310 und Radeon RX Vega 56 im Stillen vereint

Inhaltsangabe

Einleitung

Mittlerweile sind mehrere Monate ins Land gezogen und Intels Grafikkarten-Portfolio ist vollständig veröffentlicht worden. So kamen jetzt die Arc A580 auf den Markt, mit reichlich Verspätung und einer starken Konkurrenz seitens AMD und nVidia.

Und, oh Wunder, auch die kleinste Arc in Form der A310 ist jetzt auf dem deutschen Markt erhältlich.

Für günstige hust 120€ inkl. Versand konnte ich nicht nein sagen.

Beim ersten Blick stellt sich hier die Frage: wofür?

Und beim zweiten: echt jetzt?

Warum diese provokativen Worte? Weil wir hier von 75* W TDP und einer Low-Profile-Karte mit zwei Slots Bauhöhe sprechen.

Und in diesem Bereich tummeln sich schon die neuen Radeon iGPUs aus dem Hause AMD. Also schauen wir mal, ob diese Karte doch irgendwie eine Daseinsberechtigung hat.

*den 30 W Wert bei Geizhals kann man ignorieren

Nähere Betrachtung der techn. Daten

Die Arc ähnelt in der Rechenleistung einer Radeon 680M, wie sie z.B. im Ryzen 7 6800H Verwendung findet. Nur bei der Texel Leistung (@ heimlicher CB-User: Rasterleistung) kann sie sich mit großem Abstand an die Spitze setzen, 50% beträgt dieser, und auch der Vorsprung bei der Speicherbandbreite von 60% ist nicht zu verachten, kann die RDNA2 Architektur es hier doch nicht durch den Infinity Cache ausgleichen. Ob die Arc Karten einen so großen L3 Cache von 16 MB wie die DG1 aka Xe GPUs haben, konnte ich leider nicht in Erfahrung bringen.

Dieser existiert schlicht nicht in den mobilen Ablegern, was aber kein Nachteil sein muss (siehe Test im Lenovo).

Während man also die Xbox Series S in den TFLOPs schlagen kann, liegen die Series X und Playstation 5 uneinholbar vorne.

Vorteil der Arc ist hier klar die Lautstärke, die trotz nur zwei 50mm Lüfter auch unter Last sehr leise agieren. Die anvisierten 75 W TDP dürften auch mit dem Overclocking von 250 MHz auf der GPU in keinem Szenario erreicht werden, denn selbst die A380 trägt das 75 W Siegel. Beide Daten sind dabei aus der Intel eigenen Datenbank entnommen.

Tabelle

| RX 6400 | Vega 8 | Vega M | intel DG1 | intel Arc A310 | GeForce RTX 3050 Laptop | Radeon 680m | MTT S30 | |

| Date | 04/2022 | 01/2019 | 02/2018 | 10/2020 | 10/2023 | 2023 | ||

| Architecture | RDNA 2 | GCN 5.0 | GCN 4.0 | Gen 12 | Gen 12.7, Alchemist | Ampere | RDNA 2 | MUSA |

| Codename | Navi 24 | Raven | Polaris 22 | Iris Xe | DG2-128 | GA107 | Rembrandt+ | |

| Operation Area: | Notebook originally | APU Notebook | SoC Notebook/NUC | Notebook originally | Desktop | Notebook | iGPU | |

| Manufacturing Process | 6 nm | 12+ nm | 14 nm | 10 nm | 6 nm | 8 nm | 6 nm | 12 nm |

| Transistor count | 5,4 Mrd. | ca. 4,94 Mrd. | 5,0 Mrd. | --- | 7,2 Mrd. | 8,7 Mrd. | 13,1 Mrd. | |

| DIE size | 107 mm² | ca. 210 mm² | 208 mm² | 95 mm² | 157 mm² | 200 mm² | 208 mm² | |

| TDP | 53 W | ca. 15 W | 65 W | 25 W | max. 75 W | 45 W | 45 W | 40 W |

| Clock Speed GPU | 1.923 / 2.321 MHz | 300 / 1.200 MHz | 931 / 1.011 MHz | 300 / 1.650 MHz | 2.000+ MHz | 1.065 / 1.343 MHz | 2.200 MHz | 1.300 MHz |

| ROPs | 32 | 8 | 32 | 24 | 32 | 32 | 32 | |

| Pixel fillrate | 74,27 GP/s | ca. 8,8 GP/s | 32,35 GP/s | 39,6 GP/s | 78,4 GP/s | 42,98 GP/s | 70,40 GP/s | |

| Cus | 12 | 8 | 20 | 6 | 6 ? | 16 | 12 | |

| Shader | 768 | 512 | 1.280 | 768 | 768 | 2.048 | 768 | 1.024 |

| TMUs | 48 | 32 | 80 | 48 | 64 | 64 | 48 | |

| Texel fillrate | 111,4 GT/s | ca. 35,2 GT/s | 80,88 GT/s | 79,2 GT/s | 156,8 GT/s | 85,95 GT/s | 105,6 GT/s | |

| TFLOPS: | ||||||||

| FP16 | 7,13 | ca. 2,253 | 2,588 | 5,069 | 6,14 | 5,501 | 6,758 | |

| FP32 | 3,565 | ca. 1,126 | 2,588 | 2,534 | 3,07 | 5,501 | 3,379 | 2,6 |

| Memory size | 4 GB | 2 GB / Shared | 4 GB | 4 GB | 4 GB | 4 GB | Shared | 4 GB |

| Type | GDDR6 | Shared DDR4-2400 | HBM2 | LPDDR4X | GDDR6 | GDDR6 | Shared DDR5-4800 | LPDDR4X |

| Memory clock | 2.000 MHz (8.000 MHz) | 2.400 MHz | 700 MHz | 2.133 MHz | 1.937 MHz (7.748 MHz) | 1.500 MHz (6.000 MHz) | 4.800 MHz | |

| Memory interface | 64 Bit | 2x 64 Bit | 1024 Bit | 128 Bit | 64 Bit | 128 Bit | 128 Bit | 128 Bit |

| Memory bandwidth | 128 GB/s | 38 GB/s | 179,2 GB/s | 68,26 GB/s | 124 GB/s | 192 GB/s | 77 GB/s | |

| Infinity Cache | 16 MB @ 416 GB/s | n.a. | n.a. | n.a. | n.a. | n.a. | - | n.a. |

| L1 Cache | 320 KB | ? | 2.048 KB | 128 KB ? | ||||

| L2 Cache | 1.024 KB | ?? | 1.024 KB | 1.024 KB | 4.096 KB | 2.048 KB | 2.048 KB | |

| L3 Cache | n.a. | 4 MB (CPU only?) | n.a. | 16 MB | ? | 16 MB (CPU only?) | ||

| CPU | Core i3 10105 (4C/8T) | Zen+ (4C/8T) | Core i7 8705G (4C/8T) | Core i3 10105 (4C/8T) | Core i3 10105 (4C/8T) | Zen 3+ (8C/16T) | Zen 3+ (8C/16T) |

Damit kann der Angriff auf die beiden Platzhirsche beginnen, die Treiber haben in den letzten Monaten ja auch immer wieder Fortschritte erlebt und selbst die angestaubte DG1 von Gunnir verrichtet wieder ihren Dienst, als wäre nichts gewesen.

Zur Erinnerung: diese Karte hatte ich letztes Jahr vorgestellt und nachdem ich einen Beta Treiber installiert hatte, wollte dieses gute Stück nichts mehr machen. Windows Neuinstallation könnte helfen? Fehlanzeige. Zur Strafe verschwand sie in der Schublade.

Nachdem ich gebeten wurde, diese auch mal mit einem Core 2 Duo auszuprobieren (kleiner Spoiler: funktioniert nicht und ist damit auch keine Hilfe für neue Videoformate) setzte der Basteldrang wieder ein, aber noch blieb die Karte im Schrank. Erst mit erscheinen der A310 wurde auch die DG1 reaktiviert.

Und wie durch ein Wunder funktionieren, beide Karten auf Anhieb – fast. Denn während zumindest die Gunnir letztes Jahr noch in BOINC einen Marathon vollzog, war dieses Jahr Sense, Ende im Gelände, ist nicht.

Naja, man kann nicht alles haben.

Während die Treiber hier (noch) laufen, treiben mich die Intel „eigenen“ bei der Vega M wiederum in den Wahnsinn, aber das ist eine andere Geschichte.

Testsystem

Hardware:

- Core i3 10105 (4C/8T)

- 24 GB DDR4 @2.133 MHz von Crucial

- OS und Games: Samsung 1 TB SSD

- Asus Prime B560M-A

- Endorfy gehäuse und AiO

- Grafikkarten:

- ASRock Radeon RX 6400

- Sapphire Nitro R9 Fury

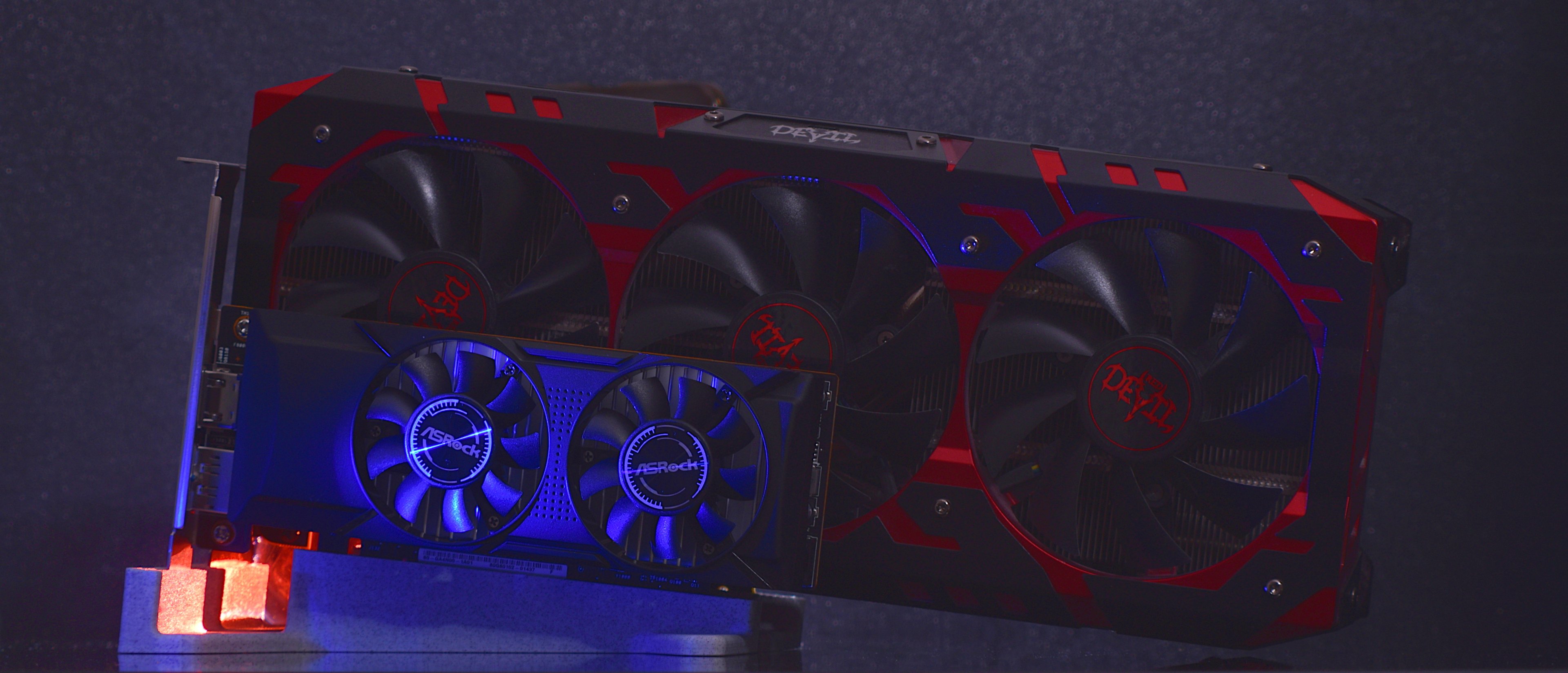

- Power Color Red Devil Radeon RX Vega 56

- Gunnir Index: Intel DG1

- Zotac GeForce GTX 1070

- Kinology Radeon RX 580 2048 SP 16 GB

- Radeon 680M und GeForce RTX 3050 Laptop (Test)

- 3DMark von UL (Download)

- Final Fanatsy XIV und XV von Square Enix (Downloads extern: XIV (Techpowerup) und XV (Square Enix))

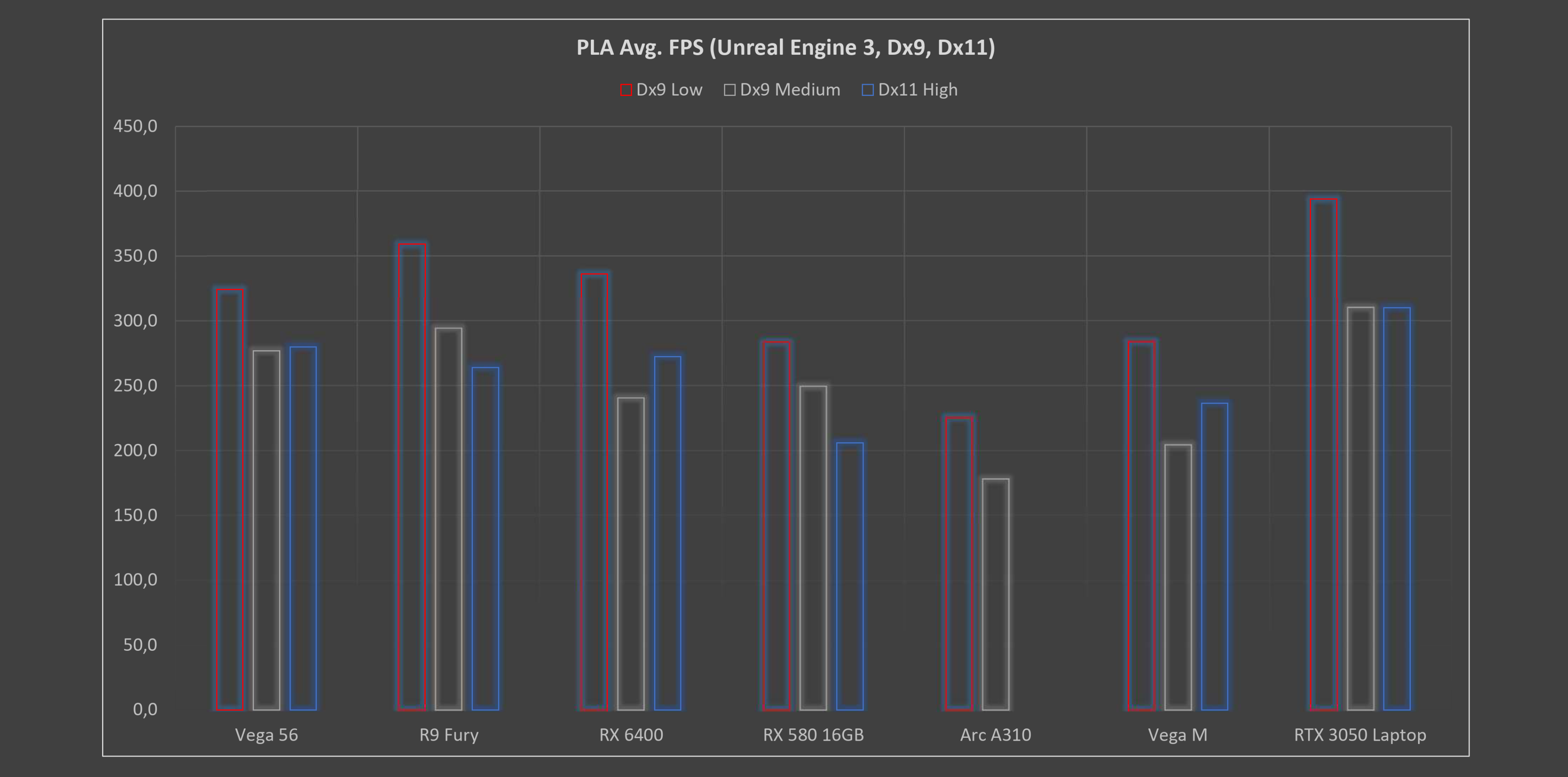

- PLA mit der Unreal Engine 3, DirectX 9 und 11 (Download extern, Techpowerup)

Benchmarks

In den Benchmarks zeigt sich dann auch ein sehr gemischtes Gefühl. Im 3DMark ist man mal in Schlagdistanz zur RX 6400, mal überholt man diese und mal wird man selbst von der iGPU Radeon 680M geschlagen.

In den Raytracing Benchmarks liegt man immer vor der kleinen RX 6400, außer in Solar Bay, dieser wollte partout nicht starten. Während also dieser Vulkan-API Benchmark nicht läuft, liegt man in den anderen beiden Vulkan Benchmarks Wild Life und Wild Life Extreme auf Augenhöhe – mhh.

So nebenbei läuft die 680M nicht mit Speed Way, während sich die RX 6400 noch durchkämpft. Beide basieren auf der RDNA 2 Architektur, beide nutzen 12 Cus.

AMD und UL, warum?

Inhaltsangabe

Intel DG1 gegen Arc A310

Final Fantasy XIV

Im älteren Final Fantasy XIV sind die Voraussetzungen zwar geringer, aber auch hier gibt man sich der RX 6400 klar geschlagen und liegt auch hinter der Vega M.

Inhaltsangabe

Final Fantasy XV

Final Fantasy XV sieht die Karte in der Einstellung High in allen vier Auflösungen knapp auf Augenhöhe mit der Vega M, die noch einen alten Polaris 22 Chip mit 20 Cus und 4 GB HBM2 nutzt.

Inhaltsangabe

PLA (Unreal Engine 3)

Inhaltsangabe

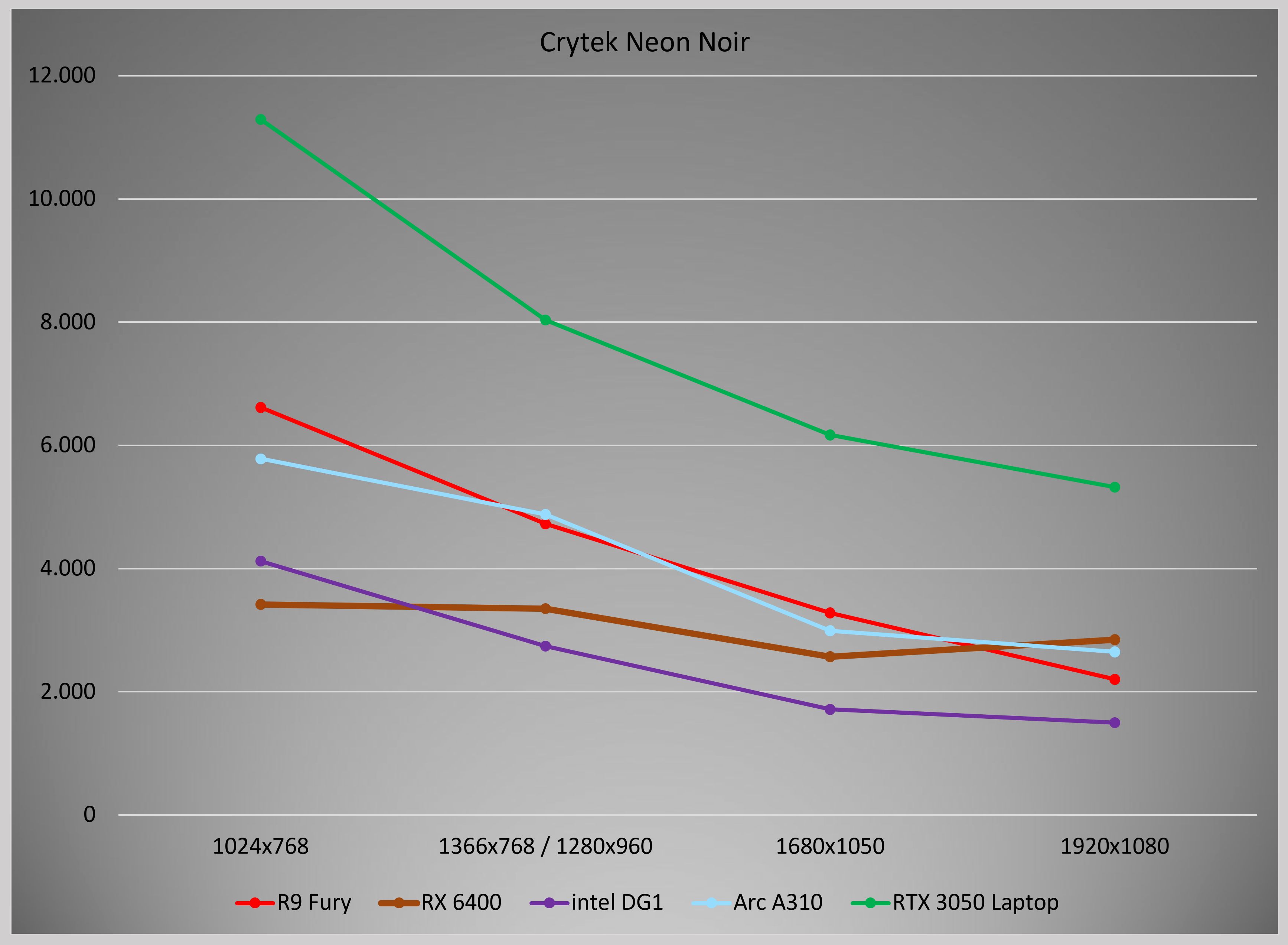

Raytracing in Neon Noir und 3DMark

Hier liegt die Radeon 680M im Ryzen 7 teils noch vor der diskreten Variante RX 6400 - die iGPU kann sich stärker beim RAM bedienen und ist nicht durch die 4 GB der 6400 begrenzt.

Inhaltsangabe

Abschließende Worte

In meinem Kuriositätenkabinett haben sich mittlerweile einige Karten angesammelt. Die A310 gehört mit ihrer Ausstattung und Leistung sicherlich auch dazu. Einerseits bietet man moderne Hardware, Stichwort AV1, andererseits bietet man Leistung, die teilweise sogar von einer Vega M, einem alten Polaris Chip, überboten wird.

Ich sehe kein vernünftiges Arbeitsgebiet für diese Arc Variante. Entweder man greift zur stärkeren A380, die es auch als Low Profile Variante gibt oder man nutzt gleich die Radeon RX 6400, die wenigstenes auch Single Slot Variante erhältlich ist.

Solange es keine AMD APUs mit RDNA2 und mehr als 12 CUs im Desktop gibt, hat sie wenigstens noch ein kleines Einsatzgebiet. Als reines Wiedergabemedium überzeugt sie in meinen Augen nicht, dafür ist sie mit 110 - 120€ einfach zu teuer.

Wo seht Ihr das Einsatzgebiet? Als Zusatzkarte, um AV1 etc. zu kodieren/dekodieren?

Impressionen

---

Gunnir Index aka Intel DG1 und A310

---

Während die Arc neben der RX 580 16 GB klein wirkt

wird dieses noch von der MTT S30 getoppt

---

Diverse Kuriositäten.

Während die Gunnir immerhin noch einen DVI bereitstellt, ist es bei der MTT S30 sogar VGA, was dem Anwender geboten wird.

Zuletzt bearbeitet: