AssassinWarlord

Lt. Commander

- Registriert

- Okt. 2008

- Beiträge

- 1.055

Hab auch mal wieder was...ist zwar schon länger fertig, aber hab halt jetzt erst die Bilder dazu mal vom Handy runtergeladen auf den PC  und will ich euch auch hier nochmal mit zeigen.

und will ich euch auch hier nochmal mit zeigen.

Ich hatte mal vor langer zeit relativ günstig eine PNY GTX1080TI geschossen, mit Blowerkühler und wie sich erst mit dem öffnen der Karte rausstellte - nicht ganz Referenz Design. Der Vorbesitzer hatte da bei einer unsanften CPU Kühler Demontage etliche Teile auf der Rückseite der Karte abgeräumt. Viele Teile konnte ich von Spenderkarten wieder anbringen wie SMD Keramik-Kondensatoren, aber einige SMD Widerstände und kleine Mosfets konnte ich nicht wiederherstellen weil das PCB nur ans Referenz Design angelehnt war, aber dennoch einiges anders war. Schaltpläne dazu gibt's auch keine. Ich hatte über Wochen hinweg versucht die Karte irgendwie wieder zu retten, hatte in der Zwischenzeit verschiedene andere 1080TIs hier wo ich hier und da was abgeschaut hatte bzw. gegen gemessen hatte um die ganzen fehlenden Teile rund um den Original PWM Controller NCP81274 wiederherzustellen um der Karte wieder leben einzuhauchen, aber es gelang mir einfach nicht die Phasen zum starten zu überreden. Auch ein umbau auf UP9511P PWM Controller brachte mich da nicht weiter Auch war noch einiges anderes an der Karte defekt wie ich später rausfand, wie der 1.8V Rail PWM Controller der anscheinend nen internen wackligen hatte - wenn ich draufdrückte hatte ich1.8V, habe ich losgelassen war der wieder aus...aber auch nicht immer. Auch ein neu einlöten des Controllers bzw. BuckConverters brachte nix. Da ich aber keinen passenden Ersatz da hatte habe ich einen externen StepDown für die 1.8V verbaut...kurz und schmerzlos halt

Auch war noch einiges anderes an der Karte defekt wie ich später rausfand, wie der 1.8V Rail PWM Controller der anscheinend nen internen wackligen hatte - wenn ich draufdrückte hatte ich1.8V, habe ich losgelassen war der wieder aus...aber auch nicht immer. Auch ein neu einlöten des Controllers bzw. BuckConverters brachte nix. Da ich aber keinen passenden Ersatz da hatte habe ich einen externen StepDown für die 1.8V verbaut...kurz und schmerzlos halt  . Auch der 1V PEX Buck Converter war hinüber -da hatte ich aber noch passenden Ersatz da.

. Auch der 1V PEX Buck Converter war hinüber -da hatte ich aber noch passenden Ersatz da.

Hab halt immer wieder mal nebenbei etwas an der Karte rumgebaut, aber nie Erfolg gehabt. Hatte sie dann schon als Teilespender abgestempelt - oder halt als möglichen Kandidat für ein Zombie umbau - also externes PowerBoard um die GPU und den Speicher mit Spannung zu versorgen...hatte aber kein passendes PowerBoard dagehabt was da gut draufpasste, zumal ich will dass die Karte auch nicht zu schlimm ausschaut nach so einem umbau.

Irgendwann bekam ich eine GPU-defekte Palit GTX780 Jetstream - das PowerBoard von der Jetstream hat 8 Phasen mit FDMF6823C DrMosfets drauf - also in summe max. 400A. Optimal für mein vorhaben, zumal es auch die passenden Abmessungen hatte . Der VRM Bereich für die Speicher auf der Jetstream war auch ausreichend dimensioniert.

. Der VRM Bereich für die Speicher auf der Jetstream war auch ausreichend dimensioniert.

Also Kurzerhand mal meine Eisensäge wieder ausgepackt und mir das PowerBoard der Jetstream abgesägt...die Säge ist mittlerweile schon stumpfer als beim Film SAW...und es sieht auch schon so ähnlich aus hier soviel abgesägte Karten wie ich mittlerweile rumliegen habe, weil ich mir die stärkeren PowerBoards aufhebe

Ziel war es jedenfalls, das PowerBoard Huckepack bzw. als Sandwich mit auf das 1080TI PCB draufzupacken.

Dazu kurzerhand das ganze unnötige Zeug auf der 1080ti abgelötet:

was dann so aussah:

Ja auch den originalen PWM Controller hab ich von der 1080ti wieder runtergenommen, weil der ja kein PowerGood Signal freilassen kann solange er verbaut gewesen wäre, damit würde sich die GPU aber in einem Reset-State befinden wenn sie kein Signal bekommt dass das VRM die GPU Spannung sauber eingestellt hat. Das läuft über ein 1.8V Signal welches per PullUp widerstand in die GPU geschoben wird - der PWM Controller aber hält das Signal auf Low (= 0V) solange der PWM Controller nicht sagt - ok, Spannung stimmt, kannst loslegen. Darum ab damit, dann kann er das Signal auch nicht mehr auf Low ziehen

Dann noch das PowerBoard etwas angepasst damit es auch startet und die Feedback Anschlüsse angezapft um später die Spannung einstellen zu können. Das Jetstream PowerBoard hat einen NCP4208 PWM Controller drauf, dessen Default-Spannung stellt man mit ein paar Widerständen ein.

Weiter gings dann ans vorbereiten der Lötverbindungen sowie das Vorverzinnen

Danach konnte ich die ersten Kabel ans PowerBoard anlöten:

Sodass ich dann mit zwei Schrauben das PowerBoard Huckepack auf die 1080TI schrauben konnte, wobei ich aber ins 1080TI PCB neue Löcher am Rand bohren musste...Im Normalfall gehen da keine Kritischen Leiterbahnen lang da auf dem original PowerBoard der 1080TI. Aber damit die Schrauben keinen Kurzschluss in den Inneren Layer machten - musste ich die Schrauben isolieren, in form von einem kurzen Stück Silikonschlauch und Isolationsscheiben unter den Unterlegscheiben - zumindest da wo auch andere Leiterbahnen außer Masse auf den obersten Layern lang geht.

Soweit so gut, das JetStream Powerboard konnte somit auf das 1080TI PC geschraubt werden, und die Plus Verbindung vom JetStream-Powerboard zur 1080TI konnte auch aufgelötet werden

Abschließend noch die Masseverbindungen:

Hier auf dem Bild hatte ich die LED Spannungsanzeigen noch nicht mit angelötet, aber man sieht hier schon recht gut die Masseverbindung zwischen dem JetStream PowerBoard und der 1080TI

Der Strom vom Netzteil geht ins JetStream PowerBoard - und von dem PowerBoard geht eine kleine verbindung runter auf das 1080TI PCB und versorgt da die ehemaligen Stromeingänge - weil der INA3221 Monitoring Chip ist ja weiterhin auf dem 1080TI PCB, und der will auch sehen das Spannung anliegt und etwas Strom fließt, damit der kein Critical Error ausgibt und die GPU in ein SafeMode schickt

Damit konnte ich jedenfalls schonmal einen kurzen Test machen ob die karte überhaupt noch lebte, und Sie lebte

aber wie man sieht - sie ist im SafeMode...Grund: sie sieht nicht dass Strom gezogen wird auf den beiden PCIe Anschlüssen, aber die Spannung sieht sie schonmal. Also muss ich dafür sorgen das irgendwie etwas Strom verbraten wird, damit sie aus dem SafeMode rauskommt

Und das erreichte ich mit jeweils einen kleinen 1k Ohm Widerstand der hinter den Shunts auf der 1080TI einfach gegen Masse geht - damit verbrate ich bei 12V also um die 0.2W - und das reicht dem INA3221 Monitoring Chip schon, die Karte freien lauf zu lassen

Anschließend gings noch weiter das VRM Modul des JetStream PowerBoards zu kühlen. Da ich aber keinen Kühler aufschrauben konnte, musste ich kleben. Also guten 2k Wärmeleitkleber mit über 10W/mK besorgt und erstmal ein 1mm Kupferstreifen aufgeklebt um die Wärme gleichmäßiger zu verteilen und um die Kühler etwas höher zu bekommen damit sie nicht auf den Kerarimkondensatoren neben den Mosfets aufliegen

Anschließend noch die Kühler aufgeklebt und ein paar Speicherkühler ebenfalls:

Hier auf den Bildern sieht man noch ein rotes Kabel oben zwischen den PCIe Stromstecker. Das hatte ich genutzt um die originalen Shunts der 1080ti etwas Strom messen zu lassen, von ein paar Mosfets des JetStream PowerBoards. Da hatte ich noch nicht ermittelt wieviel Strom der INA3221 sehen will um die GPU Freizugeben, also noch bevor ich die 1k Ohm Widerstände verbaute. Das rote Kabel gibt's jetzt damit nicht mehr. Auch sieht man hier den besagten BuckConverter für die 1.8V

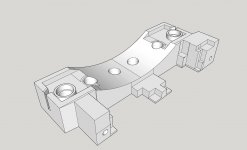

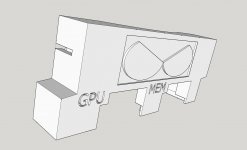

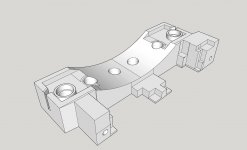

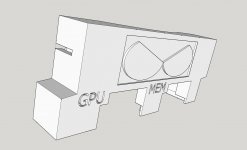

Damit konnte dann der Morpheus Kühler auch montiert werden und ihn hinten an der Karte abfangen mit einer 3D gedruckten Halterung aus PETG damit der auch wirklich Fest drauf sitzt und nicht wackelt, und das PCB hinten auch etwas mit gehalten wird.

Hier auf den Bilder hatte ich aber noch die erste Generation der Halterung, oben die 3D Zeichnungen sind schon die Finale Revision die auch jetzt mit drauf ist.

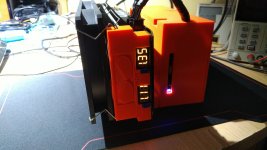

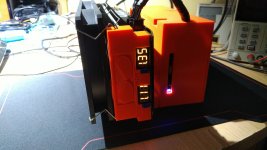

Dazu noch zwei Arctic P12 PWM Lüfter, Kabel etwas eingekürzt und eine externe PWM Lüftersteuerung, welche die Temperatur des VRM Kühlers misst.

Im Idle laufen die Lüfter mit 800U/min, der VRM bereich ist dann zwischen 35°C und 40°C warm. Sobald Last auf der Karte angelegt wird, also mit Benchmarks oder Spielen, beginnen die Lüfter schneller zu drehen sobald das VRM die 40°C Überschritten hat. Bei 75°C laufen die Lüfter mit 100% PWM Duty Cyle, also voller Drehzahl mit rund 1800U/min. Bei Furmark erreicht das VRM da dennoch 82°C - bei 1.15V GPU Spannung wo sich die Karte alleine direkt mal 350W rum genehmigt. Bei Spielen drehen die Lüfter nur mit um die 1600U/min und die VRM-Temperatur liegt da bei rund 65°C

Was interessant ist: die GPU selber kann intern die Spannung messen - was ich aber nicht auslesen kann, zumindest habe ich dafür kein passendes Debugging Tool.

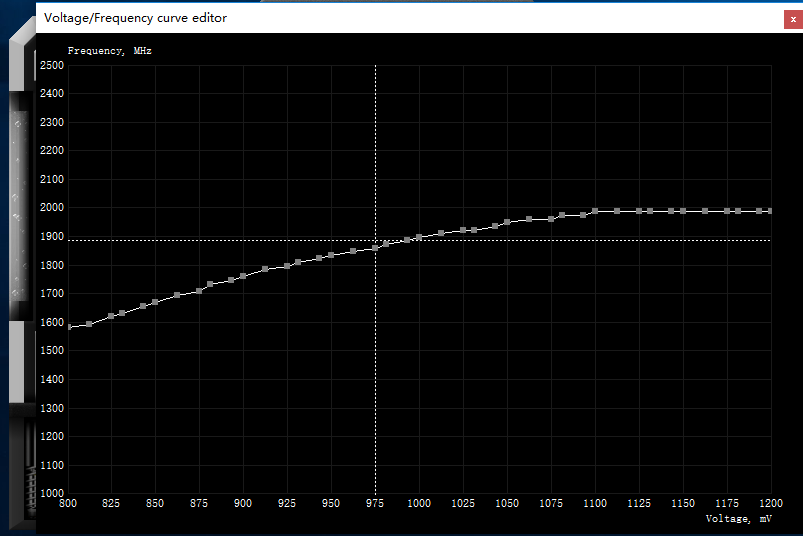

GPU-Z und alle anderen bekannten Programme zeigen immer nur die VID Spannung an - die Spannung die die GPU erwartet zu bekommen wie es im BIOS in der GPUBoost Tabelle für den jeweiligen Takt vorgesehen ist. Die GPU kommuniziert normalerweise über eine Leitung mit dem PWM Controller um die richtige Spannung einzustellen was die GPU haben will. Auch der GPU Takt der in allen Programmen angezeigt wird, auch in GPUz - ist NICHT der reelle Takt der wirklich anliegt, ist eben auch nur der Takt der anhand der BoostTabelle anliegen sollte. Die BoostTabelle bzw. die Kurve sieht man ja auch im MSI Afterburner.

Das hat zur folge, dass wenn man zuwenig Spannung auf die GPU gibt - die Karte zwar läuft und man sich ggf. freut wiewenig Spannung sie braucht für z.b. 2000Mhz - aber intern taktet die GPU garnicht so hoch, das sieht man auch an den Benchmark Werten.

Es gibt von nVidia ein Debugging Tool, das ThermSpy (angehangene Zip-Datei) - das zeigt einem den echten GPU Takt an der auch wirklich anliegt und nicht nur den Takt den die verschiedensten Programmen anzeigen.

Man kann also auch mit 0.8V die GPU locker auf 2100Mhz stellen - aber effektiv wird sie da nur mit 1700Mhz arbeiten wenn überhaupt ^^ sieht man spätestens am Stromverbrauch das da was nicht stimmen kann...so ist es mir auch aufgefallen und eben an einen recht niedrigen Benchmark wert.

Hier nochmal ein paar Bilder wo ich die GPU auf 1.00V stellte:

man sieht - die GPU taktet 6% langsamer als sie eigentlich sollte. Die Biosseitige VID Tabelle sagt der GPU eben welchen Takt sie bei welcher Spannung machen soll. Ich hab leider noch kein Tool gefunden womit man die echte GPU Spannung angezeigt bekommt worauf sich die GPU eben beruft.

Kaum erhöht man die Spannung, läuft sie auch gleich entsprechend schneller:

Anzumerken ist: die Spannung die hier angezeigt wird ist leider nicht die Spannung welche die GPU oder der Speicher unter last hat. Ich messe hier nur die Spannung die das PowerBoard am Ausgang hat. Aber unter Last bei Furmark habe ich dennoch einen ordentlichen vDrop. RAM Seitig habe ich ca. 50mV vDrop - ich muss also auf 1.40V stellen um am RAM effektiv 1.35V zu haben, wobei der RAM auch mit 1.30V laufen würde bei 5500Mhz.

Bei der GPU habe ich bei eingestellten 1.10V unter Furmark gerade mal noch 1.02V in etwa anliegen, also satte 80mV vDrop - trotz der massiven Kabelverbindungen zwischen PowerBoard und 1080ti, aber in Spielen ist der vDrop geringer. Ich hätte im Nachhinein noch extra messleitungen von der GPU zum Pwm Controller des Jetstream PowerBoard ziehen können der das Masse Potential und die plus Spannung an der GPU direkt misst - damit hätte der Controller sicherlich besser den vdrop Kompensieren können... Aber ich wollte das PowerBoard nicht mehr ablöten nur um nochmal an den Controller ranzukommen.. So funktioniert es ja auch. Beim nächsten mal mache ich das gleich mit.

Ich hab leider aktuell keine originale Pascal karte da, würde mich mal interessieren ob eine normale Pascal-karte auch etwas ihren echten tankt senkt, weil die Spannnung was die GPU anfordert muss nicht immer exakt so an der GPU auch ankommen, weil auch der originale VRM wird einen gewissen vDrop haben.

Hab da auch verschiedene BIOS'e durchprobiert, weil manche Karten haben z b. bei 1.05V in der Boost Tabelle einen takt von 2000Mhz anliegen, wo andere nur 1850Mhz Anliegen haben.

So gibts z.B. auch das Phänomen dass wenn ich das Zotac 1080ti Amp Extreme Bios drauf habe was den höhsten BoostTakt hat von 2050Mhz der eigentlich anliegen sollte lt. Bios, dass mir die Karte auch abstürzt wenn ich mit der Spannung über 1.20V gehe. Weil der Takt dann etwas über 2050Mhz gehen würde - was die GPU aber nicht mehr schafft bei der Spannung, sondern noch mehr Spannung haben will. Ich hab da nicht die echte an der GPU anliegende Spannung gemessen, schätze aber mal, dass da dennoch rund 1.10V angelegen haben.

Warum der takt über 2050Mhz gehen kann?

Ich hab hier eine BoostTabelle einer anderen 1080ti, und normalerweiße kann die karte nie mehr spannung bekommen als 1.093V - das ist ein Limit was nVidia anscheinend bei allen 1080ti Karten eingebaut hat - dennoch steht in der Boosttabelle auch ein Takt überhalb der 1.093V, und der ist höher als der, der bei den besagten 1.093V steht. Da ich ja jetzt extern Spannung reinschiebe wo die GPU nichts dagegen machen kann, und die GPU selber die Spannung intern messen kann - boostet sie noch höher als eigentlich vorgesehen.

Was auch kurrios ist: Die Karte rennt bei Furmwark ins PowerLimit - obwohl sie die aufgenomme Leistung garnicht mehr Messen kann Ich vermute mal dass auch hier neben der Spannungs-Messfähigkeit in der GPU auch eine Strom-Messfähigkeit gegeben ist, abseits von den externen Shunts. Stell ich aber im MSI Afterburner das PowerTarget auf +20% rennt sie auch bei Furmark nicht mehr ins Powerlimit.

Ich vermute mal dass auch hier neben der Spannungs-Messfähigkeit in der GPU auch eine Strom-Messfähigkeit gegeben ist, abseits von den externen Shunts. Stell ich aber im MSI Afterburner das PowerTarget auf +20% rennt sie auch bei Furmark nicht mehr ins Powerlimit.

Dabei ist es egal ob ich ein Bios drauf habe was eine default TDP von 250W oder 360W hat (Zotac Arctic Storm Bios) - sollange ich im Afterburner nicht manuell das Powertarget hochschraube rennt sie ab und zu nur bei Furmark ins Powerlimit.

Naja, Karte rennt jedenfalls wieder und läuft halt mit effektiv 1930Mhz GPU Takt bei eingestellten 1.07V - was unter last rund 1, 01V entspricht (gemessen direkt an der GPU rückseitig) . Die GPU ist halt nur eine ganz billiche, nicht selektierte GPU.

Aber immer noch besser als als Teilespender in der Ecke rumzuliegen

Ich hatte mal vor langer zeit relativ günstig eine PNY GTX1080TI geschossen, mit Blowerkühler und wie sich erst mit dem öffnen der Karte rausstellte - nicht ganz Referenz Design. Der Vorbesitzer hatte da bei einer unsanften CPU Kühler Demontage etliche Teile auf der Rückseite der Karte abgeräumt. Viele Teile konnte ich von Spenderkarten wieder anbringen wie SMD Keramik-Kondensatoren, aber einige SMD Widerstände und kleine Mosfets konnte ich nicht wiederherstellen weil das PCB nur ans Referenz Design angelehnt war, aber dennoch einiges anders war. Schaltpläne dazu gibt's auch keine. Ich hatte über Wochen hinweg versucht die Karte irgendwie wieder zu retten, hatte in der Zwischenzeit verschiedene andere 1080TIs hier wo ich hier und da was abgeschaut hatte bzw. gegen gemessen hatte um die ganzen fehlenden Teile rund um den Original PWM Controller NCP81274 wiederherzustellen um der Karte wieder leben einzuhauchen, aber es gelang mir einfach nicht die Phasen zum starten zu überreden. Auch ein umbau auf UP9511P PWM Controller brachte mich da nicht weiter

Hab halt immer wieder mal nebenbei etwas an der Karte rumgebaut, aber nie Erfolg gehabt. Hatte sie dann schon als Teilespender abgestempelt - oder halt als möglichen Kandidat für ein Zombie umbau - also externes PowerBoard um die GPU und den Speicher mit Spannung zu versorgen...hatte aber kein passendes PowerBoard dagehabt was da gut draufpasste, zumal ich will dass die Karte auch nicht zu schlimm ausschaut nach so einem umbau.

Irgendwann bekam ich eine GPU-defekte Palit GTX780 Jetstream - das PowerBoard von der Jetstream hat 8 Phasen mit FDMF6823C DrMosfets drauf - also in summe max. 400A. Optimal für mein vorhaben, zumal es auch die passenden Abmessungen hatte

Also Kurzerhand mal meine Eisensäge wieder ausgepackt und mir das PowerBoard der Jetstream abgesägt...die Säge ist mittlerweile schon stumpfer als beim Film SAW...und es sieht auch schon so ähnlich aus hier soviel abgesägte Karten wie ich mittlerweile rumliegen habe, weil ich mir die stärkeren PowerBoards aufhebe

Ziel war es jedenfalls, das PowerBoard Huckepack bzw. als Sandwich mit auf das 1080TI PCB draufzupacken.

Dazu kurzerhand das ganze unnötige Zeug auf der 1080ti abgelötet:

was dann so aussah:

Ja auch den originalen PWM Controller hab ich von der 1080ti wieder runtergenommen, weil der ja kein PowerGood Signal freilassen kann solange er verbaut gewesen wäre, damit würde sich die GPU aber in einem Reset-State befinden wenn sie kein Signal bekommt dass das VRM die GPU Spannung sauber eingestellt hat. Das läuft über ein 1.8V Signal welches per PullUp widerstand in die GPU geschoben wird - der PWM Controller aber hält das Signal auf Low (= 0V) solange der PWM Controller nicht sagt - ok, Spannung stimmt, kannst loslegen. Darum ab damit, dann kann er das Signal auch nicht mehr auf Low ziehen

Dann noch das PowerBoard etwas angepasst damit es auch startet und die Feedback Anschlüsse angezapft um später die Spannung einstellen zu können. Das Jetstream PowerBoard hat einen NCP4208 PWM Controller drauf, dessen Default-Spannung stellt man mit ein paar Widerständen ein.

Weiter gings dann ans vorbereiten der Lötverbindungen sowie das Vorverzinnen

Danach konnte ich die ersten Kabel ans PowerBoard anlöten:

Sodass ich dann mit zwei Schrauben das PowerBoard Huckepack auf die 1080TI schrauben konnte, wobei ich aber ins 1080TI PCB neue Löcher am Rand bohren musste...Im Normalfall gehen da keine Kritischen Leiterbahnen lang da auf dem original PowerBoard der 1080TI. Aber damit die Schrauben keinen Kurzschluss in den Inneren Layer machten - musste ich die Schrauben isolieren, in form von einem kurzen Stück Silikonschlauch und Isolationsscheiben unter den Unterlegscheiben - zumindest da wo auch andere Leiterbahnen außer Masse auf den obersten Layern lang geht.

Soweit so gut, das JetStream Powerboard konnte somit auf das 1080TI PC geschraubt werden, und die Plus Verbindung vom JetStream-Powerboard zur 1080TI konnte auch aufgelötet werden

Abschließend noch die Masseverbindungen:

Hier auf dem Bild hatte ich die LED Spannungsanzeigen noch nicht mit angelötet, aber man sieht hier schon recht gut die Masseverbindung zwischen dem JetStream PowerBoard und der 1080TI

Der Strom vom Netzteil geht ins JetStream PowerBoard - und von dem PowerBoard geht eine kleine verbindung runter auf das 1080TI PCB und versorgt da die ehemaligen Stromeingänge - weil der INA3221 Monitoring Chip ist ja weiterhin auf dem 1080TI PCB, und der will auch sehen das Spannung anliegt und etwas Strom fließt, damit der kein Critical Error ausgibt und die GPU in ein SafeMode schickt

Damit konnte ich jedenfalls schonmal einen kurzen Test machen ob die karte überhaupt noch lebte, und Sie lebte

aber wie man sieht - sie ist im SafeMode...Grund: sie sieht nicht dass Strom gezogen wird auf den beiden PCIe Anschlüssen, aber die Spannung sieht sie schonmal. Also muss ich dafür sorgen das irgendwie etwas Strom verbraten wird, damit sie aus dem SafeMode rauskommt

Und das erreichte ich mit jeweils einen kleinen 1k Ohm Widerstand der hinter den Shunts auf der 1080TI einfach gegen Masse geht - damit verbrate ich bei 12V also um die 0.2W - und das reicht dem INA3221 Monitoring Chip schon, die Karte freien lauf zu lassen

Anschließend gings noch weiter das VRM Modul des JetStream PowerBoards zu kühlen. Da ich aber keinen Kühler aufschrauben konnte, musste ich kleben. Also guten 2k Wärmeleitkleber mit über 10W/mK besorgt und erstmal ein 1mm Kupferstreifen aufgeklebt um die Wärme gleichmäßiger zu verteilen und um die Kühler etwas höher zu bekommen damit sie nicht auf den Kerarimkondensatoren neben den Mosfets aufliegen

Anschließend noch die Kühler aufgeklebt und ein paar Speicherkühler ebenfalls:

Hier auf den Bildern sieht man noch ein rotes Kabel oben zwischen den PCIe Stromstecker. Das hatte ich genutzt um die originalen Shunts der 1080ti etwas Strom messen zu lassen, von ein paar Mosfets des JetStream PowerBoards. Da hatte ich noch nicht ermittelt wieviel Strom der INA3221 sehen will um die GPU Freizugeben, also noch bevor ich die 1k Ohm Widerstände verbaute. Das rote Kabel gibt's jetzt damit nicht mehr. Auch sieht man hier den besagten BuckConverter für die 1.8V

Damit konnte dann der Morpheus Kühler auch montiert werden und ihn hinten an der Karte abfangen mit einer 3D gedruckten Halterung aus PETG damit der auch wirklich Fest drauf sitzt und nicht wackelt, und das PCB hinten auch etwas mit gehalten wird.

Hier auf den Bilder hatte ich aber noch die erste Generation der Halterung, oben die 3D Zeichnungen sind schon die Finale Revision die auch jetzt mit drauf ist.

Dazu noch zwei Arctic P12 PWM Lüfter, Kabel etwas eingekürzt und eine externe PWM Lüftersteuerung, welche die Temperatur des VRM Kühlers misst.

Im Idle laufen die Lüfter mit 800U/min, der VRM bereich ist dann zwischen 35°C und 40°C warm. Sobald Last auf der Karte angelegt wird, also mit Benchmarks oder Spielen, beginnen die Lüfter schneller zu drehen sobald das VRM die 40°C Überschritten hat. Bei 75°C laufen die Lüfter mit 100% PWM Duty Cyle, also voller Drehzahl mit rund 1800U/min. Bei Furmark erreicht das VRM da dennoch 82°C - bei 1.15V GPU Spannung wo sich die Karte alleine direkt mal 350W rum genehmigt. Bei Spielen drehen die Lüfter nur mit um die 1600U/min und die VRM-Temperatur liegt da bei rund 65°C

Was interessant ist: die GPU selber kann intern die Spannung messen - was ich aber nicht auslesen kann, zumindest habe ich dafür kein passendes Debugging Tool.

GPU-Z und alle anderen bekannten Programme zeigen immer nur die VID Spannung an - die Spannung die die GPU erwartet zu bekommen wie es im BIOS in der GPUBoost Tabelle für den jeweiligen Takt vorgesehen ist. Die GPU kommuniziert normalerweise über eine Leitung mit dem PWM Controller um die richtige Spannung einzustellen was die GPU haben will. Auch der GPU Takt der in allen Programmen angezeigt wird, auch in GPUz - ist NICHT der reelle Takt der wirklich anliegt, ist eben auch nur der Takt der anhand der BoostTabelle anliegen sollte. Die BoostTabelle bzw. die Kurve sieht man ja auch im MSI Afterburner.

Das hat zur folge, dass wenn man zuwenig Spannung auf die GPU gibt - die Karte zwar läuft und man sich ggf. freut wiewenig Spannung sie braucht für z.b. 2000Mhz - aber intern taktet die GPU garnicht so hoch, das sieht man auch an den Benchmark Werten.

Es gibt von nVidia ein Debugging Tool, das ThermSpy (angehangene Zip-Datei) - das zeigt einem den echten GPU Takt an der auch wirklich anliegt und nicht nur den Takt den die verschiedensten Programmen anzeigen.

Man kann also auch mit 0.8V die GPU locker auf 2100Mhz stellen - aber effektiv wird sie da nur mit 1700Mhz arbeiten wenn überhaupt ^^ sieht man spätestens am Stromverbrauch das da was nicht stimmen kann...so ist es mir auch aufgefallen und eben an einen recht niedrigen Benchmark wert.

Hier nochmal ein paar Bilder wo ich die GPU auf 1.00V stellte:

man sieht - die GPU taktet 6% langsamer als sie eigentlich sollte. Die Biosseitige VID Tabelle sagt der GPU eben welchen Takt sie bei welcher Spannung machen soll. Ich hab leider noch kein Tool gefunden womit man die echte GPU Spannung angezeigt bekommt worauf sich die GPU eben beruft.

Kaum erhöht man die Spannung, läuft sie auch gleich entsprechend schneller:

Anzumerken ist: die Spannung die hier angezeigt wird ist leider nicht die Spannung welche die GPU oder der Speicher unter last hat. Ich messe hier nur die Spannung die das PowerBoard am Ausgang hat. Aber unter Last bei Furmark habe ich dennoch einen ordentlichen vDrop. RAM Seitig habe ich ca. 50mV vDrop - ich muss also auf 1.40V stellen um am RAM effektiv 1.35V zu haben, wobei der RAM auch mit 1.30V laufen würde bei 5500Mhz.

Bei der GPU habe ich bei eingestellten 1.10V unter Furmark gerade mal noch 1.02V in etwa anliegen, also satte 80mV vDrop - trotz der massiven Kabelverbindungen zwischen PowerBoard und 1080ti, aber in Spielen ist der vDrop geringer. Ich hätte im Nachhinein noch extra messleitungen von der GPU zum Pwm Controller des Jetstream PowerBoard ziehen können der das Masse Potential und die plus Spannung an der GPU direkt misst - damit hätte der Controller sicherlich besser den vdrop Kompensieren können... Aber ich wollte das PowerBoard nicht mehr ablöten nur um nochmal an den Controller ranzukommen.. So funktioniert es ja auch. Beim nächsten mal mache ich das gleich mit.

Ich hab leider aktuell keine originale Pascal karte da, würde mich mal interessieren ob eine normale Pascal-karte auch etwas ihren echten tankt senkt, weil die Spannnung was die GPU anfordert muss nicht immer exakt so an der GPU auch ankommen, weil auch der originale VRM wird einen gewissen vDrop haben.

Hab da auch verschiedene BIOS'e durchprobiert, weil manche Karten haben z b. bei 1.05V in der Boost Tabelle einen takt von 2000Mhz anliegen, wo andere nur 1850Mhz Anliegen haben.

So gibts z.B. auch das Phänomen dass wenn ich das Zotac 1080ti Amp Extreme Bios drauf habe was den höhsten BoostTakt hat von 2050Mhz der eigentlich anliegen sollte lt. Bios, dass mir die Karte auch abstürzt wenn ich mit der Spannung über 1.20V gehe. Weil der Takt dann etwas über 2050Mhz gehen würde - was die GPU aber nicht mehr schafft bei der Spannung, sondern noch mehr Spannung haben will. Ich hab da nicht die echte an der GPU anliegende Spannung gemessen, schätze aber mal, dass da dennoch rund 1.10V angelegen haben.

Warum der takt über 2050Mhz gehen kann?

Ich hab hier eine BoostTabelle einer anderen 1080ti, und normalerweiße kann die karte nie mehr spannung bekommen als 1.093V - das ist ein Limit was nVidia anscheinend bei allen 1080ti Karten eingebaut hat - dennoch steht in der Boosttabelle auch ein Takt überhalb der 1.093V, und der ist höher als der, der bei den besagten 1.093V steht. Da ich ja jetzt extern Spannung reinschiebe wo die GPU nichts dagegen machen kann, und die GPU selber die Spannung intern messen kann - boostet sie noch höher als eigentlich vorgesehen.

Was auch kurrios ist: Die Karte rennt bei Furmwark ins PowerLimit - obwohl sie die aufgenomme Leistung garnicht mehr Messen kann

Dabei ist es egal ob ich ein Bios drauf habe was eine default TDP von 250W oder 360W hat (Zotac Arctic Storm Bios) - sollange ich im Afterburner nicht manuell das Powertarget hochschraube rennt sie ab und zu nur bei Furmark ins Powerlimit.

Naja, Karte rennt jedenfalls wieder und läuft halt mit effektiv 1930Mhz GPU Takt bei eingestellten 1.07V - was unter last rund 1, 01V entspricht (gemessen direkt an der GPU rückseitig) . Die GPU ist halt nur eine ganz billiche, nicht selektierte GPU.

Aber immer noch besser als als Teilespender in der Ecke rumzuliegen

Anhänge

Zuletzt bearbeitet: