Aha... somit lohnt es sich für Gamer ne "effiziente" AMD GCN Karte zu kaufen, die in 3 Spielen wie Metro2033,

AvP und Anno 1704 ihre extreme GPGPU-Power ausspielen kann - und was ist mit den ganzen Rest der Games ?!?

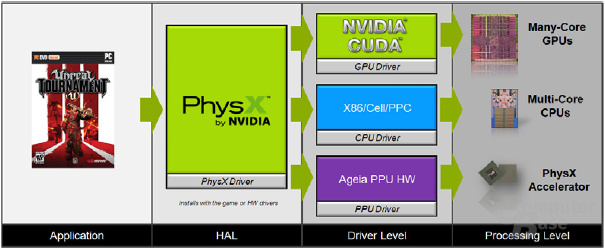

BTW: Alle zukünftigen Games die auf der

UnrealEngine 3 oder 4 basieren werden, nutzen nur so zur Info Nvidia's GPGPU Technologie => in Form von

CUDA & Physx APEX SDK für kommende Physik Berechnungen auf CPU und GPU.

Durch die implementierung von Nvidia's

PhsyX SDK & Apex SDK's in fast alle nahmhaften, weltweit populärsten

Entwickler-Bibliotheken und Game-Engines wie Unreal Engine 3 & 4, Unity 3D, Vision, Instinct, Diesel, Torque, Hero, BigWorld, DiCE, GearBox 2KGames, EA Games bis hin zu Emergent Game Technologies Gamebryo LightSpeed (Cross-Platform Product für PC, Xbox 360, PS3, Mac OS X, Linux, Tegra und Android ) und Support für 3Ds Max, Maya, etc.

Nvidia APEX (Adaptive Physics Extensions) SDK ist eine neue mächtige Bibliothek die auf der von PhysX SDK aufbaut.

Sie umfasst 4 wesentliche APEX Module:

• APEX Clothing

• APEX Destruction

• APEX Particles

• APEX Turbulence

http://www.youtube.com/watch?v=UY_kTMFpQ4E

http://www.youtube.com/watch?v=grIVUDH4FIM

http://www.youtube.com/watch?v=lkBKW4dClRw

http://www.youtube.com/watch?v=qq3mYmzOelI

Inzwischen ist die PhysX-Schnittstelle nicht nur auf Nvidias Grafikprozessoren angepasst, sondern läuft neben PC's auch auf der Playstation 3, Nintendos Wii und der Xbox 360 und damit allen modernen Spieleplattformen. Da für die Entwickler die "Cross-Platform-Programmierung" immer wichtiger wird, sind universelle Schnittstellen eine große Erleichterung.

Kurz gesagt, APEX SDK ist eine "Neue einfache Möglichkeit" und somit bietet man den Künstler, Level Designer und Spiele-Entwickler mit einer Reihe von einfach zu bedienenden Tools der PhysX-Technologie-Entwicklung als Software Development Kit (SDK), für den Prozess der Implementierung von skalierbarer Physik über mehrere rationalisieren Plattformen für Next-Generation-Titel wie "

ARMA 3, Borderlands 2, Aliens: Colonial Marines, EVE Online, etc. und wurde schon in Form von Nvidia Physx SDK in zahlreichen älteren Blockbuster'n von XBox und PC Games wie der

Gears Of War Reihe, Unreal Tournament 3, Bulletstorm, Tom Clancy's Ghost Recon Advanced Warfighter, Mirror's Edge, Cryostasis, Mafia II, Dragon Age, Need for Speed Shift, Arkham City und Mass Effect einge- setzt.

Es gibt mittlerweiler über

370 Games die auf Nvidia's Physx SDK Bibliotheken aufbauen, wobei etwa 30 auf jene "advanced" GPU Physik spezialisiert sind, der Rest läuft auf den diversen CPU's von PC's, PS3, XBox 360, Wii.

http://www.youtube.com/watch?v=HpTSK9aBP1c

http://www.youtube.com/watch?v=hmT9N5dUqcM

Hier ein schon etwas älterer Artikel (Dezember'09) der die GPGPU Physik Entwicklung ein wenig nachzeichnet:

Popular Physics Engines comparison: PhysX, Havok and ODE