Hi Leute,

ich hab mal eine kurze Frage und zwar zur Ausgangslage:

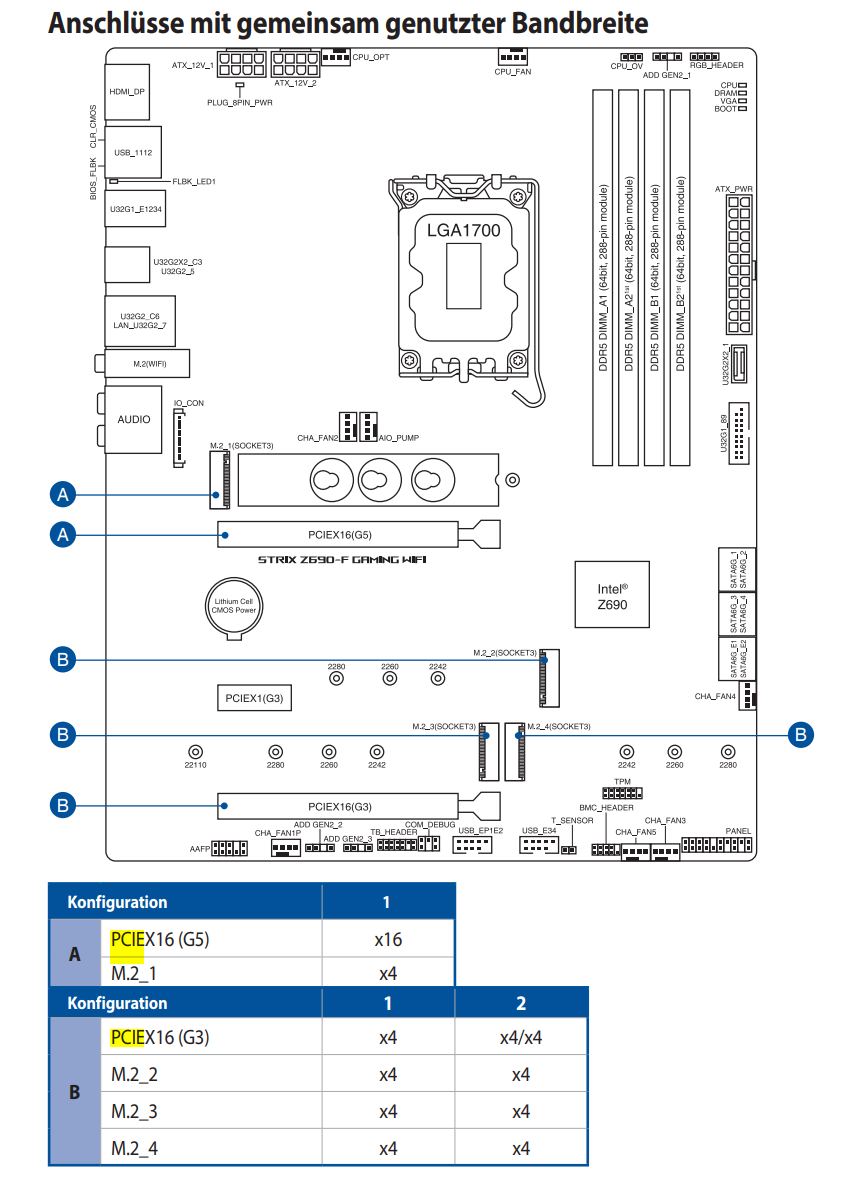

Habe ein Z690-F Gaming Wifi Board von Asus.

Drauf läuft mit dem i9 ein Windows Server.

Hyper-V wird genutzt als Hypervisor + zusätzlich VMWare Workstation auf der selben Maschine.

Benötige in einigen VMs bzw. eig. nur in einer USB Geräte, die dauerhaft eingebunden sind - auch nach Neustarts und am besten auch neue Geräte ohne zutun auf dem Host.

Sprich einstecken, in der VM und gut ist. Ich will aber nicht den kompletten USB3.0 Controller rüberschieben, weil im Host auch noch einige USB Geräte angebunden sind.

Jetzt war meine Idee ich pack mir eine USB3.0 Erweiterungskarte mit 4 Ports oder so rein und gut ist, aber leider gehen mir die PCIe Slots aus.

Im G5 Slot steckt eine 3050 für Plex, der ist voll belegt.

G3 x1 steckt eine IPMI iKVM Karte von Asus, auch belegt.

In G3 x16 steckt derzeit eine x4 angebundene Netzwerkkarte.

Nein meine Frage:

Der Slot G3 x16 kann ja PCIe Bifurcation, aber ich hab so noch nie benutzt bzw. mir noch nie genauer angeschaut.

Heißt das funktional, dass ich den Slot quasi "splitten" kann auf x4/x4?

Heißt 8 Lanes hat der Slot?

Heißt ich könnte so eine Karte nutzen:

Link

Und dazu eine USB 3.2 Karte und diese dann in VMware Workstation direkt in die VM übergeben:

Link

Würde die obere Karte in den x16 Slot packen und beide anderen via Riser Kabel dann an den Slot am Gehäuse hängen.

Eine weitere Frage die ich mir stelle ist, ob mir dann die Lanes über Chipsatz an die CPU reichen (14900KF).

Derzeit sind M2_1, M2_2, M2_3 mit NVMes + 1x SATA belegt.

Jemand Erfahrungen damit und kann mir sagen ob das realisierbar wäre?

Danke mal!

ich hab mal eine kurze Frage und zwar zur Ausgangslage:

Habe ein Z690-F Gaming Wifi Board von Asus.

Drauf läuft mit dem i9 ein Windows Server.

Hyper-V wird genutzt als Hypervisor + zusätzlich VMWare Workstation auf der selben Maschine.

Benötige in einigen VMs bzw. eig. nur in einer USB Geräte, die dauerhaft eingebunden sind - auch nach Neustarts und am besten auch neue Geräte ohne zutun auf dem Host.

Sprich einstecken, in der VM und gut ist. Ich will aber nicht den kompletten USB3.0 Controller rüberschieben, weil im Host auch noch einige USB Geräte angebunden sind.

Jetzt war meine Idee ich pack mir eine USB3.0 Erweiterungskarte mit 4 Ports oder so rein und gut ist, aber leider gehen mir die PCIe Slots aus.

Im G5 Slot steckt eine 3050 für Plex, der ist voll belegt.

G3 x1 steckt eine IPMI iKVM Karte von Asus, auch belegt.

In G3 x16 steckt derzeit eine x4 angebundene Netzwerkkarte.

Nein meine Frage:

Der Slot G3 x16 kann ja PCIe Bifurcation, aber ich hab so noch nie benutzt bzw. mir noch nie genauer angeschaut.

Heißt das funktional, dass ich den Slot quasi "splitten" kann auf x4/x4?

Heißt 8 Lanes hat der Slot?

Heißt ich könnte so eine Karte nutzen:

Link

Und dazu eine USB 3.2 Karte und diese dann in VMware Workstation direkt in die VM übergeben:

Link

Würde die obere Karte in den x16 Slot packen und beide anderen via Riser Kabel dann an den Slot am Gehäuse hängen.

Eine weitere Frage die ich mir stelle ist, ob mir dann die Lanes über Chipsatz an die CPU reichen (14900KF).

Derzeit sind M2_1, M2_2, M2_3 mit NVMes + 1x SATA belegt.

Jemand Erfahrungen damit und kann mir sagen ob das realisierbar wäre?

Danke mal!