Hallo, ich habe eben einen stack gestoppt und daraufhin auf löschen geklickt.

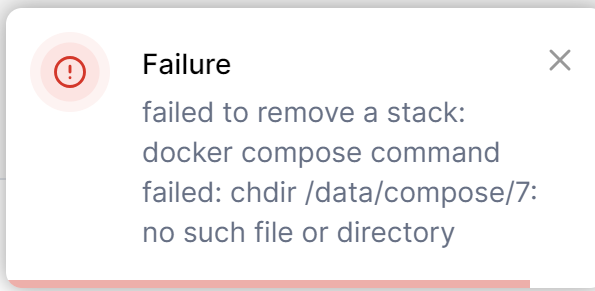

es erschien diese Fehlermeldung und ich kann den Stack nicht mehr löschen.

Was kann ich tun?

unter anderem stand das im docker compose file:

"

environment:

PAPERLESS_REDIS: redis://broker:6379

PAPERLESS_SECRET_KEY: mykey!

PAPERLESS_ADMIN_USER: myuser

PAPERLESS_ADMIN_PASSWORD: mypassword

PAPERLESS_OCR_LANGUAGE: deu+eng

PAPERLESS_CONSUMER_DELETE_DUPLICATES: true

USERMAP_UID: 0

USERMAP_GID: 0

"

die letzten beiden zeilen habe ich raus genommen.

Wollte sie erst auf die entsprechenden user uds stellen, aber es ging auch ohne.

daran kann es aber nicht liegen, dass er manchmal langsam dateien lädt, oder?

es erschien diese Fehlermeldung und ich kann den Stack nicht mehr löschen.

Was kann ich tun?

Ergänzung ()

unter anderem stand das im docker compose file:

"

environment:

PAPERLESS_REDIS: redis://broker:6379

PAPERLESS_SECRET_KEY: mykey!

PAPERLESS_ADMIN_USER: myuser

PAPERLESS_ADMIN_PASSWORD: mypassword

PAPERLESS_OCR_LANGUAGE: deu+eng

PAPERLESS_CONSUMER_DELETE_DUPLICATES: true

USERMAP_UID: 0

USERMAP_GID: 0

"

die letzten beiden zeilen habe ich raus genommen.

Wollte sie erst auf die entsprechenden user uds stellen, aber es ging auch ohne.

daran kann es aber nicht liegen, dass er manchmal langsam dateien lädt, oder?

Zuletzt bearbeitet: