Ich habe den Upscaler von https://github.com/Coyote-A/ultimate-upscale-for-automatic1111 Ist das der richtige?

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

[Sammelthread] AI - Bildgenerierung (Stable Diffusion, Midjourney & Co)

- Ersteller MechanimaL

- Erstellt am

- Registriert

- Nov. 2005

- Beiträge

- 989

Ja.

Yep, das passiert, weil jede Kachel individuell behandelt wird, nicht als Teil eines Gesamtbild.Luckeie schrieb:Allerdings setzt sich das Bild jetzt aus nicht zusammen passenden Kacheln zusammen.

Deshalb bevorzuge ich Tiled Diffusion solange es in den VRAM passt - das kennt das Gesamt-Zusammen (und hat weitere Möglichkeiten). Es wird aber jede Menge VRAM benötigt.

Controlnet nutzen oder denoising auf 0,1~0,2 setzen

- Registriert

- Nov. 2005

- Beiträge

- 989

Mh soweit ich mich erinnere ist das script bei den neueren Versionen von A1111 schon vorinstalliert. Außerdem gab es heute ein großes Update und man kann Pytorch 2.0.0 installieren, was je nach System, deutliche Geschwindigkeitsverbesserungen bringen kann. Also "git pull" im verzeichnis, wo die webui-user.bat datei liegt durchführen, wenn du das nicht in der start datei als befehl drin hast.

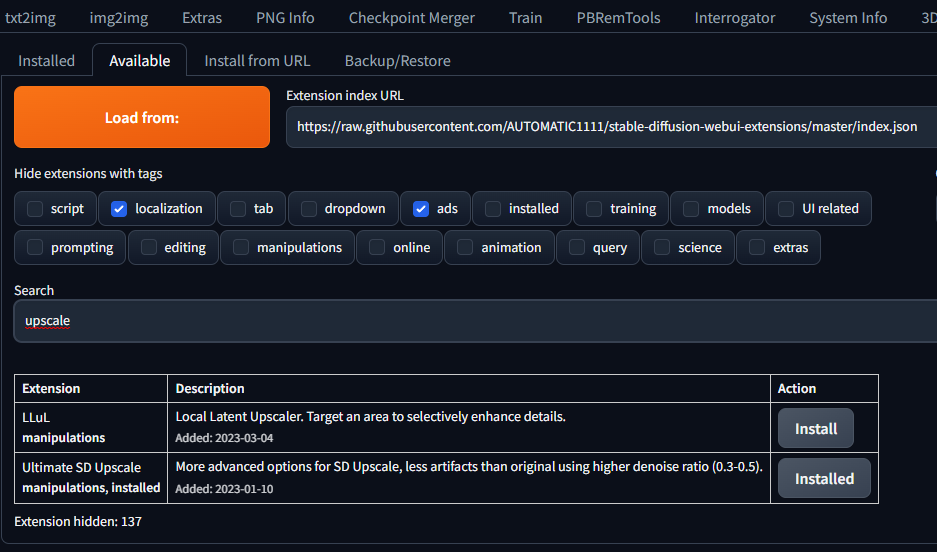

Generell für Extensions musst Du keine, die gelistet sind von Hand installieren, das geht mit 2 Mausklicks über das Extensions Menü (available, dort suchen, auswählen und installieren, siehe Screenshot).

Generell für Extensions musst Du keine, die gelistet sind von Hand installieren, das geht mit 2 Mausklicks über das Extensions Menü (available, dort suchen, auswählen und installieren, siehe Screenshot).

Ein Tipp, den ich irgendwo aufgegabelt hatte: git pull in die webui-user.bat packen. Dann wird A1111 immer beim Start geupdated, sofern etwas neues vorhanden ist.MechanimaL schrieb:Also "git pull" im verzeichnis, wo die start-webui.bat datei liegt durchführen, wenn du das nicht in der start datei als befehl drin hast.

Danke für die Tipps. 'git pull' hatte ich schon länger in 'webui.bat' eingebaut. Das Script wurde aber nicht installiert. Ich habe es von Hand in den Ordner 'scripts' kopiert. Aber jetzt ist es da! Ich bekomme aber einfach keine guten Upscale-Bilder hin. Meistens ist die Mitte Ok, aber über und unter der Mitte sind neue Gesichter entstanden. 'Denoise' habe ich verändert, bringt aber bei mir nichts.

Ich füge Euch einmal einen Screenshot von meinen Einstellungen bei:

Ich füge Euch einmal einen Screenshot von meinen Einstellungen bei:

Anhänge

- Registriert

- Nov. 2005

- Beiträge

- 989

@Luckeie cool  und noch ein kleiner Tipp, am besten den ersten Schritt zum größeren Bild mit Hires.fix machen, also eine möglichst große Ausgangsversion erzeugen, die dann upgescaled wird. (Grafikkarten RAM ist dann halt wieder eine Grenze). Das sieht wahrscheinlich dann besser aus, als wenn du nur 512x.. Bilder hast und diese dann mittels Extra-Tab oder Upscale Script nochmals upscalest.

und noch ein kleiner Tipp, am besten den ersten Schritt zum größeren Bild mit Hires.fix machen, also eine möglichst große Ausgangsversion erzeugen, die dann upgescaled wird. (Grafikkarten RAM ist dann halt wieder eine Grenze). Das sieht wahrscheinlich dann besser aus, als wenn du nur 512x.. Bilder hast und diese dann mittels Extra-Tab oder Upscale Script nochmals upscalest.

So ist es. Und darum bei mir nur in Einzelfällen funktional. :-)MechanimaL schrieb:@Luckeie(Grafikkarten RAM ist dann halt wieder eine Grenze)

Der Kabelbinder

Higitus figitus zumbakazing.

- Registriert

- März 2009

- Beiträge

- 8.869

Da helfen dann ja die VRAM-Startpamater von Automatic1111.

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Command-Line-Arguments-and-Settings

Ab einer gewissen Auflösung ist der Cache aber natürlich schlicht voll. Da hilft dann nur warten, bis es effizienter Methoden gibt, oder Upgrade.

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Command-Line-Arguments-and-Settings

Ab einer gewissen Auflösung ist der Cache aber natürlich schlicht voll. Da hilft dann nur warten, bis es effizienter Methoden gibt, oder Upgrade.

Hat einer von euch schonmal getestet, ob die auf niedrige fp getrimmten Checkpoints auch weniger VRAM verbrauchen?

Ich würde selber testen, aber die VRAM Verbrauchsanzeige von Stable Diffusion ist nicht so super genau und mit 24GB VRAM ist es nicht so einfach, den exakt voll zu machen...

Ich würde selber testen, aber die VRAM Verbrauchsanzeige von Stable Diffusion ist nicht so super genau und mit 24GB VRAM ist es nicht so einfach, den exakt voll zu machen...

- Registriert

- Nov. 2005

- Beiträge

- 989

Ich hatte ja bis vor kurzem eine 3070 mit 8GB und es gibt z.B. ein RAM Problem, das entsteht, obwohl man eigtl. noch genug RAM hat.. Dagegen hatte der untere Befehl geholfen. Außerdem hilft xformers noch RAM zu sparen. Nach wie vor habe ich die Startparameter noch drin:

Auch ist es beim Upscalen mit Hilfe SD ja immer möglich, das Bild gut hinzubekommen, mit mehr Details, auch ohne größeren RAM; meine Aussage, mit Hires fix schon was größeres als Ausgang ggf. parat zu haben, bezieht sich darauf, dass es dann vll leichter ist schnell ein gutes Ergebnis zu bekommen. Aber ist alles relativ..

Auch ist es beim Upscalen mit Hilfe SD ja immer möglich, das Bild gut hinzubekommen, mit mehr Details, auch ohne größeren RAM; meine Aussage, mit Hires fix schon was größeres als Ausgang ggf. parat zu haben, bezieht sich darauf, dass es dann vll leichter ist schnell ein gutes Ergebnis zu bekommen. Aber ist alles relativ..

Schon vor Monaten mit dem ersten Upscale Script entstand dieser Post, den ich auch im Eingangspost verlinkt hatte:

https://www.reddit.com/r/StableDiff...o_huge_sizes_and_add_detail_with_sd/?sort=new

@Rickmer hast Du in Controlnet mit dem Tile Model schon versucht die Downsampling Einstellung zu verwenden? vll kommt dann weniger schrott in die Details bei höhrem Denoising? mmh außerdem noch ne Frage mal zu testen, nicht das ganze Prompt beim Upscaling sondern nur qualitätsbegriffe rein zu machen, damit vll nicht in jedem Tile potentiell nochmal Körperteile in Miniaturversionen entstehen ^^

außerdem noch ne Frage mal zu testen, nicht das ganze Prompt beim Upscaling sondern nur qualitätsbegriffe rein zu machen, damit vll nicht in jedem Tile potentiell nochmal Körperteile in Miniaturversionen entstehen ^^

--> Downsampling während Upscaling ?!

--> Downsampling während Upscaling ?!

----------------------------------------@echo off

git pull

set PYTHON=

set GIT=

set VENV_DIR=

set COMMANDLINE_ARGS=--xformers

set PYTORCH_CUDA_ALLOC_CONF=garbage_collection_threshold:0.9,max_split_size_mb:512

call webui.bat

Nee hab ich noch nicht getestet. Aber Es gibt ja diverse Anzeigen über die VRAM Auslastung , wie im Afterburner, oder auch die system-info extension für A1111, die sollte doch genauer seinRickmer schrieb:Hat einer von euch schonmal getestet, ob die auf niedrige fp getrimmten Checkpoints auch weniger VRAM verbrauchen?

Ich würde selber testen, aber die VRAM Verbrauchsanzeige von Stable Diffusion ist nicht so super genau und mit 24GB VRAM ist es nicht so einfach, den exakt voll zu machen...

Ergänzung ()

Ja keine Sorge, es haben Leute mit weniger RAM schon sehr gute und große Bilder erzeugtLuckeie schrieb:So ist es. Und darum bei mir nur in Einzelfällen funktional. :-)

Schon vor Monaten mit dem ersten Upscale Script entstand dieser Post, den ich auch im Eingangspost verlinkt hatte:

https://www.reddit.com/r/StableDiff...o_huge_sizes_and_add_detail_with_sd/?sort=new

@Rickmer hast Du in Controlnet mit dem Tile Model schon versucht die Downsampling Einstellung zu verwenden? vll kommt dann weniger schrott in die Details bei höhrem Denoising? mmh

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Zuletzt bearbeitet:

Das macht doch genau das Gegenteil - durch das Downsampling hat das Controlnet weniger Details, weshalb das Denoise mehr Freiheiten hat, mehr zu ändern und damit mehr Details ins Bild zu packen.MechanimaL schrieb:hast Du in Controlnet mit dem Tile Model schon versucht die Downsampling Einstellung zu verwenden? vll kommt dann weniger schrott in die Details bei höhrem Denoising?

Genau deshalb packe ich eigentlich auch immer Denoise mit rein wenn ich das Controlnet benutze - wenn ich keine Änderungen wollen würde, könnte ich auch einfach den Upscaler in den Extras nehmen.

Hab's getestet - sounds good, doesn't workMechanimaL schrieb:außerdem noch ne Frage mal zu testen, nicht das ganze Prompt beim Upscaling sondern nur qualitätsbegriffe rein zu machen, damit vll nicht in jedem Tile potentiell nochmal Körperteile in Miniaturversionen entstehen ^^

Die zusätzlichen random Hände sind trotzdem da und diverse Deko-Elemente haben sich plötzlich in thematisch unpassende verwandelt, z.B.

Drachenschuppen -> Blumenblätter

Drachenkopf -> Wolfskopf (und kein besonders gefährlich aussehender -_- )

Achja, und vom Gesichtsausdruck ging auch viel verloren.

Hab jetzt mal mit GPU-Z geschaut... das macht von der VRAM-Auslastung effektiv überhaupt keinen Unterschied, ob ich Protogen_X8.6 mit 1,7GB oder chilloutmix_Ni mit 7,5GB nutze.MechanimaL schrieb:Nee hab ich noch nicht getestet. Aber Es gibt ja diverse Anzeigen über die VRAM Auslastung , wie im Afterburner, oder auch die system-info extension für A1111, die sollte doch genauer sein

Ich habe es nochmal mit der Oma versucht...

Ausgang:

Upscale 1:

Finaler Upscale:

Kurz: keine Änderung, es passiert weiterhin dasselbe 'Aufschaukeln'.

Ich habe dann auch getestet was passiert, wenn ich die Zwischenschritte überspringe und direkt vom ersten Bild zur finalen Auflösung gehe:

Von:

Zu:

Selbst recht hohem Denoise ist hier der Detailgrad um Welten schlechter und trotz Controlnet sind viele Fehler im Bild. Ich müsste also eigentlich das Denoise noch niedriger stellen.

Die Wörter habe ich dem überarbeiteten Prompt von oben mal hinzugefügt und nochmal getestet:

Wieder ausgehend von diesem Bild:

Upscale 1:

Finaler Upscale:

Wenn ich jetzt einen side-by-side Vergleich mache (naja, mit voller Auflösung betrachtet):

Originalbild - Extremer Upscale - Überarbeiteter Prompt

Dann sieht das für mich durchaus wie ein Erfolg aus. Da sind jetzt andere Fehler im Bild weil ich überhaupt keine Selektion gemacht habe, aber die Belichtung ist deutlich besser. Danke.

Jetzt müsste ich eigentlich noch experimentieren, was davon jetzt wirksam war und was nichts gebracht hatte... und vielleicht auch noch, wie sich andere Checkpoints diesbezüglich verhalten. Chilloutmix ist normalerweise nicht meine erste Wahl.

Ich habe mal alle Wörter bezüglich Belichtung aus dem Prompt genommen:MechanimaL schrieb:Was mir direkt aufgefallen ist, wie oft da "light" im originalen Prompt vorkommt, das trägt evtl auch dazu bei und ist bestimmt nicht alles nötig.

1 old woman, (80 years old gradmother:1.3), realistic detail, sitting on bench, happy, long hair, white granny dress, (4k, ultra quality, masterpiece:1.2),(extremely detailed CG unity 4k wallpaper) , (ultra realistic, photo realistic), ultra detailed, ultra high res, intricate detail, Exquisite details and textures Masterpiece,(fluttered detailed color splashs), (illustration) using the Sony Alpha A7r V, using lens 70-200mm GM f/1.4, photography style, (denoising:0.6), flower garden, realistic detail face, (looking at viewer:1.2), (medium full shot:1.1) <lora:Sakura:0.3>, skin spots, skin blemishes, age spot,

Negative prompt: mask, paintings, sketches,fewer digits, jpeg artifacts, signature,(simple background), (worst quality:2), (low quality:2), (normal quality:2),(monochrome), (gray scale), lowres, big face, poorly drawn face,cloned face,long neck, big eyes,(unclear eyes:1.331),bad eyes,mutated eyes,bad nose,mutated nose,error eyes, error nose,poorly drawn eyes,poorly drawn nose, (ugly:1.331), (duplicate:1.331), (mutilated:1.21)

Negative prompt: mask, paintings, sketches,fewer digits, jpeg artifacts, signature,(simple background), (worst quality:2), (low quality:2), (normal quality:2),(monochrome), (gray scale), lowres, big face, poorly drawn face,cloned face,long neck, big eyes,(unclear eyes:1.331),bad eyes,mutated eyes,bad nose,mutated nose,error eyes, error nose,poorly drawn eyes,poorly drawn nose, (ugly:1.331), (duplicate:1.331), (mutilated:1.21)

Ausgang:

Upscale 1:

Finaler Upscale:

Kurz: keine Änderung, es passiert weiterhin dasselbe 'Aufschaukeln'.

Ich habe dann auch getestet was passiert, wenn ich die Zwischenschritte überspringe und direkt vom ersten Bild zur finalen Auflösung gehe:

Von:

Zu:

Selbst recht hohem Denoise ist hier der Detailgrad um Welten schlechter und trotz Controlnet sind viele Fehler im Bild. Ich müsste also eigentlich das Denoise noch niedriger stellen.

MechanimaL schrieb:Zb: Positiv: professional, portrait, Soft lighting/natural lighting/ambient lighting. mit low key sollte es auch dunkler werden (key bezieht sich auf die durchschnittliche helligkeit im Bild soweit ich mich erinnere).

bzw. negativ: Overexposure, overexposed, hard lighting, flash

Die Wörter habe ich dem überarbeiteten Prompt von oben mal hinzugefügt und nochmal getestet:

1 old woman, (80 years old gradmother:1.3), professional, portrait, Soft lighting, natural lighting, ambient lighting, low key, realistic detail, sitting on bench, happy, long hair, white granny dress, (4k, ultra quality, masterpiece:1.2),(extremely detailed CG unity 4k wallpaper) , (ultra realistic, photo realistic), ultra detailed, ultra high res, intricate detail, Exquisite details and textures Masterpiece,(fluttered detailed color splashs), (illustration) using the Sony Alpha A7r V, using lens 70-200mm GM f/1.4, photography style, (denoising:0.6), flower garden, realistic detail face, (looking at viewer:1.2), (medium full shot:1.1) <lora:Sakura:0.3>, skin spots, skin blemishes, age spot,

Negative prompt: mask, Overexposure, overexposed, hard lighting, flash, paintings, sketches,fewer digits, jpeg artifacts, signature,(simple background), (worst quality:2), (low quality:2), (normal quality:2),(monochrome), (gray scale), lowres, big face, poorly drawn face,cloned face,long neck, big eyes,(unclear eyes:1.331),bad eyes,mutated eyes,bad nose,mutated nose,error eyes, error nose,poorly drawn eyes,poorly drawn nose, (ugly:1.331), (duplicate:1.331), (mutilated:1.21)

Negative prompt: mask, Overexposure, overexposed, hard lighting, flash, paintings, sketches,fewer digits, jpeg artifacts, signature,(simple background), (worst quality:2), (low quality:2), (normal quality:2),(monochrome), (gray scale), lowres, big face, poorly drawn face,cloned face,long neck, big eyes,(unclear eyes:1.331),bad eyes,mutated eyes,bad nose,mutated nose,error eyes, error nose,poorly drawn eyes,poorly drawn nose, (ugly:1.331), (duplicate:1.331), (mutilated:1.21)

Wieder ausgehend von diesem Bild:

Upscale 1:

Finaler Upscale:

Wenn ich jetzt einen side-by-side Vergleich mache (naja, mit voller Auflösung betrachtet):

Originalbild - Extremer Upscale - Überarbeiteter Prompt

Dann sieht das für mich durchaus wie ein Erfolg aus. Da sind jetzt andere Fehler im Bild weil ich überhaupt keine Selektion gemacht habe, aber die Belichtung ist deutlich besser. Danke.

Jetzt müsste ich eigentlich noch experimentieren, was davon jetzt wirksam war und was nichts gebracht hatte... und vielleicht auch noch, wie sich andere Checkpoints diesbezüglich verhalten. Chilloutmix ist normalerweise nicht meine erste Wahl.

Zuletzt bearbeitet:

- Registriert

- Nov. 2005

- Beiträge

- 989

Cool, dass das schonmal etwas geholfen hat. Man könnte die Beleuchtung auch noch weiter konkretisieren, da gibt es genaue Begriffe, wie bspw. das Gesicht beleuchtet ist. Je nachdem könnte das auch gegen Überbeleuchtung in bestimmten Bereichen helfen Siehe: Portrait-Beleuchtungs-Begriffe. Hab ich schonmal bei Portrait-Versuchen gemacht und hatte auch eine entsprechende Wirkung.

Chillout Mix ist wahrsch. gut in Sachen Hautdarstellung und nackten Körperteilen , aber hat auch häufig einen Drall in die Richtung, sagen wir mal bestimmter Schönheitsideale.. ^^

, aber hat auch häufig einen Drall in die Richtung, sagen wir mal bestimmter Schönheitsideale.. ^^

Ich bin mal gespannt, wenn Controlnet für SD 2.1 oder höheres erscheint; bis dahin probiere ich auch mal Upscaling mit einem 2.1 Modell. Da hatte ich in einem kurzen Test bereits mit dem Base Modell sehr detallierte Gesichtszügen/Falten usw. hinbekommen:

Habe auch gelesen, dass beim Upscaling via SD schrittweise der CFG-Wert erhöht werden sollte, evtl hilft das noch gegen ungewollte Elemente. Edit: bei jmd. anderem war der Wert auf 3 runtergefahren.. mh^^

Nach dem bisherigen probieren mit Controlnet+SD Upscale würde ich den sweetspot bei ca 0.3-0.4 Denoising vermuten? Vll geht mit weiteren Kontrollmitteln noch mehr. Habe aber noch nicht sehr viel probiert.

@Rickmer hast Du eigtl auch mal probiert "Tile width" zu erhöhen? Das könnte auch gegen Kuriositäten helfen.

Im Controlnet Github wird übrigens Tiled VAE als empfohlene Upscale Methode mit Controlnet genannt. edit: gesehen, dass du das schon benutzt hast.

Chillout Mix ist wahrsch. gut in Sachen Hautdarstellung und nackten Körperteilen

Ich bin mal gespannt, wenn Controlnet für SD 2.1 oder höheres erscheint; bis dahin probiere ich auch mal Upscaling mit einem 2.1 Modell. Da hatte ich in einem kurzen Test bereits mit dem Base Modell sehr detallierte Gesichtszügen/Falten usw. hinbekommen:

portrait photo of an old man working at the field, dirty, looking at the camera, highly detailed, intricate faceambient lighting, HDR, UHD, 4K, 8k,professional photograph, bokeh, trees and hills in the background, mm, fstop, raw

Negative prompt: logo, text, amateur, out of focus, blurry

Steps: 50, Sampler: DDIM, CFG scale: 7, Seed: 1098906567, Size: 768x768, Model hash: 2c02b20a

Negative prompt: logo, text, amateur, out of focus, blurry

Steps: 50, Sampler: DDIM, CFG scale: 7, Seed: 1098906567, Size: 768x768, Model hash: 2c02b20a

Habe auch gelesen, dass beim Upscaling via SD schrittweise der CFG-Wert erhöht werden sollte, evtl hilft das noch gegen ungewollte Elemente. Edit: bei jmd. anderem war der Wert auf 3 runtergefahren.. mh^^

Nach dem bisherigen probieren mit Controlnet+SD Upscale würde ich den sweetspot bei ca 0.3-0.4 Denoising vermuten? Vll geht mit weiteren Kontrollmitteln noch mehr. Habe aber noch nicht sehr viel probiert.

@Rickmer hast Du eigtl auch mal probiert "Tile width" zu erhöhen? Das könnte auch gegen Kuriositäten helfen.

Im Controlnet Github wird übrigens Tiled VAE als empfohlene Upscale Methode mit Controlnet genannt. edit: gesehen, dass du das schon benutzt hast.

Zuletzt bearbeitet:

- Registriert

- Nov. 2005

- Beiträge

- 989

Mh ein paar Testergebnisse:

- preprocessor an / aus scheint keinen Unterschied zu machen (bei 2xUpscale jedenfalls kein nennenswerter Unterschied)

- Tile Width (Ultimate SD Upscale) erhöhen verbessert LEICHT die Fehler-Rate, drei mal 4x Upscale mit gleichem Seed/Settings (außer Tile-Width), von 512-1024-2048:

1 very old woman, realistic detail, full body, long hair, white skirt, (4k, ultra quality, masterpiece:1.2),(extremely detailed CG unity 4k wallpaper) , 80 years old (ultra realistic, photo realistic),ultra detailed,ultra high res, intricate detail, Exquisite details and textures Masterpiece,(fluttered detailed color splashs), (illustration) using the Sony Alpha A7r V, using lens 70-200mm GM f/1.4, photography style, (professional) ,(denoising:0.6),soft lighting, in the garden, realistic detail face.

Negative prompt: flash, hard lighting, overexposure, paintings, sketches,fewer digits, jpeg artifacts, signature,(simple background), (worst quality:2), (low quality:2), (normal quality:2),(monochrome), (gray scale), lowres, big face,poorly drawn face,cloned face,long neck, big eyes,(unclear eyes:1.331),bad eyes,mutated eyes,bad nose,mutated nose,error eyes, error nose,poorly drawn eyes,poorly drawn nose, (ugly:1.331), (duplicate:1.331), (mutilated:1.21)

Steps: 25, Sampler: DPM++ SDE Karras, CFG scale: 10, Seed: 4032003137, Size: 2048x3072, Model hash: fc2511737a, Model: chilloutmix_NiPrunedFp32Fix, Denoising strength: 0.4, Ultimate SD upscale upscaler: 4x-UltraSharp, Ultimate SD upscale tile_width: 512, Ultimate SD upscale tile_height: 512, Ultimate SD upscale mask_blur: 8, Ultimate SD upscale padding: 32, ControlNet 0 Enabled: True, ControlNet 0 Preprocessor: none, ControlNet 0 Model: control_v11f1e_sd15_tile [a371b31b], ControlNet 0 Weight: 1, ControlNet 0 Starting Step: 0, ControlNet 0 Ending Step: 1, ControlNet 0 Resize Mode: Crop and Resize, ControlNet 0 Pixel Perfect: True, ControlNet 0 Control Mode: Balanced, ControlNet 0 Preprocessor Parameters: "(64, 64, 64)"

Negative prompt: flash, hard lighting, overexposure, paintings, sketches,fewer digits, jpeg artifacts, signature,(simple background), (worst quality:2), (low quality:2), (normal quality:2),(monochrome), (gray scale), lowres, big face,poorly drawn face,cloned face,long neck, big eyes,(unclear eyes:1.331),bad eyes,mutated eyes,bad nose,mutated nose,error eyes, error nose,poorly drawn eyes,poorly drawn nose, (ugly:1.331), (duplicate:1.331), (mutilated:1.21)

Steps: 25, Sampler: DPM++ SDE Karras, CFG scale: 10, Seed: 4032003137, Size: 2048x3072, Model hash: fc2511737a, Model: chilloutmix_NiPrunedFp32Fix, Denoising strength: 0.4, Ultimate SD upscale upscaler: 4x-UltraSharp, Ultimate SD upscale tile_width: 512, Ultimate SD upscale tile_height: 512, Ultimate SD upscale mask_blur: 8, Ultimate SD upscale padding: 32, ControlNet 0 Enabled: True, ControlNet 0 Preprocessor: none, ControlNet 0 Model: control_v11f1e_sd15_tile [a371b31b], ControlNet 0 Weight: 1, ControlNet 0 Starting Step: 0, ControlNet 0 Ending Step: 1, ControlNet 0 Resize Mode: Crop and Resize, ControlNet 0 Pixel Perfect: True, ControlNet 0 Control Mode: Balanced, ControlNet 0 Preprocessor Parameters: "(64, 64, 64)"

- zwei Durchgänge (2x + 2x SD Upscaling+controlnet) ergeben deutlich mehr Tiefe als direkt 4x