- Registriert

- Dez. 2001

- Beiträge

- 3.213

Moin.

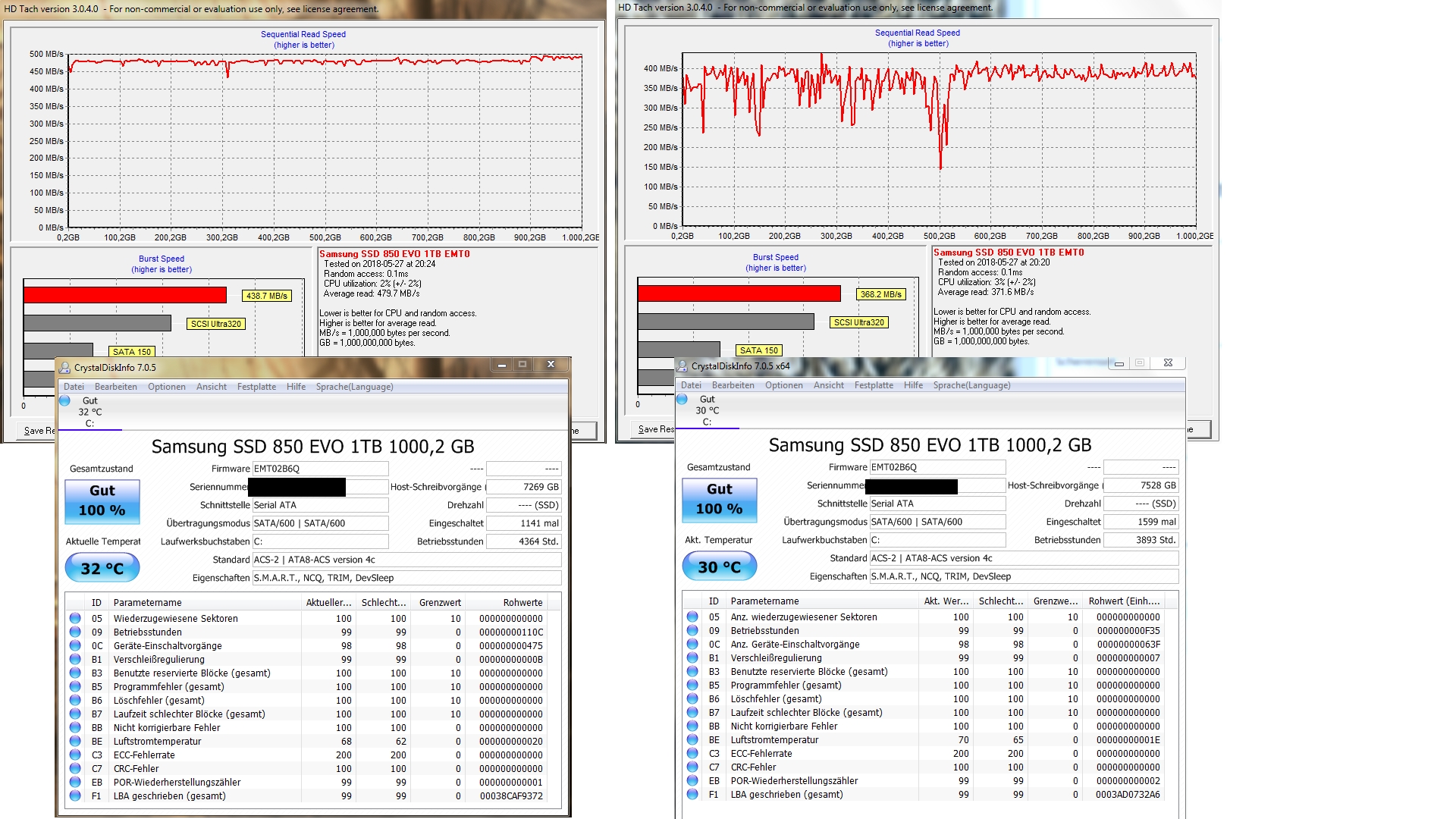

Wir haben hier zwei absolut identische PCs von 2014 (siehe meine Signatur).

Beide wurden zeitgleich im Dezember 2016 mit jeweils einer 1TB Samsung 850 EVO SSD ausgerüstet.

In der angefügten Screenshot-Collage kann man erkennen, dass eine der beiden SSDs vom scheinbar ähnlichen Leistungsabfall betroffen ist, wie es schon zuvor die 840er EVO war, von der wir zwei 500GB Modelle hatten/haben.

Kann das sein oder liegt der Fehler eventuell woanders?

Das Phänomen habe ich vor etwa drei Monaten entdeckt und es hat sich nie wieder gebessert.

Davor waren beide SSDs leistungsmäßig immer ähnlich.

Wie schon gesagt, beide PCs sind 100% identisch in Sachen Alter, Hardware, Treiber und Betriebssystem.

Auf beiden SSDs sind 93,15 GB für das Over Provisioning permanent frei gelassen (ob Sinn oder Unsinn muss ja jeder selber wissen ), während dann von der zur Verfügung bleibenden Kapazität immer zwischen 5 und 150GB frei sind.

), während dann von der zur Verfügung bleibenden Kapazität immer zwischen 5 und 150GB frei sind.

Schaut euch bitte mal das Bild an und sagt mir eventuell, was ihr davon haltet.

Danke für jede Idee im Voraus!

Wir haben hier zwei absolut identische PCs von 2014 (siehe meine Signatur).

Beide wurden zeitgleich im Dezember 2016 mit jeweils einer 1TB Samsung 850 EVO SSD ausgerüstet.

In der angefügten Screenshot-Collage kann man erkennen, dass eine der beiden SSDs vom scheinbar ähnlichen Leistungsabfall betroffen ist, wie es schon zuvor die 840er EVO war, von der wir zwei 500GB Modelle hatten/haben.

Kann das sein oder liegt der Fehler eventuell woanders?

Das Phänomen habe ich vor etwa drei Monaten entdeckt und es hat sich nie wieder gebessert.

Davor waren beide SSDs leistungsmäßig immer ähnlich.

Wie schon gesagt, beide PCs sind 100% identisch in Sachen Alter, Hardware, Treiber und Betriebssystem.

Auf beiden SSDs sind 93,15 GB für das Over Provisioning permanent frei gelassen (ob Sinn oder Unsinn muss ja jeder selber wissen

Schaut euch bitte mal das Bild an und sagt mir eventuell, was ihr davon haltet.

Danke für jede Idee im Voraus!