Hu zusammen,

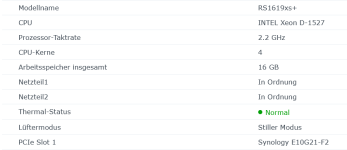

hab hier einen älteren gebrauchten 1HE Server (Intel Xeon E3-1220 v5, 2x 8GB DDR4-2133 ECC UDIMM) mit 4x Sata HotSwap und insgesamt 6x Sata Anschlüssen. Da meine Zeit mit FreeNAS schon verdammt lang zurück liegt und auch nur kurz war, wollte ich hier mal nach dem Best Practice mit TrueNAS Scale fragen. Im Grunde soll da nur 1 SMB-Share für Videos und eine iSCSI-LUN für Sicherungen angelegt werden. Festplatten fehlen noch. 2x 250GB SSDs wären schon vorhanden.

Im Server selber ist kein Platz mehr für irgendwelche NVMe-Adapter etc., da eine 10G NIC verbaut bleiben soll. Also habe ich hier 4x Sata Hotswap und 2x Sata Non-Hotswap.

Mein Plan wäre jetzt einfach die beiden Sata-SSDs beim TrueNAS-Setup zu spiegeln und da das TrueNAS-OS zu installieren und dann halt 4x 16TB HDDs zu kaufen, und die einfach in nem RaidZ1 mit 4 Laufwerken laufen zu lassen. Mir ist nur aufgefallen, dass es ja bei ZFS auch diese Special VDEVs wie ZIL, Metadata, Lesecache, Dedup und Spare-Laufwerk gibt. Macht es für meine Zwecke (Video-Share+Backup-LUN) Sinn, irgendwas davon einzusetzen und das Setup nochmal umzubasteln? Einzige was ich ansonsten noch neben den HDDs anschaffen würde, wäre vlt. nochmal 2x16GB ECC RAM. Dann käme ich auf 48GB RAM. Oder wie würdet ihr das angehen?

Danke schonmal für die Anregungen.

hab hier einen älteren gebrauchten 1HE Server (Intel Xeon E3-1220 v5, 2x 8GB DDR4-2133 ECC UDIMM) mit 4x Sata HotSwap und insgesamt 6x Sata Anschlüssen. Da meine Zeit mit FreeNAS schon verdammt lang zurück liegt und auch nur kurz war, wollte ich hier mal nach dem Best Practice mit TrueNAS Scale fragen. Im Grunde soll da nur 1 SMB-Share für Videos und eine iSCSI-LUN für Sicherungen angelegt werden. Festplatten fehlen noch. 2x 250GB SSDs wären schon vorhanden.

Im Server selber ist kein Platz mehr für irgendwelche NVMe-Adapter etc., da eine 10G NIC verbaut bleiben soll. Also habe ich hier 4x Sata Hotswap und 2x Sata Non-Hotswap.

Mein Plan wäre jetzt einfach die beiden Sata-SSDs beim TrueNAS-Setup zu spiegeln und da das TrueNAS-OS zu installieren und dann halt 4x 16TB HDDs zu kaufen, und die einfach in nem RaidZ1 mit 4 Laufwerken laufen zu lassen. Mir ist nur aufgefallen, dass es ja bei ZFS auch diese Special VDEVs wie ZIL, Metadata, Lesecache, Dedup und Spare-Laufwerk gibt. Macht es für meine Zwecke (Video-Share+Backup-LUN) Sinn, irgendwas davon einzusetzen und das Setup nochmal umzubasteln? Einzige was ich ansonsten noch neben den HDDs anschaffen würde, wäre vlt. nochmal 2x16GB ECC RAM. Dann käme ich auf 48GB RAM. Oder wie würdet ihr das angehen?

Danke schonmal für die Anregungen.