Mac_Leod schrieb:

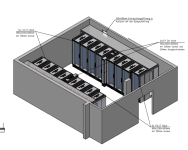

ja das kommt in der Grafik nicht gut rüber, es sind Rittal Racks die natürlich von einander getrennt sind

Hmm... seitliche Trennung. Also müssen alle Kabel über das Top bzw den Boden (Sockel) geführt werden. Das verhindert manche kurzen Wege. So lala, aber wenn man wirklich kapselt dann passt das schon

Mac_Leod schrieb:

Die komplette Verkabelung kommt von oben über Steiger,

Das ist gut. Ich hoffe ihr habt aber genug Platz eingeplant um später alles min doppelt so groß zu realisieren.

Abstände von Stromschienen und TabOut Boxen beachten!

Mac_Leod schrieb:

Sichtfenster gibt es nicht.

Die Racktüren sind komplett Luftdurchlässig, welcher

dieser Racks von hier es sind, kann ich noch nicht sagen.

Warum macht ihr das? Das ist so ein 2000er Design. Ihr beraubt euch damit unglaublich viel Flexibilität, da ihr immer eine Mischung der Temperaturen habt. Die Warme Luft mischt sich im Warmgang und im Kaltgang seid ihr durch die Komponente mit dem Bedarf an kältester Luft begrenzt...

Heutzutage macht man eher Backdoor Heat Exchanger oder nimmt gleich geschlossene Racks mit inrow Kühlern. Entweder im 1:1 Verbund oder 2 racks 1 Kühler. Wichtig gedämmte Racks für das Zeug was mit Wakü läuft.

Für den Legacy Kram kann man dann entweder mit den Backdoor Kühlern arbeiten oder mit Kalt und Warmgang. Ich würde da aber eher nicht auf den Kaltgang verzichten wollen.

Mac_Leod schrieb:

Mir fehlen die Pläne aktuell auch, geplant ist ein separater Batterie Raum, für die USVs.

USV raus ist gut. Die sind zu dick mit den Temperaturen im Allgemeinen.

Mac_Leod schrieb:

Da es hier nicht darum geht, so viel wie möglich Compute reinzupacken, also die Packungsdichte nicht maximiert werden muss, ist der Ansatz hier ein anderer.

Worum geht es dann? Bis jetzt hättest du von Hybrid gekühlten Servern für Buildsysteme gesprochen. Das wars.

Ich kann dir nur so viel raten. Pack die Server ziemlich dicht. Es hat eigentlich nur Vorteile. Zudem schau das ihr genug Platz für die Verteiler von Strom und Wasser habt. Wie gesagt, schaut das das doppelte rein passt zu dem was aktuell erforderlich ist.

Mac_Leod schrieb:

Aus finanzieller Sicht, macht es Sinn, schon alle Racks inkl. Medienzuführung hinzustellen.

Daher wird die Rechte Seite aufgestellt und mit allen Medien versorgt.

Mehr aber erst Mal auch nicht, also gibt es da initial keine Abnehmer.

Ja, aber überlegt euch wirklich was ihr betreiben könnt. 400kW sind nichts. Für mich sind das 5 Racks aktuell und ich Plane für die Zukunft mit weniger....

Ich kenne in Rechenzentren eigentlich nie ein echtes Platzproblem, sondern immer nur Kühlung und Stromzufuhr weil die Infrastruktur kacke ist und es einfach nicht verpackt. Deswegen sind die Racks ja heute oft nur noch zu 1/3 oder weniger gefüllt.

Mac_Leod schrieb:

Es ist eben die Hybridlösung und keine reine Wasserkühlung

Ja, aber siehe oben, es gibt bessere Lösungen....

Mac_Leod schrieb:

Storage, 2,5 Racks voll mit Access 48 Port Switchen, und einige andere Dinge lassen, sich stand heut nicht mit Wasser kühlen.

1G Switche? Die großen Dinger gibt es auch mit Wasser. Aber klar so low Power Zeug gibt es damit nicht. Das sollte man aber eben auch abtrennen.

Was heißt bei dir aber voll? Bei nem 48 Port Switch sehe ich als "voll" an, wenn für 48Ports inkl Routing <=3U verwendet werden auf das komplette Rack.

Btw habe ich schon erwähnt das Kabelführingssysteme überwiegend ein Drecks sind, der nicht wirklich gut funktioniert wenn die Racks wirklich vom sind?

Btw wenn es 1G Switche sind dann vertragen die auch durchaus 40°C auf der kalten Seite und 60 auf der warmen. Muss man aber mit dem Hersteller abklären, das er den Kopf hin hält Wenn's Probleme gibt....

[

QUOTE="Mac_Leod, post: 28704432, member: 1708"]

Der Statiker unbedingt unbedingt einen Riegel so, dass man die Racktüren nicht mehr auf bekommt, wenn Die normale Länge genommen wird.

[/QUOTE]

Ok, das ist blöd könnt ihr aber für Netzwerknutzen. Habt da ja scheinbar viel.

Mac_Leod schrieb:

Im aktuell vollen RZ mit 4 Racks was wir betreiben steht ein LCP welche 30KW an Kühlleistung bringt. (40KW Varianten gibt es glaub ich auch) Wie kommst du auf 12?

Google hatte mich auf die Seite gebracht und da stand 12kW.

Mac_Leod schrieb:

Laut Spec der LCPs und dem Rittal AP, reicht in einem geschotteten Kaltluft Gang, die Luft bis maximal 4 HEs nach Links und rechts.

Denkfehler!

Das sind Schönwetterangaben. Es kommt auf die tatsächlichen Volumenströme an. Wenn die Systeme mehr durchpusten als der inrow Kühler, dann kommt es immer zu backflow. Zudem kann Luft durch den Kühler gepresst werden, was die Lüfter auf Dauer schädigt.

Mac_Leod schrieb:

Du hast natürlich recht, dass nicht mehr wirklich viel kalte Luft bei den hinteren Racks an kommt, daher ist hier die Idee:

Da kommt im Zweifel gar nichts mehr an...

Mac_Leod schrieb:

Die 2,5 Racks voll mit Access Switchen auf Äußersten Racks zu verteilen, denn der Kühlbedarf ist relativ niedrig

Ob das tut? SFP+ bzw QSFP+ Module usw brauchen teils recht kühle Temps damit die nicht überhitzen.

Mac_Leod schrieb:

Ich frag mal nach, aktuell sind in dem Bereich keine weiteren Kosten vorgesehen, was aber nicht nein heißt.

Wie gesagt, schaut das ihr nicht die Verantwortung für das Funktionieren des Gesamtsystems habe, sondern ne Firma/Planer.

Ansonsten ist nach dem Umbau vor dem Umbau.

Vor allem ihr wollt den Raum ja sicherlich 10 Jahre+ nutzen. Da entwickelt sich einiges weiter.

Vor allem ein Punkt der gerne unterschlagen wird ist Dynamik. Ich würde nen Kasten Bier drauf verwetten das eure Planer von konstanten Lasten ausgehen. Das ist aber bullshit heutzutage bei allem was Compute anbelangt. Für storage und Switche ist es noch immer ne valide Annahme, aber definitiv nicht für Compute. Und das kann dir das Genick brechen.

Ich habe nicht erst einmal erlebt das die Jungs und Mädels aus der Gebäudetechnik panisch angerufen haben weil ihre Kühlsysteme vor die Wand gefahren sind obwohl davor geoßmaulig gesagt wurde ich könne mit dem neuen System Gas geben. Ihre Systeme würden das locker schaffen.

Auf Bypass schalten USVs sind auch immer gut. Genau wie abschaltende Crack Units.

Nen Kollege von mir hat auch mal das Licht im kompletten Gebäude aus gemacht. Also Hauptsicherung abgeworfen...

Ah habe ich erwähnt, das ich noch nen Dutzend oder zwei weitere Punkte habe auf die man achten sollte?