In den 90ern Jahren war die Welt noch in „Ordnung“, eine Grafikkarte hat ein Bild ausgespuckt und das hat gereicht. Der dafür zuständiger RAMDAC (Random Access Memory Digital/Analog Converter) wurde schneller, was zu einer höheren Hertz Zahl bei gestiegenen Auflösungen führte. Dieser war wichtig, da die Grafikchips rein Digitale Signale erzeugten, die CRTs (Röhrenbildschirm) aber ein Analoges Signal brauchten, um den Elektronenstrahl entsprechend zu lenken.

Inhaltsangabe

Doch nach und nach kam das Bedürfnis auf, auch einen zweiten Monitor oder TV zu befeuern. Bei Nvidia machte bereits die Riva 128 Serie den Anfang, wobei hier möglicherweise das entweder oder Prinzip zum Einsatz kam, sprich ein RAMDAC für einen Monitor oder TV, denn ein TV-Encoder bedeutet nicht automatisch, dass ein zweiter RAMDAC installiert ist.

Später war es die GeForce 2MX, zwar langsamer als die vollwertige GeForce 2 Serie, die dafür aber eine größere Auslegung Richtung Multimedia besaß, was es bei dieser Generation zu einem Alleinstellungsmerkmal im Konzern machte. Ja, wie bereits erwähnt, konnten die Riva 128 und TNT über einen TV Out verfügen, aber die Technik war noch auf dem Stand von Dx5 oder Dx6 und damit nicht mehr zeitgemäß. Denn die GeForce 256 besaß keinen entsprechenden Gegenpart und die MX Reihe war somit die erste Multimedia-Karte Nvidias.

ATi, damals noch kein Bestandteil von AMD, war da schon weiter und bot auch bei den High End Karten Radeon 7500 bis zu drei Ausgänge, von denen zwei gleichzeitig nutzbar waren.

Möglich machte das alles ein zweiter RAMDAC.

3dfx war mit der Auslegung als reine Gaming Karte ein Außenseiter, die bei der Voodoo 3 zwar schon einen TV-Tuner boten, aber beim Nachfolger wurde hauptsächlich nur ein VGA-Ausgang verbaut.

Was war aber, wenn man mehr als zwei Bildschirme brauchte? Dann musste man halt zwei Grafikkarten einsetzen.

Sollten nicht genügend Steckplätze, hier PCI und PCIe, vorhanden sein, musste man ein Multi-GPU-Gespann auf einer einzelnen Karte realisieren.

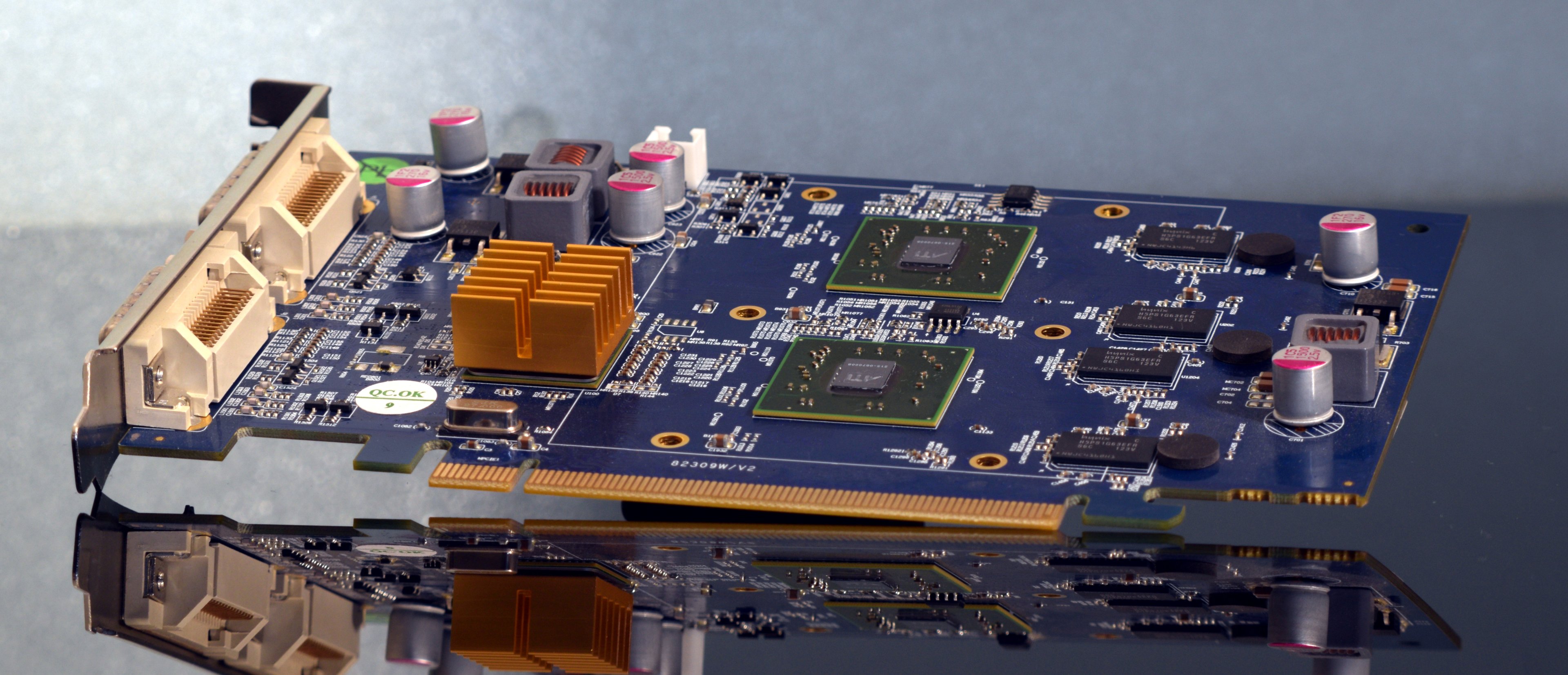

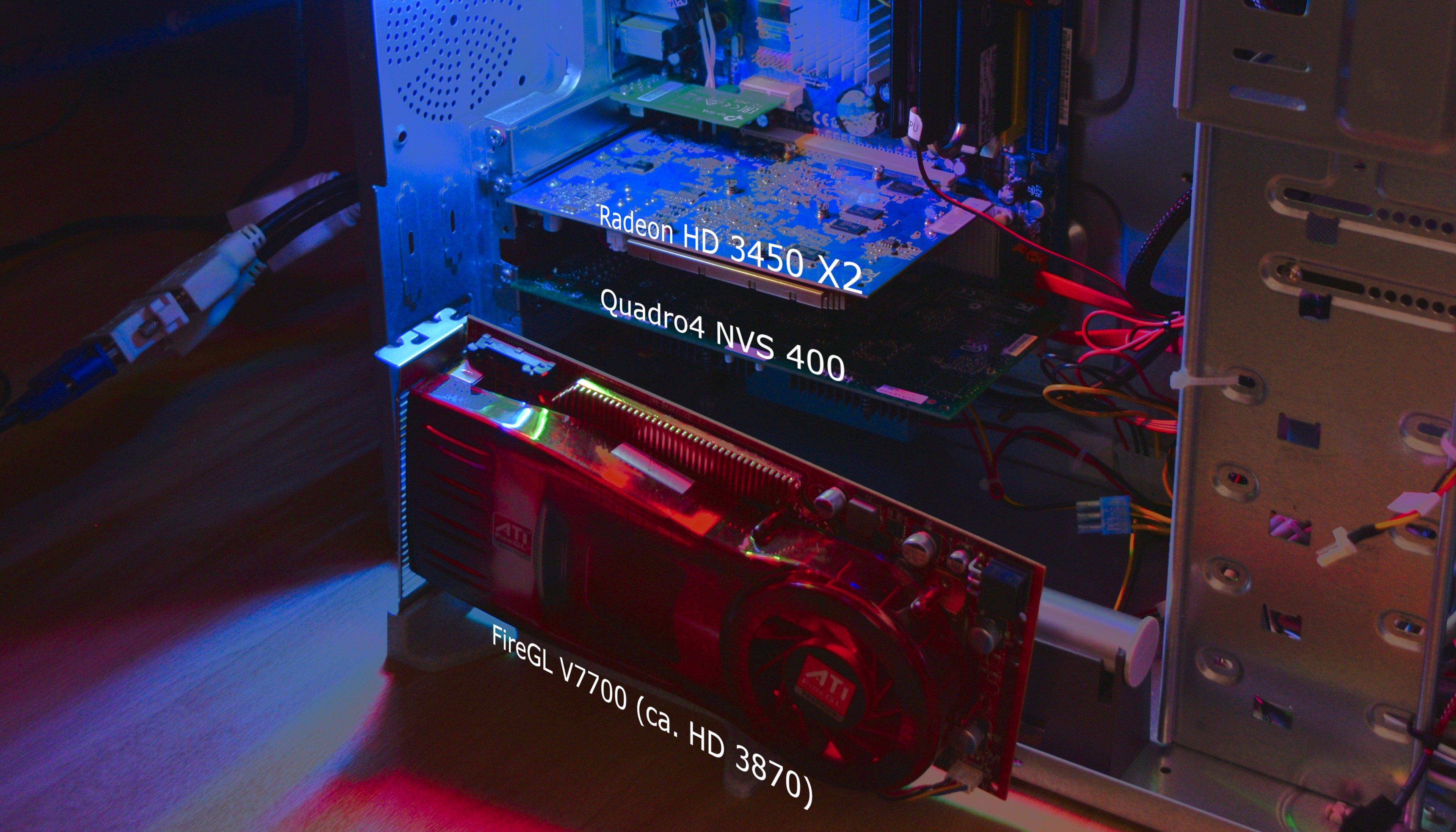

Nvidia präsentierte für diesen Fall die Quadro4 NVS 400, die zwei nv17 aka GeForce 4MX Chips auf einem einzelnen PCI (non-e) Board mit sich brachte. Da die Quadro Serie im Profi-Bereich angesiedelt war, schlug der Anfangspreis mit bis zu 1.000€ zu Buche.

Dafür wurden dem Käufer kastrierte MX-Chips geboten, denn der Chiptakt beträgt 220 MHz und der Speichertakt liegt bei 166 MHz DDR, was haargenau den MX 420 entspricht, Nvidias kleinstem Consumer-Chip.

Veröffentlicht wurde diese Karte im Juni 2002, wobei nach der Insolvenz von VisionTek jetzt PNY als Hersteller auftrat.

Quadro4 NVS 400 vor einer Radeon R9 Fury

Parallel hat Matrox die Parhelia in den Verkauf gebracht, eine der ersten oder gar die Erste Karte mit der Möglichkeit, drei Bildschirme anzuschließen.

Vorher gab es eine Karte mit vier G550 (Condor) Chips auf einer Platine für vier Bildschirme.

ATi wiederum bot im Jahr 2002 eine Monster-Karte mit 4x R300 Chips an.

Nur zum Vergleich: ein einzelner R300 Chip hat 107 Mio. Transistoren, Nvidias Topmodell hat 63 Mio. und der einzelne NVS 400 Chip verfügt über 29 Mio., so wie 80 Mio. Transistoren bei der Parhelia.

*laut Techpowerup (107 Mio. = Wiki und ComputerBase Connect3D Radeon 9700 Pro im Test: Leistungssprung bei hohen Auflösungen (Seite 4) - ComputerBase)

*sofern ein zweiter RAMDAC verbaut ist

You can calculate the max res your RAMDAC allows thusly: [horizontal res * vertical res * refresh rate (Hz)] * (1 MHz / 1,000,000Hz) = RAMDAC speed required (MHz)

Diese große ATi Karte war sicherlich etwas für Evans & Sutherland und andere Anbieter für Simulatoren, laut Google Suche kam diese tatsächlich auch direkt von E & S.

Über einen längeren Zeitraum wurden diese von 3dfx mit Chips versorgt. Entsprechende Karten waren z.B. von Quantum 3D und boten vier Voodoo 2 im SLI oder auch acht VSA-100 Chips.

Wenn weniger die Leistung gefragt war, dafür aber die Multi-Monitor-Unterstützung wichtig ist, setzte man einfach die besagten zwei NV17 Chips auf ein Board und kombinierte das mit einem PLX-Brückenchip. Teilweise ist auch die Aufschrift "HiNT" zu finden.

Aufgrund des sparsamen Verbrauchs war dann auch gleich ein passiver Betrieb möglich.

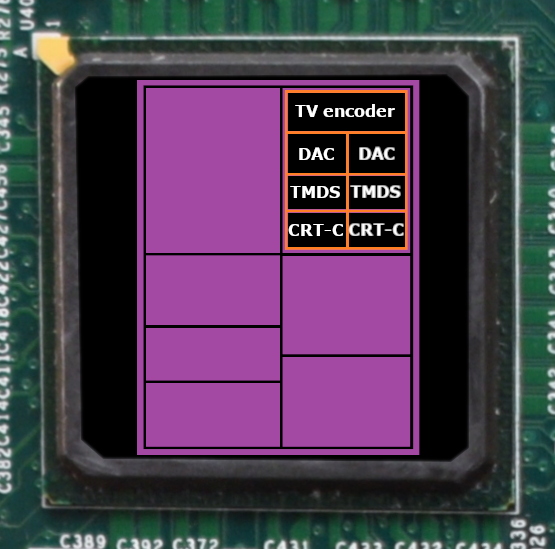

Schematische Darstellung des NV17

Der Hersteller Jaton ging später einen ähnlichen Weg und packte zwei RV620 Chips auf eine Platine.

Hier die wichtigsten Daten:

*der AGP stellt maximal 35 W zur Verfügung

Mit den beiden RV620 Chips lassen sich keine Bäume ausreißen, auch wenn der Treiber CrossfireX ermöglicht.

Weitere Benchmark Ergebnisse: https://www.computerbase.de/news/grafikkarten/gpu-generationen-benchmarks.82266/

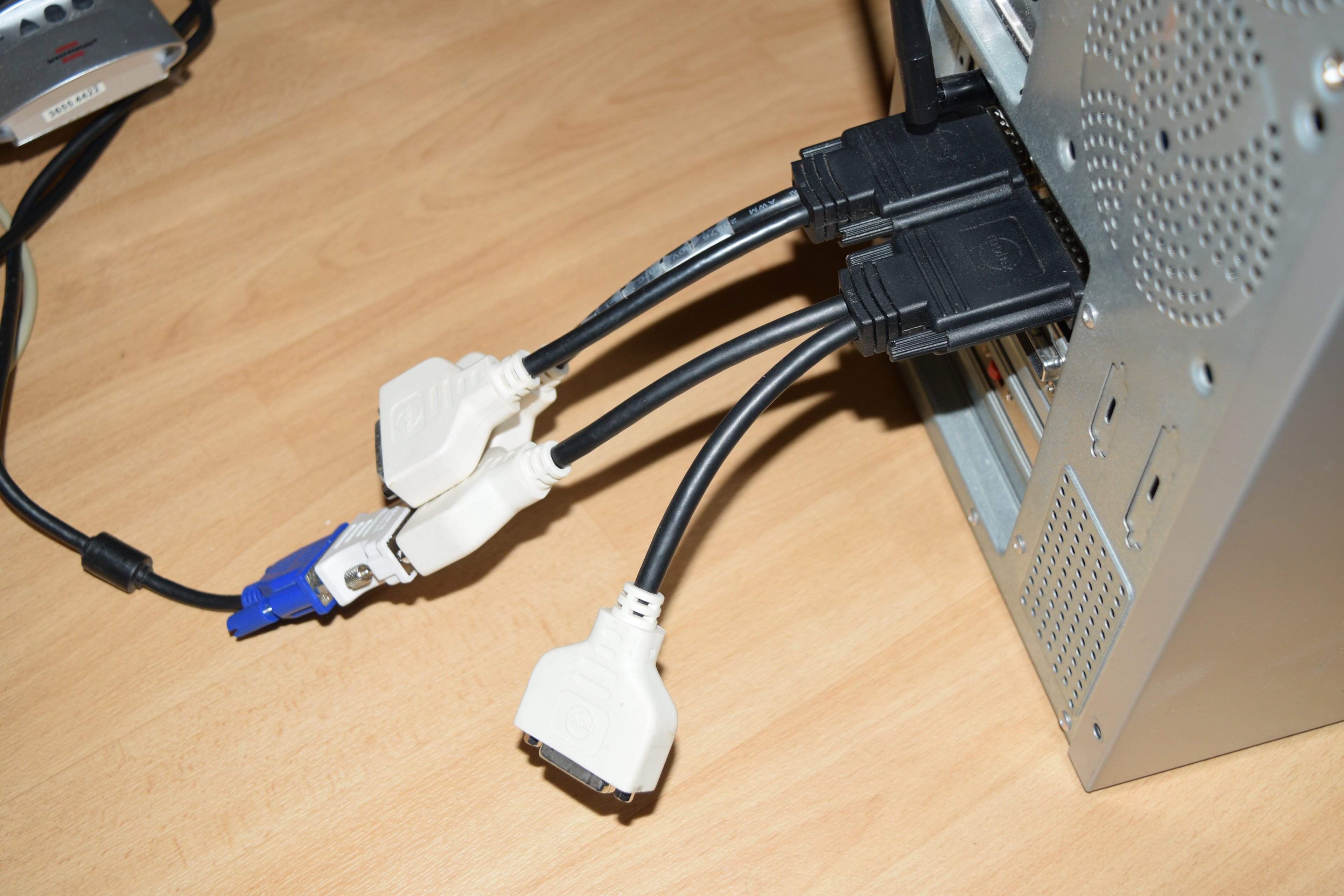

Ein Test der NVS 400 steht noch aus, da hier zu zwingend Windows XP oder älter nötig ist. Das entsprechende System muss ich noch aufsetzen sowie die entsprechenden DVI-Adapter kaufen. Als Testsystem bleibt es beim gewohnten Core 2 Quad.

Zum Abschluß lässt sich folgendes sagen:

Für die damalige Zeit war es ein guter Kompromiss aus Multi-Display und sparsamen Verbrauch. Nicht jede Anwendung benötigte die Rechenleistung, die die GeForce 4 Ti oder Radeon HD 3870 X2 bereitgestellt hatten. Eine einfache 2D Ausgabe in Kraftwerken etc. haben eine geringere Anforderung als jemand, der ein Starship in CAD abbilden muss.

Insofern war es richtig, auch die kleinsten Chips für diese Boards zu nehmen.

Aus der heutigen Perspektive mutet es seltsam an, dass man für vier Displays zwei Chips brauchte, bieten AMD, Nvidia und Matrox doch mehr Möglichkeiten. Karten wie die RX 6400/6500 werden deshalb auch von der Community bemängelt, da diese nur zwei Displays befeuern kann.

Auf der anderen Seite ist eine Matrox M9188 mit 8x Mini Display Ports, zu einem Preis von 2.000€ das andere Extrem, welches schon am 13.11.2009 eingeführt wurde. Bietet sie doch ebenfalls nur Dx10.1 wie die HD 3450 und schlug damals mit 1.300€ zu Buche.

Beide Karten basieren auf der TeraScale Architektur in 55nm, sind also Geschwister. Um welche Chips es sich genau handelt, verrät Matrox aber nicht und auch wie die doppelte Anzahl an Monitoren realisiert wird, ist mir nicht bekannt, dadurch, dass kein RAMDAC, also ein Digital-Analog-Wandler gebraucht wird, dürfte eine Videowand mit 8 Displays leichter zu realisieren sein als bei der HD 3450 X2, die vier Analoge oder Digitale Monitore befeuern kann. Eindeutig lässt sich nur erkennen, dass ebenfalls zwei Radeon GPUs zum Einsatz kommen.

Preislich kann ich zu der Jaton bisher nichts sagen, da diese weder bei Geizhals gelistet ist noch ich diese in der Wayback Machine gefunden habe.

Eine einzelne ATi Fire MV2260 kam im November 2010 120€ über Alternate (ALTERNATE - HARDWARE - Grafikkarten - PCIe-Karten ATI/AMD - Workstation - ATI Fire MV2260 Display Port (archive.org)).

Diese nutzte ebenfalls den RV620 Chip.

Die FireMV 2400 mit ebenfalls zwei Chips, aber noch auf Basis des RV380 Chips kostete im selben Zeitraum 370€ (ALTERNATE - HARDWARE - Grafikkarten - PCIe-Karten ATI/AMD - Workstation - ATI FireMV 2400 (archive.org)) (ATI FireMV 2400 PCIe x1 Specs | TechPowerUp GPU Database).

Als Basis diente hier die X600 Grafikkarte.

Ansonsten bleibt mir nur zu sagen: kommt gut in den Sonntag rein

SilentFlux (Kühler)

Sunon Waturbo - die kleinste AiO im Test (Kühler)

Thermaltake IFX-14 und HR-10 (Kühler)

Peltierkühler auf dem Sockel 775

Inhaltsangabe

- Die Situation in den 90ern

- Das Ziel

- technische Daten

- Das Testsystem

- Ergebnisse

- Fazit

- weitere Retro-Tests

Die 90er

Doch nach und nach kam das Bedürfnis auf, auch einen zweiten Monitor oder TV zu befeuern. Bei Nvidia machte bereits die Riva 128 Serie den Anfang, wobei hier möglicherweise das entweder oder Prinzip zum Einsatz kam, sprich ein RAMDAC für einen Monitor oder TV, denn ein TV-Encoder bedeutet nicht automatisch, dass ein zweiter RAMDAC installiert ist.

Später war es die GeForce 2MX, zwar langsamer als die vollwertige GeForce 2 Serie, die dafür aber eine größere Auslegung Richtung Multimedia besaß, was es bei dieser Generation zu einem Alleinstellungsmerkmal im Konzern machte. Ja, wie bereits erwähnt, konnten die Riva 128 und TNT über einen TV Out verfügen, aber die Technik war noch auf dem Stand von Dx5 oder Dx6 und damit nicht mehr zeitgemäß. Denn die GeForce 256 besaß keinen entsprechenden Gegenpart und die MX Reihe war somit die erste Multimedia-Karte Nvidias.

ATi, damals noch kein Bestandteil von AMD, war da schon weiter und bot auch bei den High End Karten Radeon 7500 bis zu drei Ausgänge, von denen zwei gleichzeitig nutzbar waren.

Möglich machte das alles ein zweiter RAMDAC.

3dfx war mit der Auslegung als reine Gaming Karte ein Außenseiter, die bei der Voodoo 3 zwar schon einen TV-Tuner boten, aber beim Nachfolger wurde hauptsächlich nur ein VGA-Ausgang verbaut.

Das Ziel

Was war aber, wenn man mehr als zwei Bildschirme brauchte? Dann musste man halt zwei Grafikkarten einsetzen.

Sollten nicht genügend Steckplätze, hier PCI und PCIe, vorhanden sein, musste man ein Multi-GPU-Gespann auf einer einzelnen Karte realisieren.

Nvidia präsentierte für diesen Fall die Quadro4 NVS 400, die zwei nv17 aka GeForce 4MX Chips auf einem einzelnen PCI (non-e) Board mit sich brachte. Da die Quadro Serie im Profi-Bereich angesiedelt war, schlug der Anfangspreis mit bis zu 1.000€ zu Buche.

Dafür wurden dem Käufer kastrierte MX-Chips geboten, denn der Chiptakt beträgt 220 MHz und der Speichertakt liegt bei 166 MHz DDR, was haargenau den MX 420 entspricht, Nvidias kleinstem Consumer-Chip.

Veröffentlicht wurde diese Karte im Juni 2002, wobei nach der Insolvenz von VisionTek jetzt PNY als Hersteller auftrat.

Quadro4 NVS 400 vor einer Radeon R9 Fury

Parallel hat Matrox die Parhelia in den Verkauf gebracht, eine der ersten oder gar die Erste Karte mit der Möglichkeit, drei Bildschirme anzuschließen.

Vorher gab es eine Karte mit vier G550 (Condor) Chips auf einer Platine für vier Bildschirme.

ATi wiederum bot im Jahr 2002 eine Monster-Karte mit 4x R300 Chips an.

Nur zum Vergleich: ein einzelner R300 Chip hat 107 Mio. Transistoren, Nvidias Topmodell hat 63 Mio. und der einzelne NVS 400 Chip verfügt über 29 Mio., so wie 80 Mio. Transistoren bei der Parhelia.

technische Daten 01

| Hersteller | nVidia | nVidia | Matrox | Matrox | Matrox | ATi | ATi/AMD | ATi/AMD | nVidia |

| Board-hersteller | diverse | PNY | Matrox | Matrox | Matrox | ?? | Jaton | diverse | PNY |

| Chip | NV25 | NV17 | Parhelia | Condor | Condor | R300 | RV620 | RV670 | G96C |

| Prozess | 150 nm | 150 nm | 150 nm | 180 nm | 180 nm | 150 nm | 55 nm | 55 nm | 55 nm |

| Mio. Trans. | 63 Mio. | 29 | 80 | 10 | 10 | 110* | 181 | 666 | 314 |

| Trans. pro mm² | 443,7 K/mm² | 446,2 K | 459,8 K | n.a. | n.a. | 511,6 K | 2,7 M/mm² | 3,5 M | 2,6 M |

| mm² | 142 mm² | 65 | 174 | n.a. | n.a. | 215 | 67 | 192 | 121 |

RAMDAC Geschwindigkeiten

| Karte | GeForce 4 Ti | GeForce 4 MX / NVS 400 | GeForce 2 MX (NV11) | Matrox Parhelia | Matrox G450 Quad | Radeon 9700 | Radeon HD 3450 X2 | Radeon HD 3850 | Quadro FX 580 |

| RAMDAC 1 | 350 MHz | min. 240 MHz | 400 MHz | 360 MHz | 400 MHz | ||||

| RAMDAC 2 (z.B. Chip intern) | 350 MHz | 350 MHz (intern?) | 350 MHz | 400 MHz | 200 MHz | 400 MHz (?) | |||

| RAMDAC 3 | min 270 MHz | ||||||||

| Monitore max. | max. 4 | bis zu 2* | 3 | bis zu 32 Desktops | 2 |

You can calculate the max res your RAMDAC allows thusly: [horizontal res * vertical res * refresh rate (Hz)] * (1 MHz / 1,000,000Hz) = RAMDAC speed required (MHz)

Diese große ATi Karte war sicherlich etwas für Evans & Sutherland und andere Anbieter für Simulatoren, laut Google Suche kam diese tatsächlich auch direkt von E & S.

Über einen längeren Zeitraum wurden diese von 3dfx mit Chips versorgt. Entsprechende Karten waren z.B. von Quantum 3D und boten vier Voodoo 2 im SLI oder auch acht VSA-100 Chips.

Wenn weniger die Leistung gefragt war, dafür aber die Multi-Monitor-Unterstützung wichtig ist, setzte man einfach die besagten zwei NV17 Chips auf ein Board und kombinierte das mit einem PLX-Brückenchip. Teilweise ist auch die Aufschrift "HiNT" zu finden.

Aufgrund des sparsamen Verbrauchs war dann auch gleich ein passiver Betrieb möglich.

Schematische Darstellung des NV17

Karten

Der Hersteller Jaton ging später einen ähnlichen Weg und packte zwei RV620 Chips auf eine Platine.

Hier die wichtigsten Daten:

| Hersteller | nVidia | nVidia | Matrox | Matrox | ATi | ATi/AMD | ATi/AMD | nVidia |

| Karte | GeForce 4 Ti 4200 | Quadro4 NVS400 | Parhelia | Millenium G450 x4 MMS | Radeon 9700 Pro X4 | Radeon HD 3450 X2 | Radeon HD 3850 | Quadro FX580 |

| Chip | NV25 | 2x NV17 | Parhelia-512 | 4x Condor | 4x R300 | 2x RV620 | RV670 | G96C |

| TDP | ? (<35W*) | 1x 18W | ? | ? | 4x ? (ca. 4x 40W) | 2x 25W | 75W | 40W |

| DircetX (Dx) | Dx8.1 | Dx7 | Dx8.1/9 | Dx6 | Dx9 | Dx10.1 | Dx10.1 | Dx10.0 |

| OpenGL | 1.5 | 1.5 | 1.3 | ? | 2.0 | 3.3 | 3.3 | 3.3 |

| Pixel-pipelines | 4 | 2x 2 | 4 | 4x 2 | 4x 8 | 2x 4 | 16 | 8 |

| Textur-units | 8 | 2x 4 | 16 | 4x 2 | 4x 8 | 2x 4 | 16 | 16 |

| Pixel Shader | 4 | 0 | 4 | 0 | 4x 8 | 2x 40 | 320 | 32 |

| PS Version | 1.3 | 1.3 (Dx8.1) | 2.0 | Unified Shader 4.1 | Unified Shader 4.1 | Unified Shader 4.0 | ||

| Vertex Shader | 2 | 0 | 4 | 0 | 4x 4 | / | / | / |

| VS Version | 1.1 | 2.0 (Dx9) | 2.0 | / | / | / | ||

| GPU-Takt | 250 MHz | 2x 220 MHz | 250 MHz | 4x 125 MHz | 4x 325 MHz | 2x 600 MHz | 668 MHz | 450 MHz |

| Shader-Takt | - | - | - | - | - | - | - | 1125 MHz |

| Speicher-Takt | 250 MHz DDR | 2x 166 MHz DDR | 300 MHz DDR | 4x 166 MHz DDR | 4x 310 MHz DDR | 2x 500 MHz DDR | 830 MHz DDR | 800 MHz DDR |

| Busbreite | 128 Bit | 2x 128 Bit | 256 Bit | 4x 64 Bit | 4x 256 Bit | 2x 64 Bit | 256 Bit | 128 Bit |

| Speicher-bandbreite in GB/s | 8,0 GB/s | 2x 5,312 | 19,2 | 2,656 | 4x 19,84 | 2x 8,0 | 53,12 | 25,6 |

| Speicher in MB | 64 MB DDR | 2x 64 MB DDR | 128 MB DDR | 4x 32 MB DDR | 4x 128 MB DDR | 2x 512 MB DDR2 | 512 MB GDDR3 | 512 MB GDDR3 |

Mit den beiden RV620 Chips lassen sich keine Bäume ausreißen, auch wenn der Treiber CrossfireX ermöglicht.

Das Testsystem

- Core 2 Q8300 ES (4x 2,5 GHz)

- ASRock G31M-GS,

- 2x 2GB OCZ DDR2 @666 MHz

- 2,5" 120 GB SSD

- Windows 7 Pro

- Ryzen 5 3500U (4x 2,1 GHz, 8 Threads)

- 2x 8 GB DDR4 @2.400 MHz

- Vega 8, max. 1,1 GHz

- 512 GB Samsung NVMe

- Windows 10/11 Pro

Software

- 3DMark 2000

- 3DMark 2001 SE

- 3DMark 03

- 3DMark 05

- 3DMark 06

- Tropics

- Sanctuary

- Aquamark

Testergebnisse

| Karte | Radeon X1600 Pro | Quadro FX 580 | Radeon HD 3450 X2 | Radeon HD 3450 Single GPU | Radeon Vega 8 | |

| Benchmark | CrossfireX aktiviert | |||||

| 3DMark 2000 | 1024*768 @16 Bit | 19.668 | 4.901 | n.a. | 15.962 | - |

| @32 Bit | 19.129 | 5.398 | - | 14.023 | - | |

| 2001 SE | 1024*768 | 16.208 | - | n.a. | 12.852 | - |

| 4xAA | 11.571 | - | - | 6.170 | - | |

| 3DMark 03 | 1024*768 | 7.372 | 13.791 | n.a. | 4.214 | 29.494 |

| 4x AA | 4.430 | 8.050 | - | 2.038 | 14.098 | |

| 3DMark 05 | 1024*768 | 4.622 | 10.459 | 5.562 | 3.918 | - |

| 4x AA | 3.838 | 8.107 | 3.873 | 2.478 | - | |

| 3DMark 06 | 1280*1024 | 1.972 | 4.773 | 3.040 | 1.711 | 10.242 |

| 4x AA | 1.388 | - | 2.008 | 1.086 | 6.512 | |

| Tropics | 1024*768 | 151 | - | 256 | 138 | - |

| 4x AA | 77 | - | 160 | 86 | - | |

| Sanctuary | 1024*768 | 431 | - | 709 | 357 | - |

| 4x AA | 404 | - | 622 | 313 | - | |

| Aquamark | 1024*768 | 49,991 | - | 65,326 | 38,427 | - |

Ein Test der NVS 400 steht noch aus, da hier zu zwingend Windows XP oder älter nötig ist. Das entsprechende System muss ich noch aufsetzen sowie die entsprechenden DVI-Adapter kaufen. Als Testsystem bleibt es beim gewohnten Core 2 Quad.

Fazit

Zum Abschluß lässt sich folgendes sagen:

Für die damalige Zeit war es ein guter Kompromiss aus Multi-Display und sparsamen Verbrauch. Nicht jede Anwendung benötigte die Rechenleistung, die die GeForce 4 Ti oder Radeon HD 3870 X2 bereitgestellt hatten. Eine einfache 2D Ausgabe in Kraftwerken etc. haben eine geringere Anforderung als jemand, der ein Starship in CAD abbilden muss.

Insofern war es richtig, auch die kleinsten Chips für diese Boards zu nehmen.

Aus der heutigen Perspektive mutet es seltsam an, dass man für vier Displays zwei Chips brauchte, bieten AMD, Nvidia und Matrox doch mehr Möglichkeiten. Karten wie die RX 6400/6500 werden deshalb auch von der Community bemängelt, da diese nur zwei Displays befeuern kann.

Auf der anderen Seite ist eine Matrox M9188 mit 8x Mini Display Ports, zu einem Preis von 2.000€ das andere Extrem, welches schon am 13.11.2009 eingeführt wurde. Bietet sie doch ebenfalls nur Dx10.1 wie die HD 3450 und schlug damals mit 1.300€ zu Buche.

Beide Karten basieren auf der TeraScale Architektur in 55nm, sind also Geschwister. Um welche Chips es sich genau handelt, verrät Matrox aber nicht und auch wie die doppelte Anzahl an Monitoren realisiert wird, ist mir nicht bekannt, dadurch, dass kein RAMDAC, also ein Digital-Analog-Wandler gebraucht wird, dürfte eine Videowand mit 8 Displays leichter zu realisieren sein als bei der HD 3450 X2, die vier Analoge oder Digitale Monitore befeuern kann. Eindeutig lässt sich nur erkennen, dass ebenfalls zwei Radeon GPUs zum Einsatz kommen.

Preislich kann ich zu der Jaton bisher nichts sagen, da diese weder bei Geizhals gelistet ist noch ich diese in der Wayback Machine gefunden habe.

Eine einzelne ATi Fire MV2260 kam im November 2010 120€ über Alternate (ALTERNATE - HARDWARE - Grafikkarten - PCIe-Karten ATI/AMD - Workstation - ATI Fire MV2260 Display Port (archive.org)).

Diese nutzte ebenfalls den RV620 Chip.

Die FireMV 2400 mit ebenfalls zwei Chips, aber noch auf Basis des RV380 Chips kostete im selben Zeitraum 370€ (ALTERNATE - HARDWARE - Grafikkarten - PCIe-Karten ATI/AMD - Workstation - ATI FireMV 2400 (archive.org)) (ATI FireMV 2400 PCIe x1 Specs | TechPowerUp GPU Database).

Als Basis diente hier die X600 Grafikkarte.

Ansonsten bleibt mir nur zu sagen: kommt gut in den Sonntag rein

Weitere Retro-Tests:

SilentFlux (Kühler)

Sunon Waturbo - die kleinste AiO im Test (Kühler)

Thermaltake IFX-14 und HR-10 (Kühler)

Peltierkühler auf dem Sockel 775

Zuletzt bearbeitet: