Hallo, ich habe ein Spielfeld was 8x8 Felder ist. Es geht darum, immer 3-Felder oder mehr, der gleichen Zahlenfolge zu verbinden. Die Zahlenfolgen liegen nicht immer genau nebeneinander - somit muss die jeweilige Zahl von Links nach Rechts, Oben oder Unten verschoben werden.

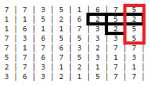

Ein Beispiel, vom Spielfeld:

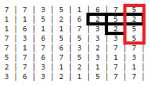

Ein Beispiel einer Kombination, wenn erstere ausgelöst wird, wird zweite (Rechts) im Anschluss ausgelöst:

Die Zahlen sind immer gleich, minimal 1 und maximal 7. Das Kombinieren ist nicht mein eigentliches Problem. Sobald eine Kombination besteht, werden diese auch entfernt und es "fallen" neue Zahlen von unten. Es besteht somit die Möglichkeit mit einer Kombination gleich mehrere Auszulösen, durch das "fallen" der Zahlen.

Die Zahlen, die nachkommen, sind irrelevant. Es geht nur um die im Moment bestehenden Zahlen.

Gibt es einen möglicherweise einen Algorithmus bzw. hat jemand eine Idee, wie sich solch eine Kombinationsmöglichkeit am besten bewältigen lässt?

Ein Beispiel, vom Spielfeld:

Ein Beispiel einer Kombination, wenn erstere ausgelöst wird, wird zweite (Rechts) im Anschluss ausgelöst:

Die Zahlen sind immer gleich, minimal 1 und maximal 7. Das Kombinieren ist nicht mein eigentliches Problem. Sobald eine Kombination besteht, werden diese auch entfernt und es "fallen" neue Zahlen von unten. Es besteht somit die Möglichkeit mit einer Kombination gleich mehrere Auszulösen, durch das "fallen" der Zahlen.

Die Zahlen, die nachkommen, sind irrelevant. Es geht nur um die im Moment bestehenden Zahlen.

Gibt es einen möglicherweise einen Algorithmus bzw. hat jemand eine Idee, wie sich solch eine Kombinationsmöglichkeit am besten bewältigen lässt?

Zuletzt bearbeitet: