Die Fabric von AMD ist schön und gut, braucht aber auch extrem viel Power:

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Notiz Architecture Event: Intel will im kleinen Kreis über Architekturen sprechen

- Ersteller MichaG

- Erstellt am

- Zur Notiz: Architecture Event: Intel will im kleinen Kreis über Architekturen sprechen

- Registriert

- März 2011

- Beiträge

- 705

Präsentiert Intel da stolz den Inhalt ihrer berühmten Schublade?... Klebstoff um ihre Dies zu verkleben? 🤣

Spaß bei Seite. Mal sehen was davon nach außen dringt. Wäre schon interessant wann Intel eine komplett neue Architektur plant.

Spaß bei Seite. Mal sehen was davon nach außen dringt. Wäre schon interessant wann Intel eine komplett neue Architektur plant.

aldaric

Admiral

- Registriert

- Juli 2010

- Beiträge

- 8.264

@TopperHarley87

Es ist ja eigentlich nichts neues das Intel eine neue Architektur plant. Gerüchte sagten was von 2021/2022. Für diesen Zeitraum soll auch AMD eine neue Architektur planen.

Ob es dann aber wirklich komplett neue Architekturen werden, oder nur aufgebohrte Zen/Core Architektur werden wir wohl noch lange warten müssen.

Es ist ja eigentlich nichts neues das Intel eine neue Architektur plant. Gerüchte sagten was von 2021/2022. Für diesen Zeitraum soll auch AMD eine neue Architektur planen.

Ob es dann aber wirklich komplett neue Architekturen werden, oder nur aufgebohrte Zen/Core Architektur werden wir wohl noch lange warten müssen.

Aldaric87 schrieb:2021/2022. Für diesen Zeitraum soll auch AMD eine neue Architektur

So früh? Ist nicht von einem AMD-Mitarbeiter bereits was von Zen5 erwähnt worden? Der dürfte ja frühestens 2022 auf dem Markt kommen, wenn der Jahrestakt eingehalten werden kann (Zen2: 2019; Zen3: 2020; Zen4: 2021 und Zen5 dann 2022). Neue Architektur ab 2023 wäre natürlich nicht unrealistisch, man reitet sie dann auch nicht so tot, wie Intel ihr Core.

Die Frage ist ob SMT bzw. Hyperthreading bei zukünftigen CPU bleiben wird, wie wir mittlerweile wissen ist es ein Sicherheitsrisiko, welches zumindest bei zukünftigen Server-CPUs wegfallen könnte und durch eine größere Anzahl an nativen Kernen kompensiert werden könnte.

Die Frage ist ob der IPC-Wert auf Threadlevel überhaupt noch signifikant gesteigert werden kann ohne dass der Energiebedarf immens ansteigt,

oder ob AMD und Intel zukünftig einfach mehr Kerne und Cache auf den Chip packen werden u. es den Programmierern überlassen aus diesen die entsprechende Performance herauszukitzeln.

Die Frage ist ob der IPC-Wert auf Threadlevel überhaupt noch signifikant gesteigert werden kann ohne dass der Energiebedarf immens ansteigt,

oder ob AMD und Intel zukünftig einfach mehr Kerne und Cache auf den Chip packen werden u. es den Programmierern überlassen aus diesen die entsprechende Performance herauszukitzeln.

Richtig, das Gesetz von Amdahl,Holt schrieb:Die Performance skaliert aber auch nicht beliebig über die Kerne...

allerdings skaliert die Performance genausowenig linear mit der Anzahl der Transistoren eines Kerns.

Zwei Kerne mit weniger Transistoren können mehr Rechenleistung bringen im Vergleich zu einem "Transistor-Monsterkern".

Die Frage ist wie wichtig die Rechenleistung pro Thread zukünftig noch sein wird.

Die Taktfrequenz weiter zu erhöhen ist wohl keine Option, wie man schön sehen kann kann die Taktfrequenz trotz Verkleinerungen der Chipstrukturen nur wenig gesteigert werden.

Am 11. Dezember werden wir wohl von Intel mehr dazu erfahren...

Die Zahl der Transistoren wächst ja vor allem um immer mehr Befehlserweiterungen zu bringen, die sind dann zwar sehr schnell, aber eben nur für sehr bestimmte Probleme nutzbar. Da längst nicht alles parallelisiert werden kann, wird die Rechenleistung pro Thread immer wichtig bleiben, je nach Anwendung mehr oder weniger. Bei Servern die viele VMs hosten sicher weniger als bei anderen Anwendung, aber irgendwo gibt es z.B. auch immer Resourcen die man zentral verwalten muss, da können einfach nur zwei gleichzeitig etwas machen und dann ist die Singlethreadperformance wieder sehr wichtig, damit jeder solche kritischen Sequenzen schnell abarbeitet und der nächste Thread dran kann. Gäbe es sowas nicht, wozu würde man dann sowas wie einen Mutex oder Semaphore brauchen?

Smartcom5

Lt. Commander

- Registriert

- Dez. 2007

- Beiträge

- 1.704

Nein. Keine überarbeiteten x86-Erweiterungen, sondern gar keine mehr …InsideDaft schrieb:Erste Gerüchte kamen bereits Ende 2016 auf, dass man nach den Lakes (2021?) ne neue Architektur mit überarbeiteten x86 Erweiterungen bringen wird. […]

Smartcom5 schrieb:…

Dieses »hinsetzen und Brainstorming« haben sie jetzt erst vor wenigen Wochen getan – und dies ja auch mit einer gänzlich neuen Architektur angekündigt. Ihre ersten Bemühungen werden sein, daß man viele Teile der in Hardware vorhandenen Abwärtskompatibilität aus der Architektur entfernt und damit hoffentlich die IPC deutlich steigern kann.

Man entfernt quasi sämtliche Befehlssätze von 8080–486 (die x86-64-Architektur ist bis heute Bit- und Ausführungs-kompatibel zum ersten Prozessor der x86-Plattform), spart dadurch etwas mehr Platz, erhofft sich aber dadurch, die Ausführungseinheiten deutlich höher takten zu können. Ob das der Fall sein wird, wissen selbst die Intel-Ingenieure nicht – es bleibt eine hehre Hoffnung und hoffentlich Früchte tragende Erwartungshaltung. Es ist eben einen Versuch wert, auch wenn es eine milliardenschwere Sackgasse werden könnte.

…

Von Licht und Schatten

Die Kehrseite der Medaille ist allerdings, daß Intel „ihre“ eigene Architektur – daher sowohl die kapitalen Fundamente der x86-Architektur in Form der IA-32 (retronym als „Intel Architecture 32-bit“ bezeichnet) – damit unweigerlich vollständig aufgeben würde und in Folge die zugrundeliegende Intel'sche (Haupt-) Architektur (Intel 80x86) als auch die Verquickung mit der AMD64-Architektur (-erweiterung) damit aufhören würde zu existieren. Diese Verquickung der beiden Architekturen wird ja nicht ohne Grund als x86_64 tituliert …

Ich weiß ja nicht wie ihr das seht, aber ich fände das irgendwie in höchstem Maße ironisch!

Ironie des Schicksals

In Ermangelung eigenen geistigen Eigentums würde Intel mit diesem Tag de facto nur noch zum bloßen Lizenznehmer ihrer „eigenen“ Prozessor-Architektur verkommen – da ja mit einem Schlage plötzlich nur noch eine einzige „x86“-Architektur bestünde. Und das wäre dann unweigerlich AMD64, welche bekanntlich unbestreitbar nur einem gehört: AMD.

Intel wäre dann unausweichlich auf Gedeih und Verderb plötzlich vollends auf das Wohlvollen AMDs angewiesen, da sie die Architekturerweiterung ja lediglich von AMD lizenzieren. Ihr eigener Vorstoß in Richtung 64-Bit war ja die unsinkbare

Das wäre allerdings der für alle Zeiten ungeschlagene Treppenwitz der Weltgeschichte!

Mal schauen wie‘s dann kommt – in Sachen Kurzsichtigkeit hat Intel ja die letzten Jahre doch schon größere Erfahrungen gemacht …

@cirrussc Das ist definitiv kein from the scratch wie das weiße Blatt Papier, womit AMD seinerzeit bei Zen angefangen hat!cirrussc schrieb:Das ist doch schon seit einem Jahr bekannt, dass Intel daran arbeitet.RYZ3N schrieb:Spaß bei Seite, bin gespannt was davon durchsickern wird. Es wird Zeit das Intel die Core Microarchitektur begräbt und from the scratch am Reißbrett anfängt.

Es werden nur Bestandteile der Core-µArch entfernt, siehe unten …

@RYZ3N Ach Sven, komm! Core-Architektur begraben und neu am Reißbrett anfangen?!

Was soll das denn, wo kämen wir denn da hin – das wäre ja innovativ!

In diesem Sinne

Smartcom

Das auch, aber nicht nur, es gehen auch immer mehr Transistoren für die notwendigen Caches drauf, um die Recheneinheiten nicht durch den Zugriff auf das vergleichsweise langsame RAM auszubremsen.Holt schrieb:Die Zahl der Transistoren wächst ja vor allem um immer mehr Befehlserweiterungen zu bringen, die sind dann zwar sehr schnell, aber eben nur für sehr bestimmte Probleme nutzbar.

Fakt ist dass zwar der Speichertakt u. damit der Durchsatz steigt, aber die Latenz hat sich über die Jahre nicht so deutlich geändert.

Die CPU muss 40 bis 50 Taktzyklen warten falls die Daten nicht im Cache vorliegen u. direkt aus dem RAM geladen werden müssen.

Was ebenfalls schwierig ist weiter zu beschleunigen dass sind bedingte Anweisungen und Verzweigungen.

Was bislang bei der Ice Lake Architektur bekannt ist:

- Die AVX-Recheneinheiten werden auf 512 Bit verdoppelt (AVX-512)

- Die Größe der L2-Caches wird verdoppelt, vermutlich um die AVX-Recheneinheiten nicht auszubremsen.

- Die iGPU wird deutlich an 3D-Performance zulegen.

Ansonsten habe ich gerade Null Motivation mit so wenig Infos über zukünftige CPU-Architekturen ins Blaue hinein zu spekulieren.

Ergänzung ()

AMD und Intel sind gegenseitig auf einander angewiesen was Befehlssatzerweiterungen betrifft.Smartcom5 schrieb:Intel wäre dann unausweichlich auf Gedeih und Verderb plötzlich vollends auf das Wohlvollen AMDs angewiesen, da sie die Architekturerweiterung ja lediglich von AMD lizenzieren.

Intel muss die 64 Bit-Erweiterung bei AMD lizensieren,

und AMD muss die SSE- und AVX-Befehlserweiterungen bei Intel lizensieren.

(MMX kann mittlerweile lizenzfrei genutzt werden, dürfte allerdings keine große Bedeutung mehr haben.)

Die Frage ist ob AMD es sich erlauben könnte CPUs ohne SSE und AVX zu verkaufen. Ich denke nicht.

Mitgefangen, mitgehangen.

Zuletzt bearbeitet:

Smartcom5 schrieb:Was soll das denn, wo kämen wir denn da hin – das wäre ja innovativ!

In meinen Augen ist das aber [für Intel] die einzige Möglichkeit [in der jetzigen Situation.]

Mit diesem „immer so weitermachen“ sind sie in die aktuelle Situation geraten und ja du hast vollkommen Recht, (...)

Smartcom5 schrieb:(...) in Sachen Kurzsichtigkeit hat Intel ja die letzten Jahre doch schon größere Erfahrungen gemacht … [IMG]https://www.computerbase.de/forum/attachments/hehee15x18-gif.723741/[/IMG]

(...) aber so kann es einfach nicht weitergehen.

Mit der aktuellen Taktik, der [irgendwann] 10., 11. und 12. Auflage der Core-µArch und der aktuell desolaten Außendarstellung ist irgendwann Ende.

Ich verstehe nicht was da aktuell bei Intel so alles schiefläuft.

Liebe Grüße

Sven

Das ist so, aber da die Taktraten ja auch kaum steigen, ist es eher zunehmend ein Problem das zu viele Kerne um die RAM Zugriffe konkurrieren. Wenn er gerade aufs RAM zugreift, muss der nächste ja auch noch warten bis der Zugriffe abgearbeitet wurde, bevor sein Zugriff überhaupt erst einmal dran ist, außer man hat eben keine Dual-Chanel Betrieb, sondern betreibt die Kanäle unabhängig (was auch weniger Bandbreite in den üblichen Benchmarks bedeutet) und die Daten liegen auf RAM Riegeln die an unterschiedlichen Kanälen hängen.WinnieW2 schrieb:Die CPU muss 40 bis 50 Taktzyklen warten falls die Daten nicht im Cache vorliegen u. direkt aus dem RAM geladen werden müssen.

Dafür gibt es wie bei den RAM Zugriffen die Vorhersagen, die man auch immer weiter zu perfektionieren versucht. Aber beides Grenzen, bei den RAM Zugriffen kann man nichts mehr durch Vorhersagen beschleunigen, wenn die Kerne mehr Datendurchsatz anfordern als das RAM liefern kann, eben weil die Algorithmen nur wenige Berechnungen auf den Daten anstellen und dann wieder andere Daten anfragen, die eben nicht im Cache stehen. Werden Daten über einen kleinen Adressraum benötigt, stehen die Daten also artig im Cache und laufen aufwendige Berechnungen darauf, dann spielt der RAM Durchsatz kaum noch eine Rolle. Man sieht es bei den Treadripper 29x0WX, deren Abschneiden in Benchmarks sehr von dem jeweiligen Benchmark abhängt.WinnieW2 schrieb:Was ebenfalls schwierig ist weiter zu beschleunigen dass sind bedingte Anweisungen und Verzweigungen.

Mag sein, aber da es tendenziell mehr Kerne geben wird, macht ein größere Cache schon Sinn um Die Anzahl der RAM Zugriffe möglichst zu verringern. Aber ein größerer Cache bedeutet immer auch mehr Aufwand bei dessen Verwaltung, man riskiert also auch eine größere Latenz bei den Zugriffen, es muss ja erst geschaut werden ob die Daten im RAM stehen und eine größere Leistungsaufnahme.WinnieW2 schrieb:Die Größe der L2-Caches wird verdoppelt, vermutlich um die AVX-Recheneinheiten nicht auszubremsen.

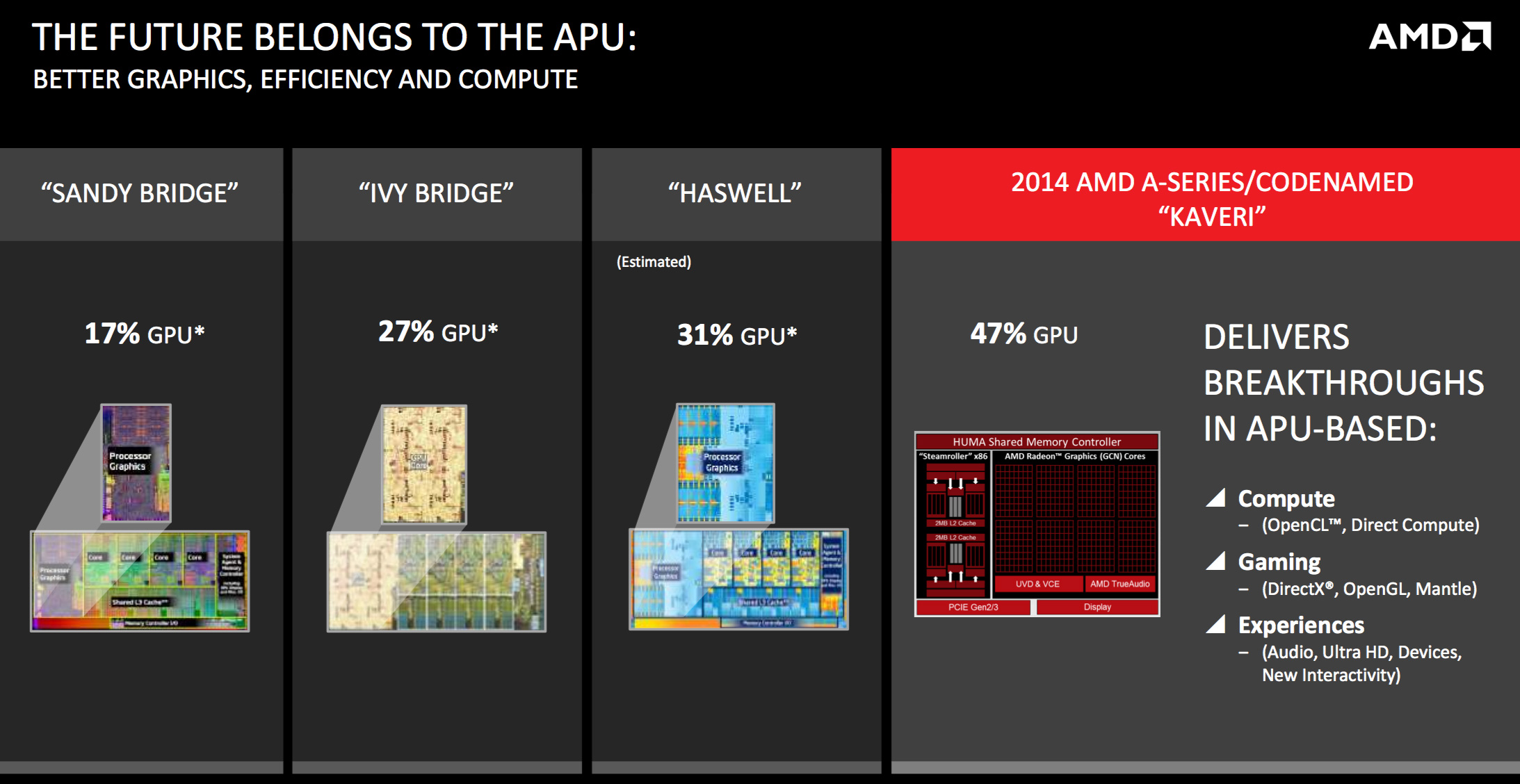

Das ist doch für den Eimer, die iGPU ist toll um Windows darauf darzustellen und ggf. noch das Abspielen von Videos zu beschleunigen, aber für halbwegs ernsthaftes Gaming wird man immer eine Graka verbauen und dann ist die iGPU allenfalls als Fallback relevant, sollte die Graka mal defekt sind. Eine iGPU mit hoher Leistung braucht also eigentlich kein Mensch, die sollten es sich sparen dafür Geld auszugeben und lieben jeder CPU eine kleine iGPU spendieren, so wie AMD den RYZEN auch gerne so eine kleine iPGU nur für Windows spendieren könnte. Dann bräuchte man nicht zwangsweise eine Graka verbauen nur um Windows oder gar nur ein Linux drauf laufen zu lassen, bei dem man den Monitor eigentlich nur einmal zu Installation des Systems braucht.WinnieW2 schrieb:Die iGPU wird deutlich an 3D-Performance zulegen.

Deshalb haben beide ja auch eine langfristiges Abkommen zum gegenseitigen Lizenzaustausch.WinnieW2 schrieb:AMD und Intel sind gegenseitig auf einander angewiesen was Befehlssatzerweiterungen betrifft.

Deswegen glaube ich nicht, dass das passieren wird.Smartcom5 schrieb:Ironie des Schicksals

In Ermangelung eigenen geistigen Eigentums würde Intel mit diesem Tag de facto nur noch zum bloßen Lizenznehmer ihrer „eigenen“ Prozessor-Architektur verkommen – da ja mit einem Schlage plötzlich nur noch eine einzige „x86“-Architektur bestünde. Und das wäre dann unweigerlich AMD64, welche bekanntlich unbestreitbar nur einem gehört: AMD.

Ich weiß auch nicht, inwieweit diese uralten Architekturteile so viel Raum und Problematik im gesamten Design einnehmen als dass sich so ein krasser Schnitt lohnen würde.

Und wenn es doch passiert, dann in einer Weise, die Intel nicht von AMD abhängig macht. Das würde Intel niemals zulassen.

Mithin bin ich der Überzeugung, dass Intel heimlich schon viel länger an neuen Auswegen und Architekturen forscht. Die Kapazitäten haben sie, auch die Notwendigkeit.

Smartcom5

Lt. Commander

- Registriert

- Dez. 2007

- Beiträge

- 1.704

Aldaric87 schrieb:Es ist ja eigentlich nichts neues das Intel eine neue Architektur plant. Gerüchte sagten was von 2021/2022. Für diesen Zeitraum soll auch AMD eine neue Architektur planen.

Ob es dann aber wirklich komplett neue Architekturen werden, oder nur aufgebohrte Zen/Core Architektur werden wir wohl noch lange warten müssen.

Wie gesagt, ihr Vorstoß einer gänzlich neuen Architektur beschrieb ich ja weiter oben schon. Quasi Core-µArch bloß ohne x86-Abwärtskompatibilität. Diese 'Slimline-x86'-Prozessor-Architektur soll (um Altlasten bereinigt) Geschwindigkeitsvorteile bringen, angeblich. Dumm ist nur, daß auf diese Ideé auch schon AMD gekommen ist – vor weit über einem Jahrzehnt bitteschön.TopperHarley87 schrieb:Präsentiert Intel da stolz den Inhalt ihrer berühmten Schublade?... Klebstoff um ihre Dies zu verkleben? 🤣

Spaß bei Seite. Mal sehen was davon nach außen dringt. Wäre schon interessant wann Intel eine komplett neue Architektur plant.

Oder um es mit anderen Worten zu sagen;What AMD Taught Me: x86 Everywhere

„Back when AMD first announced its intentions to extend the x86 ISA to 64-bits I asked Fred Weber, AMD's old CTO, whether it really made sense to extend x86 or if Intel made the right move with Itanium and its brand new ISA. His response made sense at the time, but I didn't quite understand the magnitude of what he was saying.

Fred said that the overhead of maintaining x86 compatibility was negligible, at the time around 10% of the die was the x86 decoder and that percentage would only shrink over time. We're now at around 8x the transistor count of the K8 processor that Fred was talking about back then and the cost of maintaining x86 backwards compatibility has shrunk to a very small number. But the benefit of backwards compatibility is huge.

These days just about everything is written for x86, everything in the PC space that is.“

— Anand Lal Shimpi, Gründer und damaliger Chefredakteur AnandTech.com, am 2. April 2008 · Intel's Atom Architecture: The Journey Begins

Intel wird hoffentlich nicht so dämlich sein den Fehler zu begehen, daran zu glauben daß man dadurch – also durch Entfernung des kausalen x86-Unterbaus, in diesem Falle ihrer eigenen fundamentalen Architektur in Form der IA-32 – heutzutage noch wie auch immer geartete signifikante Performance-Steigerungen würde erfahren, vor allem aber würde einfahren können.

Denn das ist schlicht ein kapitaler Trugschluß, den selbst AMD seinerzeit schon zur Zeit des AMD K-8 (nach offensichtlich eigenen Versuchen) kaum mehr als eine Randnotiz an Wert beimessen konnte. Es wurde ja auch immer wieder die letzten Jahre betont, daß der bloße Vorstoß in eine solche Richtung ein absolut erfolgloses Unterfangen wäre, da die Die-Fläche wie auch prozentuale Anzahl an der eigentlichen Transistor-Anzahl bei heutigen Prozessoren dermaßen verschwindend gering wäre, daß sich die bloße Überlegung einer solchen Durchführung dieses Vorhabens als vollkommen wertlos erweisen wird.

Ich hoffe, dessen ist sich Intel bewußt – und sie haben stattdessen einmal ein paar wirklich innovative Ideén. Und kommen nicht bloß mit einer Architektur wie Itanium 2.0, Larrabee oder ähnlichen Totgeburten, die krampfhaft aus Prestige-Gründen am Leben erhalten werden …

Hier übrigens der Artikel auf den sich Anand damals™ bezog – ist von August 2000.

Demnach hatte AMD diesen Einfall bereits vor jetzt fast 20 Jahren verworfen. Hoffentlich weiß das Intel …

Habe ich ja auch gar nicht in Abrede stellen wollen, da war mein Beitrag ja sarkastischer Natur.RYZ3N schrieb:In meinen Augen ist das aber [für Intel] die einzige Möglichkeit [in der jetzigen Situation.]

Mit diesem „immer so weitermachen“ sind sie in die aktuelle Situation geraten und ja du hast vollkommen Recht, (...)

Sie könnten ja ruhig noch eine Weile so weitermachen. Zumindest so lange, bis man tatsächlich eine gänzlich neue Architektur aus der Taufe gehoben hat – und bei der sie hoffentlich (wie AMD) tatsächlich einmal mit diesem leeren „weißen Blatt Papier“ angefangen haben (und nicht bloß die Core-Architektur einmal mehr nur modifizieren), sondern wirklich neu anfangen. Ohne Altlasten und ohne krumme Touren – vor allen Dingen aber eines: Ehrlich.

So lange – und das möchte ich einmal als Prognose für das morgige Event vorausschicken – könnte Intel sich behelfen, indem sie AMD's Fineglue™ eiskalt kopieren. Wobei ich stark vermute, daß sie zukünftig genau dies tun werden;

Prognose:

Intel kopiert AMD auf Technologie-Ebene in Richtung 'clustered CPU' und startet ebenso mit einem modularen Aufbau mit Chiplets, verbunden (günstigerweise) via EMIB. So könnte man die Kerne reduziert auf beispielsweise CPU-Cluster von bloß 4 Kernen mit flächenmäßig minimaler Größe (hoffentlich) dann auch auf ihrer kaputten 10nm-Node bringen und das heißgeliebte Milliardengrab vom Schlage Intel Iris Graphis™ müßten sie auch nicht aufgeben, da modular einzeln auf 14nm aufgelegt.

So könnte sich Intel bis zur neuen Architektur retten, man kann gar noch die desaströse Fertigung vom 10nm-Fiskao halbwegs brauchbar nutzen, ohne sie komplett abschreiben zu müssen (denn für alles außer Dual- oder Quadcore ist die Yield ja nachweislich schlicht nicht zu gebrauchen) …

Also winzige CPU-Kerne dediziert auf 10nm, Rest auf 14nm oder gar 22nm – alles als Cluster auf Die-Ebene udn nicht bloß als MCP. Bleibt spannend …

Selbst Cannonlake hat doch schon AVX-512? Und größere Caches sollen jetzt für Tigerlake die große Innovation bringen? Ich bleibe vorerst dabei, Tigerlake als dann (hoffentlich) allerletzte Iteration der Core-µArch wird wieder nur eine kaum veränderte Marginalie und Variante X und Referesh Y von Skylake & Konsorten – ebenso wie die ganzen anderen Aufgüsse à la Whiskey Lake, Comet Lake, Ice Lake und so fort.WinnieW2 schrieb:…

Ansonsten habe ich gerade Null Motivation mit so wenig Infos über zukünftige CPU-Architekturen ins Blaue hinein zu spekulieren.

SSE sicherlich nicht, aber AVX wäre wenn müßte denke ich schon zu einem gewissen Grad entbehrlich.WinnieW2 schrieb:Die Frage ist ob AMD es sich erlauben könnte CPUs ohne SSE und AVX zu verkaufen. Ich denke nicht.

Mitgefangen, mitgehangen.

Lektüre:

Planet3DNow.de • Intel mit komplett neuer CPU-Architektur nach 2019?

Bits'nChips.com • Even Intel is studying a new x86 uArch

In diesem Sinne

Smartcom

Zuletzt bearbeitet:

(Meine Güte, diese verflixten Auto-Tags! Ich HASSE respsonsive WYSIWYG-Editoren!!!)

Wenn es um 64 Bit Befehle geht und ohne die geht heute nichts mehr, ist Intel vom AMD abhängig, weil die eigene 64 Bit Erweiterung gefloppt ist und sich die von AMD durchgesetzt hat. Aber dies ist wegen des Patentaustauschabkommens auch kein Problem. AMD und Intel sind enger verbunden und stärker aufeinander angewiesen als es den Faboys in den Foren lieb ist.

Was die Architektur angeht, wo arbeitet Intel ja an der größte Erneuerung seit langer Zeit, aber wie genau die Architektur dann aussehen wird, werden wir kaum erfahren, denn seit AMD wieder ein ernstzunehmender Konkurrent ist, mauert Intel bei solchen Details gewaltig. Dies ist aber auch nicht so schlimm, denn wenn man sich nicht nur akademisch damit auseinander setzen möchte, kommt es sowieso mehr auf das Ergebnis als auf den Grund warum es so ist wie es eben ist.

Was die Architektur angeht, wo arbeitet Intel ja an der größte Erneuerung seit langer Zeit, aber wie genau die Architektur dann aussehen wird, werden wir kaum erfahren, denn seit AMD wieder ein ernstzunehmender Konkurrent ist, mauert Intel bei solchen Details gewaltig. Dies ist aber auch nicht so schlimm, denn wenn man sich nicht nur akademisch damit auseinander setzen möchte, kommt es sowieso mehr auf das Ergebnis als auf den Grund warum es so ist wie es eben ist.

Du meinst sicherlich das Event in einem Monat, oder?Smartcom5 schrieb:...das möchte ich einmal als Prognose für das morgige Event vorausschicken...

Cannon Lake sehe ich nicht als relevante CPU-Architektur, das ist eher Broadwell reloaded, meiner Ansicht nach.Smartcom5 schrieb:Selbst Cannonlake hat doch schon AVX-512?

Diese CPU wird nur in sehr kleinen Stückzahlen an OEM-Hersteller geliefert; zu geringe Stückzahlen um wirklich marktrelevant zu sein.

Bedeutende Stückzahlen in 10 nm wird Intel erst mit den Ice-Lake-CPU liefern... und diese werden noch ein ganzes Jahr auf sich warten lassen.

Nö, aber durch die Fertigung in 10 nm wären theoretisch auch 12 Kerner realisierbar, natürlich nur im Multi-Chip-Design, was aber ohnehin kommen wird.Smartcom5 schrieb:Und größere Caches sollen jetzt für Tigerlake die große Innovation bringen?

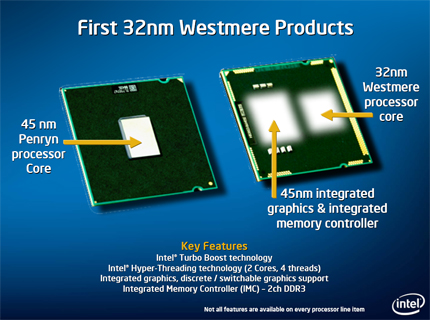

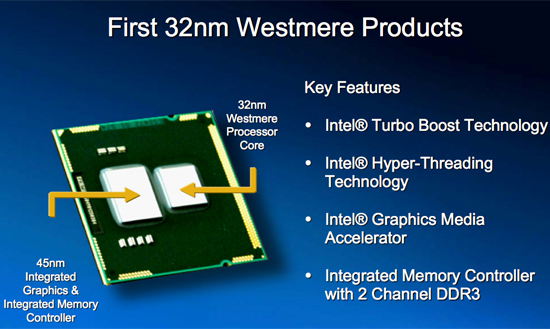

Ist aber nicht wirklich was neues bei Intel. Die Core 2 Quad waren ein Multichip-Design, ebenso wie die Westmere-Chips.

Vermutlich wird es wieder in diese Richtung gehen, kleinere Chips erhöhen die Yield-Rate und senken den Ausschuss bei der Fertigung insgesamt.

Ich will damit sagen dass ich deiner Annahme mit dem Multichip-Design zustimme.

Der Verzicht auf SSE alleine bewirkt dass die CPUs praktisch unverkäuflich werden.Smartcom5 schrieb:SSE sicherlich nicht, aber AVX wäre wenn müßte denke ich schon zu einem gewissen Grad entbehrlich.

Zuletzt bearbeitet:

K

knoxxi

Gast

Smartcom5

Lt. Commander

- Registriert

- Dez. 2007

- Beiträge

- 1.704

Eine iGPU braucht in der Tat kein Mensch, ja.Holt schrieb:Eine iGPU mit hoher Leistung braucht also eigentlich kein Mensch, die sollten es sich sparen dafür Geld auszugeben und lieben jeder CPU eine kleine iGPU spendieren, so wie AMD den RYZEN auch gerne so eine kleine iPGU nur für Windows spendieren könnte. Dann bräuchte man nicht zwangsweise eine Graka verbauen nur um Windows oder gar nur ein Linux drauf laufen zu lassen, bei dem man den Monitor eigentlich nur einmal zu Installation des Systems braucht.

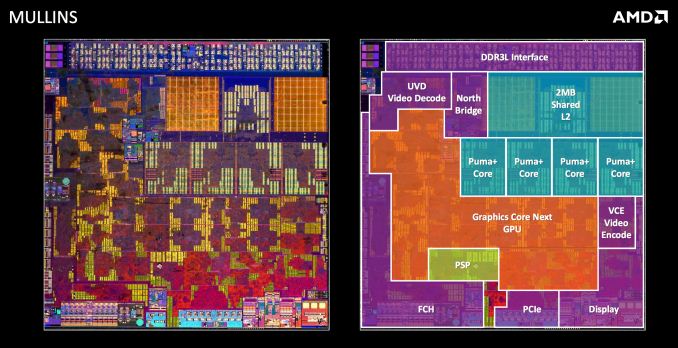

Eine APU von AMD allerdings war jedoch eigentlich immer halbwegs zum spielen brauchbar – zumindest was den Part der Grafik anging. Und ja, ich definiere und trenne da strikt; iGPU ist von Intel (intel GPU), APU von AMD. Gemein ist beiden, daß es eGPUs sind, also embedded GPUs.

Danke Dir mein Lieber!Holt schrieb:…

Das ist doch für den Eimer, die iGPU ist toll um Windows darauf darzustellen und ggf. noch das Abspielen von Videos zu beschleunigen, aber für halbwegs ernsthaftes Gaming wird man immer eine Graka verbauen und dann ist die iGPU allenfalls als Fallback relevant, sollte die Graka mal defekt sein.

Kommen wir also doch noch beizeiten auf einen gemeinsamen Nenner. Mein Reden – seit Jahren!

»Adventures of The Mighty Blue Electron facing Competition: The Road towards Iris-Graphics«

Smartcom5 schrieb:…

Keine einzige eGPU-Variante die Intel im Laufe der Geschichte ihrer iGPU hervorgebracht hat, konnte sich wirklich gegen die Modelle von nVidia aber insbesondere AMDs APUs behaupten oder, geschweige denn einen Stich landen. Bei den APUs seit jeher prozessor-seitig, ja. Aber Intel kann halt AMD (aus Intel's Sicht wahrscheinlich) bedauerlicherweise nicht auch Grafik-technisch dominieren. Sie haben allesamt (mehr oder minder) um Leistungsgrößen hinterher gehinkt.

[…]

Wer nicht erfindet, verschwindet

Das Problem von und mit Intel's iGPUs ist schlicht, daß Intel es salopp gesagt „ums Verrecken nicht“ begreifen will, daß sie ohnehin niemals mit ihrer Iris Graphics™ (Intel GMA, Intel HD, UHD – oder wie auch immer sie diese Woche heißen möge …) leistungsmäßig in Gefilde werden vorrücken können, die in der selben (Leistungs-) Klasse wie AMD oder nVidia liegen. Und das ist zugrunde liegend gar nicht ein zuvorderst technischer Makel, sondern vielmehr ein psychischer.

Intel kann und will nämlich bis heute schlicht nicht wahr haben, daß das, was ihren iGPUs bis heute fehlt – um zu nVidia respektive AMD leistungsmäßig aufschließen zu können – nicht Phantasie, Handwerkskunst, technische Finesse, kluge Erfindungsgabe oder gar (technisches) Können zählt, sondern bloß eines: Patente!

Sie können und wollen es bis zum heutigen Tage schlicht nicht wahrhaben, daß sie einfach keine ausgewachsene und potente eGPU oder gar dGPU bauen und/oder fertigen können, und das recht sicher auch für die Zukunft so bleiben wird. Und das weiß Intel – auch wenn sie es wahrscheinlich niemals wirklich werden akzeptieren können.

Wer nicht patentiert, verliert

Da liegt es gar nicht so sehr an Fertigungskompetenzen oder anderen technischen Machbarkeiten, sondern vielmehr ist es darin begründet, daß man (und in diesem Falle besonders Intel) heutzutage keine GPU wird bauen können, ohne gleich eine Vielzahl an Patenten von entweder nVidia, AMD, Qualcomm und PowerVR (und damit Imagination Technologies) oder aber wahlweise gleich allen vier im Bunde zusammen zu verletzen.

Und das ist es, was Intel nicht wahrhaben kann und auch nicht wahrhaben will – nicht für Geld und gute Worte.

Sie begreifen es einfach nicht, weil sie es nicht begreifen wollen – weil sie es bewußt gar nicht begreifen können, da sie dies niemals akzeptieren werden. Und das wurmt sie seit jeher. Insbesondere aber, daß es ausgerechnet dieser 'kleine' „Störenfried“ und ihr ärgster Erzfeind AMD ist, der den mit Abstand größten Fundus an Patenten bezüglich Grafik hält – und sie in Folge dessen 'ungerechtfertigterweise' von ihrem Vorhaben abhält.

Das ist es, was Intel seit Jahren ärgert und was sie nicht vertragen können weil sie‘s schlicht nicht vertragen wollen. Und exakt das ist der einzige Grund, weswegen man trotzdem seit mittlerweile über einem Jahrzehnt von Seiten Intel auf Gedeih und Verderb versucht, ihre iGPU immer weiter krampfhaft aufzubohren, ohne wirklich signifikante Leistungssteigerungen erhalten zu können.

Psychoanalyse: Reiseleitung für Ego-Trips

Es geht dabei Intel auch überhaupt nicht darum, ob die Intel'sche Grafik-Einheit zu irgend etwas Größerem denn wirklich Nutze wäre oder daß sie gar Irgendwer bräuchte – oder gar jemals auch nur irgend Jemand nach dem Für und Wider oder dem Nutzen des Ganzen gefragt hätte. Darum geht es absolut nicht! Es geht darum, daß man nach Intel's Auffassung den verhaßten Gegner AMD zu dem man seit jeher abschätzig hernieder guckt unter allen Umständen zu do·mi·nie·ren hat – koste es was es wolle.

Und da scheut Intel keine Kosten oder Aufwand, weder Zeiten noch Mühen.

Da wird lieber seit jeher die Sinnlos-Grafik auf Teufel komm raus aufgepumpt und die mangels veritablen Patenten notwendigerweise primitiven¹ Videologiken lieber ein ums andere Mal zum x-ten Male aneinandergereiht und Caches vergrößert, in der hehren Hoffnung, daß man eben doch noch irgendwie auf magische Weise plötzlich den ganz großen Durchbruch feiern kann – und zwar natürlich ohne Hilfe von und mit Patenten AMDs.

¹ primitiv i.S.v. simple, einfach oder [technisch] unkompliziert oder vielmehr grafischen Grundformen, grafisches Primitiv; vgl. → primitive Shader; nicht i.S.v. billig, niveaulos oder schlecht!

Das Ego rechtfertigt jeden Aufwand

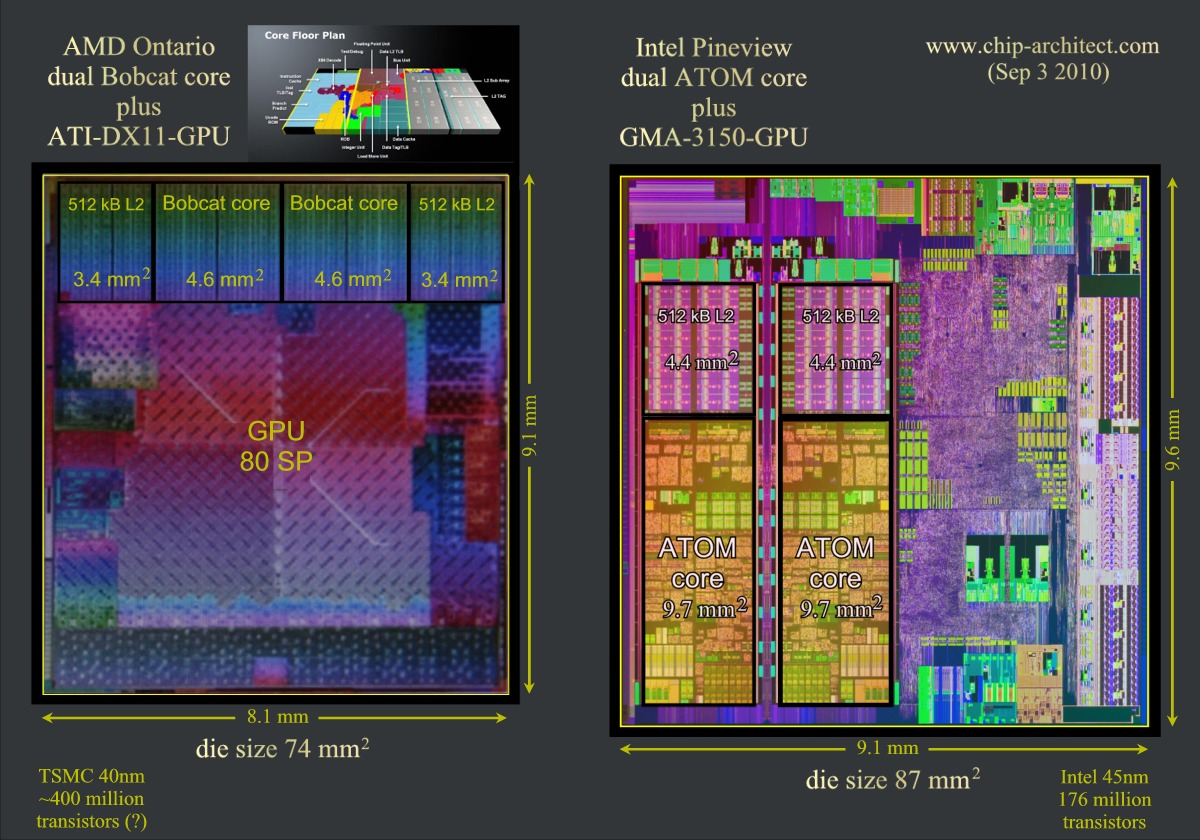

Da wird lieber fröhlich grinsend Jahr für Jahr großzügig Die-Fläche verschwendet bis sie wie jetzt etwa 70–75% der Größe des Dies eines Quad-Core für sich beansprucht, man versaut sich seit über einem Jahrzehnt wissentlich und vollends bewußt die Yields und treibt vollkommen unnötig die Stückkosten von Prozessoren in die Höhe – und all daß, ohne auch nur den geringsten nennenswerten Mehrwert, zumindest wenn man einmal von Ausnahmen absieht, die nur mit sündhaft teurem eDRAM halbwegs brauchbar sind oder zumindest daran grenzwertig vorbeischrammen.

All dies, obwohl für den Platz der nutzlosen Grafik-Logik ohne Weiteres ein kompletter zusätzlicher Quadcore-Cluster einen vollständigen Octa-Core (mitsamt Uncore inklusive Caches) ermöglichen würde …

Ironischerweise hätte man all die Jahre noch höhere Profite einstreichen können, wenn man denn die Grafik weggelassen hätte, welche ja so schon durch Die-Komplexität die Yield-Raten um Größenordnungen nach unten drückt und damit die Kosten durch Defekte/Yields um Faktor 3x–9x nach oben (gegenüber einen vergleichbaren CPU-Die ohne Grafik). Man hätte all die Zeit entweder deutlich kleinere und damit erheblich kostengünstigere Prozessor-Dies fertigen – oder aber für selbe Kosten gleich Octa-Cores fertigen können. Effektiv aber wäre die Ausbeute aufgrund geringerer Komplexität einer CPU gegenüber Graphic-Bibliotheken sogar noch deutlich gestiegen, selbst bei letztendlich gleicher Die-Größe.

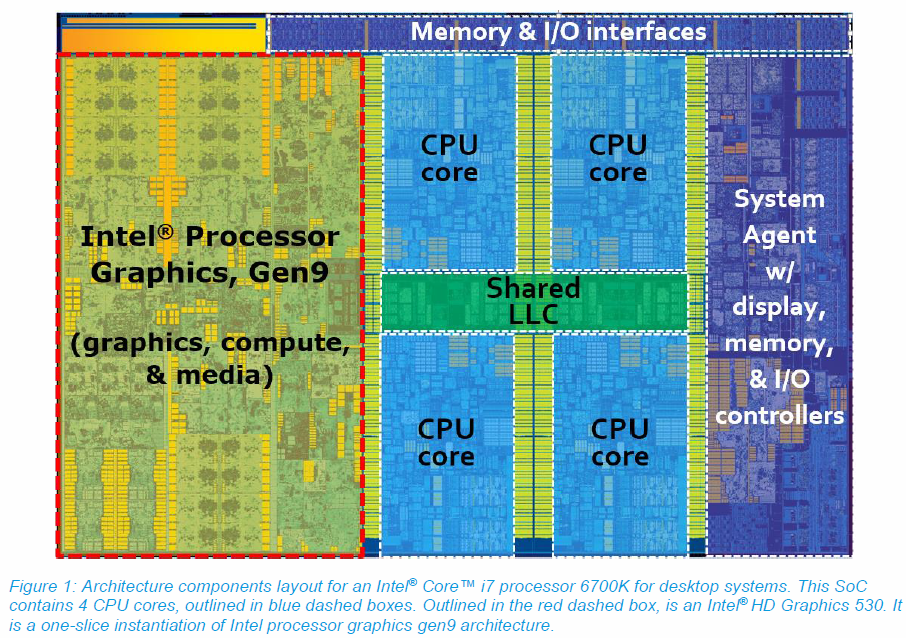

i7 6700K Blockdiagramm/Die-shot mit Intel-Graphics

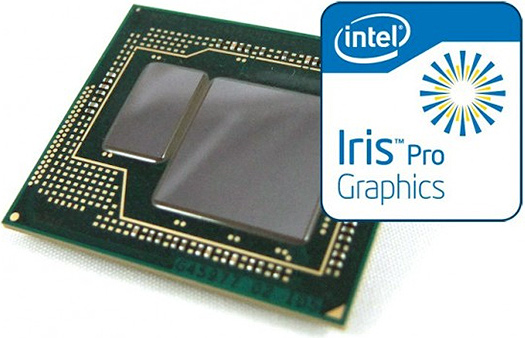

Intel Core Haswell, Broadwell eDRAM GT-Graphic

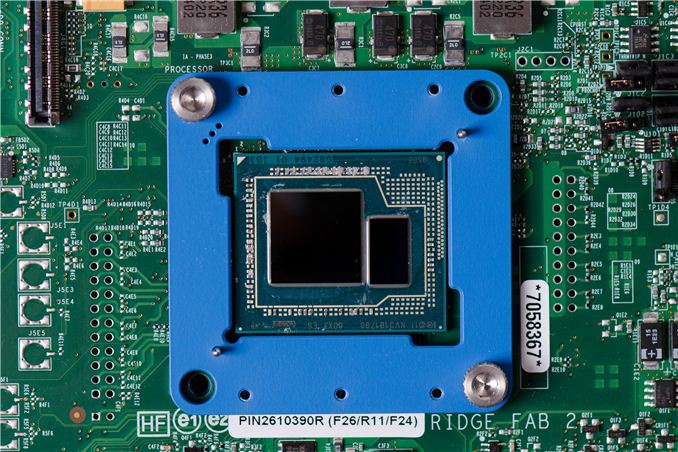

Symbolbild zur Veranschaulichung der Größenverhältnisse iGPU versus Prozessor-Kerne

Anfänge der iGPU …

Zum Vergleich AMD Die-Shots;

Intel Core Haswell, Broadwell eDRAM GT-Graphic

Symbolbild zur Veranschaulichung der Größenverhältnisse iGPU versus Prozessor-Kerne

Anfänge der iGPU …

Zum Vergleich AMD Die-Shots;

Am Beispiel Skylake sieht man, daß die Grafik-Einheit +70% (sic!) der immens kapitalen Die-Fläche beansprucht und damit nicht nur aufgrund der schier wahnwitzigen Verschwendung an Die-Fläche, sondern auch noch aufgrund der deutlich erhöhten Komplexität abermals (ggü. CPU-Die ohne Grafik) zu Buche schlägt und damit der Hauptkostentreiber der Intel'schen CPUs sind. Der Malus der iGPU auf die Fertigung ist damit gleich doppelt vorhanden. Die Haswell-Die zeigt ebenso, daß die GT2-GPU etwa 3,4× so groß ist, wie ein einziger Prozessor-Kern – bei Skylake wiedrum ist der Faktor GT2-Grafik- zu einzelner CPU-Kern-Die-Fläche gar schon 5,4×.

Der Punkt ist, daß mit jeder neuen Iteration der Intel-Graphics der GPU-Part immer wieder größer wird und folglich immer mehr Anteil der absoluten Die-Fläche vereinnahmt, damit mit jedem Stepping mehr und mehr an absoluten Kosten verursacht und währenddessen gleichzeitig die letztendliche Ausbeute an vollends funktionierenden CPU-Dies immer weiter verringert. Und das in einem Markt, wo man ohnehin nicht das Geringste gegen die Leistungsgrößen von nVidia oder AMD's APUs ausrichten kann – sie laufen quasi seit jeher immer außerhalb jeder Konkurrenz im Sinne von „unter ferner liefen“.

Ironisch wird das ganze umso mehr als daß AMD allumfassend es daher nicht nur immer wieder schaffte eine um Faktoren höhere relative Leistungsdichte in Grafik-Performance in ihre APUs wandern zu lassen, sondern sogar absolut betrachtet kleinere Grafikkerne mit trotzdem einem Vielfachen der Performance zu verwirklichen als es Intel jemals schaffte.

Während Intel also mit einem Vielfachen der Die-Fläche AMD'scher Graphic-Cores im wahrsten Sinne des Wortes kapital am rumaasen war, bot AMD immer wieder trotz nur einem Bruchteil der Die-Fläche eine absolut gesehen deutlich über Intel liegende Grafik-Performance – all das bei AMD bitteschön auf größeren und damit schlechteren Strukturgrößen …

Von großen Wahn und kleinen Geistern

Das gesamte Kapitel ihrer iGPUs – oder wie ich es gerne nenne: »Adventures of The Mighty Blue Electron facing Competition: The Road towards Iris-Graphics« – ist gepflastert mit Fehlentscheidungen, -urteilen wie -einschätzungen und Dickköpfigkeit sowie egomanisch geprägter Starsinnigkeit, das ganze garniert mit einer gehörigen Portion Selbstüberschätzung, -erhöhung und kapitalster Borniertheit.

Allein vom (betriebs-) wirtschaftlichen Standpunkt aus betrachtet, hätte man die iGPU bereits unmittelbar schon zu jenen Zeiten beerdigen

Hartes Geld & weiche Scheine

Ihre liebevoll genannten »Graphics Media Decelerators« sind bis heute nur ein weiteres ihrer einzig aus Prestigegründen hoch- und am Leben gehaltenen Milliardengräber. Retrospektiv betrachtet ist und war Intel's iGPU sets nur weitestgehend sinnlose und ohne jedweden größeren Nutzen kapitale Verschwendung gewesen.

Nicht nur im Hinblick auf Forschung & Entwicklung, sondern auch in absoluten harten Zahlen an Hartgeld in Milliardenhöhe der Investorengelder ihrer Anteilseigner, insbesondere aber mit Blick auf die Die-Fläche der CPUs allein. Die weitestgehende künstliche Beschränkung auf High-End CPU-Klassen dürfte der Verbreitung auch nicht gerade zuträglich gewesen sein – allein diese ökonomisch betrachtet vollkommen grenzdebile Marktsegmentierung ist an Engstirnigkeit und Idiotie kaum zu überbieten.

Auch wenn all diese von purer Arroganz geprägten Ausflüge Intel in der Regel teuer zu stehen gekommen sein mögen, die Zeche gezahlt haben dafür gezwungenermaßen ausschließlich die Endanwender, welche die widersinnige iGPU selbst bei aus teildeaktivierten Quadcore-Modellen entsprungenen Dualcore-Varianten stets mit eigentlich unnotwendigerweise überhöhten Endanwenderpreisen gezahlt haben. Selbst ein Heimanwender, der für eine Budget-Konfiguration einen Pentium oder Core i3 kaufte, bezahlte die iGPU stets anteilig mit.

Fortsetzung folgt …

In diesem Sinne

Smartcom

Zuletzt bearbeitet:

Wenn, dann eher Skylake Reloaded, zwischen Broadwell und Skylake hatte sich ja schon etwas bei der Architektur getan, aber die Cannon Lake haben immerhin AVX512, also anderes als Kaby Lake und Coffee Lake nicht nur eine geänderte Fertigung.WinnieW2 schrieb:Cannon Lake sehe ich nicht als relevante CPU-Architektur, das ist eher Broadwell reloaded

Ja, aber wie die Architektur aussehen wird, weiß man nicht, die wirklich neue Architektur dürfte erst mit Tiger Lake kommen. Aber kann es sein das Du Architektur und Fertigungsprozess durcheinander wirfst? Kaby Lake war Skylake in 14nm+ Fertigung und Coffee Lake ist Skylake in 14nm++.WinnieW2 schrieb:Bedeutende Stückzahlen in 10 nm wird Intel erst mit den Ice-Lake-CPU liefern...

Wenn Intel schon 28 Kerne in 14nm bei einem Die herstellen kann? Dann braucht man für 12 Kernesicher kein MCM.WinnieW2 schrieb:durch die Fertigung in 10 nm wären theoretisch auch 12 Kerner realisierbar, natürlich nur im Multi-Chip-Design

Nein, die sind nun auch in 14nm++ gefertigt.Aldaric87 schrieb:die Core X sind einfach die alten Chips

Ähnliche Themen

- Antworten

- 46

- Aufrufe

- 5.727

Bei den mit Info-Icon markierten Links handelt es sich um Affiliate-Links. Im Fall einer Bestellung über einen solchen Link wird ComputerBase am Verkaufserlös beteiligt, ohne dass der Preis für den Kunden steigt.