Ich weiß nicht ob Du Dich auf meinen Post beziehst. Ich war vielleicht nicht klar genug.latiose88 schrieb:wenn die das schon verlassen haben,ist das ja kein gutes zeichen.Die haben das sinkende Schiff verlassen,bevor es ganz absaufen tut.

Wenn also Intel den schweren Anker (Altera) nicht los wird,zieht es den ganzen laden mit in den den Abgrund.

Altera ist kein schwerer Anker. Altera zieht Intel nicht in den Abgrund. Aber ein Verkauf wäre die letzte Möglichkeit Altera zu retten und würde Intel Cash bringen. Cash, den Intel für die eigentliche Baustelle braucht.

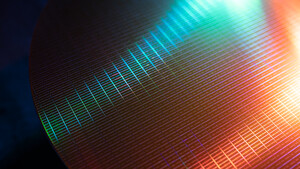

Die eigentliche Bausstelle ist die Halbleiterfertigung, die vom Erfolgsgaranten zum Problemkind mutierte. Intel hat ein zu kleines Wafervolumen um damit eine State of the Art Halbleiterfertigung aufrecht erhalten zu können. Hier haben sich die immer weiter steigenden Kosten für Prozessentwicklung und Aussrüstung und die einbrechenden Margen

Das Problem für Intel ist, dass Intel diese Chipfertigung nicht verkaufen kann. Dieser Weg ist spätestens seit dem Ausstieg von AMD verbaut.

Pat Gelsinger hat einen sehr riskanten Weg beschritten das Problem zu lösen. Er wollte erst Mal 100 Milliarden USD*) in das Geschäft hineinpumpen, so dass es konkurrenzfähig wird. Der alte CFO wollte den Weg nicht mitgehen und ging in den Ruhestand.

Konkurrenzfähig was den Prozess in Punkto PPA anbelangt, ist dabei die leichteste Übung. Schwieriger wird es in Punkto Kosten und noch viel schwieriger in Punkto PDK und IP.

Intel hat das fatale Problem, dass die IFS praktisch keine Kunden für 14 nm Intel 7 und Intel 3 gewinnen konnte. Erst bei 18A scheint es größeres Interesse an Testchips zu geben.

*) keine exakte Zahl, aber Größenordnung

14 nm war AFAIK ein halbes Jahr verspätet.stefan92x schrieb:Schon 14nm hatte Probleme.

Und sobald 14 nm verfügbar war, hatte Intel einen Vorsprung von 1 1/2 Generation auf TSMC und Samsung.

Was beide mit den Namen ihrer Prozesse vertuschen wollten. Samsungs 14 nm und TSMCs 16 nm waren FinFET mit mit 20 nm. Also die Konkurrenten zu Intel 22 nm Prozess.

Das kann man nie trennen. Der Prozesses legt mit seinen Libs die Grenzen des möglichen fest.stefan92x schrieb:Und die Kernentwicklung kann man bei Intel nicht davon trennen,

Insofern ist die Entwicklung der CPU-Kerne bei Intel mit den 10 nm Fiasko zusätzlich belastet worden.

Man kann Architektur und Prozess komplett nicht voneinander trennen. Je moderner der Prozess, desto höher das Transistorbudget, dass für die Architektur verfügbar ist.stefan92x schrieb:da sie eben ganz bewusst Architekturen an Prozesse gebunden haben,

Klar war dies ab 2017/2018 für Intel ein Problem. Aber bis 2015 war ein entscheidender Vorteil für Intel. Und zwar doppelt.stefan92x schrieb:was ja auch Teil des Problems war.

- Intel war bis 14 nm immer früher als die Konkurrenz und Foundries dran.

- Intel hatte immer Prozesse. die auf die Anforderungen der CPUs zugeschnitten waren. Davon haben die Intel CPUs massiv profitiert.

Da meine ich nicht nur AMD, sondern auch oder vor allem IBM, Motorola, Sun, RISC, MIPS und HP.

Zen musste mit dem Rückstand von einer Prozessgeneration gegen Kaby Lake antreten.

Erst mit Zen 2 ist AMD durch 7 nm an Intel vorbei gezogen.

Ergänzung ()

Es wurde gegen den Vorstand und Board von Intel eine Klage eingereicht:

https://storage.courtlistener.com/recap/gov.uscourts.cand.441318/gov.uscourts.cand.441318.1.0.pdf

Noch etwas was Intel nicht gebrauchen kann.

Zuletzt bearbeitet: