Einleitung / Vorgeschichte

Weihnachten 2003 - der kleine chiller (grade 13 Jahre alt geworden) hat endlich seinen ersten neuen Gaming-PC geschenkt bekommen! Vorbei sind die Zeiten in denen die gebrauchten PCs der Eltern genutzt werden mussten, nun steht endlich ein neues Gerät unter dem Schreibtisch

Die Daten des PCs waren auf dem ersten Blick ansehnlich: Athlon XP 2800+, 512MB RAM, 80GB HDD, verpackt in einem schicken blau-weißen Gehäuse. Nach kurzer Nutzungsdauer fiel allerdings ein Bauteil eher negativ auf und nach genauem Hinsehen entpuppte sich dieses Bauteil als Geforce FX5200 ...mit 64Bit Speicherinterface

Mit dieser Gurke von Grafikkarte musste ich das gesamte Spiele-Jahr 2004 durchhalten - also dem Jahr in dem unter anderem Far Cry, Half Life 2 und Doom 3 launchten. Erst zum darauf folgenden Weihnachten wurde ich endlich mit einer Geforce 6800 erlöst.

Im Nachhinein betrachtet ist es ein Wunder, dass ich trotz dieser Karte seit 8 Jahren beruflich in der Hardware-Branche arbeite und mir kein anderes Hobby gesucht habe ^^ Mit diesem Artikel arbeite ich somit mein Hardware-Kindheits-Trauma auf, also schnallt euch an und begebt euch mit mir auf die wilde Reise durch den tiefen FX5200-Sumpf!

Die Daten des PCs waren auf dem ersten Blick ansehnlich: Athlon XP 2800+, 512MB RAM, 80GB HDD, verpackt in einem schicken blau-weißen Gehäuse. Nach kurzer Nutzungsdauer fiel allerdings ein Bauteil eher negativ auf und nach genauem Hinsehen entpuppte sich dieses Bauteil als Geforce FX5200 ...mit 64Bit Speicherinterface

Mit dieser Gurke von Grafikkarte musste ich das gesamte Spiele-Jahr 2004 durchhalten - also dem Jahr in dem unter anderem Far Cry, Half Life 2 und Doom 3 launchten. Erst zum darauf folgenden Weihnachten wurde ich endlich mit einer Geforce 6800 erlöst.

Im Nachhinein betrachtet ist es ein Wunder, dass ich trotz dieser Karte seit 8 Jahren beruflich in der Hardware-Branche arbeite und mir kein anderes Hobby gesucht habe ^^ Mit diesem Artikel arbeite ich somit mein Hardware-Kindheits-Trauma auf, also schnallt euch an und begebt euch mit mir auf die wilde Reise durch den tiefen FX5200-Sumpf!

Inhaltsverzeichnis:

- Die Testkandidaten

- Pleiten, Pech und Pannen

- Testsystem

- Testergebnisse

- Fazit

Die Testkandidaten

Wenn man nicht so genau hinschaut, fällt einem eine beliebige Geforce FX5200 schon für unter 10€ in die Hände. Bis 20€ bekommt man dann eigentlich schon fast sämtliche Varianten mit diversen Kühlern, Taktraten, Speichergrößen und Speicheranbindungen angeboten. Einzig die PCI-Variante ist seltener und teurer - von der FX 5200 Ultra ganz zu schweigen.

Zuerst einmal die obligatorische Übersicht an Daten und Fakten:

| AGP | DirectX | Chip | Fertigungsprozess | ROP/TMU | Pixel-/Vertexshader | Chiptakt | Speichertakt | Interface | |

| Geforce FX5200 | 8x | 9.0 | NV34 | 150nm | 4 / 4 | 4 / 2 | 250 MHz | 200 MHz | 128 Bit |

Und das habe ich so alles bei ebay und einem Sammler gefunden:

| Modell | Marke | Chiptakt | Speicher | Speichertakt | Interface | Bandbreite |

| FX5200 PCI | Zotac | 250 MHz | 128MB DDR | 166 MHz | 64 Bit | 2,7GB/s |

| FX5200 | MSI (OEM) | 250 MHz | 64MB DDR | 203 MHz | 64 Bit | 3,2GB/s |

| FX5200 | Albatron | 255 MHz | 128MB DDR | 166 MHz | 64 Bit | 2,7GB/s |

| FX5200 | MSI (OEM) | 250 MHz | 128MB DDR | 200 MHz | 64 Bit | 3,2GB/s |

| FX5200 | MSI (OEM) | 250 MHz | 64MB DDR | 200 MHz | 128 Bit | 6,5GB/s |

| FX5200 | XFX | 250 MHz | 128MB DDR | 166 MHz | 128 Bit | 5,3GB/s |

| FX5200 | MSI (OEM) | 250 MHz | 128MB DDR | 200 MHz | 128 Bit | 6,5GB/s |

| FX5500 | Manli | 270 MHz | 256MB DDR | 200 MHz | 128 Bit | 6,5GB/s |

Wie Overclocking, nur anders rum! - So könnte man die Auswahl zusammen fassen, die ich gefunden und getestet habe. Denn die meisten FX5200 hatten nämlich nur ein 64 Bit breites Speicherinterface. Viel schlimmer noch: Fast alle Karten von Marken wie Gainward, MSI, Albatron, XFX und co. drehten an den Speicher-Taktraten - allerdings in die falsche Richtung! So werden oft Modelle mit 166, 150, 140, 133 und sogar 125 MHz Speichertakt angeboten, sodass es fast unmöglich ist überhaupt eine Karte mit Referenz-Taktraten zu finden.

Einzig die OEM-Karten von MSI hielten sich an die Regeln, sowie die FX5500 von Manli - letztere ist im Prinzip nur ein Refresh der FX5200 mit erhöhten Taktraten und kam etwa ein Jahr nach dem Release der FX5200 auf den Markt. Die FX5500 ist insgesamt deutlich weniger verbreitet als die FX5200, auch wenn es keine Kunst sein dürfte eine günstige FX5500 zu erwischen.

Mit der Albatron FX5200 ist übrigens auch exakt die gleiche Karte im Roundup dabei, die vor knapp 20 Jahren in meinem PC werkelte. Mal schauen wie schlecht dieses Modell gegenüber dem Rest abschneidet, denn natürlich wurde auch hier an der Speicher-Taktrate gedreht.

Einzig die OEM-Karten von MSI hielten sich an die Regeln, sowie die FX5500 von Manli - letztere ist im Prinzip nur ein Refresh der FX5200 mit erhöhten Taktraten und kam etwa ein Jahr nach dem Release der FX5200 auf den Markt. Die FX5500 ist insgesamt deutlich weniger verbreitet als die FX5200, auch wenn es keine Kunst sein dürfte eine günstige FX5500 zu erwischen.

Mit der Albatron FX5200 ist übrigens auch exakt die gleiche Karte im Roundup dabei, die vor knapp 20 Jahren in meinem PC werkelte. Mal schauen wie schlecht dieses Modell gegenüber dem Rest abschneidet, denn natürlich wurde auch hier an der Speicher-Taktrate gedreht.

Pleiten, Pech und Pannen

Das ist mein erster Artikel seit Ende 2015, daher ging natürlich nicht alles glatt. Aber schaut selbst:

Eine FX5200 Ultra, die keine ist

Auf den Bildern weiter oben ist eine ASUS-Karte mit grünem PCB und goldenem Kühler zu sehen, welche als "FX 5200 Ultra" verkauft wurde. In Realität stellte sich dann Ernüchterung ein, denn es handelte sich nur um eine reguläre FX5200  Immerhin, der Verkäufer hat sich kulant gezeigt und die Karte wieder zurück genommen.

Immerhin, der Verkäufer hat sich kulant gezeigt und die Karte wieder zurück genommen.

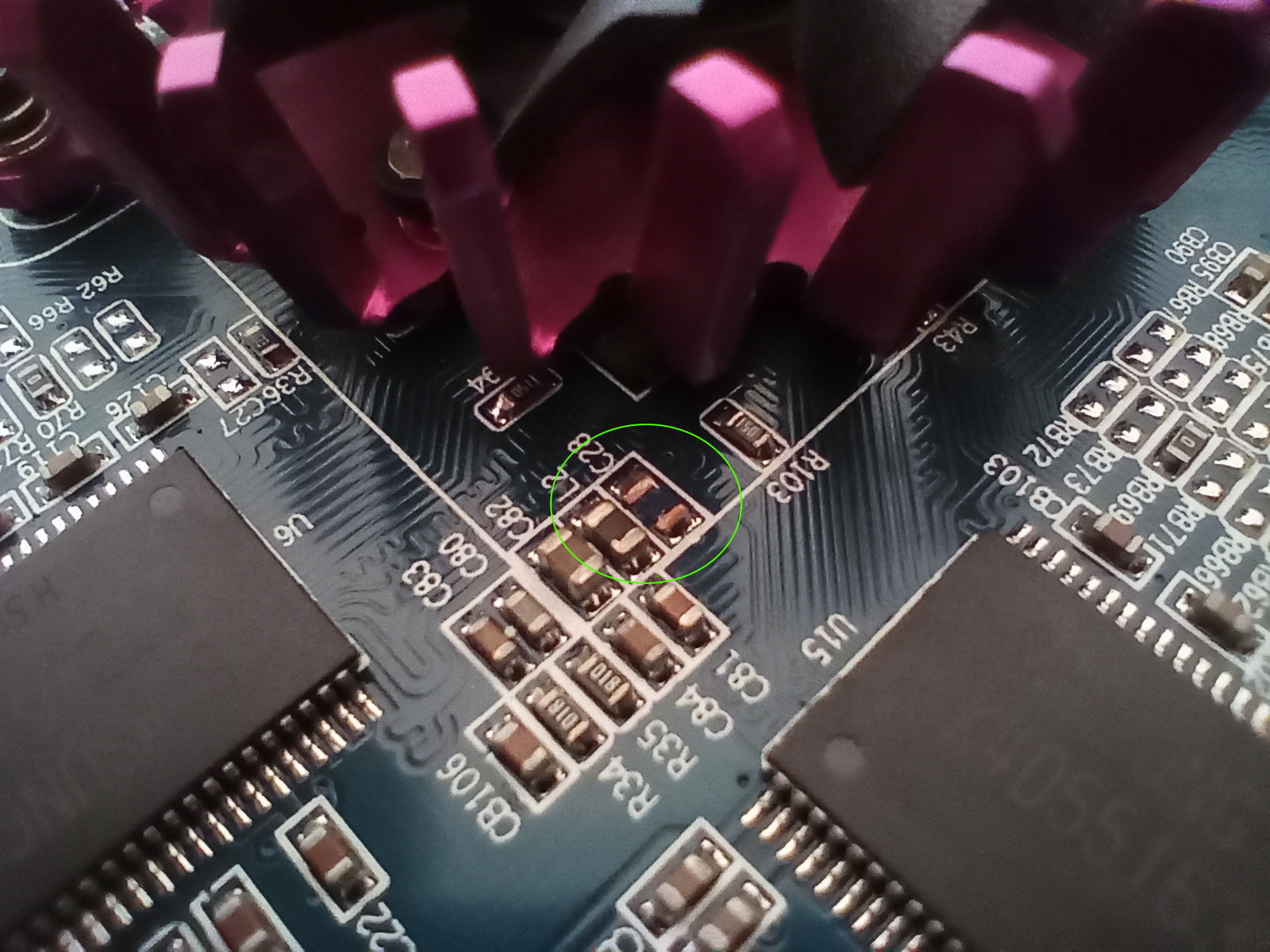

Eine zerbröselte FX5500

Tja, ärgerlich: Die FX5500 wollte erst nicht in den AGP-Slot rein - nach kurzer Durchsicht fand ich den Übeltäter, denn einer der Widerstände auf dem PCB hatte sich gelöst und den Slot blockiert. Erstaunlicher Weise funktioniert die Karte noch, allerdings fällt die Performance ein paar Prozent schlechter aus als sie eigentlich sein müsste - ich vermute mal das Speicherinterface hat etwas ab bekommen. Die FX5500 wird daher nicht im Test auftauchen, da ich die Ergebnisse nicht verfälschen möchte.

Bugs!

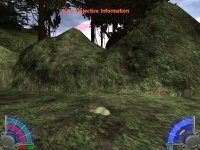

Ich hab noch ein paar andere Karten zum Vergleich in die Tests reingenommen, allerdings kam es hier und da zu Abstürzen und Grafikfehlern. Gothic 1 hatte keine Lust mit älteren DX7-Karten zu starten, und Radeons mochte das Spiel ebenfalls nicht. Jedi Knight 3 produziert auf DX7-Karten Grafikfehler, allerdings nur unter 1024x768x16 - mit 1280x1024 sieht das Spiel einwandfrei aus (klicken zum Vergrößern der Screenshots):

Eine zerbröselte FX5500

Tja, ärgerlich: Die FX5500 wollte erst nicht in den AGP-Slot rein - nach kurzer Durchsicht fand ich den Übeltäter, denn einer der Widerstände auf dem PCB hatte sich gelöst und den Slot blockiert. Erstaunlicher Weise funktioniert die Karte noch, allerdings fällt die Performance ein paar Prozent schlechter aus als sie eigentlich sein müsste - ich vermute mal das Speicherinterface hat etwas ab bekommen. Die FX5500 wird daher nicht im Test auftauchen, da ich die Ergebnisse nicht verfälschen möchte.

Bugs!

Ich hab noch ein paar andere Karten zum Vergleich in die Tests reingenommen, allerdings kam es hier und da zu Abstürzen und Grafikfehlern. Gothic 1 hatte keine Lust mit älteren DX7-Karten zu starten, und Radeons mochte das Spiel ebenfalls nicht. Jedi Knight 3 produziert auf DX7-Karten Grafikfehler, allerdings nur unter 1024x768x16 - mit 1280x1024 sieht das Spiel einwandfrei aus (klicken zum Vergrößern der Screenshots):

Testsystem

Getestet wurde mit folgenden Komponenten:

| CPU | Intel C2D E6600 @ 2,6GHz (FSB auf 290 MHz erhöht) |

| RAM | 2x 1GB DDR-434 CL2-3-2-5 (G.Skill) |

| Mainboard | ASRock 775Dual-VSTA |

| SD-Karte | 128GB Samsung (per IDE-Adapter) |

| PSU | Corsair TX750M |

| Monitor | 24" ASUS Full HD |

Als Betriebssystem kam Windows XP Service Pack 3 in der x86-Version zum Einsatz.

Weitere Grafikkarten, die zum Vergleich heran gezogen wurden:

- Radeon 9200SE (128MB DDR, 64Bit, 200/166 MHz)

- Radeon 9250 (128MB DDR, 64Bit, 240/200 MHz)

- Geforce 4 MX-440 (64MB DDR, 128Bit, 275/200 MHz)

- Geforce 6200 (256MB DDR2, 64Bit, 350/266 MHz)

Ich habe zwei ATI-Karten aus der gleichen Klasse und dem gleichen Zeitraum heran gezogen, um zu schauen wie sich die FX5200 hier einordnet. Mit der MX-440 und der 6200 habe ich den jeweiligen Vorgänger und Nachfolger gewählt, um eine gute Einordnung zu ermöglichen.

Treiberversionen:

Geforce 6200: 307.83

Geforce 4 und FX: 93.71

Radeons: Catalyst 6.11

Testergebnisse

Zuerst habe ich mit ein paar Benchmarks gestartet:Treiberversionen:

Geforce 6200: 307.83

Geforce 4 und FX: 93.71

Radeons: Catalyst 6.11

Testergebnisse

Ich fand es erstaunlich, wie gut die alte Geforce 4 MX-440 mithalten konnte und die FX5200-Garde oft auf die hinteren Plätze schicken konnte. Einzig im 3DMark 03 liegen die Radeons und die Geforce 4 hinten, da diese keine DirectX 9-Tests darstellen können.

Dramatisch finde ich, dass 128MB Speicher bei der FX5200 überhaupt nichts bringen, denn die 64MB-Karten sind im Prinzip genau so schnell. Allerdings wurden meines Wissens nach keine 64MB-Versionen der Karte, abgesehen von den OEM-Varianten angeboten. Ich möchte mir besser nicht vorstellen, wie viel ungenutzten Speicher es auf FX5200-Karten insgesamt auf der Welt gegeben hat Daher ist der Ausfall der FX5500 mit 256MB auch zu verschmerzen, denn das hätte sowieso keinen Unterschied gemacht.

Daher ist der Ausfall der FX5500 mit 256MB auch zu verschmerzen, denn das hätte sowieso keinen Unterschied gemacht.

Nach den Benchmarks kamen auch echte Spiele zum Einsatz. Ich habe mich auf Spiele beschränkt, welche in etwa zu der Zeit rausgekommen sind, außerdem habe ich auf eine bunte Auswahl von OpenGL- und DirectX-Spielen geachtet. Es handelt sich durchgehend um GOG-Versionen der Spiele.

(Anklicken zum Vergrößern)

Dramatisch finde ich, dass 128MB Speicher bei der FX5200 überhaupt nichts bringen, denn die 64MB-Karten sind im Prinzip genau so schnell. Allerdings wurden meines Wissens nach keine 64MB-Versionen der Karte, abgesehen von den OEM-Varianten angeboten. Ich möchte mir besser nicht vorstellen, wie viel ungenutzten Speicher es auf FX5200-Karten insgesamt auf der Welt gegeben hat

Nach den Benchmarks kamen auch echte Spiele zum Einsatz. Ich habe mich auf Spiele beschränkt, welche in etwa zu der Zeit rausgekommen sind, außerdem habe ich auf eine bunte Auswahl von OpenGL- und DirectX-Spielen geachtet. Es handelt sich durchgehend um GOG-Versionen der Spiele.

(Anklicken zum Vergrößern)

Elite Force: Hier laufen viele Karten in das 90fps-Limit des Spiels. Insgesamt gibt es in der Reihenfolge viel Durcheinander, zum Beispiel kommt die Geforce 6200 nicht zur Geltung.

Gothic 1: Wie oben bereits geschrieben, wollte das Spiel nicht mit einigen Karten zusammen arbeiten. Ansonsten ist es erstaunlich, wie stark die FX5200-Riege von der 6200er deklassiert wird - so deutlich wie hier wird das in keinem anderen Spiel. Im Gegenzug dazu sind aus irgend einem Grund die 64MB-Versionen der FX5200 reproduzierbar etwas schneller unterwegs, als die Pendants mit 128MB.

Gothic 2: Hier ist die Auswahl an möglichen Auflösungen im Spiel eher schlecht. Außerdem unterstützen die Radeon-Karten einige der Auflösungen nicht. Erstaunlich finde ich wieder einmal das Abschneiden der Geforce 4 MX-440, welche aber wahrscheinlich von einem verringertem Feature-Set aufgrund ihrer DX7-Kompatibilität profitiert.

Unreal 2: Nichts spannendes zu vermelden, abgesehen von kleineren Messungenauheiten - durch eine Ruckelorgie zu navigieren ist halt nicht einfach

Jedi Knight 3: Warum die Geforce 6200 hier nicht so recht zündet, kann ich mir nicht erklären. Es handelt sich allerdings um die gleiche Grafik-Engine wie bei Elite Force, sofern mir das bekannt ist. Auch dort hat die Karte nicht gut performt. Auffällig ist zudem das besonders schlechte Abschneiden der PCI-Grafikkarte, die hier besonders lahm unterwegs ist.

Spellforce: Zum Abschluss hab ich nochmal einen richtigen Kracher organisiert, denn das Spiel war auf damaligen PCs kaum ruckelfrei spielbar und blieb mir mit seinen heftigen Hardware-Anforderungen in Erinnerung. Kein Wunder also, dass wir hier viele einstellige FPS-Zahlen sehen.

Fazit:

Nun was soll ich sagen, aus persönlicher Sicht hatte ich damals nicht nur eine der Grafikkarten mit dem schlechtesten Grafikchip den man damals für Geld kaufen konnte, sondern auch innerhalb des FX5200-Kosmos eine der langsamsten Varianten im PC stecken

Auch sonst waren die Leistungsunterschiede innerhalb des FX5200-Angebots gigantisch, zum Teil habe ich Performance-Unterschiede von 50% und mehr gemessen. Selbst die alte Geforce 4 MX-440 kann einen Großteil der getesteten Karten in den meisten Benchmarks und Spielen hinter sich lassen - das reduzierte DX7-Featureset mal außen vor gelassen. Auch im ATI-Lager sah es damals nicht besser aus, die getesteten Radeon-Karten mischen sich meistens unauffällig unter die FX5200-Karten.

Der FX5200 sind damals ein paar Eigenschaften zum Verhängnis geworden:

Gothic 1: Wie oben bereits geschrieben, wollte das Spiel nicht mit einigen Karten zusammen arbeiten. Ansonsten ist es erstaunlich, wie stark die FX5200-Riege von der 6200er deklassiert wird - so deutlich wie hier wird das in keinem anderen Spiel. Im Gegenzug dazu sind aus irgend einem Grund die 64MB-Versionen der FX5200 reproduzierbar etwas schneller unterwegs, als die Pendants mit 128MB.

Gothic 2: Hier ist die Auswahl an möglichen Auflösungen im Spiel eher schlecht. Außerdem unterstützen die Radeon-Karten einige der Auflösungen nicht. Erstaunlich finde ich wieder einmal das Abschneiden der Geforce 4 MX-440, welche aber wahrscheinlich von einem verringertem Feature-Set aufgrund ihrer DX7-Kompatibilität profitiert.

Unreal 2: Nichts spannendes zu vermelden, abgesehen von kleineren Messungenauheiten - durch eine Ruckelorgie zu navigieren ist halt nicht einfach

Jedi Knight 3: Warum die Geforce 6200 hier nicht so recht zündet, kann ich mir nicht erklären. Es handelt sich allerdings um die gleiche Grafik-Engine wie bei Elite Force, sofern mir das bekannt ist. Auch dort hat die Karte nicht gut performt. Auffällig ist zudem das besonders schlechte Abschneiden der PCI-Grafikkarte, die hier besonders lahm unterwegs ist.

Spellforce: Zum Abschluss hab ich nochmal einen richtigen Kracher organisiert, denn das Spiel war auf damaligen PCs kaum ruckelfrei spielbar und blieb mir mit seinen heftigen Hardware-Anforderungen in Erinnerung. Kein Wunder also, dass wir hier viele einstellige FPS-Zahlen sehen.

Fazit:

Nun was soll ich sagen, aus persönlicher Sicht hatte ich damals nicht nur eine der Grafikkarten mit dem schlechtesten Grafikchip den man damals für Geld kaufen konnte, sondern auch innerhalb des FX5200-Kosmos eine der langsamsten Varianten im PC stecken

Auch sonst waren die Leistungsunterschiede innerhalb des FX5200-Angebots gigantisch, zum Teil habe ich Performance-Unterschiede von 50% und mehr gemessen. Selbst die alte Geforce 4 MX-440 kann einen Großteil der getesteten Karten in den meisten Benchmarks und Spielen hinter sich lassen - das reduzierte DX7-Featureset mal außen vor gelassen. Auch im ATI-Lager sah es damals nicht besser aus, die getesteten Radeon-Karten mischen sich meistens unauffällig unter die FX5200-Karten.

Der FX5200 sind damals ein paar Eigenschaften zum Verhängnis geworden:

- Die unglückliche FX-Architektur, die sich durch das gesamte Lineup bis zur 5800er gezogen hat und von ATI Radeon 9500/9700 deklassiert wurde

- Die volle DX9-Unterstützung, bei der NVIDIA wohl nicht den gleichen Fehler wie beim Vorgänger machen wollte und für die Einsteiger-Karten Geforce 4 MX damals Kritik einstecken musste

- Die Boardpartner, die ohne große Kennzeichnung an Speicherbandbreite und Taktraten rumgeschnippelt haben und die bereits mäßige Performance komplett erwürgt haben

- Das offensive Marketing, denn die Karten wurden insbesondere in Komplett-PCs mit DirectX 9-Support und 128MB Speicher beworben. Klang toll, war es aber nicht

- Damit ichs mal erwähnt habe: Auch das OC-Potential der FX5200 war nicht toll. Der Chiptakt lässt sich meist nur auf knapp über 300 MHz erhöhen und auch dem Speicher geht schnell die Puste aus, da meistens der billigste Schrott verbaut wurde, der irgendwo vom Band gefallen ist.

Zum Abschluss:

Ich hoffe euch hat mein erster Artikel gefallen - gebt mir bitte gerne Kritik und Verbesserungsvorschläge