- Registriert

- Sep. 2018

- Beiträge

- 29

Nunja wie immer sind die letzten Prozente an Sicherheit sehr "teuer" und auch wenn 99% schön wären wird meine Lösung sicher Schwachstellen in Bezug auf "KISS" haben. Denn je mehr Skripte für die Magie sorgen, desto mehr Fehler Potential in der Backup Strategie. Ich bin wirklich überrascht wie komplex das Thema 2023 noch ist. Und wie Leute sehr komplizierte scripte und Architekturen wählen für ihre wichtigsten Daten.

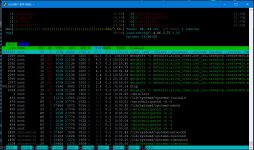

@Bohnenhans ich werde mal ein paar Tests mit zfs machen. Merkt man in der auslastung der CPU hier merklich was? Ist ja immerhin 128 bit was die 64bit CPU da verarbeiten muss.

@Bohnenhans ich werde mal ein paar Tests mit zfs machen. Merkt man in der auslastung der CPU hier merklich was? Ist ja immerhin 128 bit was die 64bit CPU da verarbeiten muss.