Aeromax

Commander

- Registriert

- Feb. 2011

- Beiträge

- 2.347

Eyefinity und Vision Surround 2021

Es ist eine Weile her, dass ich etwas Sinnvolles im Forum beigetragen habe, doch durch einige aktuelle persönliche Upgrades und damit einhergehende Probleme und Ärgernisse hat sich da etwas ergeben. Daher möchte ich euch heute Eyefinity und Vision Surround mit aktuellen RDNA2 und Amperekarten vorstellen.

Eyefinity: Erklärung, Konfiguration, verwendete Hardware und Probleme

Der Anfang

Im September 2009 stellte damals noch ATI eine neue Grafikkarte vor, die Radeon HD 5870. Diese Karte war in vielerlei Hinsicht neu. Die RV870 „Cypress“ war die erste Grafikkarte für Endkunden, die DX11 fähig war, in 40nm produziert wurde und vieles mehr. Der für uns heute interessante Teil ist vieles mehr, vor allem Eyefinity. Seitdem gibt es bei Ati bzw. heute AMD dieses Feature.

Doch was ist Eyefinity eigentlich? Eyefinity ist ein Multimonitormanagement, das es uns ermöglicht, mehrere physisch einzelne Monitore zu einem Endgerät zusammenzufügen, das als großes, einzelnes Display erkannt und benutzt werden kann. Zu Beginn war die maximal mögliche Auflösung durch die DVI-Spezifikationen beschränkt und nur die Highendkarten konnten theoretisch eine Auflösung von 6 x 2560x1600@60Hz anzeigen. Bei der damaligen Rechenleistung war das allerdings nur ein Gedankenexperiment, das maximal im 2D-Betrieb umsetzbar war und das einige Voraussetzungen hatte. Bis zur HD 7xxx bzw. einigen Modellen der R9 Serie waren lediglich zwei Taktgeber in den Grafikkarten verbaut, sodass man für die Nutzung eines dritten Bildschirms einen aktiven Displayportadapter ergo einen dritten Taktgeber nutzen musste. Diese Adapter mussten extern erworben werden und waren anfangs durchaus teuer.

Neuere Karten – eigentlich das gesamte Highendsortiment seit der R9 290x – können problemlos drei und mehr Monitore betreiben und leiden zusätzlich nicht unter eingeschränkten Auflösungen abgesehen von den Begrenzungen durch die Spezifikation der Anschlüsse.

Warum Eyefinity?

Vor zehn Jahren waren 4K-Displays und WQHD Monitore der Traum einiger weniger Enthusiasten, doch keinesfalls für die breite Masse umsetzbar. Sehr teure und hochwertige Monitore waren teils in 2560x1600 aufgelöst, doch mehr gab es tendenziell nicht oder zumindest nicht mehr bezahlbar. 1920x1080 mauserte sich damals zum Standard und scheint das erschreckenderweise auch heute immer noch zu sein. Durch die Kombination von drei recht preiswerten Full HD Monitoren, einer Highendkarte bei AMD und evtl. einem aktiven miniDP-Adapter konnte man ein sinnvolles Eyefinitystarterpaket aufbauen ohne dabei arm zu werden.

In Zeiten von WQHD Displays und gewaltigen Monitoren wie dem Samsung Odyssee G9 muss man sich allerdings tatsächlich fragen, ob Eyefinity noch sinnvoll ist oder ob nicht besser doch zu einem einzelnen großen Display gegriffen werden sollte. Selbigen Gedankengang hat man wohl auch bei AMD gehabt und ist zu einem definitiven Ergebnis gekommen, doch dazu später mehr. Ich möchte hier zuerst eine Lanze für die Multimonitorsetups brechen. Seit 2012 (damals mit Team grün) nutze ich mindestens drei Monitore an meinem Computer und möchte nicht mehr davon weg. Besagte Ultrawidemonitore habe ich gesehen und ausprobiert, doch der Funke ist nicht übergesprungen. Der Grund dafür ist einfach und vermutlich für jeden von euch, der mit mehreren Monitoren arbeitet, nachvollziehbar. Auch wenn es schöne wäre, kann nicht jede Minute, die man vor dem Rechner verbringt, mit Spielen verbracht werden. In der Zeit, die man mit Produktivarbeit verbringt, schlägt das Konzept mehrerer einzelner Monitore einen Ultrawide jederzeit. Ein Meeting in der Mitte, Spreadsheets auf den Rechten und links der Zugang zum Intranet und das alles ohne jegliches Anpassen von Fenstern, extra Programmen oder manuelles Eingreifen.

Wenn man dann mal mit der Arbeit durch ist, nimmt man die drei Monitore und verbringt einige schönes Stunden in Night City, Los Santos oder an der Kaspischen Grenze.

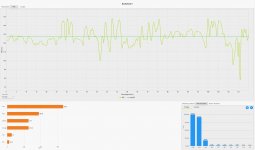

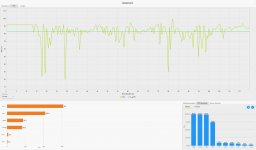

Verwendete Hardware

Eyefinity macht mit zwei Monitoren äußerst wenig Sinn, da Fadenkreuze auf den Bezels lägen oder man einen halbierten Sportwagen betrachtet. Für das Optimum sollte es drei Monitore sein. Bei einer Auflösung von 5760x1080 würde das bereits bedeuten, dass die Grafikkarte uns 6,2 Millionen Pixel berechnen müsste, UHD hätte nur noch ca. 2 Millionen Pixel mehr, nur um eine grobe Hausnummer zu geben. Heute wollen wir uns allerdings nicht Eyefinity in 5760x1080 ansehen, wie es bereits in vielen Tests geschehen ist, sondern eine Stufe darüber, in 7680x1440, testen. Dafür muss unser armer Rechenknecht mehr als 11 Millionen Pixel berechnen und demensprechend viel Leistung sollten wir haben.

Zuallererst betrachten wir allerdings die verwendeten Monitore. Ein Upgrade war bei meinen Monitoren seit Jahren überfällig und ich habe Features wie 144Hz, Freesync und HDR nie privat nutzen können. Zu allem Überfluss waren es in meinem Fall auch noch unterschiedliche Monitore, ein einzelner von Philips in der Mitte und zwei Packard Bells außen. Nachdem ich bei meinem Bruder einen AOC WQHD mit aktuellem Featureset und einen Odyssee G9 bei meinem besten Kumpel erleben konnte, war klar, dass ein Upgrade kommen musste. Ich habe daher zu Beginn nach einem einzelnen Monitor gesucht, der die entsprechenden Features hatte und preislich im Rahmen war. Dazu wollte ich mir dann zwei Weitere in der gleichen Größe mit 60Hz aufstellen, damit ich besser arbeiten kann. Diese Vorgehensweise ist allerdings nicht empfehlenswert und wir gehen im Rahmen der Probleme noch auf die Gründe ein.

Nach einigen Tagen der Suche hatte ich allerdings immer noch nichts gefunden und habe schließlich bei Caseking in der Übersicht etwas entdeckt. LG verkaufte bei einer UVP von 300€ für 250€ den 32GN600B. Der Monitor war auf dem Papier nahe am Optimum für Eyefinity. 32 Zoll, QHD, 165Hz, Freesync. Zwar nur HDR10 und 5ms Reaktionszeit, aber ich bin weder besonders kompetitiv in Spielen, noch wäre HDR10 nicht schon x-mal besser als ein acht Jahre alter Packard Bell Viseo.

Bei der restlichen Hardware gibt es eigentlich nichts weiteres Spezielles zu beachten, außer dass es nie zu viel Rechenleistung gibt und auch wenn der Zeitpunkt aktuell schlecht ist, das meiste Geld für die Grafikkarte ausgegeben werden sollte.

Hier das alte Setup:

Und dann das Neue:

Der Rest des Systems besteht aus:

AMD Ryzen 9 5900X@4,60GHz@Kraken X62

32GB Crucial DDR4 3400

AMD Radeon RX 6800XT MB @2,7GHz@300W

MSI X470 Gaming Plus Max

1600W Superflower Leadex

Aerocool Strike X ST

1TB Crucial P2

Adrenalin 21.7.1

Probleme bei der Konfiguration

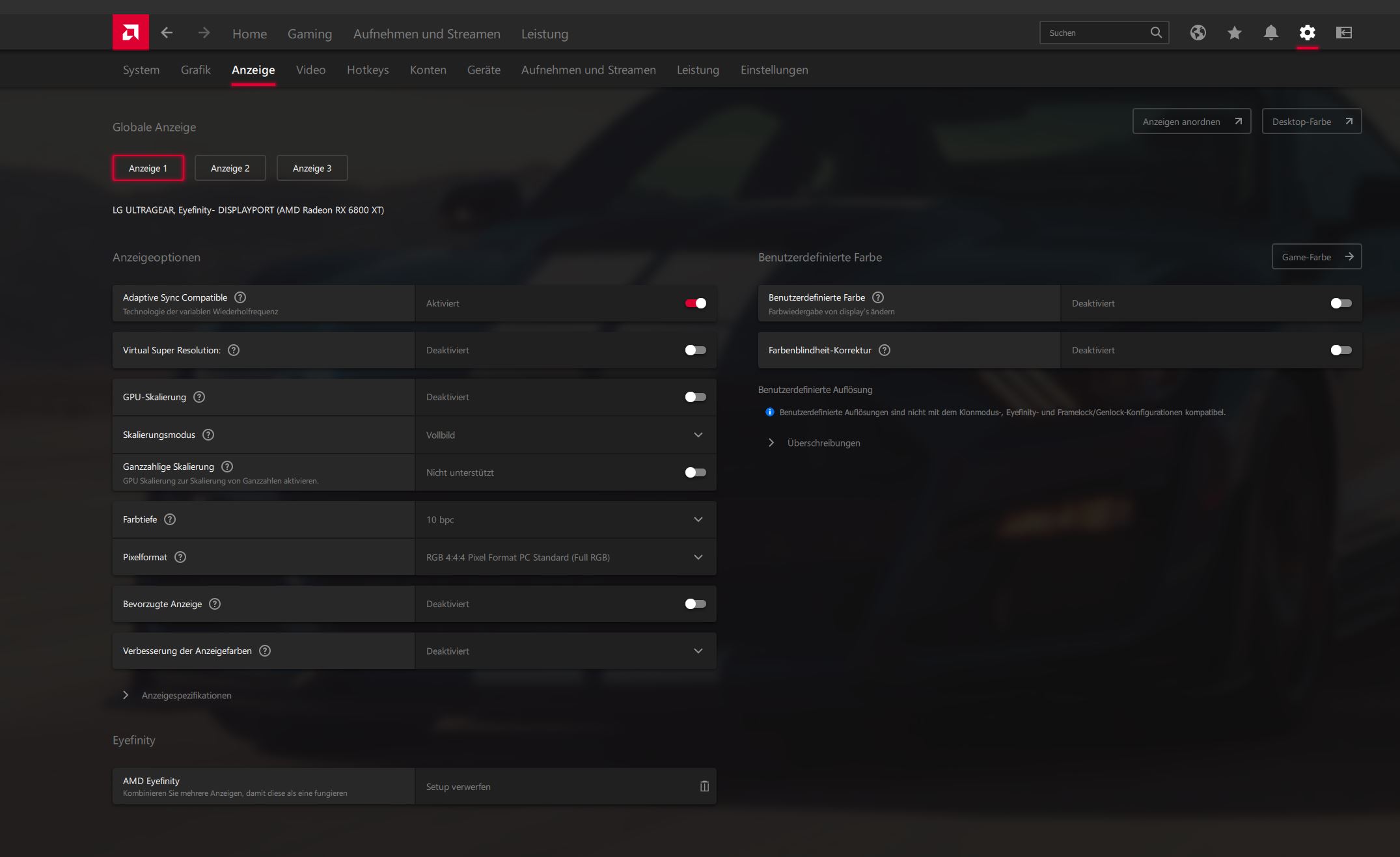

Ich will es nicht beschönigen, aber es gibt leider einige Probleme bei Eyefinity. Die Konfiguration von lediglich drei Monitoren erweist sich als problemlos. Man muss die Monitore lediglich in der Windowsanzeige richtig anordnen und ein einziger weiterer Klick auf AMD Eyefinity legt das Setup an.

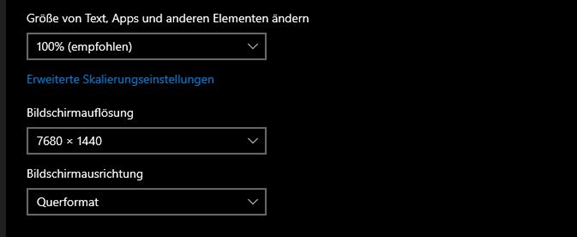

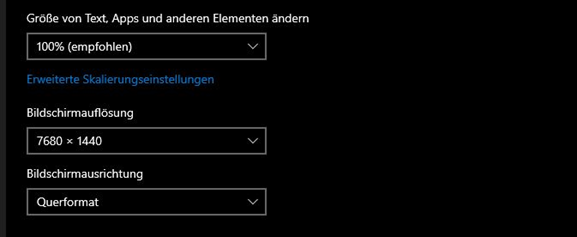

Der Gegencheck unter Windows bestätigt es, man hat nun eine nutzbare Auflösung von 7680x1440.

Hierzu muss allerdings einiges angemerkt werden. AMD Referenzkarten verfügen über zwei DP 1.4, einen HDMI 2.1 und einen Typ C. Zwei Monitore können problemlos über die Displayports angeschlossen werden. Sie werden mit QHD, 165Hz und HDR erkannt und funktionieren. Der dritte Monitor muss entweder via Typ C oder HDMI angeschlossen werden. Meine beiden neu gekauften Typ C – DP Kabel waren leider nicht dafür tauglich, den Monitor mit mehr als 60Hz zu betreiben. Der Wechsel auf HDMI 2.1 sollte diesbezüglich Besserung bringen, doch falsch, der 32GN600 hat HDMI-Ports, allerdings keine HDMI 2.1 Ports. Daher muss der dritte Monitor nun leider mit 144Hz und ohne HDR auskommen. Um die gesamte Auflösung zu aktivieren, müssen daher die anderen beiden Monitore ebenfalls auf 144Hz reduziert werden.

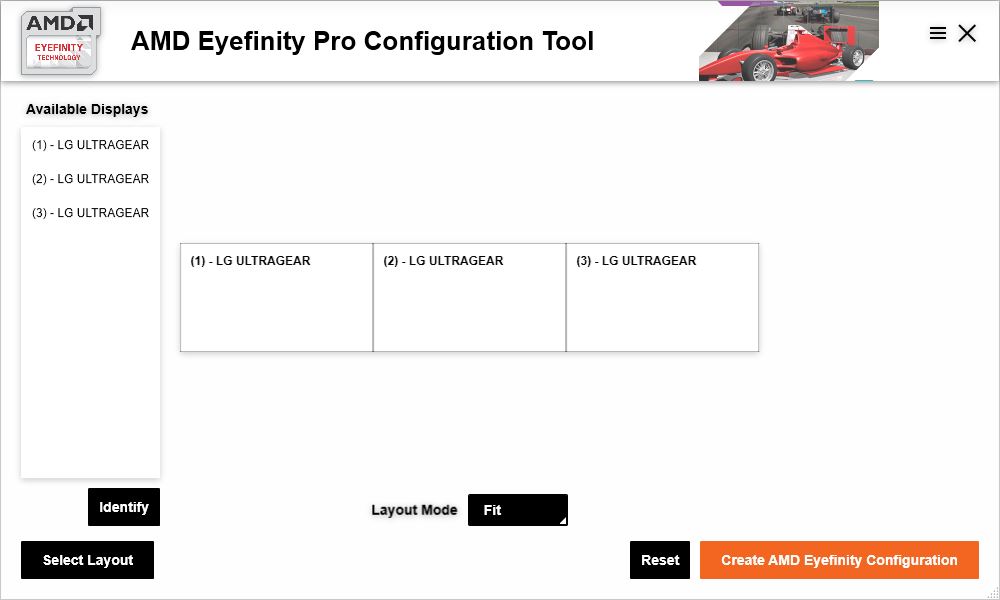

Ein weiteres Problem fällt auf, wenn mehr als drei Monitore an der GPU genutzt werden sollen. Wie auf meinem Bild zu sehen ist, hängt da noch ein älterer Fernseher, den ich angeschlossen hatte, damit darauf TS, Afterburner o.ä. laufen können. Drückt man mit solch einer angeschlossenen Kombo im Treiber auf AMD Eyefinety, so wird der vierte Bildschirm in das Setup integriert – ob ihr wollt oder nicht. Abhilfe schafft EyefinetyPro, ein AMD-Tool, das sich allerdings versteckt, AMD traut uns wohl den Umgang damit nicht zu.

Ihr findet es unter C:\Program Files\AMD\CNext\CNext

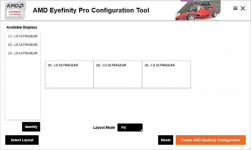

Öffnet man die Anwendung wird man von diesem Screen begrüßt.

Hier werden alle Anzeigegeräte aufgelistet, die gerade vorhanden sind. In meinem Fall sind es gerade nur drei Monitore, doch wenn es bei euch vier sind, ist das Vorgehen identisch. In der linken unteren Ecke ist das Layout wählbar.

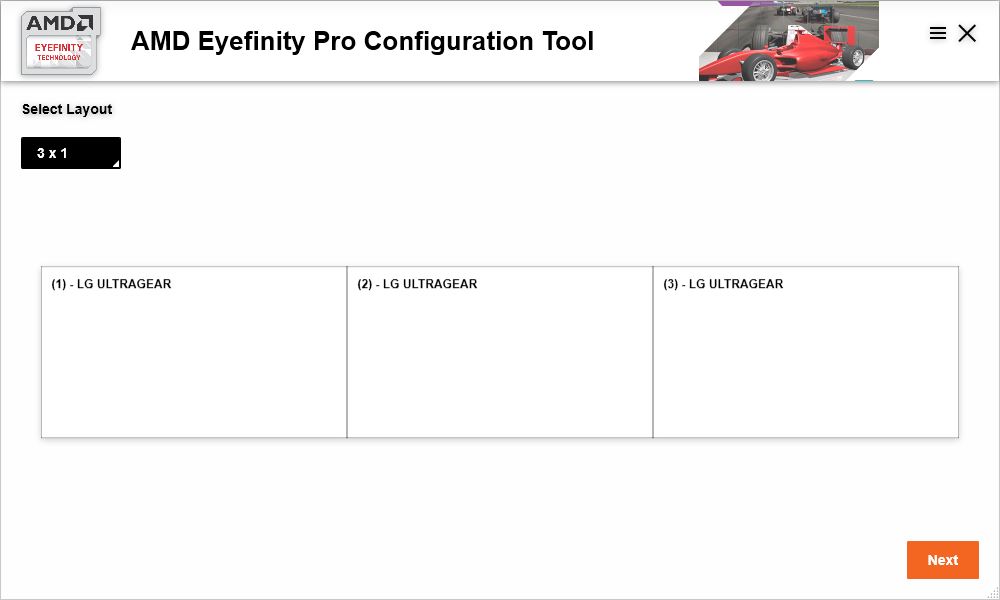

Nun wählt man 3x1 und kann dann aus den gelisteten Geräten die richtigen auswählen und auf die Positionen zuordnen. Der vierte Bildschirm kann dabei ignoriert werden, er kann danach mittels den Windowsanzeigeeinstellungen beliebig verändert werden und ist autark vom Eyefinetysetup. Beim Layoutmodus konnte ich keinen Unterschied zwischen den verschiedenen Presets feststellen und habe ihn daher immer auf Fit belassen.

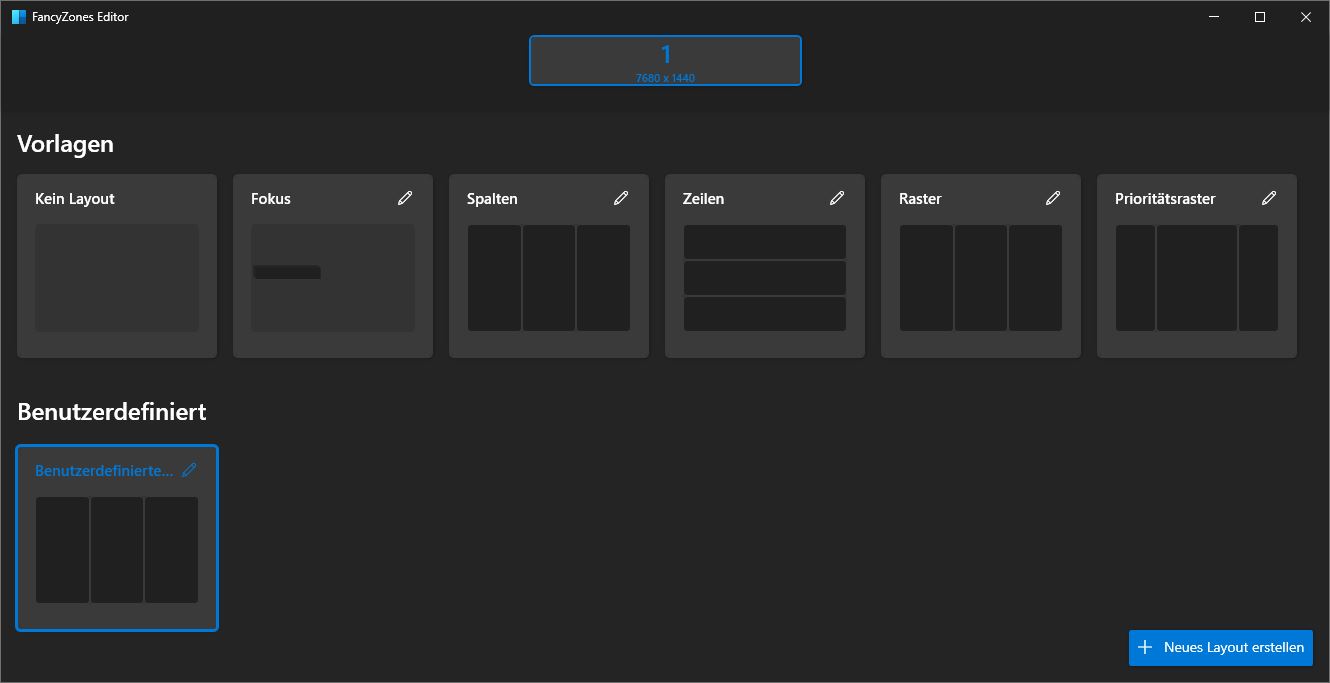

Jetzt ist das Setup zumindest erstmal eingerichtet, Zeit es auszuprobieren. Nur noch schnell etwas im Browser… verdammt, jetzt werden alle Fenster, die ich öffne, über drei Bildschirme maximiert. So ist der Computer nicht nutzbar. Abhilfe kann man schaffen, indem man die Fenster manuell zurechtzieht und die Positionen immer beibehält. Das ist aber einerseits zeitaufwendig und andererseits maximal unpraktisch, wenn ein Fenster hinzukommt oder auf einen anderen Monitor wandern soll.

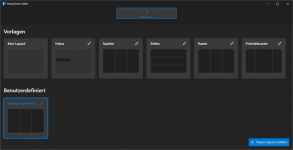

Daher empfehle ich PowerToys. Das Tool ist recht einfach zu bedienen und bietet mit der Funktion Fancy Zones eine einfache Lösung des Problems.

Hier kann die riesige Monitorfläche sinnvoll unterteilt werden. Wählt man das Preset „Spalten“ können die drei Monitore defacto als einzelne Bildschirme genutzt werden. Die einzige Umgewöhnung ist, dass Fenster nun per Windows + Pfeile verschoben werden müssen und man nicht mehr auf maximieren klicken darf, da ansonsten immer noch alle drei Monitore ausgefüllt werden. Damit ist der Computer nun zumindest nutzbar.

Probleme bei Spielen

Doch die Probleme sind damit noch nicht beendet. Das eine oder andere Spiel hält noch Überraschungen für uns bereit.

Battlefield 3

Battlefield 3 mag uns keine GUI anzeigen, dafür sieht es immernoch hübsch aus.

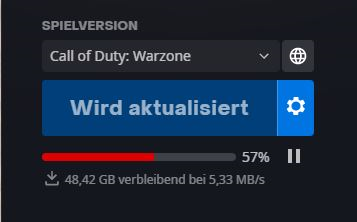

Call of Duty Warzone

Kein weiterer Kommentar.

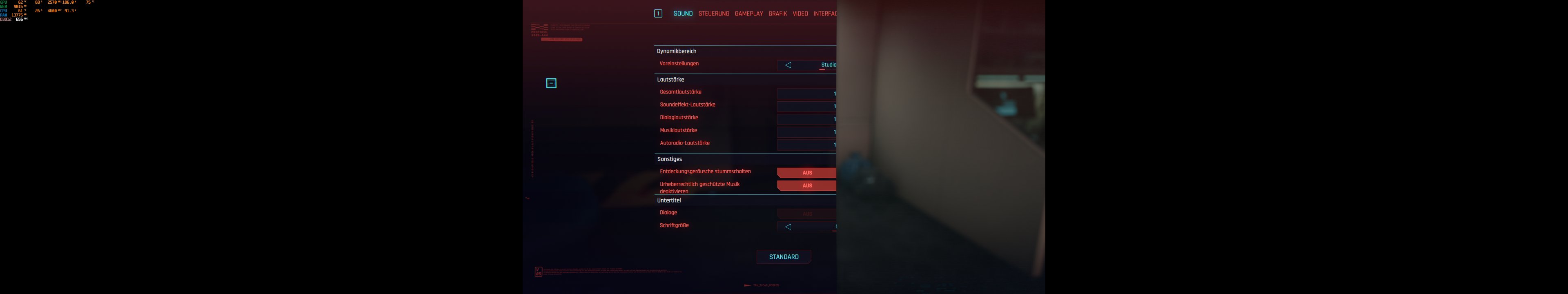

Cyberpunk 2077

Dieser Screenshot zeigt Cyberpunk 2077 im Menü. Dieses ist bei 2/3 des mittleren Monitors abgeschnitten und damit ist das Spiel eigentlich nicht nutzbar. Wird die Auflösung dagegen auf 5760x1080 reduziert, läuft alles problemlos.

Ich könnte an dieser Stelle sicher noch zig weitere Spiele aufzählen, die verzogene Loadscreens (GTA IV), ein falsches Seitenverhältnis ingame (COD 4 – 8), eigenartiges Tearing (Rage 2) oder andere Probleme haben, doch der Konsens dabei ist, dass man davon ausgehen sollte, das lediglich Triple A Titel mit DX11/12 halbwegs ordentlich funktionieren. Bei allen anderen Spielen kann man es versuchen und im Notfall wird das Eyefinitysetup deaktiviert und auf einem Monitor gespielt. Zusätzlich gibt es Widescreen Fix Pro, das in vielen Spielen eine Korrektur der Seitenverhältnisse ermöglicht, sodass sie doch noch genutzt werden können. Ich würde die Nutzung dennoch nicht empfehlen, da z.B. Cutszenes nicht angepasst werden und entsprechend schlecht aussehen.

Vision Surround 2021

Nach Eyefinity geht es nun um Nvidias Vision Surround.

Vision Surround: Erklärung, Konfiguration und verwendete Hardware

Vision Surround hat bei Nvidia kurz nach AMDs Eyefinity begonnen. Die ersten Karten, die dafür nutzbar waren, sind die GTX 4xx, Fermi oder auch Grillforce Thermi, weil sie so kalt waren. Vision Surround ist Nvidias Antwort auf Eyefinity und war daher anfangs von ähnlichen Problemen gequält. Ich habe mit dieser Technik das erste Mal exzessiv Multimonitoring erlebt und habe nicht allzu positive Erinnerungen aus dieser Zeit mitgenommen.

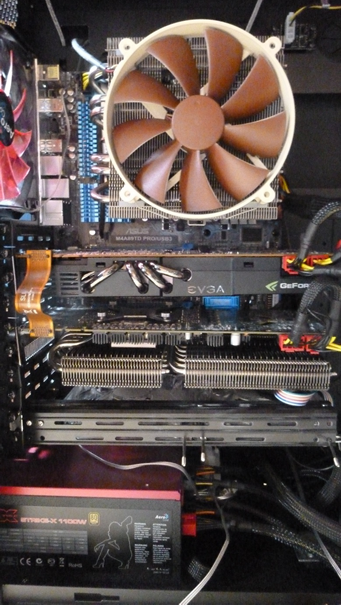

Springen wir kurz zurück ins Jahr 2010, genauer ans Ende des Jahres 2010. Nvidia hatte nach durchaus verheerender Kritik an den originalen Fermikarten einen Refresh gelauncht. Der GF110 alias GTX580 war der Vollausbau von Fermi und sollte an den neuralgischen Punkten wie Lautstärke und Kühlung ansetzen. Der Speicherbus, die Architektur, der Speicherausbau und vor allem das I/O blieben allerdings gleich. Anfang 2011 habe ich mir damals daher eine GTX480 im Referenzdesign günstig besorgt. Weniger als ein Jahr nach Release eine Grafikkarte für weniger als die UVP zu erhalten war damals anders als heute Standard und mit einem EKL Peter war auch das Temperaturproblem schnell gelöst. Die GTX480 verfügte wie auch ATIs HD5870 allerdings nur über zwei Taktgeber und man musste mit 2 DVI-Ports und einem mHDMI Vorlieb nehmen. Ich habe daran zwei Monitore in FHD betrieben und war eigentlich recht zufrieden. Durch einen glücklichen Zufall habe ich im Freundeskreis sehr günstig eine weitere GTX480 erstehen können und habe mir diese daher eingebaut.

Mein Setup sah grauenhaft aus, funktionierte allerdings echt gut.

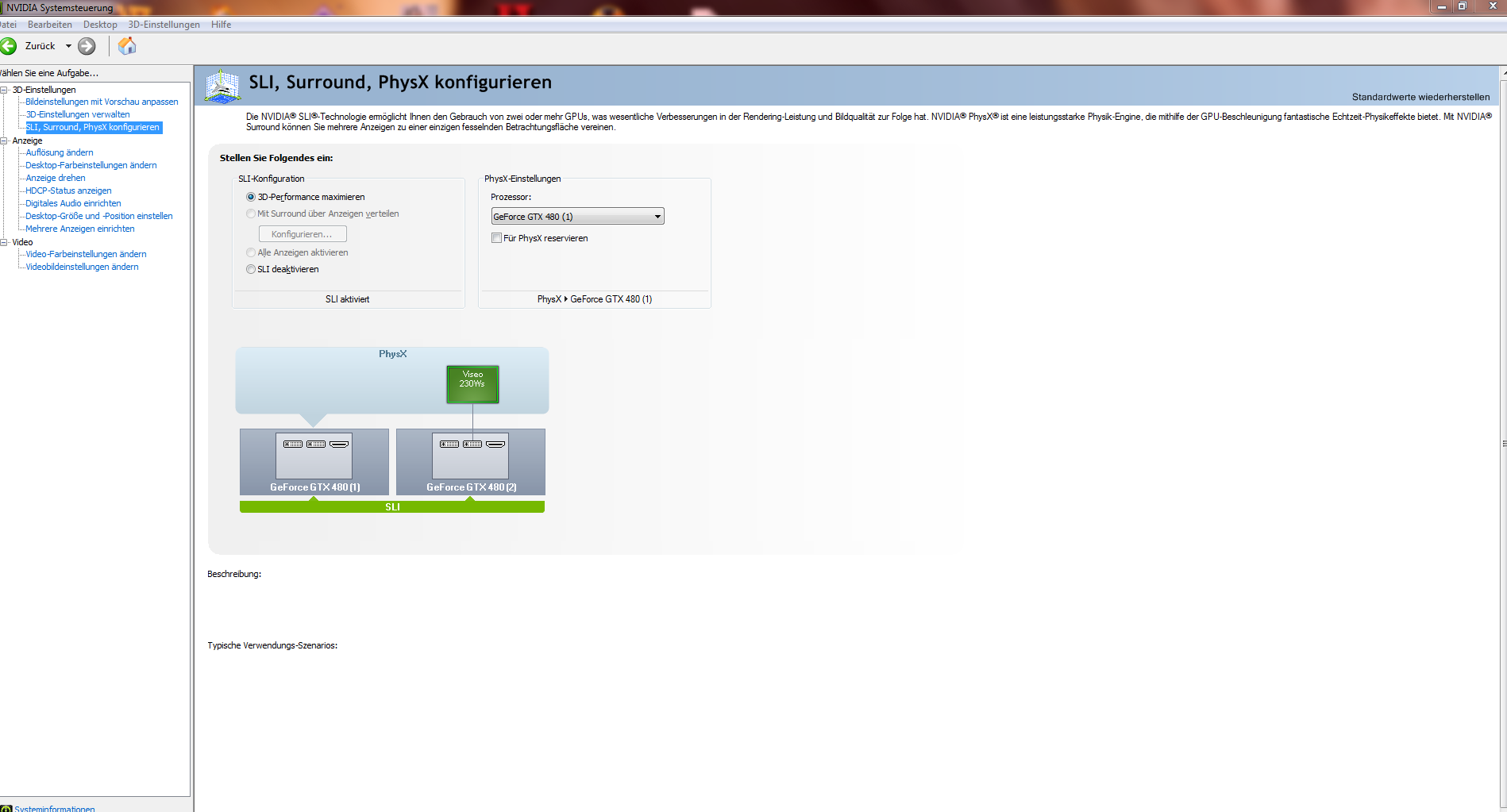

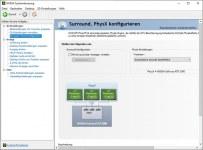

So sah das dann damals wie heute in der Systemsteuerung aus.

Aktivierte man allerdings SLI, konnte man ein interessantes Detail entdecken. „Mit Surround über die Anzeigen verteilen“ war damals und ist heute die Konfiguration für jedes Nvidiabasierte Multimonitorsetup. Ich wollte das durchaus mal testen und habe mir daher kurzerhand einen weiteren Monitor besorgt. Der enorme Vorteil, den AMD damals bot war, dass lediglich eine Grafikkarte mit aktivem Displayportadapter für den Betrieb dreier Monitore nötig war. In Ermangelung eines DP-Anschlusses war das bei den Fermikarten nicht möglich und eine zweite Grafikkarte mit einem weiteren Taktgeber wurde nötig. Wollte man lediglich drei einzelne Monitore nutzen, konnte man z.B. eine günstige G210 verbauen, die den dritten Bildschirm befeuerte. Leider ließ sich so aber kein Surroundsetup zum Spielen einrichten, dafür wurden zwei gleiche GPUs benötigt.

Mit dem Setup aus zwei GTX480 konnte man das Ende 2011 erschienene Battlefield 3, bis heute eines meiner liebsten Spiele, in 5760x1080 spielen. Der Stromverbrauch und die Lautstärke waren allerdings krass und auch die Framerate war suboptimal. Danach begann für mich eine bis zur GTX1080 andauernde Nvidiaabstinenz, in der Eyefinity und zwei R9 290 mein System befeuerten.

Nvidia erreichte relativ zeitgleich mit AMD durch mehr Taktgeber bei Kepler, dass mehr als zwei Monitore an einer Grafikkarte betrieben werden konnten und seitdem ist Vision Surround auch mit SGPUs nutzbar.

Warum Vision Surround?

Hier berufe ich mich auf den og. Vorteile, die genannten Argumente zählen für beide Seiten. Zusätzlich könnte man anführen, dass bis zum Erscheinen von RDNA wahrscheinlich mehr Enthusiasten Nvidiaprodukte verwendet haben und daher mehr Ressourcen in die Entwicklung geflossen sind.

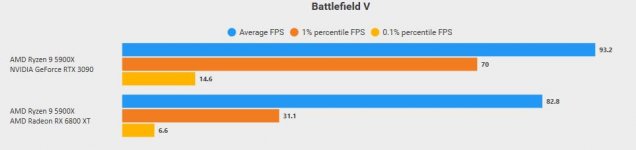

Verwendete Hardware

Der Systemaufbau ist relativ ähnlich geblieben. Ich habe das Mainboard durch ein MSI B550 Gaming Carbon Wifi ersetzt und aus Fairnessgründen im UEFI PCI-E Gen. 3 forciert. Zusätzlich kam eine Palit RTX 3090 GamingPro OC zum Einsatz, bei der das Powertarget maximiert und ein Offset von +100MHz auf die GPU und +150MHz auf den Speicher gegeben wurde. Ich nehme es gleich vorweg, damit mir niemand unterstellen kann, ich wäre ein Fanboy: Diese RTX3090 ist wohl eine der schlechtesten, die man so kaufen kann. Die FE hat ein Powerlimit von 350W, das man um 14% erhöhen kann. Die Palitkarte hat die gleichen 350W zur Verfügung, allerdings können sie hier nur um 4% erhöht werden. Zusätzlich ist mein Exemplar leider auch kein guter Overclocker, ich habe aber mein Bestes gegeben.

Der Rest des Systems besteht aus:

AMD Ryzen 9 5900X@4,60GHz@Kraken X62

32GB Crucial DDR4 3400

Palit RTX 3090 GamingPro OC @ca. 1.9Ghz, maximales PT@364W

MSI B550 Gaming Pro Carbon Wifi

1600W Superflower Leadex

Aerocool Strike X ST

1TB Crucial P2

Treiberversion 471.41

Probleme bei der Konfiguration

Glücklicherweise gibt es hier weniger Probleme beim Einrichten des Setups. Die drei Monitore können an der RTX 3090 mittels Displayport angeschlossen werden.

Anders als bei AMD muss man nicht in verwinkelten Pfaden nach Konfigurationstools suchen, sondern kann einfach die im Treiber gegebenen Optionen nutzen.

Hier wählt man die gewünschten Monitore aus und kann problemlos den vierten Bildschirm oberhalb oder daneben getrennt von dem Vision Surround Setup einstellen. Ein womöglich kriegsentscheidender Vorteil ist allerdings das Zonenmanagement. Auch nach der Einrichtung von Vision Surround kann man ohne weitere Tools und Tricks seine Monitore im Desktopbetrieb wie Einzelbildschirme nutzen. Wird ein Fenster auf dem linken Bildschirm maximiert, füllt es auch nur diesen aus und breitet sich nicht über die gesamten Bildschirme aus. Dabei lassen sich auch weiterhin beliebige windowseigene Shortscuts nutzen, lediglich die Teilung von Einzelbildschirmen in zwei Fenster funktioniert nicht und man erhält Fenster, die sich jeweils über 1,5 Bildschirme erstrecken.

Der Treiber bestätigt nach der Einrichtung sofort, dass das Setup erkannt wurde und auch hier kann man in Windows gegenchecken.

Weitere Probleme wie bei AMD sind mir nicht aufgefallen. Man könnte noch anmerken, dass – aber das trifft partiell auf beide Lager zu – die Grafikkarte bei solch einem Setup ihren Speicher nicht mehr im 2D-Takt betreibt. Dadurch ist – zumindest bei meinem Palit-Modell – der Zerofanmodus hinfällig und man hört die Grafikkartenlüfter ganz leise. Bei der Nvidiakarte war das z.B. Videos auf YT der Fall, während die AMD-Karte einfach permanent den maximalen Speichertakt nutzt.

Probleme bei Spielen

Hier gibt es einige Unterschiede. Battefield 3 hat mit der RTX 3090 seine GUI wiedergefunden und ist problemlos spielbar und auch das liebe Warzoneupgrade ist mittlerweile auf meiner SSD eingezogen.

Einzig und allein Cyberpunk zeigt sich kontinuierlich problematisch.

Genau wie bei Team Rot ist das Menü abgeschnitten und das Spiel nicht nutzbar. Alle weiteren getesteten Titel haben sich ordentlich benommen und es hat echt Spaß gemacht.

Es ist eine Weile her, dass ich etwas Sinnvolles im Forum beigetragen habe, doch durch einige aktuelle persönliche Upgrades und damit einhergehende Probleme und Ärgernisse hat sich da etwas ergeben. Daher möchte ich euch heute Eyefinity und Vision Surround mit aktuellen RDNA2 und Amperekarten vorstellen.

Eyefinity: Erklärung, Konfiguration, verwendete Hardware und Probleme

Der Anfang

Im September 2009 stellte damals noch ATI eine neue Grafikkarte vor, die Radeon HD 5870. Diese Karte war in vielerlei Hinsicht neu. Die RV870 „Cypress“ war die erste Grafikkarte für Endkunden, die DX11 fähig war, in 40nm produziert wurde und vieles mehr. Der für uns heute interessante Teil ist vieles mehr, vor allem Eyefinity. Seitdem gibt es bei Ati bzw. heute AMD dieses Feature.

Doch was ist Eyefinity eigentlich? Eyefinity ist ein Multimonitormanagement, das es uns ermöglicht, mehrere physisch einzelne Monitore zu einem Endgerät zusammenzufügen, das als großes, einzelnes Display erkannt und benutzt werden kann. Zu Beginn war die maximal mögliche Auflösung durch die DVI-Spezifikationen beschränkt und nur die Highendkarten konnten theoretisch eine Auflösung von 6 x 2560x1600@60Hz anzeigen. Bei der damaligen Rechenleistung war das allerdings nur ein Gedankenexperiment, das maximal im 2D-Betrieb umsetzbar war und das einige Voraussetzungen hatte. Bis zur HD 7xxx bzw. einigen Modellen der R9 Serie waren lediglich zwei Taktgeber in den Grafikkarten verbaut, sodass man für die Nutzung eines dritten Bildschirms einen aktiven Displayportadapter ergo einen dritten Taktgeber nutzen musste. Diese Adapter mussten extern erworben werden und waren anfangs durchaus teuer.

Neuere Karten – eigentlich das gesamte Highendsortiment seit der R9 290x – können problemlos drei und mehr Monitore betreiben und leiden zusätzlich nicht unter eingeschränkten Auflösungen abgesehen von den Begrenzungen durch die Spezifikation der Anschlüsse.

Warum Eyefinity?

Vor zehn Jahren waren 4K-Displays und WQHD Monitore der Traum einiger weniger Enthusiasten, doch keinesfalls für die breite Masse umsetzbar. Sehr teure und hochwertige Monitore waren teils in 2560x1600 aufgelöst, doch mehr gab es tendenziell nicht oder zumindest nicht mehr bezahlbar. 1920x1080 mauserte sich damals zum Standard und scheint das erschreckenderweise auch heute immer noch zu sein. Durch die Kombination von drei recht preiswerten Full HD Monitoren, einer Highendkarte bei AMD und evtl. einem aktiven miniDP-Adapter konnte man ein sinnvolles Eyefinitystarterpaket aufbauen ohne dabei arm zu werden.

In Zeiten von WQHD Displays und gewaltigen Monitoren wie dem Samsung Odyssee G9 muss man sich allerdings tatsächlich fragen, ob Eyefinity noch sinnvoll ist oder ob nicht besser doch zu einem einzelnen großen Display gegriffen werden sollte. Selbigen Gedankengang hat man wohl auch bei AMD gehabt und ist zu einem definitiven Ergebnis gekommen, doch dazu später mehr. Ich möchte hier zuerst eine Lanze für die Multimonitorsetups brechen. Seit 2012 (damals mit Team grün) nutze ich mindestens drei Monitore an meinem Computer und möchte nicht mehr davon weg. Besagte Ultrawidemonitore habe ich gesehen und ausprobiert, doch der Funke ist nicht übergesprungen. Der Grund dafür ist einfach und vermutlich für jeden von euch, der mit mehreren Monitoren arbeitet, nachvollziehbar. Auch wenn es schöne wäre, kann nicht jede Minute, die man vor dem Rechner verbringt, mit Spielen verbracht werden. In der Zeit, die man mit Produktivarbeit verbringt, schlägt das Konzept mehrerer einzelner Monitore einen Ultrawide jederzeit. Ein Meeting in der Mitte, Spreadsheets auf den Rechten und links der Zugang zum Intranet und das alles ohne jegliches Anpassen von Fenstern, extra Programmen oder manuelles Eingreifen.

Wenn man dann mal mit der Arbeit durch ist, nimmt man die drei Monitore und verbringt einige schönes Stunden in Night City, Los Santos oder an der Kaspischen Grenze.

Verwendete Hardware

Eyefinity macht mit zwei Monitoren äußerst wenig Sinn, da Fadenkreuze auf den Bezels lägen oder man einen halbierten Sportwagen betrachtet. Für das Optimum sollte es drei Monitore sein. Bei einer Auflösung von 5760x1080 würde das bereits bedeuten, dass die Grafikkarte uns 6,2 Millionen Pixel berechnen müsste, UHD hätte nur noch ca. 2 Millionen Pixel mehr, nur um eine grobe Hausnummer zu geben. Heute wollen wir uns allerdings nicht Eyefinity in 5760x1080 ansehen, wie es bereits in vielen Tests geschehen ist, sondern eine Stufe darüber, in 7680x1440, testen. Dafür muss unser armer Rechenknecht mehr als 11 Millionen Pixel berechnen und demensprechend viel Leistung sollten wir haben.

Zuallererst betrachten wir allerdings die verwendeten Monitore. Ein Upgrade war bei meinen Monitoren seit Jahren überfällig und ich habe Features wie 144Hz, Freesync und HDR nie privat nutzen können. Zu allem Überfluss waren es in meinem Fall auch noch unterschiedliche Monitore, ein einzelner von Philips in der Mitte und zwei Packard Bells außen. Nachdem ich bei meinem Bruder einen AOC WQHD mit aktuellem Featureset und einen Odyssee G9 bei meinem besten Kumpel erleben konnte, war klar, dass ein Upgrade kommen musste. Ich habe daher zu Beginn nach einem einzelnen Monitor gesucht, der die entsprechenden Features hatte und preislich im Rahmen war. Dazu wollte ich mir dann zwei Weitere in der gleichen Größe mit 60Hz aufstellen, damit ich besser arbeiten kann. Diese Vorgehensweise ist allerdings nicht empfehlenswert und wir gehen im Rahmen der Probleme noch auf die Gründe ein.

Nach einigen Tagen der Suche hatte ich allerdings immer noch nichts gefunden und habe schließlich bei Caseking in der Übersicht etwas entdeckt. LG verkaufte bei einer UVP von 300€ für 250€ den 32GN600B. Der Monitor war auf dem Papier nahe am Optimum für Eyefinity. 32 Zoll, QHD, 165Hz, Freesync. Zwar nur HDR10 und 5ms Reaktionszeit, aber ich bin weder besonders kompetitiv in Spielen, noch wäre HDR10 nicht schon x-mal besser als ein acht Jahre alter Packard Bell Viseo.

Bei der restlichen Hardware gibt es eigentlich nichts weiteres Spezielles zu beachten, außer dass es nie zu viel Rechenleistung gibt und auch wenn der Zeitpunkt aktuell schlecht ist, das meiste Geld für die Grafikkarte ausgegeben werden sollte.

Hier das alte Setup:

Und dann das Neue:

Der Rest des Systems besteht aus:

AMD Ryzen 9 5900X@4,60GHz@Kraken X62

32GB Crucial DDR4 3400

AMD Radeon RX 6800XT MB @2,7GHz@300W

MSI X470 Gaming Plus Max

1600W Superflower Leadex

Aerocool Strike X ST

1TB Crucial P2

Adrenalin 21.7.1

Probleme bei der Konfiguration

Ich will es nicht beschönigen, aber es gibt leider einige Probleme bei Eyefinity. Die Konfiguration von lediglich drei Monitoren erweist sich als problemlos. Man muss die Monitore lediglich in der Windowsanzeige richtig anordnen und ein einziger weiterer Klick auf AMD Eyefinity legt das Setup an.

Der Gegencheck unter Windows bestätigt es, man hat nun eine nutzbare Auflösung von 7680x1440.

Hierzu muss allerdings einiges angemerkt werden. AMD Referenzkarten verfügen über zwei DP 1.4, einen HDMI 2.1 und einen Typ C. Zwei Monitore können problemlos über die Displayports angeschlossen werden. Sie werden mit QHD, 165Hz und HDR erkannt und funktionieren. Der dritte Monitor muss entweder via Typ C oder HDMI angeschlossen werden. Meine beiden neu gekauften Typ C – DP Kabel waren leider nicht dafür tauglich, den Monitor mit mehr als 60Hz zu betreiben. Der Wechsel auf HDMI 2.1 sollte diesbezüglich Besserung bringen, doch falsch, der 32GN600 hat HDMI-Ports, allerdings keine HDMI 2.1 Ports. Daher muss der dritte Monitor nun leider mit 144Hz und ohne HDR auskommen. Um die gesamte Auflösung zu aktivieren, müssen daher die anderen beiden Monitore ebenfalls auf 144Hz reduziert werden.

Ein weiteres Problem fällt auf, wenn mehr als drei Monitore an der GPU genutzt werden sollen. Wie auf meinem Bild zu sehen ist, hängt da noch ein älterer Fernseher, den ich angeschlossen hatte, damit darauf TS, Afterburner o.ä. laufen können. Drückt man mit solch einer angeschlossenen Kombo im Treiber auf AMD Eyefinety, so wird der vierte Bildschirm in das Setup integriert – ob ihr wollt oder nicht. Abhilfe schafft EyefinetyPro, ein AMD-Tool, das sich allerdings versteckt, AMD traut uns wohl den Umgang damit nicht zu.

Ihr findet es unter C:\Program Files\AMD\CNext\CNext

Öffnet man die Anwendung wird man von diesem Screen begrüßt.

Hier werden alle Anzeigegeräte aufgelistet, die gerade vorhanden sind. In meinem Fall sind es gerade nur drei Monitore, doch wenn es bei euch vier sind, ist das Vorgehen identisch. In der linken unteren Ecke ist das Layout wählbar.

Nun wählt man 3x1 und kann dann aus den gelisteten Geräten die richtigen auswählen und auf die Positionen zuordnen. Der vierte Bildschirm kann dabei ignoriert werden, er kann danach mittels den Windowsanzeigeeinstellungen beliebig verändert werden und ist autark vom Eyefinetysetup. Beim Layoutmodus konnte ich keinen Unterschied zwischen den verschiedenen Presets feststellen und habe ihn daher immer auf Fit belassen.

Jetzt ist das Setup zumindest erstmal eingerichtet, Zeit es auszuprobieren. Nur noch schnell etwas im Browser… verdammt, jetzt werden alle Fenster, die ich öffne, über drei Bildschirme maximiert. So ist der Computer nicht nutzbar. Abhilfe kann man schaffen, indem man die Fenster manuell zurechtzieht und die Positionen immer beibehält. Das ist aber einerseits zeitaufwendig und andererseits maximal unpraktisch, wenn ein Fenster hinzukommt oder auf einen anderen Monitor wandern soll.

Daher empfehle ich PowerToys. Das Tool ist recht einfach zu bedienen und bietet mit der Funktion Fancy Zones eine einfache Lösung des Problems.

Hier kann die riesige Monitorfläche sinnvoll unterteilt werden. Wählt man das Preset „Spalten“ können die drei Monitore defacto als einzelne Bildschirme genutzt werden. Die einzige Umgewöhnung ist, dass Fenster nun per Windows + Pfeile verschoben werden müssen und man nicht mehr auf maximieren klicken darf, da ansonsten immer noch alle drei Monitore ausgefüllt werden. Damit ist der Computer nun zumindest nutzbar.

Probleme bei Spielen

Doch die Probleme sind damit noch nicht beendet. Das eine oder andere Spiel hält noch Überraschungen für uns bereit.

Battlefield 3

Battlefield 3 mag uns keine GUI anzeigen, dafür sieht es immernoch hübsch aus.

Call of Duty Warzone

Kein weiterer Kommentar.

Cyberpunk 2077

Dieser Screenshot zeigt Cyberpunk 2077 im Menü. Dieses ist bei 2/3 des mittleren Monitors abgeschnitten und damit ist das Spiel eigentlich nicht nutzbar. Wird die Auflösung dagegen auf 5760x1080 reduziert, läuft alles problemlos.

Ich könnte an dieser Stelle sicher noch zig weitere Spiele aufzählen, die verzogene Loadscreens (GTA IV), ein falsches Seitenverhältnis ingame (COD 4 – 8), eigenartiges Tearing (Rage 2) oder andere Probleme haben, doch der Konsens dabei ist, dass man davon ausgehen sollte, das lediglich Triple A Titel mit DX11/12 halbwegs ordentlich funktionieren. Bei allen anderen Spielen kann man es versuchen und im Notfall wird das Eyefinitysetup deaktiviert und auf einem Monitor gespielt. Zusätzlich gibt es Widescreen Fix Pro, das in vielen Spielen eine Korrektur der Seitenverhältnisse ermöglicht, sodass sie doch noch genutzt werden können. Ich würde die Nutzung dennoch nicht empfehlen, da z.B. Cutszenes nicht angepasst werden und entsprechend schlecht aussehen.

Vision Surround 2021

Nach Eyefinity geht es nun um Nvidias Vision Surround.

Vision Surround: Erklärung, Konfiguration und verwendete Hardware

Vision Surround hat bei Nvidia kurz nach AMDs Eyefinity begonnen. Die ersten Karten, die dafür nutzbar waren, sind die GTX 4xx, Fermi oder auch Grillforce Thermi, weil sie so kalt waren. Vision Surround ist Nvidias Antwort auf Eyefinity und war daher anfangs von ähnlichen Problemen gequält. Ich habe mit dieser Technik das erste Mal exzessiv Multimonitoring erlebt und habe nicht allzu positive Erinnerungen aus dieser Zeit mitgenommen.

Springen wir kurz zurück ins Jahr 2010, genauer ans Ende des Jahres 2010. Nvidia hatte nach durchaus verheerender Kritik an den originalen Fermikarten einen Refresh gelauncht. Der GF110 alias GTX580 war der Vollausbau von Fermi und sollte an den neuralgischen Punkten wie Lautstärke und Kühlung ansetzen. Der Speicherbus, die Architektur, der Speicherausbau und vor allem das I/O blieben allerdings gleich. Anfang 2011 habe ich mir damals daher eine GTX480 im Referenzdesign günstig besorgt. Weniger als ein Jahr nach Release eine Grafikkarte für weniger als die UVP zu erhalten war damals anders als heute Standard und mit einem EKL Peter war auch das Temperaturproblem schnell gelöst. Die GTX480 verfügte wie auch ATIs HD5870 allerdings nur über zwei Taktgeber und man musste mit 2 DVI-Ports und einem mHDMI Vorlieb nehmen. Ich habe daran zwei Monitore in FHD betrieben und war eigentlich recht zufrieden. Durch einen glücklichen Zufall habe ich im Freundeskreis sehr günstig eine weitere GTX480 erstehen können und habe mir diese daher eingebaut.

Mein Setup sah grauenhaft aus, funktionierte allerdings echt gut.

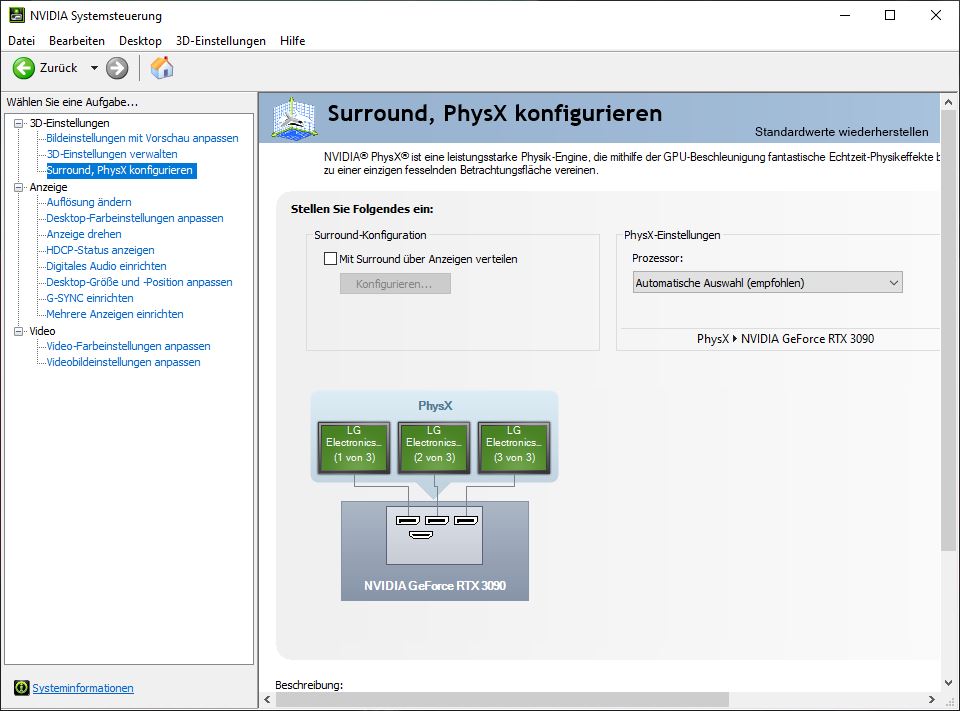

So sah das dann damals wie heute in der Systemsteuerung aus.

Aktivierte man allerdings SLI, konnte man ein interessantes Detail entdecken. „Mit Surround über die Anzeigen verteilen“ war damals und ist heute die Konfiguration für jedes Nvidiabasierte Multimonitorsetup. Ich wollte das durchaus mal testen und habe mir daher kurzerhand einen weiteren Monitor besorgt. Der enorme Vorteil, den AMD damals bot war, dass lediglich eine Grafikkarte mit aktivem Displayportadapter für den Betrieb dreier Monitore nötig war. In Ermangelung eines DP-Anschlusses war das bei den Fermikarten nicht möglich und eine zweite Grafikkarte mit einem weiteren Taktgeber wurde nötig. Wollte man lediglich drei einzelne Monitore nutzen, konnte man z.B. eine günstige G210 verbauen, die den dritten Bildschirm befeuerte. Leider ließ sich so aber kein Surroundsetup zum Spielen einrichten, dafür wurden zwei gleiche GPUs benötigt.

Mit dem Setup aus zwei GTX480 konnte man das Ende 2011 erschienene Battlefield 3, bis heute eines meiner liebsten Spiele, in 5760x1080 spielen. Der Stromverbrauch und die Lautstärke waren allerdings krass und auch die Framerate war suboptimal. Danach begann für mich eine bis zur GTX1080 andauernde Nvidiaabstinenz, in der Eyefinity und zwei R9 290 mein System befeuerten.

Nvidia erreichte relativ zeitgleich mit AMD durch mehr Taktgeber bei Kepler, dass mehr als zwei Monitore an einer Grafikkarte betrieben werden konnten und seitdem ist Vision Surround auch mit SGPUs nutzbar.

Warum Vision Surround?

Hier berufe ich mich auf den og. Vorteile, die genannten Argumente zählen für beide Seiten. Zusätzlich könnte man anführen, dass bis zum Erscheinen von RDNA wahrscheinlich mehr Enthusiasten Nvidiaprodukte verwendet haben und daher mehr Ressourcen in die Entwicklung geflossen sind.

Verwendete Hardware

Der Systemaufbau ist relativ ähnlich geblieben. Ich habe das Mainboard durch ein MSI B550 Gaming Carbon Wifi ersetzt und aus Fairnessgründen im UEFI PCI-E Gen. 3 forciert. Zusätzlich kam eine Palit RTX 3090 GamingPro OC zum Einsatz, bei der das Powertarget maximiert und ein Offset von +100MHz auf die GPU und +150MHz auf den Speicher gegeben wurde. Ich nehme es gleich vorweg, damit mir niemand unterstellen kann, ich wäre ein Fanboy: Diese RTX3090 ist wohl eine der schlechtesten, die man so kaufen kann. Die FE hat ein Powerlimit von 350W, das man um 14% erhöhen kann. Die Palitkarte hat die gleichen 350W zur Verfügung, allerdings können sie hier nur um 4% erhöht werden. Zusätzlich ist mein Exemplar leider auch kein guter Overclocker, ich habe aber mein Bestes gegeben.

Der Rest des Systems besteht aus:

AMD Ryzen 9 5900X@4,60GHz@Kraken X62

32GB Crucial DDR4 3400

Palit RTX 3090 GamingPro OC @ca. 1.9Ghz, maximales PT@364W

MSI B550 Gaming Pro Carbon Wifi

1600W Superflower Leadex

Aerocool Strike X ST

1TB Crucial P2

Treiberversion 471.41

Probleme bei der Konfiguration

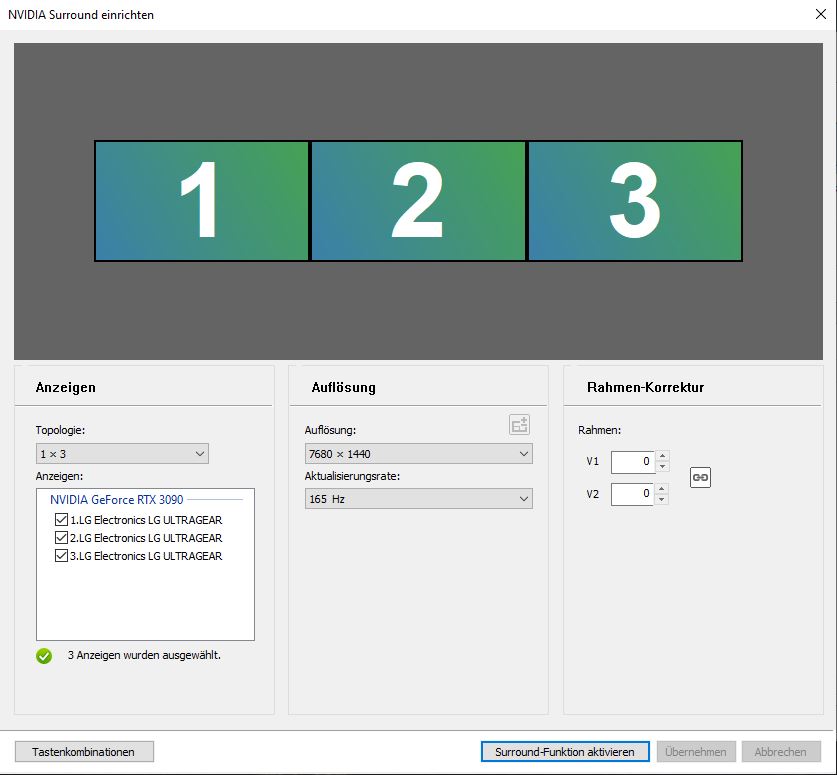

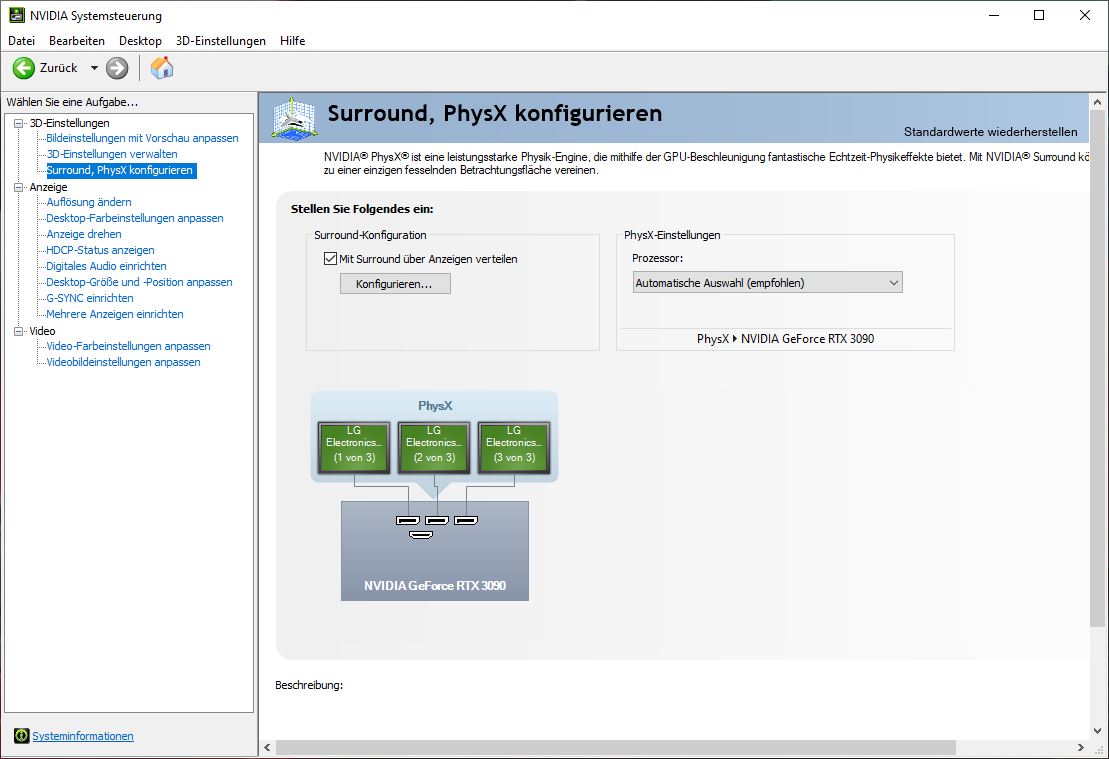

Glücklicherweise gibt es hier weniger Probleme beim Einrichten des Setups. Die drei Monitore können an der RTX 3090 mittels Displayport angeschlossen werden.

Anders als bei AMD muss man nicht in verwinkelten Pfaden nach Konfigurationstools suchen, sondern kann einfach die im Treiber gegebenen Optionen nutzen.

Hier wählt man die gewünschten Monitore aus und kann problemlos den vierten Bildschirm oberhalb oder daneben getrennt von dem Vision Surround Setup einstellen. Ein womöglich kriegsentscheidender Vorteil ist allerdings das Zonenmanagement. Auch nach der Einrichtung von Vision Surround kann man ohne weitere Tools und Tricks seine Monitore im Desktopbetrieb wie Einzelbildschirme nutzen. Wird ein Fenster auf dem linken Bildschirm maximiert, füllt es auch nur diesen aus und breitet sich nicht über die gesamten Bildschirme aus. Dabei lassen sich auch weiterhin beliebige windowseigene Shortscuts nutzen, lediglich die Teilung von Einzelbildschirmen in zwei Fenster funktioniert nicht und man erhält Fenster, die sich jeweils über 1,5 Bildschirme erstrecken.

Der Treiber bestätigt nach der Einrichtung sofort, dass das Setup erkannt wurde und auch hier kann man in Windows gegenchecken.

Weitere Probleme wie bei AMD sind mir nicht aufgefallen. Man könnte noch anmerken, dass – aber das trifft partiell auf beide Lager zu – die Grafikkarte bei solch einem Setup ihren Speicher nicht mehr im 2D-Takt betreibt. Dadurch ist – zumindest bei meinem Palit-Modell – der Zerofanmodus hinfällig und man hört die Grafikkartenlüfter ganz leise. Bei der Nvidiakarte war das z.B. Videos auf YT der Fall, während die AMD-Karte einfach permanent den maximalen Speichertakt nutzt.

Probleme bei Spielen

Hier gibt es einige Unterschiede. Battefield 3 hat mit der RTX 3090 seine GUI wiedergefunden und ist problemlos spielbar und auch das liebe Warzoneupgrade ist mittlerweile auf meiner SSD eingezogen.

Einzig und allein Cyberpunk zeigt sich kontinuierlich problematisch.

Genau wie bei Team Rot ist das Menü abgeschnitten und das Spiel nicht nutzbar. Alle weiteren getesteten Titel haben sich ordentlich benommen und es hat echt Spaß gemacht.

Anhänge

-

1627045756388.png430,9 KB · Aufrufe: 430

1627045756388.png430,9 KB · Aufrufe: 430 -

1627045778228.png468 KB · Aufrufe: 565

1627045778228.png468 KB · Aufrufe: 565 -

1627045792707.png430,9 KB · Aufrufe: 523

1627045792707.png430,9 KB · Aufrufe: 523 -

1627045843174.png140,2 KB · Aufrufe: 520

1627045843174.png140,2 KB · Aufrufe: 520 -

1627045881379.png69,1 KB · Aufrufe: 532

1627045881379.png69,1 KB · Aufrufe: 532 -

1627045900773.png51 KB · Aufrufe: 512

1627045900773.png51 KB · Aufrufe: 512 -

1627045921702.png33,5 KB · Aufrufe: 508

1627045921702.png33,5 KB · Aufrufe: 508 -

1627045940963.png206,4 KB · Aufrufe: 512

1627045940963.png206,4 KB · Aufrufe: 512 -

1627045975593.png41,5 KB · Aufrufe: 513

1627045975593.png41,5 KB · Aufrufe: 513 -

1627046106797.png64,8 KB · Aufrufe: 505

1627046106797.png64,8 KB · Aufrufe: 505 -

1627046132011.png190,1 KB · Aufrufe: 515

1627046132011.png190,1 KB · Aufrufe: 515 -

1627046148356.png135,4 KB · Aufrufe: 495

1627046148356.png135,4 KB · Aufrufe: 495 -

1627046166553.png157,2 KB · Aufrufe: 506

1627046166553.png157,2 KB · Aufrufe: 506 -

1627046282241.png178,3 KB · Aufrufe: 495

1627046282241.png178,3 KB · Aufrufe: 495 -

1627047148736.jpeg128,8 KB · Aufrufe: 496

1627047148736.jpeg128,8 KB · Aufrufe: 496 -

1627047155149.jpeg155,9 KB · Aufrufe: 480

1627047155149.jpeg155,9 KB · Aufrufe: 480 -

1627047160563.jpeg182,3 KB · Aufrufe: 488

1627047160563.jpeg182,3 KB · Aufrufe: 488

Zuletzt bearbeitet: