ich hatte in meinem ca. 8 Jahre alten Fujitsu Esprimo P2560 seit ca. 5 Jahren eine GTX750ti zu voller Zufriedenheit laufen. Die hat kürzlich den Geist aufgegeben, und ich wollte sie durch eine GTX1650 ersetzen.

Leider scheint dieses Vorhaben nicht zu funktionieren. Nach dem Einschalten des PC passiert folgendes:

Ich sehe am Bildschirm kurz dieses verwaschene Bild - siehe Beilage "GTX1650_boot". Danach kommt das Windows10-Logo auf blauem Hintergrund, und kurz danach wird der Monitor komplett schwarz, mit kurzer Einblendung "entering Power Safe Mode".

Allerdings ist es mir ein einziges Mal gelungen, das Bild länger aufrecht zu erhalten, für mehrere Minuten - dabei hat sich sofort der richtige Grafiktreiber runtergeladen und installiert, und ein perfektes Bild geliefert. Bis auch dann kurz danach der Monitor wieder schwarz wurde.

Weitere Boot-Versuche endeten immer wie eingangs beschrieben mit "entering Power Safe Mode" kurz nach Erscheinen des Windows10-Logos auf blauem Hintergrund.

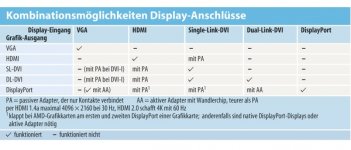

Kurz als weitere Info: Der Bildschirm ist mittels VGA-Kabel angeschlossen, die Karte hat u.a. einen DVI-Ausgang wie auch Displayport-Ausgänge. Beide Möglichkeiten habe ich mittels entsprechender Adapter ausprobiert, ohne Erfolg.

Eine genaue Beschreibung des PC liegt hier als pdf bei, wobei ich außer der seinerzeitigen Aufrüstung der Grafik auf eine GTX750ti auch das Netzteil erneurt habe (450W), den ursprünglichen 2-Kern-Prozessor mit einem 4-Kerner ersetzt (Intel Core 2 Quad Q9550) und die ursprünglichen 4GB RAM auf 8GB erweitert habe.

Wie gesagt, mit der GTX750ti hat alles bestens funktioniert, bis zu derem kürzlichen Tod.

Derzeit werkt im PC ersatz- bzw. vorübergehenderweise eine ganz alte Grafikkarte, die ich gleich nach dem Kauf des PC eingesetzt hatte, nämlich eine ATI Radeon HD5450.

Hat jemand eine Idee, wo das Problem liegen bzw. wie ich dieses beheben könnte?

Ich hätte die Möglichkeit, die neue GTX1650 bis Mitte nächster Woche an den Online-Händler zu retournieren, sollte ich sie nicht zum Laufen bringen. Andersrum wäre es mir natürlich lieber.

Leider scheint dieses Vorhaben nicht zu funktionieren. Nach dem Einschalten des PC passiert folgendes:

Ich sehe am Bildschirm kurz dieses verwaschene Bild - siehe Beilage "GTX1650_boot". Danach kommt das Windows10-Logo auf blauem Hintergrund, und kurz danach wird der Monitor komplett schwarz, mit kurzer Einblendung "entering Power Safe Mode".

Allerdings ist es mir ein einziges Mal gelungen, das Bild länger aufrecht zu erhalten, für mehrere Minuten - dabei hat sich sofort der richtige Grafiktreiber runtergeladen und installiert, und ein perfektes Bild geliefert. Bis auch dann kurz danach der Monitor wieder schwarz wurde.

Weitere Boot-Versuche endeten immer wie eingangs beschrieben mit "entering Power Safe Mode" kurz nach Erscheinen des Windows10-Logos auf blauem Hintergrund.

Kurz als weitere Info: Der Bildschirm ist mittels VGA-Kabel angeschlossen, die Karte hat u.a. einen DVI-Ausgang wie auch Displayport-Ausgänge. Beide Möglichkeiten habe ich mittels entsprechender Adapter ausprobiert, ohne Erfolg.

Eine genaue Beschreibung des PC liegt hier als pdf bei, wobei ich außer der seinerzeitigen Aufrüstung der Grafik auf eine GTX750ti auch das Netzteil erneurt habe (450W), den ursprünglichen 2-Kern-Prozessor mit einem 4-Kerner ersetzt (Intel Core 2 Quad Q9550) und die ursprünglichen 4GB RAM auf 8GB erweitert habe.

Wie gesagt, mit der GTX750ti hat alles bestens funktioniert, bis zu derem kürzlichen Tod.

Derzeit werkt im PC ersatz- bzw. vorübergehenderweise eine ganz alte Grafikkarte, die ich gleich nach dem Kauf des PC eingesetzt hatte, nämlich eine ATI Radeon HD5450.

Hat jemand eine Idee, wo das Problem liegen bzw. wie ich dieses beheben könnte?

Ich hätte die Möglichkeit, die neue GTX1650 bis Mitte nächster Woche an den Online-Händler zu retournieren, sollte ich sie nicht zum Laufen bringen. Andersrum wäre es mir natürlich lieber.