damn80 schrieb:

ssds werden aber sicher nie auch nur annähernd den preis von festplatten erreichen.

Zumindest auf lange Zeit nicht, da ja auch bei den HDDs noch neue Technologien wie HAMR kommen, die dann deren Preis pro TB weiter senken werden. Bei NAND ist man schon in die dritte Dimension gegangen, da ist nicht mehr unendlich viel Potential für Kostensenkungen drin.

AAS schrieb:

-Für grosse Dateien sind Festplatten immer noch praktisch

Ja, die spielt die lange Zugriffszeit der HDDs keine so große Rolle.

AAS schrieb:

-Gerade bei grossen Schreibvorgängen, kann es sein, dass eine HDD sparsmer ist als eine SSD

Wobei das die SSD im Idle dann meist wieder ausgleicht und weil die meist schneller schreibt, ist sie auch früher wieder Idle. Man sollte da nicht nur die Watt sondern auch die Zeit betrachten.

AAS schrieb:

-Eine HDD kann ich in den Schrank legen und 10 Jahre später auslesen, eine SSD die 10 Jahre keinen Strom gesehen hat, wird wohl nicht mehr alles hergeben

Da sehe ich bei einer SSD bessere Chancen, zumal wenn sie neu ist und die Lagerung kühl erfolgt. HDDs sind nicht unbeschränkt lagerfähig! Dazu schreibt Seagate z.B. hier und auch in einigen anderen Product Manuals:

Wenn also die Lagerbedingungen nicht eingehalten werde, sind 90 Tage und zwar in der ungeöffneten Originalverpackung, sonst bestenfalls 1 Jahr. Nach dem Öffnen sollten HDD nicht länger als 30 Tage stromlos sein.

Bei der neuen Barracuda Pro 10TB mit Heliumfüllung schreibt Seagate:

Also hier nur ein halbes Jahr in der ungeöffneten originalen Versandverpackung von Seagate und sonst 2 Monate, nur bei optimalen Bedingungen bis zu einem Jahr.

HGST schreibt für die Megascale:

Es kann sein das eine vor 10 Jahren eingelagerte HDD heute nocht geht, verlassen kann man sich darauf nicht und wenn sie noch geht, muss das nicht auch für eine heutige HDD in 10 Jahren genauso gelten. Die Langzeitarchivierung digitaler Daten ist sowieso ein besonderes Problem und weder mit eingelagerten HDDs noch eingemotteten SSDs wirklich zu lösen.

AAS schrieb:

-TBW von 500-1000 TB sind einfach lächerlich für eine enterprise Medium

Wovon redest Du? Die meisten Enterprise SSDs werden nur mit weniger als 0,3 DWPD beaufschlagt und weiter SSDs sich verbreiten, umso mehr werden auch für Anwendungen verwendet so es noch weniger ist. Die HDDs haben auch einen beschränkten Workload (von den 15krpm abgesehen) und da zählt anderes als bei SSDs auch das gelesene Schreibvolumen dazu. Bei den 3.5" ist 550TB/Jahr das Limit, es gibt keine die noch höher spezifiziert sind!

AAS schrieb:

-Datenrettung extrem schwieriger bzw. teilweise unmöglich

Wer Datenrettung braucht, hat vorher schon grobe Fehler bei der Datensicherung gemacht! Für Enterprisekunden sollte das kein Argument sein und hier geht es in der News um eine Enterprise HDD!

AAS schrieb:

-URE sind bei Inbetriebnahme recht hoch und erst mit der Zeit niedriger

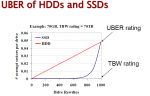

Wie bitte? Bei was, HDDs oder SSDs? Die Kurven sehen im Prinzip so aus:

Da sehe ich weder bei HDDs noch bei SSDs eine hohe Rate unkorrigierbarer Bitfehler am Anfang und bei SSDs kommen solche Fehler erst am Ende der Lebenserwartung vor, außer man hat sie z.B. mit unerwarteten Spannungsabfälle provoziert, aber die entsprechenden Enterprise für Data Center sind alle mit eine Full-Power-Loss-Protection versehen und nicht nur so einer Client Lösung wie sie einige Consumer SSDs haben und das Marketing sie anderen nur andichtet.

Shoryuken94 schrieb:

Das gleiche mit schnellen SAS Platten. Auch diese haben eine berechtigung, da diese beispielsweise super Schreibleistungen abliefern, ohne dass der Speicher dabei verschleißt.

Nein, deren Zukunft ist schon zu Ende, WD hat das Segment selbst schon aufgegeben, Seagate hat kürzlich noch einmal eine neu Generation vorgestellt, aber auch gleich mit den Hinweis das es sie letzte sein wird. Die Teile sind im Vergleich zu SSDs zu lahm, aber die werden eben immer dort eingesetzt wo die Performance eine Rolle spielt und die Kapazitäten sind geradezu lächerlich klein, was für Storage mit großen Kapazitäten zusätzliche Kosten für die Infrastruktur bedeutet.

Die Haltbarkeit der NANDs ist bei SSDs auch nicht das Problem welches manche immer noch dort zu sehen glauben. Erstens sind auch HDDs nur auf eine Nutzungsdauer von 5 Jahren ausgelegt, zweitens gibt es auch SSDs mit 10 und mehr DWPD und drittens liegt es an der intelligenten Verteilung wie viele DWPD die SSDs wirklich haben müssen. Wenn man z.B. für eine DB die Daten auf ein RAID 5 / 6 packt und nur die Tablespaces mit viel Schreibvolumen schon wegen der Performance extra auf ein RAID 1 oder RAID 10, dann wären die SSDs für dieses RAID 1 (RAID 10 bräuchte man bei deren Performance und Kapazität vermutlich nicht) natürlich hoch belastet. Aber man könnte sehr wahrscheinlich einfach nur ein RAID 5 über alle SSDs machen und wäre immer noch schneller, würde aber die hohe Schreiblast damit über alle SSDs verteilen und würde dann für diese auf weit weniger DWPD kommen, da auch Datenbank meist einen gewissen und oft nicht geringen Teil statischer Daten enthalten die sich eben kaum bis gar nicht ändern. Das Know-How wie man es am geschicktesten anstellt, ist aber leider bei vielen der Verantwortlichen nicht zu finden.

Shoryuken94 schrieb:

Der Professionelle bereich spült viel mehr umsatz in die taschen der Hersteller und spielt auch eine größere Rolle. Für diese einsatzzwecke werden huptsächlich die produkte entwickelt.

Richtig, es geht in der News um eine "Server‑Festplatte", die ist nicht für den Heimanwender gedacht.

Shoryuken94 schrieb:

Ich glaube Backblaze hatte mal vor einigen jahren größere Statistiken aufgestellt und da hat Hitachi mit abstand am besten abgeschnitten.

Nicht wieder Backblaze, die haben Anwendungen für die sie genau solche Server-Festplatten einsetzen müssen, nehmen aber stattdessen von Seagate und Toshiba nur die einfachsten Desktopplatten und damit ist es auch kein Wunder, dass diese nicht so lange durchhalten. Die einzelnen Kategorien von HDDs unterschieden sich intern viel stärker als man es ihnen von außen ansieht, die billigsten Desktopplatten haben zum Beispiel nur 55TB/Jahr Workload Rating, also ein Zehntel dessen was die Enterprise Nearline HDDs haben. Die HGST Megascale die Backblaze einsetzt, sind übrigens Enterprise HDDs der Cloud Klassen, also mit 180TB/Jahr Workload, aber 24/7 Zulassung und aufwendiger Technik gegen Vibrationen, die sind für unendliche viele HDDs im gleichen Gehäuse zugelassen. Von WD werden dort die Red verbaut, einfache NAS Platten die zwar 24/7 Zulassung haben, aber nur für bis zu 8 HDDs in einem Gehäuse gedacht und zugelassen sind, die frühen Red sogar nur für bis zu 5.

Die alten Hitachi waren übrigens alle mit 24/7 Zulassung und der aufwendigen Technik gegen Vibrationen versehen, selbst die einfache Deskstar! Mit den einfachen Desktopplatten von heute oder auch schon von vor Jahren bei Seagate wie der ST3000DM001, haben die also nichts zu tun, waren aber von einige guten Angeboten in der Zeit der Übernahme durch WD auch immer deutlich teurer und wurden danach direkt nur als Deskstar NAS weiter geführt, die einfachen Deskstar gab es nach der Übernahme lange gar nicht mehr im HGST Programm.

Shoryuken94 schrieb:

andere Serien hingegen sind kaum kaputt zu bekommen.

Man muss die für die jeweilige Anwendung passende Platte kaufen und nicht einfach die, die in der Kapazität am günstigsten ist! Würde Backbalze von Seagate und Toshiba auch Enterprise HDDs verwenden wie von HGST, wäre ein Vergleich der Ausfallraten der Hersteller möglich, so ist er dort wegen der unterschiedlichen Arten von HDDs aber einfach nicht legitim!

N4zGuL schrieb:

stacke nur noch Flash only, auch im backup. der Preis Unterschied bei entsprechenden Volumen ist nicht mehr relevant.

Gerade wenn es um große Datenvolumen geht, ist der Preisunterschied von HDDs und SSDs relevant und keiner kann sehr viele TB als SSDs zu ähnlichen Preisen wie als HDDs verbauen, außer der Lieferant verkauft die HDDs total überteuert