Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Nvidia × MediaTek: Neuer G-Sync-Scaler macht Monitore günstiger und leiser

- Ersteller Vitche

- Erstellt am

- Zur News: Nvidia × MediaTek: Neuer G-Sync-Scaler macht Monitore günstiger und leiser

Nochmal: G-Sync kann auch nichts anderes tun als Bilder verdoppeln. Es macht es nur im Monitor anstatt in der GPU.t3chn0 schrieb:Wenn man unter 40FPS kommt und die Bilder gedoppelt werden, ist das einfach nur Müll.

Und der klassiche FreeSync Monitor ist halt primitiver und lässt die GPU machen, was er nicht kann.

Die spannende Frage ist wie und wann genau wird verdoppelt, dass es besser wirkt. Aber bis jetzt kam mir keine Idee, warum es nicht möglich sein sollte das mit LFC auf der GPU genauso gut zu können. Ich sage nur immer wieder, der Monitor kennt sich selbst genau. Während die GPU die Internas des Monitors erstmal nicht kennt. Also ist es gut vorstellbar, dass die G-Sync Module einfach besser auf den jeweiligen Monitor abgestimmt sind als die meisten FreeSync Lösungen. Aber man sollte nicht ausschließen, dass ein anderer Monitor Hersteller ähnlich gute Ergebnisse erzielen kann, ohne Hilfe von Nvidia.

Auch bricht es keine Kompatibilität mit Adaptive Sync oder HDMI VRR einfach wie Nvidia LFC im Monitor zu machen, wenn es so einfach bessere Ergebnisse gibt. Deshalb kann man ja auch aktuelle G-Sync Displays an anderen GPUs mit VRR gut nutzen, ohne irgendwelche VRR Features zu verlieren. Der Monitor macht einfach 90% der Arbeit, unabhängig von welche GPU ihm Frames sendet.

Und als Beispiel: ich habe meinen G-Sync Ultimate Monitor seit 2 Jahren an meiner Intel iGPU.

Ich kann im Intel Treiber auswählen ob ich GPU LFC haben will oder einfach den Monitor machen lassen will. Und ich sehe keinen Unterschied wie flüssig es ist mit niedrigen FPS. Tatsächlich habe ich GPU LFC an, weil dann mein Mauszeiger nicht ruckelt wenn ein Spiel oder auch nur ein Fenster niedrige Frames ausgibt.

- Registriert

- Juni 2010

- Beiträge

- 1.424

Sieht man ja an dem neuen WGHD Monitor von Asus der ebenfalls in einem der aktuellen Themen vorgestellt wurde. Die Hersteller erhöhen sich damit die Marge, mehr auch nicht.kenny12 schrieb:signifikant sollen die Änderungen am Preis sein.

Am Ende wird das ganze teurer als vorher.

engineer123

Banned

- Registriert

- Jan. 2009

- Beiträge

- 3.783

Hoebelix schrieb:...und hat doch mehr Substanz als:

Denn das ist nichts anderes als Kaffeesatz Leserei mit Anti-nVidia Bias...

Ja, klasse erkannt, von G-Sync hab ich keine Ahnung und fand es schon immer scheisse...

schau mal runter 👇😂 (Tipp: Z35P)

engineer123

Banned

- Registriert

- Jan. 2009

- Beiträge

- 3.783

Na also, da ist das Ding:

Erste Vorstellung mit dem neuen Mediatek-Chip!

https://www.computerbase.de/news/mo...d-mit-480-hz-und-den-neuen-g-sync-chip.89262/

Der PG27AQDP soll in Kürze für 1.099 Euro erhältlich sein 👌 ✌️

Ist billig, kann man sich auch im 3er Pack rauslassen.

^^jo, exakt. Der Einkaufsvorteil von dem Mediatek Chip teilt sich vermutlich Asus mit Nvidia.

Endverbraucher wird halt mit dem Argument von Nvidia "dient dazu die UVP signifikant zu senken" total verarscht, das ist echt lachhaft.

Bester Marketing Stunt des Jahres bislang, eine günstigere Produktion schön reden, das glaubt man alles nicht 😂

Erste Vorstellung mit dem neuen Mediatek-Chip!

https://www.computerbase.de/news/mo...d-mit-480-hz-und-den-neuen-g-sync-chip.89262/

Der PG27AQDP soll in Kürze für 1.099 Euro erhältlich sein 👌 ✌️

Ist billig, kann man sich auch im 3er Pack rauslassen.

xcsvxangelx schrieb:Sieht man ja an dem neuen WGHD Monitor von Asus der ebenfalls in einem der aktuellen Themen vorgestellt wurde. Die Hersteller erhöhen sich damit die Marge, mehr auch nicht.

^^jo, exakt. Der Einkaufsvorteil von dem Mediatek Chip teilt sich vermutlich Asus mit Nvidia.

Endverbraucher wird halt mit dem Argument von Nvidia "dient dazu die UVP signifikant zu senken" total verarscht, das ist echt lachhaft.

Bester Marketing Stunt des Jahres bislang, eine günstigere Produktion schön reden, das glaubt man alles nicht 😂

t3chn0 schrieb:Wenn man unter 40FPS kommt und die Bilder gedoppelt werden, ist das einfach nur Müll.

Ich konnte bisher nur bei dem offiziell nicht G-Sync-kompatiblen Dell S2719DGF leichtes Flackern in manchen Situationen feststellen. Der Dell G2724D tut bisher genau das, was er soll. Wie der G-Sync-Monitor mit Modul, den ich vor den Dells hatte.

Seufz, nein.Ray519 schrieb:Bist du Nvidia PR?

Genau das steht ja auch in der News. ^^Ray519 schrieb:Ich hätte jetzt erwartet dass der Daseinszweck von Redakteuren ist, nicht Presse Mitteilungen unreflektiert abzudrucken, sondern das für die Leser etwas aufzuschlüsseln. Das wenn Nvidia das Wort "G-Sync" nutzt, das alles und nichts heißen kann

Natürlich braucht das keine konkrete GPU oder deren Treiber.Ray519 schrieb:Dann musst du mir jetzt mal erklären wie Backlight Strobing im Monitor die GPU oder der ihren Treiber braucht.

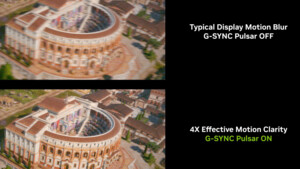

Das ist wie Black Frame Insertion. Das ist ein Monitor-Feature. Das braucht keine GPU. Da geht es doch nur darum, dass der Monitor sein Backlight zwischen 2 Frames abschaltet um von der Sample-and-Hold Natur von LCD wegzukommen. Und das ist nicht leicht, wenn die Framerate sich ständig ändert und jedes Verschieben des an/aus Verhältnisses des Backlights die wahrgenommene Helligkeit des Monitors entschieden beeinflusst.

Und geneau deswegen könnte man das behaupten, weil es eben gar nicht zwingend eine GeForce benötigen müsste.Ray519 schrieb:Wenn man behaupten möchte, dass Nvidia die Kunden hier gängelt, sollte man das eben wissen.

Nun, VRR ist ein Teil von G-Sync. Bei Nvidia dann eben G-Sync Compatible. Hier geht es aber um G-Sync. Und das ist != VRR.Ray519 schrieb:Außerdem hat sich das ursprüngliche Zitat und alle meine Antworten auf VRR selbst bezogen,

Mir ist klar und das habe ich auch in einigen Posts klargestellt, dass zB die Nvidia Reflex End-To-End Latenzmessung spezifisch für Nvidia GPU und Treiber ist. Aber das würde ich nicht als etwas Wesentliches im VRR Kontext bezeichnen.

Bitte, versteh mich nicht falsch. Ich versteh dich ja auch nicht falsch, ich weiß, worauf du hinaus willst und dass du um die technischen Hintergründe bemüht bist. Aber ich kann dir aus Erfahrung sagen, dass es für die allerallermeisten Leser nur noch verwirrender wird, wenn ich die "Dinge" bei einem doch recht komplexen Kontext nicht bei dem Namen nenne, den der Hersteller nutzt und den sie kennen.

Dem Gedanken kann ich nicht folgen. Du hast nirgendwo gesagt, und ich finde keine glaubhafte Aussage, dass Pulsar verdongelt ist. Du klangst am Anfang so als würdest du es vermuten mit deiner Zustimmung zu anderen Meinungen, dass das ja nichts taugt, weil es exklusiv wäre.Vitche schrieb:Und geneau deswegen könnte man das behaupten, weil es eben gar nicht zwingend eine GeForce benötigen müsste.

Und jetzt sagst du gleichzeitig, na klar ist das nicht exklusiv aber man "sollte keine Nvidia GPU benötigen"?

Ich habe kein Problem mit der News selbst. Da wurde nichts wirklich falsches gesagt.

Ich habe ein Problem damit wenn Leute das fälschlicherweise als Exklusivfeatures verteufeln. Und Fehlinformationen über die Technik streuen und nicht über die Marketingbegriffe.

Und auch damit wenn Leute den Marketingbegriff "G-Sync" als Technik bezeichnen. Weil das ist einfach nicht gegeben.

Und du hast auf folgenden Kommentar

mitengineer123 schrieb:offensichtlich immer noch so, dass die G-Sync Funktion weiterhin nur mit NV-Karte und Treiber angesprochen werden kann.

geantwortet. Das lese ich als Zustimmung, dass es exklusiv ist. Nachdem ich versucht habe zu erklären dass das nicht stimmt.Vitche schrieb:Hätte ich diese Frage gestellt wäre ich wahrscheinlich ausgelacht worden. ^^ Ich denke wir alle kennen die Antwort.

Folgendes wäre meine Zusammenfassung der Fakten:

- "G-Sync Ultimate" wird von Nvidia als eine Zertifizierung verwendet, für wie es mit Nvidia GPUs zusammenarbeitet.

- "G-Sync Ultimate" garantiert laut Nvidia mit Nvidia GPUs die neu genug sind HDR und gutes und zuverlässiges VRR

- "G-Sync Pulsar" ist ein getrenntes Feature das nur den Prefix mit G-Sync teilt. Es ist auch für "G-Sync Ultimate" optional

- "Reflex Analyzer" ist auch ein optionales Feature

- "G-Sync Ultimate" [Module aus den letzten 3-4 Jahren] liefern einen High End Monitor mit VRR und HDR.

- Gute VRR Umsetzung für DP Adaptive Sync und HDMI VRR. Standardkonform und Herstellerübergreifend

- Variables Overdrive ist auch immer dabei für LCDs und Herstelleragnostisch.

- "G-Sync"

MonitoreModule ohne "Ultimate" aus den letzten 3 Jahren und in Zukunft garantieren kein HDR, aber immer noch Herstellerübergreifendes VRR mit variablem Overdrive wo möglich - "G-Sync Pulsar" ist mit extrem hoher Wahrscheinlichkeit auch nur ein Feature des Monitors das Herstellerübergreifend geht

- "Reflex Analyzer" ist exklusiv für Nvidia GPUs mit Treibern

Also, das Kern Feature von "G-Sync" und "G-Sync Ultimate" ist definitiv VRR. Und es ist seit Jahren Herstelleragnostisch. Und die meisten der optionalen Features sind auch Herstelleragnostisch, inklusive von Pulsar.

Das einzige was Nvidia exklusiv zu sein scheint ist das optionale Feature der Latenzmessung, dass noch nicht mal "G-Sync" im Namen trägt.

Das taugt meiner Meinung nach nicht ansatzweise als Begründung "G-Sync" als Exklusivfeature ab zu tun.

Tatsächlich ist "G-Sync Ultimate" auch für nicht-Nvidia GPU Besitzer ein Zertifikat für die Qualität der VRR Lösung, in einem Maß, wie es kein exaktes Äquivalent von AMD gibt. Es war nur bisher auch ein Garant von Rückstand in Ports.

Ist ja ok, wenn man alles schön einfach halten will. Wie der gemeine Apple-Nutzer kauft man sich dann nur Komponenten aus dem passenden Ökosystem. Dann braucht man sich um die Details nicht kümmern. Aber man kann sich auch nicht beschweren, dass es nicht offen oder exklusiv ist, wenn man die Details nicht wissen will. Man muss sich dann auch zurückhalten mit negativen Aussagen halt einfach nicht stimmen.

Edit: ich habe meine Aussagen auf "Module" geändert und ein Zeitlimit hinzugefügt. Weil ich nicht sicher bin ob alle Ultimate Module das konnten. Es gab eine Pressemitteilung das alle ab Zeitpunkt X das können.

Und scheinbar hat Nvidia auch andere Monitore mit "Ultimate" zertifiziert, die kein Modul nutzen. So wie die TVs mit "G-Sync". Da hängt es dann vom Monitor Hersteller ab.

Zuletzt bearbeitet:

@t3chn0

Ich glaube das Folgende könnte für dich interessant sein:

Ist von 2015

pcper Analyse G-Sync Verhalten

Man muss berücksichtigen, dass der Artikel zu einem Zeitpunkt erschienen ist, wo es bei FreeSync noch kein Frame-Doubling gab und dahingehend bezüglich FreeSync veraltet ist.

Youtube Video Live Analyse pcper

Untersuchung eines G-Sync Monitors durch Schrittweise Herabsenken der fps in der Nvidia Pendeldemo.

Ergebnis von pcper: Bereich ohne Frame Doubling: 37-144 Hz

unter 37 beginnt Frame Doubling

verwendeter Monitor:

Geizhals Link Acer 144 Hz G-Sync

angegebene Werte:

Variable Synchronisierung NVIDIA: G-Sync (1-144Hz via DisplayPort)

Auch wenn ich meine, dass da früher grundsätzlich 30-144 Hz stand. Aber in beiden Fällen ändert sich nichts.

Die untere angegebene Grenze ist anscheinend ein gewürfelter Wert von Nvidia.

Das Problem mit der ungenauen Angabe hält ja mittlerweile auch bei FreeSync Monitoren Einzug.

Da hilft wohl nur noch der Blick ins Datenblatt:

Beispiel:

G-Sync Ultimate Monitor: Sync-Range 1 - 175 Hz

Geizhals MSI Optix MEG381CQRDE Plus

Datenblatt MSI

Signalfrequenz: 48-170 Hz

Tja, schön wärs gewesen, dass die G-Sync Ultimate Monitore bis runter auf 1 Hz ohne Frame Doubling kommen.

@Vitche

Wie wäre es wenn ihr wie pcper bei Monitortests mit einem Oszilloskopen die Werte der heutigen angegebenen Monitorspezifikationen gleich mit überprüfen würdet? Das würde euch von den anderen Testseiten auf jedenfall abheben und mir mal einen Grund geben ein CB Pro Abo abzuschließen.

Ich glaube das Folgende könnte für dich interessant sein:

Ist von 2015

pcper Analyse G-Sync Verhalten

Man muss berücksichtigen, dass der Artikel zu einem Zeitpunkt erschienen ist, wo es bei FreeSync noch kein Frame-Doubling gab und dahingehend bezüglich FreeSync veraltet ist.

Youtube Video Live Analyse pcper

Untersuchung eines G-Sync Monitors durch Schrittweise Herabsenken der fps in der Nvidia Pendeldemo.

Ergebnis von pcper: Bereich ohne Frame Doubling: 37-144 Hz

unter 37 beginnt Frame Doubling

verwendeter Monitor:

Geizhals Link Acer 144 Hz G-Sync

angegebene Werte:

Variable Synchronisierung NVIDIA: G-Sync (1-144Hz via DisplayPort)

Auch wenn ich meine, dass da früher grundsätzlich 30-144 Hz stand. Aber in beiden Fällen ändert sich nichts.

Die untere angegebene Grenze ist anscheinend ein gewürfelter Wert von Nvidia.

Das Problem mit der ungenauen Angabe hält ja mittlerweile auch bei FreeSync Monitoren Einzug.

Da hilft wohl nur noch der Blick ins Datenblatt:

Beispiel:

G-Sync Ultimate Monitor: Sync-Range 1 - 175 Hz

Geizhals MSI Optix MEG381CQRDE Plus

Datenblatt MSI

Signalfrequenz: 48-170 Hz

Tja, schön wärs gewesen, dass die G-Sync Ultimate Monitore bis runter auf 1 Hz ohne Frame Doubling kommen.

@Vitche

Wie wäre es wenn ihr wie pcper bei Monitortests mit einem Oszilloskopen die Werte der heutigen angegebenen Monitorspezifikationen gleich mit überprüfen würdet? Das würde euch von den anderen Testseiten auf jedenfall abheben und mir mal einen Grund geben ein CB Pro Abo abzuschließen.

Suspektan

Commodore

- Registriert

- März 2021

- Beiträge

- 4.248

Ich sehe keinen Zusammenhang zu hdr, weil es eigentlich unabhängig von vrr vom Display unterstûtzt wird oder eben nicht, "gsync compatible" entspricht bei Übertragung via hdmi auch nur " hdmi forum vrr", womit hdr auch nicht beeinträchtigt wird.Ray519 schrieb:G-Sync"MonitoreModule ohne "Ultimate" aus den letzten 3 Jahren und in Zukunft garantieren kein HDR, aber immer noch Herstellerübergreifendes VRR mit variablem Overdrive wo möglich

Mit "Gsync compatible" über DP aka adaptive sync mag es sich aber anders verhalten, nutze ich nie.

Dafür hätte ich gerne eindeutige Belege, fehlende technische Notwendigkeit muss nvidia nicht von irgendeiner unnötigen Zwangsbindung abhalten.Ray519 schrieb:G-Sync Pulsar" ist mit extrem hoher Wahrscheinlichkeit auch nur ein Feature des Monitors das Herstellerübergreifend geht

Wurde eben von nvidia mit entwickelt und wird so auch gerne von nvidia als exklusives Feature beschrieben, kein Monitorhersteller scheint bisher eine vergleichbare Technik von sich aus anzubieten.

Hier wurde die Frage ja auch gestellt, wird sich wohl demnächst klären

https://forums.blurbusters.com/viewtopic.php?p=107131#p107131

Zuletzt bearbeitet:

Ich glaube das war einfach nur so ein hartnäckiges Gerücht. Befeuert davon dass in den EDID Daten sowas wie " Monitor ranges (Bare Limits): 30-120 Hz" stand. Aber ohne Adaptive Sync, was die nicht hatten, sagt das eben nichts über die VRR Range aus. Und wenn der FPS Counter vom Monitor bis 1Hz runter geht, dann geht die VRRmin auch bis dahin runter.Traxton schrieb:Auch wenn ich meine, dass da früher grundsätzlich 30-144 Hz stand.

Jetzt muss ich das Video schauen um zu verstehen wie die Frame Doubling erkennen, wenn das Frame gleich bleibt... ^^Traxton schrieb:rgebnis von pcper: Bereich ohne Frame Doubling: 37-144 Hz

Edit: "with science" und machen einen großen Deal daraus wie großzügig sie doch sind den Nerds zu erklären welche Zeiteinheiten man auf dem Oszi misst, wenn sie das explizit in der Kamera zeigen wollen. Aber sie gehen mit keinem Wort drauf ein, was sie denn messen und warum das die Refreshrate ist. Messen die einfach Backlight Strobing und der Monitor macht das ein mal pro Refresh? Oder was?

Ergänzung ()

Korrekt. Technisch ist das bei allen normalen Protokollen ganz unabhängig. Aber "Lifelike HDR" ist Teil von dem was "G-Sync Ultimate" zertifiziert. Nur deshalb schreibe ich das so. HDR ist nicht verhindert ohne "Ultimate". Aber Nvidia gibt dann Null Garantien darauf wie es aussieht oder ob es überhaupt geht.Suspektan schrieb:ch sehe keinen Zusammenhang zu hdr, weil es eigentlich unabhängig von vrr vom Display unterstûtzt wird

Ich kann zwar sagen, dass die Garantien für HDR an meinem AW3821 viel zu lax sind. Kontrast und Nutzbarkeit für HDR wird einfach effektiv nicht garantiert. Aber immerhin die Farben passen. So dass man HDR anschalten kann ohne dass sich die Farben auf dem Desktop ändern. Etwas dass man bei vielen schlechten HDR Umsetzungen sehen kann "der Grauschleier" etc.

Ja. Wenn sie es verdongeln wollten, wäre es möglich. Oder wenn das radikal anders funktioniert als mich mir vorstelle. Ich würde dafür empfehlen sich die Historie von anderen G-Sync Features und BFI anzusehen. Und an G-Sync war nie etwas verdongelt. Eher Nvidia hat etwas selbst entwickelt und dann nicht offen gelegt. Aber an G-Sync nie durch so etwas wie Apple mit ihren iPhone Batterien zwangsgebunden. Mag für viele Leute effektiv das gleiche heißen. Ist es aber technisch nicht.Suspektan schrieb:fehlende technische Notwendigkeit muss nvidia nicht von irgendeiner unnötigen Zwangsbindung abhalten.

Und wenn es keinen Grund zur Annahme gibt, dass der Monitor dazu in irgendeiner Weise mit der GPU reden muss, wäre es gewaltiger Aufwand jetzt neu eine Verdongelung einzuführen, wenn man gerade anfängt mit anderen Chipherstellern zu kooperieren um das mehr in den Markt zu bringen.

Deshalb wage ich zu vermuten, dass sie das auch jetzt nicht machen werden.

Aber ja es bleibt ein "educated guess". Betrachte es als Begründung, warum ich erwarte dass eine Publikation da nachfragen sollte und keine Anhaltspunkte hat anhand derer man sagen könnte "das hat Nvidia die letzten 3 Mal gemacht, das machen die jetzt bestimmt wieder". Weil das war bei G-Sync nach meiner Kenntnis noch nie der Fall.

Zuletzt bearbeitet:

lynx007

Rear Admiral

- Registriert

- Feb. 2011

- Beiträge

- 5.405

"Ein OLED-Monitor beispielsweise wird aus technischen Gründen niemals G-Sync Pulsar („VRR + ULMB“) anbieten können, weil es eben kein Backlight fürs Strobing gibt."

Das verstehe ich nicht.... warum soll es kein Blacklight fürs Strobing geben? Gibt doch OLED die das haben .... Zumidnest sollen auch OLED motionblure haben und manche OLEDs sollen dem mit Strobing begegenen.

https://blurbusters.com/faq/oled-motion-blur/

Das verstehe ich nicht.... warum soll es kein Blacklight fürs Strobing geben? Gibt doch OLED die das haben .... Zumidnest sollen auch OLED motionblure haben und manche OLEDs sollen dem mit Strobing begegenen.

https://blurbusters.com/faq/oled-motion-blur/

ChrisBln82

Cadet 4th Year

- Registriert

- Feb. 2023

- Beiträge

- 87

Ich habe in der Vergangenheit diverse "Gamer"-Monitore ausprobiert, u.a. den Asus PG35VQ (GSYNC-Ultimate), welcher mich mit seinem Lüfter allerdings fast in den Wahnsinn getrieben hat. Über 2.000€ für das Ding bezahlt und dann sowas. Unter dem Strich ist das für mich wirklich die reinste Abzocke.

Seit einem Jahr habe ich nun einen LG OLED 42" TV als Monitorersatz auf meinem Schreibtisch: OLED-Panel, 120Hz, GSYNC-Kompatibilität und kein nerviger Lüfter. Darüber hinaus mit knapp über 1.000€ nichtmal halb so teuer wie der PG35VQ damals. War die beste Entscheidung die ich treffen konnte und bin seitdem absolut zufrieden. Kann ich nur empfehlen, wenn man nicht unbedingt Ultrawide-Auflösung oder extrem hohe Bildwiederholraten braucht.

Seit einem Jahr habe ich nun einen LG OLED 42" TV als Monitorersatz auf meinem Schreibtisch: OLED-Panel, 120Hz, GSYNC-Kompatibilität und kein nerviger Lüfter. Darüber hinaus mit knapp über 1.000€ nichtmal halb so teuer wie der PG35VQ damals. War die beste Entscheidung die ich treffen konnte und bin seitdem absolut zufrieden. Kann ich nur empfehlen, wenn man nicht unbedingt Ultrawide-Auflösung oder extrem hohe Bildwiederholraten braucht.

Zuletzt bearbeitet:

engineer123 schrieb:Der PG27AQDP soll in Kürze für 1.099 Euro erhältlich sein 👌 ✌️

Ist billig, kann man sich auch im 3er Pack rauslassen.

Auch hier wieder - das ist doch einfach Quatsch...

Das ist die UVP des neuesten 480 Hz (!) OLED Monitors von ASUS.

Wo siehst du da jetzt den Beweis dass sich nichts am Preis geändert hat?

Nehmen wir als Vergleich den ASUS ROG Swift PG27AQN 360 Hz IPS aber mit mit G-Sync Modul

-> Der hat vor genau einem Jahr 1249 € gekostet - ASUS Preise halt.

Du hast jetzt also einen kommenden OLED Monitor mit maximaler Bildwiderholfrequenz - also das 27" Top Modell von ASUS (somit eh einer der teureren Hersteller) und fabulierst bei 1099€ von "nix ist billiger geworden", obwohl das der angekündigte UVP ist - somit nach 2 Wochen sicher schon unter 1000€ Straßenpreis sein wird!?

Komm mal klar, das ist doch schon peinlich...

Naicon

Lieutenant

- Registriert

- Dez. 2021

- Beiträge

- 742

Dann müsste erstmal das VRR Flickering Problem gelöst werden.theGucky schrieb:

engineer123

Banned

- Registriert

- Jan. 2009

- Beiträge

- 3.783

Hoebelix schrieb:Auch hier wieder - das ist doch einfach Quatsch...

Das ist die UVP des neuesten 480 Hz (!) OLED Monitors von ASUS.

Wo siehst du da jetzt den Beweis dass sich nichts am Preis geändert hat?

Nehmen wir als Vergleich den ASUS ROG Swift PG27AQN 360 Hz IPS aber mit mit G-Sync Modul

-> Der hat vor genau einem Jahr 1249 € gekostet - ASUS Preise halt.

Du hast jetzt also einen kommenden OLED Monitor mit maximaler Bildwiderholfrequenz - also das 27" Top Modell von ASUS (somit eh einer der teureren Hersteller) und fabulierst bei 1099€ von "nix ist billiger geworden", obwohl das der angekündigte UVP ist - somit nach 2 Wochen sicher schon unter 1000€ Straßenpreis sein wird!?

Komm mal klar, das ist doch schon peinlich...

nice, voll daneben gelangt 😂

Zitat von mir selbst von der Monitorvorstellung:

Nvidia hat einfach einen Marketing Stunt hingelegt, da sie auf Nachfrage von CB geantwortet haben

"UVP sinkt signifikant"...

Das ist auf diesem Level ziemlich Kokolores, niemand kann wissen oder ausrechnen ob dieser Monitor hier mit dem alten Modul z.B. 1199,- anstatt 1099,- UVP gekostet hätte.

Und die Marktbezogen sehr kleine Zielgruppe, die über 1000,- Ocken für einen Monitor ausgeben, würde den Monitor wegen den Eigenschaften kaufen, ganz gleich ob er 100 mehr oder weniger kostet.

Das ist halt Blödsinn wenn Nvidia sagt "Mediatek Modul weil günstiger und mehr Marktverbreitung von G-Sync"...

Um mehr Marktanteil in Höhe von mindestens 20 bis 30% mehr zu bekommen, müsste Nvidia dieses angeblich so günstige Modul im Preisbereich von 200 bis 400 Euro Monitoren massiv reinbringen. Dann

würde dieses "günstiger" Gebrabbel von Nvidia Sinn machen und tatsächlich G-Sync im Markt breiter aufstellen.

Nvidia hat einfach das Bullshit Bingo angeworfen, mehr nicht und weniger auch nicht. Eine Komponente der Produktion wurde billiger gemacht. Geschieht Tausende mal am Tag.

Daraus hat Nvidia einen "riesen Schritt" und "billigere Monitore" gemacht. Und schon der erste Monitor mit Mediatek Chip erfüllt exakt nichts davon, sondern liegt wie einige andere G-Syncs auch bei 1000 und drüber.

Die Marktanteile die Nvidia "erobern und verbreitern" will gibts nicht. Die liegen somit weiter nur bei ein paar einzelnen Prozentpunkten.

@engineer123

Ich mal mir die Welt, wie sie mir gefällt.

Wenn der unten stehende Artikel richtig ist und dieser Monitor dieses Modul entsprechend gar nicht besitzt, geht deine ganze Kaffeesatzleserei erstmal wieder den Bach runter.

Der Monitor ist also so teuer in der UVP, ohne dass nVidia irgendwas damit zu tun hat.

Oder wie du es ausdrücken würdest:

Nice, voll daneben gelangt...

https://www.computerbase.de/news/mo...d-mit-480-hz-und-den-neuen-g-sync-chip.89262/

Ich mal mir die Welt, wie sie mir gefällt.

Wenn der unten stehende Artikel richtig ist und dieser Monitor dieses Modul entsprechend gar nicht besitzt, geht deine ganze Kaffeesatzleserei erstmal wieder den Bach runter.

Der Monitor ist also so teuer in der UVP, ohne dass nVidia irgendwas damit zu tun hat.

Oder wie du es ausdrücken würdest:

Nice, voll daneben gelangt...

https://www.computerbase.de/news/mo...d-mit-480-hz-und-den-neuen-g-sync-chip.89262/

engineer123

Banned

- Registriert

- Jan. 2009

- Beiträge

- 3.783

Hoebelix schrieb:@engineer123

Ich mal mir die Welt, wie sie mir gefällt.

Wenn der unten stehende Artikel richtig ist und dieser Monitor dieses Modul entsprechend gar nicht besitzt, geht deine ganze Kaffeesatzleserei erstmal wieder den Bach runter.

Der Monitor ist also so teuer in der UVP, ohne dass nVidia irgendwas damit zu tun hat.

Oder wie du es ausdrücken würdest:

Nice, voll daneben gelangt...

https://www.computerbase.de/news/mo...d-mit-480-hz-und-den-neuen-g-sync-chip.89262/

Um die Technik geht es doch gar nicht, der 480Hz OLED wäre auch ohne Mediatek Modul teuer und gut 1000 Euro in der UVP.

Es geht darum, dass Nvidia die Produktionskosten Verringerung für ihre G-Sync Technik weiterhin

in High-End Preisklassen einbaut.

Nichts mit "signifikant günstiger" und "wir wollen den G-Sync Marktanteil ausbauen".

Nochmal Zitat:

Um mehr Marktanteil in Höhe von mindestens 20 bis 30% mehr zu bekommen, müsste Nvidia dieses angeblich "so günstige" Modul im Preisbereich von 200 bis 400 Euro Monitoren massiv reinbringen.

Dann würde dieses "günstiger" Gebrabbel von Nvidia Sinn machen und

tatsächlich G-Sync im Markt breiter aufstellen.

So ist es ein Marketing Furz von Nvidia. Totaler Bullshit, weil weder der Marktanteil hoch geht, noch

an einer 1000 Euro UVP sich irgendwas ändert.

Diesen OLED Monitor hier und andere G-Sync Monitore für 600 Ocken und darüber werden sich nicht mehr und nicht weniger Personen kaufen als noch vor nem Monat.

Der G-Sync Monitor "Marktanteil" ändert sich nicht. Er bleibt weiterhin bei ein paar Prozent. Auf alle Monitore inkl. die Office Krüken sind es vielleicht nur ein paar Dezimal Zehntel Marktanteil.

Unterm Strich ist es nicht mehr als Nvidia hat eine günstigere Chipkomponente im Einkauf gefunden und macht jetzt ein Weltwunder daraus.

Du bleibst wirklich felsenfest auf deiner Kaffeesatzleserei.

Abgesehen davon dass der 480 Hz OLED ja scheinbar eben nicht diesen Mediatek Chip verbaut hat - dein Gerede darüber also einfach substanzlos ist - wurde diese Kooperation zw. nVidia und Mediatek gerade erst angekündigt.

Aber du weißt scheinbar jetzt schon, welche Monitore diesen Chip in 12, 24 oder 36 Monaten verbaut haben werden?

Deshalb meine Frage: Wo nimmst du das Wissen her?

Kaffeesatz? Hühnerknochen? Glaskugel?

Erleuchte mich

- oder nein, lassen wir es einfach...

Abgesehen davon dass der 480 Hz OLED ja scheinbar eben nicht diesen Mediatek Chip verbaut hat - dein Gerede darüber also einfach substanzlos ist - wurde diese Kooperation zw. nVidia und Mediatek gerade erst angekündigt.

Aber du weißt scheinbar jetzt schon, welche Monitore diesen Chip in 12, 24 oder 36 Monaten verbaut haben werden?

Deshalb meine Frage: Wo nimmst du das Wissen her?

Kaffeesatz? Hühnerknochen? Glaskugel?

Erleuchte mich

- oder nein, lassen wir es einfach...