Wenn dich die Geschwindigkeit nicht stört, könntest du auch das 32b Modell testen. Wie es ist, wenn mehr als die Hälfte vom Modell im RAM steckt, weiß ich natürlich nicht.WildKätzchen schrieb:Ja, also so schnell braucht es für mich nicht sein. So schnell kann ich gar nicht lesen.

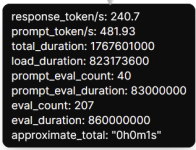

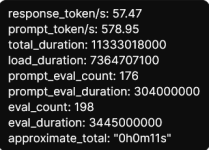

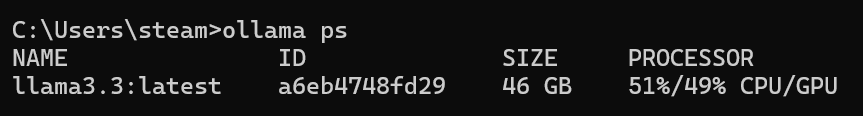

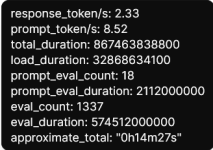

Um das mal mit Zahlen zu unterlegen. Ich habe seine Frage mal im 32b Modell eingegeben und die Antwort hat 36,44 Sekunden gedauert.

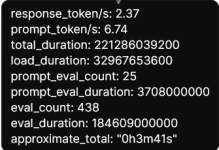

Bei ihm bricht er nach einer Minuten ab und das Modell ist noch beim "think".

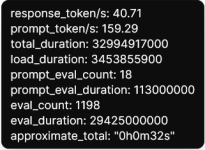

Ich habe dann dieselbe Frage beim 70b Modell eingegeben und dort hat die Antwort (die ist auch etwas kürzer als beim 32b) 4 Minuten und 19 Sekunden gedauert. Wie man sieht, ist das ein deutlicher Unterschied.