I'm unknown

Rear Admiral

- Registriert

- Feb. 2005

- Beiträge

- 5.508

Hallo zusammen,

für den Lesertest der Crucial P5 bin ich auf ein Luxusproblem gestoßen: Ich kann mit dd von der Samsung 970 Evo+ 1TB nicht mit mehr als 1,9 bis 2,1 GB (nicht GiB) pro Sekunde lesen.

System: Ubuntu 21.04 mit Live-USB-Stick, Asus Crosshair Hero VI, 3700X, 3200er RAM (4x16 GiB) und Samsung 970 Evo + im NVME-Slot vom Board per PCIe 3.0 x4 angebunden.

iostat zeigt dabei dieselben plausiblen Werte an:

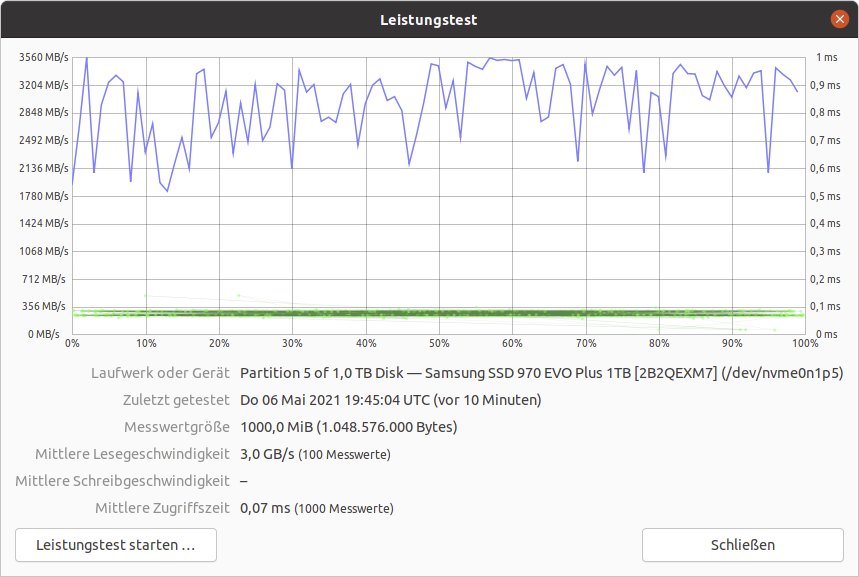

Die Anbindung funktioniert jedoch, der integrierte Disk Benchmark kann auf Dateisystemebene deutlich schneller lesen:

iostat ist ebenfalls plausiebel zu den gezeigten Werten:

Ebenfalls liegt kein generelles Performanceproblem mit dem System vor:

Und auch die Werte der 850 Evo 1TB passen mit dd:

Für Hinweise warum dd in ein hartes Limit läuft wäre ich dankbar, sonst kann ich den Schreibcache der Crucial SSD nicht voll auslasten und die Ergebnisse sind wertlos.

für den Lesertest der Crucial P5 bin ich auf ein Luxusproblem gestoßen: Ich kann mit dd von der Samsung 970 Evo+ 1TB nicht mit mehr als 1,9 bis 2,1 GB (nicht GiB) pro Sekunde lesen.

System: Ubuntu 21.04 mit Live-USB-Stick, Asus Crosshair Hero VI, 3700X, 3200er RAM (4x16 GiB) und Samsung 970 Evo + im NVME-Slot vom Board per PCIe 3.0 x4 angebunden.

Code:

ubuntu@ubuntu:~$ sudo dd if=/dev/nvme0n1 of=/dev/null bs=1M count=10000

10000+0 Datensätze ein

10000+0 Datensätze aus

10485760000 Bytes (10 GB, 9,8 GiB) kopiert, 5,99427 s, 1,7 GB/siostat zeigt dabei dieselben plausiblen Werte an:

Code:

Linux 5.11.0-16-generic (ubuntu) 06.05.2021 _x86_64_ (16 CPU)

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 91,19 57380,22 0,00 0,00 10306634 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 928,00 633344,00 0,00 0,00 633344 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2519,00 1719296,00 0,00 0,00 1719296 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2541,00 1734656,00 0,00 0,00 1734656 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2560,00 1747968,00 0,00 0,00 1747968 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2648,00 1807360,00 0,00 0,00 1807360 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2633,00 1797632,00 0,00 0,00 1797632 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 1173,00 800768,00 0,00 0,00 800768 0 0Die Anbindung funktioniert jedoch, der integrierte Disk Benchmark kann auf Dateisystemebene deutlich schneller lesen:

iostat ist ebenfalls plausiebel zu den gezeigten Werten:

Code:

ubuntu@ubuntu:~$ sudo iostat nvme0n1 -d 1

Linux 5.11.0-16-generic (ubuntu) 06.05.2021 _x86_64_ (16 CPU)

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 132,84 86977,90 0,00 0,00 20547658 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 1084,00 1380748,00 0,00 0,00 1380748 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2057,00 2625288,00 0,00 0,00 2625288 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2365,00 3015692,00 0,00 0,00 3015692 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 1911,00 2434572,00 0,00 0,00 2434572 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2063,00 2632968,00 0,00 0,00 2632968 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 1482,00 1889288,00 0,00 0,00 1889288 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 1729,00 2205448,00 0,00 0,00 2205448 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2035,00 2593292,00 0,00 0,00 2593292 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2136,00 2726788,00 0,00 0,00 2726788 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2068,00 2635152,00 0,00 0,00 2635152 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2099,00 2675212,00 0,00 0,00 2675212 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2167,00 2766088,00 0,00 0,00 2766088 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2033,00 2590732,00 0,00 0,00 2590732 0 0

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd

nvme0n1 2397,00 3056652,00 0,00 0,00 3056652 0 0Ebenfalls liegt kein generelles Performanceproblem mit dem System vor:

Code:

ubuntu@ubuntu:~$ sudo dd if=/dev/zero of=/dev/null bs=1M count=10000

10000+0 Datensätze ein

10000+0 Datensätze aus

10485760000 Bytes (10 GB, 9,8 GiB) kopiert, 0,406004 s, 25,8 GB/sUnd auch die Werte der 850 Evo 1TB passen mit dd:

Code:

ubuntu@ubuntu:~$ sudo dd if=/dev/sda of=/dev/null bs=1M count=10000

10000+0 Datensätze ein

10000+0 Datensätze aus

10485760000 Bytes (10 GB, 9,8 GiB) kopiert, 21,3434 s, 491 MB/sFür Hinweise warum dd in ein hartes Limit läuft wäre ich dankbar, sonst kann ich den Schreibcache der Crucial SSD nicht voll auslasten und die Ergebnisse sind wertlos.