yast

Lt. Commander

- Registriert

- Mai 2013

- Beiträge

- 1.790

Precide schrieb:-Wird als VR-Karte angepriesen

-Besitzt 1x HDMI

1. DP hat mehr Bandbreite

2. Die Vive hat z.B DP

3. reicht ein einfacher Adapter

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

Precide schrieb:-Wird als VR-Karte angepriesen

-Besitzt 1x HDMI

xeonking schrieb:daher wird es wohl partner-karten mit dvi geben. ich sehe auch kein grund weshalb man von amd seite aus noch dvi mit verbauen sollte,da reicht ein adapter locker aus. und wenn die monitore noch kein dp haben,ist oft zumindest hdmi verbaut.

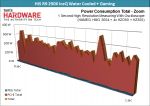

edit: und die 100watt verbrauch unter last sind auch interessant, da ist noch ein wenig luft zum übertakten,selbst ohne weiteren 6/8 pin!

gruß

Ok, danke für den Hinweis!9t3ndo schrieb:FreeSync geht nur über DP, da es auf dem DP Standard Adaptive Sync aufbaut, wenn ich das noch richtig im Kopf habe.

9t3ndo schrieb:Evtl. weil so langsam HDMI 2.0a in allen Geräten ankommt, welches einfach genug Bandbreite bietet?

noxon schrieb:Was ist das denn für eine professionelle Temperaturmessung?

BookerDeWitt schrieb:Nur 100W Verbrauch? Aber die Karte hat doch eine 150W TDP? Da gab es doch ein paar Experten, die aus 75W PCI-E und 75W vom 6Pin von einem 24/7 Realverbrauch von 150W geredet haben, natürlich untermauert von anderen Werten, sowie dem großartigem Verlgeich von NVidias Board-Design-Power und AMDs TDP.

Auf die famose Idee, dass die Karte keine 150W verbrauchen kann, da sie sonst außerhalb der Spezifikationen arbeitet sind diese Experten auch nicht gekommen, denn schließlich passt dies nicht gut in die Bashing-Argumentation, dass die Karte nur ähnliche Werte wie eine 970 erreicht und AMD ja eh tot ist, da sie die Leistung der 1080 nicht erreichen können (selbst wenn sie immer noch ~100mm^2 Puffer haben um erst einmal einen Die in der Größe des GP104 zu erreichen).

BookerDeWitt schrieb:Da ist ja schon der erste.

guy47 schrieb:Wo sind die Indizien zu den Preisen? Hab ich was übersehen?

MichaG schrieb:Ich wollte noch was zu den Preisen schreiben, aber da tappen alle noch im Dunkeln. Daher habe ich es gelassen, aber in der Einleitung vergessen.