Das hab ich doch geschrieben?... - lieber ein paar mehr automatisierte Writes als schlechte Performance.massaker schrieb:Naja, im Idealfall sollte aber nicht der User selbst mühsam dagegen ankämpfen, sondern die Firmware entsprechende automatische Pflege-Routinen beinhalten/durchführen.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Readspeed degradation 2022 kein Thema mehr ? Von wegen ! MP510 -> 14MB/s ! 980pro auch nicht ohne Probleme...

- Ersteller BigKid1973

- Erstellt am

Salierfähig

Lt. Junior Grade

- Registriert

- Juni 2020

- Beiträge

- 353

"Unsere SSD Spezialisten..." Ah ja. Und wo waren diese die ganze Zeit? Schließlich existiert die KC3000 jetzt schon 2 Jahre lang. Und wo wären die Spezialisten gewesen ohne die Beschwerden von Kunden? Genau - nirgendswo!

Du hast die Tragweite wohl nicht ganz erfaßt. Muß ich dann nun alle paar Wochen alles neu kopieren, sprich Windows, Apps, Anwendungsprogramme, Spiele, damit diese wieder in den Zellen erneuert werden? Ansonsten hätte ich doch den Effekt, daß Programme, die lange nicht verändert wurden (nicht neu geladen oder so), und die ich regelmäßig pro Woche starte, irgendwann langsamer laufen. Man überlege die Konsequenzen, wenn man große Dateien und Bibliotheken hat in Form von Plugins und Audiodaten bei DAWs, wo diese mal pro Plugin 10-50 GB und mehr groß sind, Audio- und Videoprojekte, die durchaus mal ein paar Wochen oder Monate rumliegen können, bevor man weiter daran arbeitet. All das muß man wieder neu hinkopieren, um volle Performance zu erhalten und nicht mit 15-18 MB/s abgespeist zu werden. Da wäre sogar eine Festplatte an der Stelle wieder schneller.Rickmer schrieb:Das sehe ich nicht als Problem bei Geräten, deren Write-Endurance u.A. auch in DWPD (Drive Writes Per Day) gemessen wird...

Das heißt, ich muß komplett die SSD sichern (2-4TB), und wieder zurücksichern. Das dauert mit einer HDD locker mal 1-2 Tage, wenn die SSDs voll sind, und genauso lange dauert die Rücksicherung.

Das halte ich für nicht praktikabel. Da werde ich dann wohl gegen eine Samsung 990 Pro tauschen müssen, und das 3x.

Stormfirebird

Admiral

- Registriert

- Sep. 2012

- Beiträge

- 9.544

Immerhin akzeptiert man scheinbar dass es ein Problem ist, anders als bei WD.Salierfähig schrieb:"Unsere SSD Spezialisten..."

Ärgerlich dass bei mir auch eine KC3000 werkelt von der ich dachte dass sie nicht so stark betroffen wäre, zu einem gewissen Grad haben das ja praktisch die meisten ab TLC.

Es gibt Programme die das inplace neu schreiben und alle paar Wochen ist auch quatsch.dv1996 schrieb:Das heißt, ich muß komplett die SSD sichern (2-4TB), und wieder zurücksichern.

Samsung ist sowieso auch nicht unberührt von dem ganzen.

Du hast mich nicht verstanden.dv1996 schrieb:Du hast die Tragweite wohl nicht ganz erfaßt. Muß ich dann nun alle paar Wochen alles neu kopieren, sprich Windows, Apps, Anwendungsprogramme, Spiele, damit diese wieder in den Zellen erneuert werden?

Ich bin voll dafür, dass dieses Refresh direkt durch den Controller der SSD gemanaged und durchgeführt wird, idealerweise wenn dieser grade nicht viel zu tun hat.

Den entsprechenden Overhead an Writes bin ich gerne bereit zu akzeptieren.

Selbst wenn die SSD dann im Schnitt alle 3 Monate ihren kompletten Inhalt einmal neu schreibt wäre mir spontan keine SSD bekannt, die das nicht (auf Basis ihrer TBW) 50+ Jahre durchhält.

Andersrum gerechnet: Auf eine Betriebsdauer von 10 Jahren würde der Overhead maximal 20% der gesamt-TBW verbrauchen. Bei den hochwertigen SSDs deutlich weniger.

(Und die wenigen Budget SSDs für die das ein Problem sein könnte werden eh nie einen Controller bekommen, der zu sowas fähig ist. Das ist ja ein zusätzliches Feature, das kostet Geld.)

Es ist wirklich ärgerlich, dass ein bald ein Jahrzehnt altes Problem von Samsung jetzt auf breiter Front wieder hochkocht. Dass die Lebensdauer bei einem Refresh alle paar Monate so gut wie gar nicht leidet, lässt sich ja leicht errechnen. Was nicht zumutbar ist, ist eine manuelle Pflege mit irgendwelchen Drittprogrammen.

Wie hier schon paarmal erwähnt (und für mich ist das auch logisch), ist die Einheit "Zeit" keine valide Metrik für einen Refreshalgorithmus. Aber ja, ich bin ganz bei euch. Es sollten keine externen Diskrefresh-Programme notwendig sein. Ich nehme auch gern einen erhöhten Löschzyklen-Verbrauch in Kauf. Die maximal zulässigen PBW/TBW sind mittlerweile so hoch, dass es keine Rolle spielt. Ich hab lieber eine ordentliche Leseperformance und wenn die SSD anstatt 20Jahre nur noch 18Jahre hält, juckt mich das kein bisschen. Meine Intel Postville G2 ist jetzt im 14. Lebensjahr und der Rechner ist 5/7 Tagen aktiv. Meine 1TB 840Evo funktioniert mit der neuesten Firmware wunderbar. Es geht also.

nazgul77

Lieutenant

- Registriert

- Feb. 2006

- Beiträge

- 847

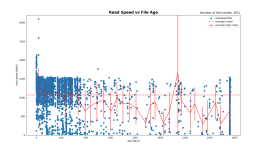

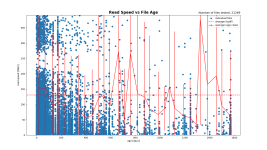

Hier Mal eien NVMe MP510 , ca 3 Jahre alt.

Getestet mit Linux SSD Reader

Der nimmt nicht zufällig Dateien, sondern deterministisch alles mit einer eingestellten Suchtiefe in der Orderstruktur.

Ein Refresh durch Kopieren/Datenrücksicherung habe ich noch nicht gemacht.

Tue mich etwas schwer das Ergebnis zu deuten, aber katastrophal sieht das nicht aus. Die ältesten Daten sind jetzt nicht eindeutig langsamer lesbar.

Getestet mit Linux SSD Reader

Der nimmt nicht zufällig Dateien, sondern deterministisch alles mit einer eingestellten Suchtiefe in der Orderstruktur.

Ein Refresh durch Kopieren/Datenrücksicherung habe ich noch nicht gemacht.

Tue mich etwas schwer das Ergebnis zu deuten, aber katastrophal sieht das nicht aus. Die ältesten Daten sind jetzt nicht eindeutig langsamer lesbar.