H

HierGibtsNichts

Gast

Guten Abend an Alle AMD GPU User die weiterhin einen hohen Idle Stromverbrauch haben.

Diesen Workaround hat der YTber Ancient Gameplays in seinem neusten Video als erstes publiziert. Er macht im Moment die Runde in den Hardwareforen und da ich ihn hier noch nicht entdeckt habe, wollte ich das nachholen.

Ihr nutzt eine Option aus dem Adrenalin GPU Treiber, zu finden unter Einstellungen - Display-Benutzerdefinierte Auflösung (engl. Custom Resolution)

Ihr erstellt eine neue Benutzerdefinierte Auflösung mit den exakt gleichen Werten welche euer Monitor nativ nutzt.

Mit der Ausnahme das ihr eure Hz Frequenz bei 144hz Monitoren zum Beispiel auf 142 Hz begrenzt. Beim Timing Standard wählt ihr "CVT" aus, sollte diese Option nicht funktionieren könntz ihr "CVT Reduced Blanking" auswählen oder ihr müsst mit den Hertz eures Monitors weiter

runtergehen 140, 120, 100 usw. bis er die normale CVT Option zulässt.

Danach klickt ihr die neu erstellte Auflösung 1x im Treiber an.

Nun müsst ihr diese nur noch in den Windows Monitor Einstellungen auswählen.

Für Multi Monitor Setups und hohen Idle Powerdraw durch Multi Monitot

Bei den anderen Monitoren eures Setup verfahrt ihr genauso hier reduziert ihr die Hertz auf 60,75,85,100hz solange bis ihr im Fenster Powerdraw des Treibers einen deutlichen Abfallfall der Wattzahl im Idle feststellt. Auf einem Zweit oder Drittmonitor sollte für die Meisten eine niedrigere Hertz verschmerzbar sein.

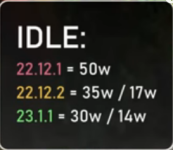

Das Prozedere hat bei mir jeweils bei eine 7900XTX und einer 6750XT mit jeweils Dual und Triple Monitor Setup zu einer deutlichen Senkung des Idle Powerdraw geführt.

28-32W bei der 6750XT, 40-50W bei der 7900er Karte.

Im Video ist alles sehr gut erklärt und gezeigt. Es ist absolut kein Hexenwert und hilft stromspare.

Wichtige Anmerkung : CVT funktioniert bei Wenigen Monitoren erst unterhalb/ab von ca. 100/118 Hz darüber muss man bei diesen Monitoren auf CVT Reduced Blanking zurückgreifen. Bitte beachtet aber das bei dieser Option ihr den Monitor etwas außerhalb der Herstellerspezfikation betreibt! Bei manchen Monitoren wird je nach Panel die Farbtiefe auf 6bit reduziert (meist bei 1080p TN Panels) solange ihr nur das Übliche wie Office, YT/Twitch, Gaming etc. mit dem Monitor macht sollte euch das nicht stören.

Wenn ihr Foto/Videobearbeitung nutzt dann müsst ihr auf diesen Workaround mit diesem/eurem speziellen Monitor dann leider verzichten.

Ich hoffe dem Ein oder Andere hilft dieser Workaround, so wie Mir und man kann etwas Stromsparen.

Diesen Workaround hat der YTber Ancient Gameplays in seinem neusten Video als erstes publiziert. Er macht im Moment die Runde in den Hardwareforen und da ich ihn hier noch nicht entdeckt habe, wollte ich das nachholen.

Ihr nutzt eine Option aus dem Adrenalin GPU Treiber, zu finden unter Einstellungen - Display-Benutzerdefinierte Auflösung (engl. Custom Resolution)

Ihr erstellt eine neue Benutzerdefinierte Auflösung mit den exakt gleichen Werten welche euer Monitor nativ nutzt.

Mit der Ausnahme das ihr eure Hz Frequenz bei 144hz Monitoren zum Beispiel auf 142 Hz begrenzt. Beim Timing Standard wählt ihr "CVT" aus, sollte diese Option nicht funktionieren könntz ihr "CVT Reduced Blanking" auswählen oder ihr müsst mit den Hertz eures Monitors weiter

runtergehen 140, 120, 100 usw. bis er die normale CVT Option zulässt.

Danach klickt ihr die neu erstellte Auflösung 1x im Treiber an.

Nun müsst ihr diese nur noch in den Windows Monitor Einstellungen auswählen.

Für Multi Monitor Setups und hohen Idle Powerdraw durch Multi Monitot

Bei den anderen Monitoren eures Setup verfahrt ihr genauso hier reduziert ihr die Hertz auf 60,75,85,100hz solange bis ihr im Fenster Powerdraw des Treibers einen deutlichen Abfallfall der Wattzahl im Idle feststellt. Auf einem Zweit oder Drittmonitor sollte für die Meisten eine niedrigere Hertz verschmerzbar sein.

Das Prozedere hat bei mir jeweils bei eine 7900XTX und einer 6750XT mit jeweils Dual und Triple Monitor Setup zu einer deutlichen Senkung des Idle Powerdraw geführt.

28-32W bei der 6750XT, 40-50W bei der 7900er Karte.

Im Video ist alles sehr gut erklärt und gezeigt. Es ist absolut kein Hexenwert und hilft stromspare.

Wichtige Anmerkung : CVT funktioniert bei Wenigen Monitoren erst unterhalb/ab von ca. 100/118 Hz darüber muss man bei diesen Monitoren auf CVT Reduced Blanking zurückgreifen. Bitte beachtet aber das bei dieser Option ihr den Monitor etwas außerhalb der Herstellerspezfikation betreibt! Bei manchen Monitoren wird je nach Panel die Farbtiefe auf 6bit reduziert (meist bei 1080p TN Panels) solange ihr nur das Übliche wie Office, YT/Twitch, Gaming etc. mit dem Monitor macht sollte euch das nicht stören.

Wenn ihr Foto/Videobearbeitung nutzt dann müsst ihr auf diesen Workaround mit diesem/eurem speziellen Monitor dann leider verzichten.

Ich hoffe dem Ein oder Andere hilft dieser Workaround, so wie Mir und man kann etwas Stromsparen.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Zuletzt bearbeitet von einem Moderator: