filisnhrnsn schrieb:

Ist die so klein, weil da nur 2-Bit-MLC zum Einsatz kommt? Die meisten aktuellen SSDs haben doch 3-Bit-MLC. Klingt für mich so, als ob das Produkt auf veralteter Technik basiert. Was will man denn mit so einer kleinen SSD?

Für mich klingt es so, dass Du von NANDs und SSDs absolut Null Ahnung hast, denn TLC bringt nur einen Kostenvorteil, technisch ab nur Nachteile, denn es ist weniger haltbar und langsamer zu beschreiben als MLC NAND. Zumindest Samsungs 3D V-NAND ist aber wegen dessen großen Zellen schon den 2D MLC NANDs in 15/16nm durchaus ebenbürtig, wie die 3D NANDs der anderen Anbieter sein werden, wird man sehen, aber es reicht eben auch nicht nur auf die Anzahl der Bits pro Zelle zu schauen und wenn hier etwas altmodisch ist, dann eben die Verwendung von planaren NANDs, nur hat bisher außer Samsung noch kein Hersteller seine 3D NAND serienreif, auch wenn von Intel nun bald die ersten SSDs mit 3D NANDs kommen sollten und damit der nächste Anbieter 3D NANDs auf den Markt bringt,

fast 3 Jahre nach Samsung!

filisnhrnsn schrieb:

Nein, der nächste Sprung wird wohl offensichtlich deutlich größer sein als der letzte.

Ob wir einen Sprung noch einmal sehen werden, wird man abwarten müssen, denn die Latenzen sind entscheidend und die 4k bei QD1 sind bei HDDs gerade mal bei wenigen MB/s, bei guten SSDs bei bis zu 50MB/s oder leicht darüber und wären die Messung bei Benchmarks wie AS-SSD oder CDM nicht nur über 1GB sondern die volle Kapazität, so wären der Wert bei HDDs noch mal deutlich schlechter.

Die erste

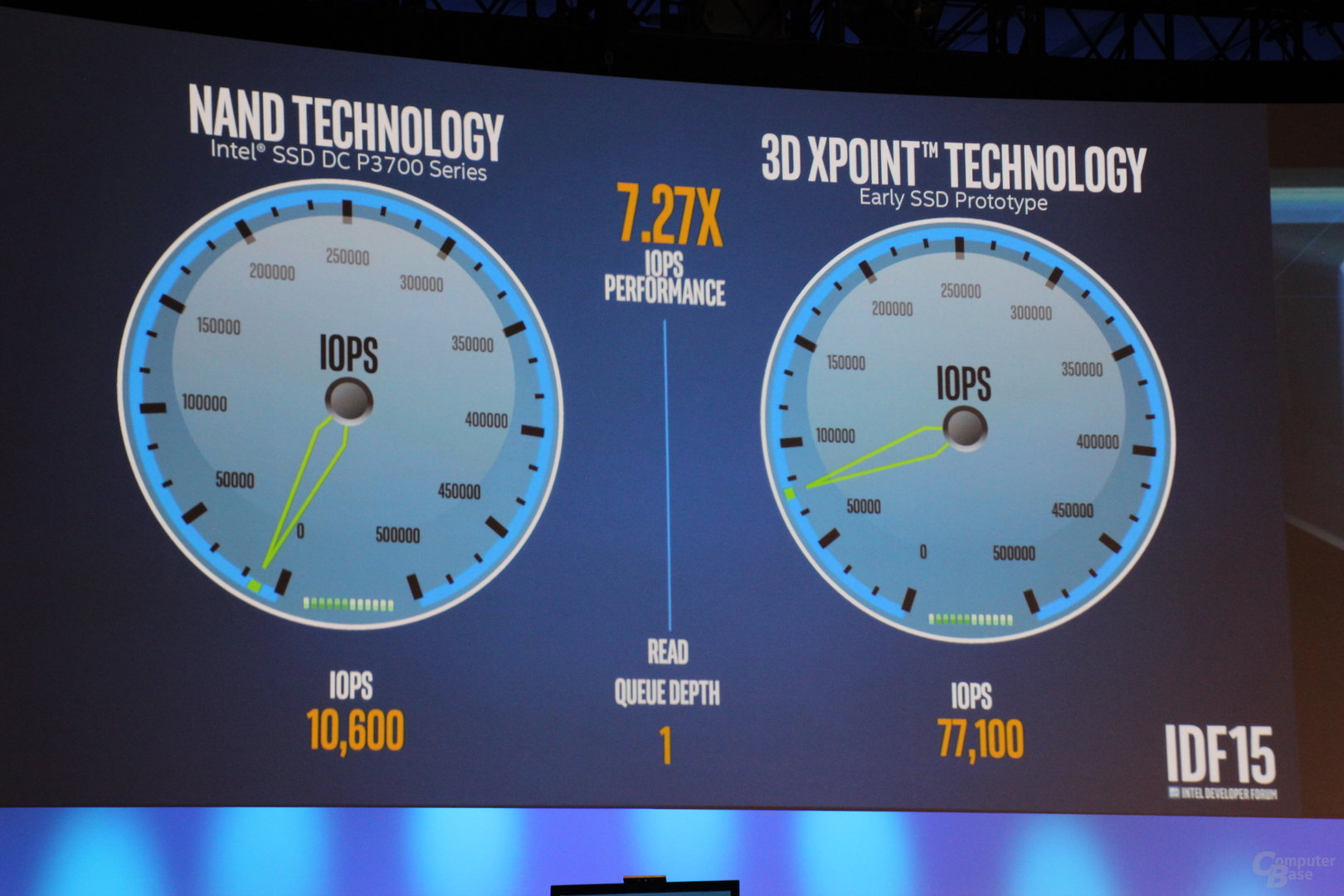

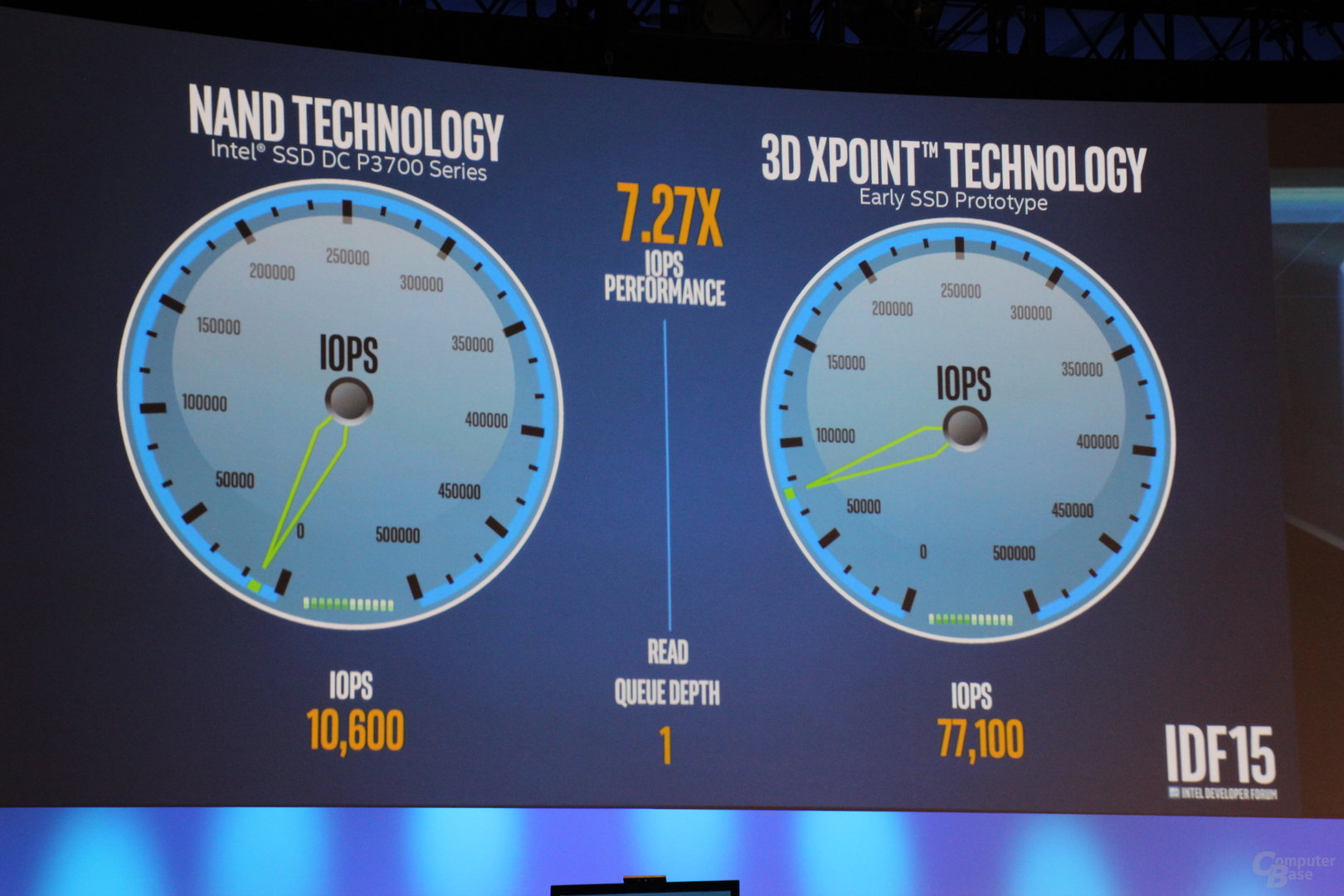

Prototypen SSD mit dem 3D Point hat aber immerhin über 300MB/s bei 4k QD1 geschafft und davon merkt ein Heimanwender am meisten, die maximalen IOPS bei extrem hohen QD sind dagegen irrelevant, denn so viele parallele Zugriffe gibt es nur bei Enterpriseanwendungen.

filisnhrnsn schrieb:

Ne SATA HDD hat ja vor den SSDs so ca 150 MB/s geschafft. Ne SATA SSD schafft kein 600 MB/s. Das ist weniger als Faktor 4.

Das ist für die meisten Anwendungen sowas von egal und dann schaffen die HDDs und SSDs solche Werte auch nur bei langen sequentiellen Zugriffen und die PCIe SSDs (egal in welchem Formfaktor) brauchen noch längere Zugriffe und wie man sieht scheint da Windows gar nicht so lange Zugriffe zu ermöglichen, denn CDM hat seit der 5er Version extra einen Test mit 128k QD32 und nur dort werden bei so schnellen PCIe SSDs überhaupt die maximale Transferraten erzielt. Aber in der Praxis kommen solche extrem lange Zugriffe eher selten vor, außer man macht z.B. Videoschnitt auf Rohmaterial und dann braucht man immer noch eine zweite SSD die die Daten so schneller liefern bzw. schreiben kann.

filisnhrnsn schrieb:

Wenn es bald SSDs gibt, die nicht auf uralten NANDs basieren, sondern auf aktuellen Technologien wie z.B. Intels 3D XPoint, dann ist ein Geschwindigkeitszuwachs um Faktor 1000 zu erwarten.

Erstes ist 3D XPoint noch Zukunftsmusik, die gibt es noch nicht zu kaufen und damit kann man sie auch noch nicht als aktuelle sondern nur als zukünftige Technologie bezeichnen. Dann ist ein Faktor 1000 total übertrieben, zumindest wenn man die klassische Anbindung über PCIe betrachtet und sie nicht in die Slots der RAM Riegel packt. Intel selbst hat beim frühen Prototyp einen Faktor von bestenfalls 7.27 gezeigt:

jodd schrieb:

(hoffentlich recht zügig)

Ist nicht zu erwarten.

Da wäre ich mir nicht so sicher, denn PCIe SSDs müssen nicht immer solche Leistungsmonster sein wie die hier bisher getesteten SSDs. PCIe wird SATA auch am anderen Ende der Skala ablösen,

schau Dir den Marvell 88NV1140 an, der zielt einen PCIe x1 Controller mit 2 Kanälen und Techniken um das RAM des Rechner statt eines eigenen Caches als Cache zu nutzen, doch klar auf das Ultra-Budget Segment für kompakte Mobilgeräte und da kann man sich dann auch gleich den SATA Host Controller sparen, den ja auch einige SoC für diese Segment schon gar nicht mehr enthalten.

TenDance schrieb:

Davon abgesehen ist die Frage ob man von PCIe booten kann immer noch recht spannend. Plug'n Play hat dieses Segment noch nicht erreicht.

Probleme gibt es vor allem auf alten Plattformen, aber sowas ist ja nicht neu und Kompatibilität verspricht eben nur, dass es irgendwie funktioniert, nicht aber das man die volle Performance bekommt und alle Feature nutzen kann. Außerdem haben mache ihre negativen Erfahrungen auch mit OEM SSDs gemacht die kein Option-ROM haben und auch nie dafür gedacht waren in deren Rechnern zu landen.

TenDance schrieb:

Persönlich empfinde ich M.2 sowie PCIe-SSDs immer noch als Notlösung.

M.2 kann SATA oder PCIe sein, Du solltest schon präziser sein was Du da genau meinst und wieso bzw. wofür sollte eine PCIe SSDs, egal in welchem Formfaktor eine Notlösung sein?

TenDance schrieb:

Ich brauche meine PCIe-Steckplätze eigentlich für andere Dinge

Dann hat dein Board vielleicht zu wenige PCIe Slots und selbst wenn nicht, musst Du Dich eben entscheiden für was Du diese nutzt. Die I/O Bandbreite einer Plattform wird immer beschränkt bleiben und sehr viele solcher PCIe SSDs kann man dort eben nicht unterbringen.

TenDance schrieb:

M.2 ist ohnehin das letzte.

Wieso? Für Desktops ist es im Grunde genauso fehl am Platz wie mSATA da es eigentlich für Notebooks und Rechner mit ähnlich kompakten Gehäusen gedacht war, aber die Kunden wollen es eben haben. U.2 wäre für den Desktop passender und wird sich hoffentlich durchsetzen.

TenDance schrieb:

Sich ohnehin schon thermisch am Limit befindliche Steckkarten auf die Rückseite des mainboards verpflanzen oder unter die GPU, wo sie zusätzlich beheizt werden

Also meine Graka scheint meine 950 Pro eher zu kühlen als zu erhitzen, aber es ist ja nicht die Schuld der Erfinder des Formfaktors wenn die Hersteller der Geräte die Slots dann so ungünstig positionieren, dass dann auch die SSDs thermisch am Limit sind.

TenDance schrieb:

U.2 ist auch nur ein Kompromiss, aber wenigstens ein Anfang.

In welcher Hinsicht ist das nun bitte nur ein Kompromiss? Weil auch wieder nur 4 PCIe Lanes möglich sind oder was?

TenDance schrieb:

Wenn ich raten müsste würde ich sagen dass wir auf Basis der Thunderbolt-Technologie interne optische Anschlüsse an den Bus bekommen.

TB ist auch nur auf PCIe basiert und optische Anschlüsse sind für Consumer HW viel zu teuer, die werden sich so bald wohl nicht durchsetzen lassen.

TenDance schrieb:

Bis dahin hoffe ich mal dass SATAexpress Verwendung im Massenmarkt findet.

Blos nicht, SATA Express hat sich überlebt bevor die ersten Laufwerke dafür auf den Markt gekommen sind und da es nur maximal 2 PCIe Lanes unterstützt und garantiert immer 2 SATA Ports kostet, ist das auch sehr gut so. U.2 ist die viel bessere Alternative und war ja auch von Anfang an als SFF-8639 als die Alternative zu SATA Express für Enterprise Anwendungen geplant, nun wird es hoffentlich das Consumersegment erobern.

TenDance schrieb:

Jedes mainboard hat die Anschlüsse und irgendwann werden die Hersteller rausfinden dass das ein Thema ist mit dem man sich von der Masse der im SATA-Limit hängenden SSDs abheben kann ohne massive Kosten zu verursachen.

Nur braucht man dafür einen PCIe SSD Controller und da gibt es eben einmal die mit einer PCIe Lane wie eben den 88NV1140 und die dicken Monster mit PCIe 3.0 x4 und die würden mit nur 2 Lanes am limitiert aber nicht billiger sein als wenn man der SSD den U.2 Anschluss mit 4 Lanes gönnt. Wo soll also SATA Express da je Sinn machen?

TenDance schrieb:

Wie gesagt, über kurz oder lang wird vermutlich USB3.1/Alpine Ridge die Basis für so etwas. Vor allem wenn der Sprung auf optische Leitungen gelingt. Direkte PCIe-Anbindung, kurze Latenzen, hohe Bandbreiten, schmale und flexible Kabel

Was sollte das bitte für interne Geräte bringen? Optische Anbindung kostet viel Geld und die Latenzen werden wegen der Umwandlung zwischen elektrischen und optischen Signale doch nur schlechter und wenn die PCIe Lanes über den Alpine Ridge statt direkt an die SSD doch auch. Optische Übertragung lohnt sich nur über lange Distanzen, PCIe hat man heute ja auch schon bei allen hier getesteten SSDs und die Bandbreite ist nur eine Frage davon wie viele Lanes man nutzt, bis TB alle maximal 16 Lanes eines Slots überbietet, wird es wohl noch eine Weile dauern, also kann ich echt keinen der Vorteile erkennen die Du da zu sehen glaubst.

strex schrieb:

Die meiste Hitze kommt auch vom SoC..das hat schon die c't im Test der 950 Pro per Wärmebild gezeigt.

Eben und da nun die ersten Phison E7 mit einem Kühlkörper und im Add-In-Card Formfaktor kommen und nicht im M.2 Formfaktor, scheint mir trotz der 28nm Fertigung die Energieeffizienz der Controller der Grund zu sein, warum noch niemand eine M.2 PCIe SSD mit der Leistung einer 950 Pro gebracht hat. Ich wette das Samsung der Controller der SM951 und 950 in 14nm fertigt, die haben den Prozess ja schon zu der Zeit gehabt und damit ARM CPUs für Smartphone gebaut und da deren SSD Controller ebenfalls auf ARM Kernen basieren, dürfte es ein leichtes gewesen sein auch diese im neuen 14nm Prozess zu fertigen. Daher wird so bald keiner nachziehen, solange die alle noch keinen Fertiger haben der ihnen ihre PCIe 3.0 x4 Controller ebenfalls in einen 1x Prozess herstellt.

filisnhrnsn schrieb:

Die Latenzen von 3D XPoint sind übrigens im zweistelligen Nanosekundenbereich...

Nur nutzt das alleine ja nichts, die Daten müssen ja auch von dem Speicher ins RAM, wenn man das für eine normale SSD verwendet und da ist dann auch noch ein Controller dazwischen. Also kommt am Ende nur ein Faktor von 7,27 raus, was sich sicher noch steigern lässt, aber eben weit unter dem bleibt, was das 3D XPoint dem NAND bzgl. der Latenz überlegen ist. Dann bleibt noch die Frage wie viel die Anwendungen am Ende davon profitieren, die CPUs müssen die Daten ja auch verarbeiten um die Bandbreite des Speichermedium überhaupt auslasten zu können und das sogar zweimal, einmal in der Anwendung und dann noch mal im I/O Subsystem!

h00bi schrieb:

Wurde doch eigentlich ausgiebig diskutiert dass das kein "Problem" ist sondern working as intended. Niemand kann was dafür wenn die Software FUA Befehle schickt außer der Software.

Also Moment mal, die Anwendung selbst schickt nur ein fsync() und der Treiber macht dann daraus die FUA Befehlen für die NVMe SSDs. Da sollte Microsoft es beim Treiber analog zum Verhalten beim AHCI Treiber halten und das passiert eben nicht. Nimmt man den oberen Haken raus, so verhalten sich normale SATA SSDs so wie die NVMe SSDs selbst wenn der obere Haken gesetzt ist und erst wenn man beide setzt, verhalten sich die NVMe SSDs wie erwartet, dabei dürften sie ihren internen Schreibcache ja eigentlich schon nutzen, wenn nur der obere Haken gesetzt ist.

Die Ursache für den Bug dürfte sein, dass es zuerst ja nur die NVMe SSDs von Intel gab, aber die haben als Enterprise SSDs mit Full-Power-Loss-Protection natürlich auch das Recht solche FUA Befehle zu ignorieren (sync-faking) und daher macht es denen auch von der Performance her nichts aus den Microsoft stornvme Treiber zu verwenden. Nur haben eben Consumer SSD in aller Regel keine Full-Power-Loss-Protection, nur die Intel 730 und 750 haben die, auch wenn andere trotzdem sync-faking machen.

drSeehas schrieb:

MLC oder TLC alleine sagt wenig aus, viel wichtiger ist welche konkreten NANDs es sind.

drSeehas schrieb:

Mir würden auch 120 GB reichen, wenn die nicht überproportional teurer wären.

Damit bekommt man dann aber zu wenig Performance hin und bei den nicht so billigen Controllern wäre die SSD im Verhältnis viel zu teuer, so wie schon jetzt die meisten 120/128GB SSD viel zu teuer im Vergleich zu den Modellen mit mehr Kapazität sind. Außerdem sind 120GB für ein Windows mit Programme und vielleicht noch ein paar aktuellen Daten doch schon eher knapp.

Trambahner schrieb:

Und genau wg. dem Treiberdebakel ist Intels 750 immer noch die NVMe-SSD der Wahl.

Mit dem Samsung Treiber gibt es auch keine Probleme mit den M.2 PCIe NVMe SSDs von Samsung, da sehe ich jetzt nur SSDs im Nachteil, für die es eben keinen eigenen Treiber gibt.

Trambahner schrieb:

Da sie der Datacenter-Serie entstammt, ist der Treibersupport einfach einfach besser und vielfältiger.

S.o., der Grund warum den Intel NVMe SSDs die FUA Befehle egal ist, ist eben deren Full-Power-Loss-Protection und die haben sie eben, weil sie Datacenter SSDs sind. Vorteile beim Treibersupport dürfte aber das eher für Server-OS bedeuten als für normale Windowsversionen.

Übrigens scheint der Phison E7 durchaus auch für Full-Power-Loss-Protection vorbereitet zu sein, nur wurden die Kondensatoren eben nicht bestückt, wie man an den freien Plätze auf der Platine sehen kann.

Im

Datenblatt sind übrigerns 3000 P/E Zyklen, 698TBW und 3 Jahre Garantie angegeben, was für eine WA von 2,2 sprechen würde.

Aber auch die Zotac Sonix weiß zu beeindrucken. Die Marke von 100.000 IOPS durchbricht die SSD zwar nicht, dafür liefert sie zwei Minuten lang mehr als 90.000 IOPS, was eine Samsung 950 Pro lange nicht erreicht.

Ist klar, die Zotec hat mehr OP, die Nutzkapazität beträgt ja auch nur 480GB statt 512GB wie bei der 950 Pro, gibt man der mehr OP, dann performt die 950 Pro besser im Steady State, aber das ist bei fast jeder SSD so und die Intel hat noch viel mehr OP. Habt ihr da eigentlich mit nicht komprimierbaren Daten gemessen? Mit scheint nicht, denn im

Review bei tomshardware schneidet die Zotec in der Disziplin recht bescheiden ab.

Immerhin wissen wir jetzt wohl, warum Intel die Preise der 750 Reihe so massiv gesenkt hat