Baal Netbeck

Fleet Admiral

- Registriert

- Apr. 2008

- Beiträge

- 12.374

Dies ist ein ausgelagertes Thema aus diesem Hauptthread:

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Edit: Achtung, das ist ein alter artikel mit teilweise veralteten Infos:

Intro:

Bei den meisten Spieletests werden die durchschnittlichen Frames Pro Sekunde angegeben(avg FPS) und daran festgemacht wie gut ein Spiel läuft und wie gut welche Hardware sich im Vergleich schlägt.

Das ist nicht richtig schlecht, bildet aber meiner Meinung nach nicht zuverlässig die Realität ab.

Von vielen Testseiten und auch hier auf CB werden inzwischen 99 Perzentil(manchmal auch 99.8) Werte angegeben. Wenn über diese in Foren gesprochen wird, sehe ich aber viel Unsicherheit und Missverständnisse. In der Nomenklaturerläuterung im Hauptthread habe ich bereits geschrieben wie sie gebildet werden und das sie nicht immer unproblematisch sind.

Schon bevor CB 99 Perzentil Werte angegeben hat, gab es vereinzelt Frametime-Graphen zu begutachten. Leider sind diese jetzt wieder seltener geworden und wurden dem Publikum auch nicht näher erläutert, sodass kaum jemand sie beachtet hat.

Ich selbst fand diese Artikel sehr interessant und wenn man auf das erste Datum schaut sieht man, das die Thematik eigentlich keine neue ist. Der Fokus liegt hier zwar erst mal auf Grafikkarten aber es lässt sich gut auf CPUs übertragen.

http://techreport.com/review/21516/inside-the-second-a-new-look-at-game-benchmarking

http://techreport.com/review/24553/inside-the-second-with-nvidia-frame-capture-tools

http://techreport.com/review/31546/where-minimum-fps-figures-mislead-frame-time-analysis-shines

In diesem Artikel will ich versuchen mit ein paar Beispielen Vorteile und Probleme von verschiedenen Bewertungsmethoden aufzuzeigen. Dabei benutze ich überwiegend Extrembeispiele und Cherry picking um meine Punkte zu erläutern und Aussagen zu falsifizieren. Das ist mit meinen Möglichkeiten nicht anders möglich weil ich für allgemeingültige Aussagen alle Spiele auf allen erdenklichen Systemkonfigurationen testen müsste....aber einzelne Gegenbeispiele bekomme ich hin

Grundsätzliches zu Frametimegraphen:

Perzentilwerte und mögliche Probleme

Die P99 Werte sind je nach Spiel anders zu interpretieren.

Mehr Messgrößen für ein besseres Gesamtbild.

Die reine Angabe der avg FPS hat meiner Meinung nach nur minimale Aussagekraft und sollte immer mit Frametimemessungen ergänzt werden.

So bleibt bei der Erfassung der Frametimes die Möglichkeit der graphischen Darstellung und der statistischen Auswertung. Beides hat Vor- und Nachteile....und für diese zu sensibilisieren war ein großes Ziel dieses Themas.

Das soll es erstmal gewesen sein....eventuell fällt mir später noch was ein.

Was meint ihr dazu? Fallen euch weitere Punkte ein?

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Edit: Achtung, das ist ein alter artikel mit teilweise veralteten Infos:

Intro:

Bei den meisten Spieletests werden die durchschnittlichen Frames Pro Sekunde angegeben(avg FPS) und daran festgemacht wie gut ein Spiel läuft und wie gut welche Hardware sich im Vergleich schlägt.

Das ist nicht richtig schlecht, bildet aber meiner Meinung nach nicht zuverlässig die Realität ab.

Von vielen Testseiten und auch hier auf CB werden inzwischen 99 Perzentil(manchmal auch 99.8) Werte angegeben. Wenn über diese in Foren gesprochen wird, sehe ich aber viel Unsicherheit und Missverständnisse. In der Nomenklaturerläuterung im Hauptthread habe ich bereits geschrieben wie sie gebildet werden und das sie nicht immer unproblematisch sind.

Schon bevor CB 99 Perzentil Werte angegeben hat, gab es vereinzelt Frametime-Graphen zu begutachten. Leider sind diese jetzt wieder seltener geworden und wurden dem Publikum auch nicht näher erläutert, sodass kaum jemand sie beachtet hat.

Ich selbst fand diese Artikel sehr interessant und wenn man auf das erste Datum schaut sieht man, das die Thematik eigentlich keine neue ist. Der Fokus liegt hier zwar erst mal auf Grafikkarten aber es lässt sich gut auf CPUs übertragen.

http://techreport.com/review/21516/inside-the-second-a-new-look-at-game-benchmarking

http://techreport.com/review/24553/inside-the-second-with-nvidia-frame-capture-tools

http://techreport.com/review/31546/where-minimum-fps-figures-mislead-frame-time-analysis-shines

In diesem Artikel will ich versuchen mit ein paar Beispielen Vorteile und Probleme von verschiedenen Bewertungsmethoden aufzuzeigen. Dabei benutze ich überwiegend Extrembeispiele und Cherry picking um meine Punkte zu erläutern und Aussagen zu falsifizieren. Das ist mit meinen Möglichkeiten nicht anders möglich weil ich für allgemeingültige Aussagen alle Spiele auf allen erdenklichen Systemkonfigurationen testen müsste....aber einzelne Gegenbeispiele bekomme ich hin

Grundsätzliches zu Frametimegraphen:

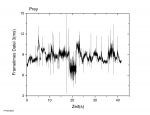

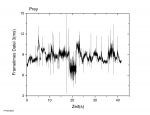

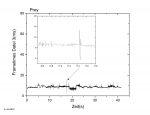

Fangen wir mit einer einfachen bildlichen Darstellung von zwei Frametimeverläufen an.

Auf der X-Achse ist die Zeit in Sekunden aufgetragen und auf der Y-Achse die Frametimes in Millisekunden. Längere und damit in der Auftragung höhere Frametimes sind schlecht.

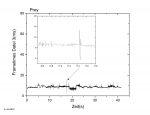

Auf den ersten Blick sieht Bild 1 nach deutlich mehr und höheren Schwankungen aus. Doch auf den zweiten Blick sollte man die Skalierung beachten und sehen, dass im linken Bild der schlechteste Frametime immer noch unter 15ms liegt und damit gut unterhalb der 16,67ms, die 60FPS entsprechen. Im folgenden schauen wir uns die Diagramme bei gleicher Skalierung an und vergrößern einen Bereich mit einem inset:

Hier wird klar, das Bild 1 in Wahrheit besser läuft und an der gleichen Stelle mit einer größeren Schwankung zu kämpfen hat.

Nicht so schön finde ich das bei CB gelöst, denn da sind zwar beide Graphen im selben Diagramm und das löst das Problem der y-Achsenskalierung,aber auf der X-Achse ist nicht die Zeit sondern die Framenummer angegeben und dann werden Verläufe mit weniger FPS kürzer dargestellt.Edit:das wurde gefixt

https://www.computerbase.de/2017-03...player-frametimes-ryzen-7-1800x-gegen-fx-8370

Interessant für den Aspekt Frametimes vs. FPS ist zu erwähnen, das Bild 2 einen Durchschnitt von 8.97 +-2.35 ms bzw. 111,5 FPS hat. Bild 1 kommt auf 8,6 +- 0,89 ms bzw. 116,2 FPS.

Das macht nur 4,2% mehr FPS für Bild 1 aber Bild 1 fällt gar nicht unter 60FPS und Bild 2 43 mal.

Die Auftragung als Graphen mit richtiger Skallierung und am besten zusammen in einem Diagramm ist also schonmal vielversprechend und hilft für die Bewertung viel.

Aber müssen wir dann dutzende Diagramme durchschauen? Immer nur 2 bis 3 CPUs oder CPU Konfigurationen gleichzeitig vergleichen? Wie vergleich man sowas wenn alles recht gleich ist, man aber Feinheiten sehen möchte? Schlimmer noch Werte quantifizieren, die man dann prozentual vergleichen kann?

So schon mal nicht:

Auf der X-Achse ist die Zeit in Sekunden aufgetragen und auf der Y-Achse die Frametimes in Millisekunden. Längere und damit in der Auftragung höhere Frametimes sind schlecht.

Auf den ersten Blick sieht Bild 1 nach deutlich mehr und höheren Schwankungen aus. Doch auf den zweiten Blick sollte man die Skalierung beachten und sehen, dass im linken Bild der schlechteste Frametime immer noch unter 15ms liegt und damit gut unterhalb der 16,67ms, die 60FPS entsprechen. Im folgenden schauen wir uns die Diagramme bei gleicher Skalierung an und vergrößern einen Bereich mit einem inset:

Hier wird klar, das Bild 1 in Wahrheit besser läuft und an der gleichen Stelle mit einer größeren Schwankung zu kämpfen hat.

Nicht so schön finde ich das bei CB gelöst, denn da sind zwar beide Graphen im selben Diagramm und das löst das Problem der y-Achsenskalierung,

https://www.computerbase.de/2017-03...player-frametimes-ryzen-7-1800x-gegen-fx-8370

Interessant für den Aspekt Frametimes vs. FPS ist zu erwähnen, das Bild 2 einen Durchschnitt von 8.97 +-2.35 ms bzw. 111,5 FPS hat. Bild 1 kommt auf 8,6 +- 0,89 ms bzw. 116,2 FPS.

Das macht nur 4,2% mehr FPS für Bild 1 aber Bild 1 fällt gar nicht unter 60FPS und Bild 2 43 mal.

Die Auftragung als Graphen mit richtiger Skallierung und am besten zusammen in einem Diagramm ist also schonmal vielversprechend und hilft für die Bewertung viel.

Aber müssen wir dann dutzende Diagramme durchschauen? Immer nur 2 bis 3 CPUs oder CPU Konfigurationen gleichzeitig vergleichen? Wie vergleich man sowas wenn alles recht gleich ist, man aber Feinheiten sehen möchte? Schlimmer noch Werte quantifizieren, die man dann prozentual vergleichen kann?

So schon mal nicht:

Perzentilwerte und mögliche Probleme

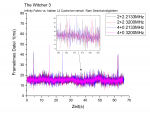

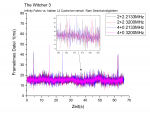

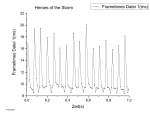

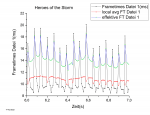

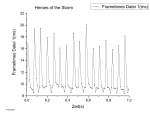

Ich beginne mit einem Beispiel aus einer meiner Heros of the Storm Messungen:

Vorgegriffen stehen hier schon ein paar mehr statistische Werte dabei, interessant ist aber der 99.9Percentil Wert. Die Graphen zeigen einen Vorteil für 4+0 aber keine so dramatischen, wie die 63% Unterschied die der Wert suggeriert.

Warum der große Unterschied? Beide Messungen haben 5 Ausreißer und einer von ihnen macht bei 2+2 die 51,63 ms. Denn die Messung hat 4988 Wertepaare und der P99.9 Wert entspricht dem 5. schlechtesten Frametime Wert.

Die Messung für 4+0 hat 5144 Wertepaare und daher wird der 6. schlechteste Wert betrachtet. Etwas niedrigere avg FT sorgen also für den entscheidenden Sprung.

Zugegeben...bei P99 Werten ist mir sowas noch nicht passiert.

Das liegt aber auch daran, dass meine Testszenen eher 40s bis 3min dauern. Da geht es für die P99 Werte nicht mehr um einzelne Ausreißer sondern um ganze Bereiche hoher FT.

Wenn die Testszenen 25s dauern wie bei CB und dann nur weniger FPS erreicht werden, landet man schonmal bei um die 1000-2000 Wertepaaren....und dann ist der Sprung von knapp unter zu knapp über 2000 für die P99 Werte der Unterschied zwischen dem 20. und 21. schlechtesten Wert. Je nachdem wie viele Ausreißer in den Frametimes enthalten sind, können diese also zahlreich vorhanden sein und werden trotzdem ignoriert oder kommen gerade über die Grenze und fallen dann um so stärker auf....siehe Beispiel 2

Beispiel 2( Forza 7):

Wie das Beispiel von Forza 7 zeigt, kann es Situationen geben, wo Perzentil Werte minimale Unterschiede aufweisen obwohl diese größer sind. Ober es werden wie bei dem Heroes of the Storm Beispiel große Unterschiede suggeriert, die eigentlich nur gering sind. Das soll nicht heißen, dass dies oft passiert. Aber ich denke man sollte die Möglichkeit im Hinterkopf haben, bevor man die Perzentil Werte auf die Goldwaage legt .

.

Vorgegriffen stehen hier schon ein paar mehr statistische Werte dabei, interessant ist aber der 99.9Percentil Wert. Die Graphen zeigen einen Vorteil für 4+0 aber keine so dramatischen, wie die 63% Unterschied die der Wert suggeriert.

Warum der große Unterschied? Beide Messungen haben 5 Ausreißer und einer von ihnen macht bei 2+2 die 51,63 ms. Denn die Messung hat 4988 Wertepaare und der P99.9 Wert entspricht dem 5. schlechtesten Frametime Wert.

Die Messung für 4+0 hat 5144 Wertepaare und daher wird der 6. schlechteste Wert betrachtet. Etwas niedrigere avg FT sorgen also für den entscheidenden Sprung.

Zugegeben...bei P99 Werten ist mir sowas noch nicht passiert.

Das liegt aber auch daran, dass meine Testszenen eher 40s bis 3min dauern. Da geht es für die P99 Werte nicht mehr um einzelne Ausreißer sondern um ganze Bereiche hoher FT.

Wenn die Testszenen 25s dauern wie bei CB und dann nur weniger FPS erreicht werden, landet man schonmal bei um die 1000-2000 Wertepaaren....und dann ist der Sprung von knapp unter zu knapp über 2000 für die P99 Werte der Unterschied zwischen dem 20. und 21. schlechtesten Wert. Je nachdem wie viele Ausreißer in den Frametimes enthalten sind, können diese also zahlreich vorhanden sein und werden trotzdem ignoriert oder kommen gerade über die Grenze und fallen dann um so stärker auf....siehe Beispiel 2

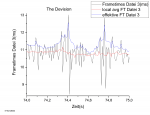

Beispiel 2( Forza 7):

https://www.computerbase.de/2017-09/forza-7-benchmark/3/

Im obere Frametimeverlauf bitte auf die Vega Performance achten und im unteren auf die 1080FE mit neuem Treiber.

Der neue Treiber bessert nicht nur die avg FT der 1080FE sondern auch die Anzahl und Höhe der Ausreißer. Trotzdem sieht man noch ca 17 deutliche Ausreißer in diesen 25s. Bei Vega sind es je nach Betrachtung 5-9. Ein nicht zu verachtender Unterschied in meinen Augen, der sich in der Angabe der Perzentil Werte wiederspiegeln sollte...aber schauen wir sie uns an...

1080 neuer Treiber----- avg FPS = 88FPS----- P99 = 75,4FPS

Vega64---------------- avg FPS =83,7FPS---- P99 = 75,3FPS

Warum sieht man keinen Unterschied? Weil in beide Fällen knapp über 2100Frames aufgenommen wurden und die P99 Werte daher die schlechtesten 21 Werte ignoriert.

Würden die P99.9 Werte angegeben, würde beide Male der 3. schlechteste Frametime betrachtet und wenn ich das richtig aus dem Frametimeverlauf ablese, komme ich auf:

1080 neuer Treiber----- =16,8ms = 59,52FPS

Vega64 ----------------= 13,6ms = 73,5FPS

Ein deutlicher Unterschied, der meiner Meinung nach besser den Verlauf repräsentiert.

Man kann argumentieren, dass der P99 Wert gar keine Ausreißer enthalten soll und mehr ein Ersatz für die minimum FPS darstellt.

Aber schaut man sich den alten Treiber an:

1080 alter Treiber P99 = 62,1FPS

Dann sieht man wie hier die Ausreißer enthalten sind, weil es ca 30 sind und bei knapp unter 2000Frames, der 20. schlechteste von ihnen den P99 Wert ausmacht. Wen es interessiert....ich würde hier als P99.9 Wert ca 13,6ms = 45,3FPS ablesen.

Man kann weiter argumentieren, dass sowohl die Vega64 als auch die 1080 mit neuem Treiber ein flüssiges spielen ermöglichen und die Ausreißer zu klein sind um wahrgenommen zu werden....dem stimme ich als Aussage zu, aber die gleichen Unzulänglichkeiten, die sich hier bei den P99 Werten offenbaren, könnten in einem anderen Fall durchaus relevant für das Spielgefühl sein.

Im obere Frametimeverlauf bitte auf die Vega Performance achten und im unteren auf die 1080FE mit neuem Treiber.

Der neue Treiber bessert nicht nur die avg FT der 1080FE sondern auch die Anzahl und Höhe der Ausreißer. Trotzdem sieht man noch ca 17 deutliche Ausreißer in diesen 25s. Bei Vega sind es je nach Betrachtung 5-9. Ein nicht zu verachtender Unterschied in meinen Augen, der sich in der Angabe der Perzentil Werte wiederspiegeln sollte...aber schauen wir sie uns an...

1080 neuer Treiber----- avg FPS = 88FPS----- P99 = 75,4FPS

Vega64---------------- avg FPS =83,7FPS---- P99 = 75,3FPS

Warum sieht man keinen Unterschied? Weil in beide Fällen knapp über 2100Frames aufgenommen wurden und die P99 Werte daher die schlechtesten 21 Werte ignoriert.

Würden die P99.9 Werte angegeben, würde beide Male der 3. schlechteste Frametime betrachtet und wenn ich das richtig aus dem Frametimeverlauf ablese, komme ich auf:

1080 neuer Treiber----- =16,8ms = 59,52FPS

Vega64 ----------------= 13,6ms = 73,5FPS

Ein deutlicher Unterschied, der meiner Meinung nach besser den Verlauf repräsentiert.

Man kann argumentieren, dass der P99 Wert gar keine Ausreißer enthalten soll und mehr ein Ersatz für die minimum FPS darstellt.

Aber schaut man sich den alten Treiber an:

1080 alter Treiber P99 = 62,1FPS

Dann sieht man wie hier die Ausreißer enthalten sind, weil es ca 30 sind und bei knapp unter 2000Frames, der 20. schlechteste von ihnen den P99 Wert ausmacht. Wen es interessiert....ich würde hier als P99.9 Wert ca 13,6ms = 45,3FPS ablesen.

Man kann weiter argumentieren, dass sowohl die Vega64 als auch die 1080 mit neuem Treiber ein flüssiges spielen ermöglichen und die Ausreißer zu klein sind um wahrgenommen zu werden....dem stimme ich als Aussage zu, aber die gleichen Unzulänglichkeiten, die sich hier bei den P99 Werten offenbaren, könnten in einem anderen Fall durchaus relevant für das Spielgefühl sein.

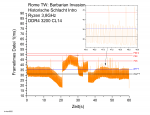

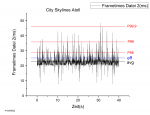

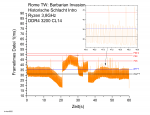

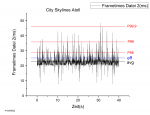

So ist der P99 Wert in meiner einen RomeTW Testszene fast gleich den Minimum FPS aber in City Skylines so ein Mittelding.

Das Diagramm von Rome zeigt zusätzlich ein weiteres Problem. Mittelwerte sind schlechte Darstellungen der Spieleperformance wenn die Testszene Kamerasprünge und Szenenwechsel beinhaltet. Und wie oben schon gezeigt, Perzentil Werte decken nur die schlechten Teile der Szene ab und ignorieren den Rest.

Das Diagramm von Rome zeigt zusätzlich ein weiteres Problem. Mittelwerte sind schlechte Darstellungen der Spieleperformance wenn die Testszene Kamerasprünge und Szenenwechsel beinhaltet. Und wie oben schon gezeigt, Perzentil Werte decken nur die schlechten Teile der Szene ab und ignorieren den Rest.

Mehr Messgrößen für ein besseres Gesamtbild.

Die Grenzwertverletzungen die ich bei der Nomenklatur(Hauptthread) schon beschrieben habe sind eine nette Ergänzung und zusammen mit den Percentile Werten geben sie einen guten Eindruck, was man schlimmstenfalls zu erwarten hat.

Sie schwanken aber auch gerne stärker und natürlich sollte man nicht wie in den Beispielen hier nur eine Messung betrachten sondern über mehrere Mitteln. Ebenso ignorieren sie weite Teile der Messung.

Mittelwerte haben also auch ihre Berechtigung, aber der klassische Mittelwert widerstrebt mir wenn ich mir die Mikroschwankungen angucke, die man in vielen Spielen findet.

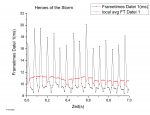

Zoomen wir mal in eine Sekunde von Heroes of the Storm hinein:

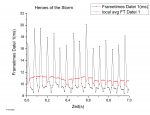

Ich habe die einzelnen Messpunkte mit Punkten markiert und man sieht, das jeder 5. bis 6. Frametime deutlich schlechter ist. Liegen die guten Werte im Bereich von 100+FPS, schwanken die schlechten im Bereich von 60FPS. Schauen wir uns die lokalen Mittelwerte über jeweils 11 Frames an:

Wie man sieht liegt der Mittelwert eher im Bereich der guten Frametimes weil diese in der Überzahl sind.

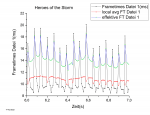

Da kommen meine effektiven Frametimes ins Spiel.

Das bestimmen der effektiven Frametimes gibt weitere Informationen

Diese eff FT orientieren sich eher an den schlechten Frametimes und ihr Mittelwert ist demnach näher am eigentlichen Spielgefühl. In diesem Beispiel würde ich sie gerne noch etwas extremer haben, aber dann würden sie in anderen Spielen über das Ziel hinausschießen und das möchte ich vermeiden.

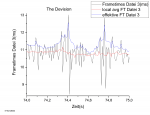

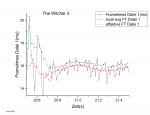

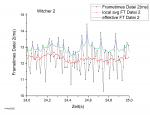

weitere Beispiele:

Was bringen sie mir also? Als Graph nicht viel...eventuell eine besse Übersicht, wenn man mehrere Graphen mit vielen Mikroschwankungen zusammen darstellen möchte. Den Durchschnitt der eff FT als statistische Messgröße(avg eff FT) kann man angeben. Er ist meiner Meinung nach eine bessere Angabe als der klassische Durchschnitt, aber sicherlich problematisch, weil keine allgemeine Definition dahinter steht.

Für mich, war der prozentuale Unterschied zwischen den avg FT und den avg eff FT, ein guter Indikator für das Maß an Mikroschwankungen. Unter 5% Abweichung ist dabei noch gut und ab 10% wird es schlecht.

Später hinzugenommen habe ich noch die 95% low, 99% low und 0.1% low Werte. Diese stellen den Mittelwert der Frametimes dar, die z.B. schlechter sind als der 95 Perzentil Wert.

So werden die Ausreißer sicher erfasst und das mit einer allgemeingültigeren Form als bei den Grenzwertüberschreitungen.

Die 0.1% low Werte unterliegen oft einer schlechten Reproduzierbarkeit, aber die 1% low Werte sind für mich inzwischen die beste Möglichkeit um das Spielgefühl einer Testsequenz zu beschreiben.

Sie schwanken aber auch gerne stärker und natürlich sollte man nicht wie in den Beispielen hier nur eine Messung betrachten sondern über mehrere Mitteln. Ebenso ignorieren sie weite Teile der Messung.

Mittelwerte haben also auch ihre Berechtigung, aber der klassische Mittelwert widerstrebt mir wenn ich mir die Mikroschwankungen angucke, die man in vielen Spielen findet.

Zoomen wir mal in eine Sekunde von Heroes of the Storm hinein:

Ich habe die einzelnen Messpunkte mit Punkten markiert und man sieht, das jeder 5. bis 6. Frametime deutlich schlechter ist. Liegen die guten Werte im Bereich von 100+FPS, schwanken die schlechten im Bereich von 60FPS. Schauen wir uns die lokalen Mittelwerte über jeweils 11 Frames an:

Wie man sieht liegt der Mittelwert eher im Bereich der guten Frametimes weil diese in der Überzahl sind.

Da kommen meine effektiven Frametimes ins Spiel.

Das bestimmen der effektiven Frametimes gibt weitere Informationen

Diese eff FT orientieren sich eher an den schlechten Frametimes und ihr Mittelwert ist demnach näher am eigentlichen Spielgefühl. In diesem Beispiel würde ich sie gerne noch etwas extremer haben, aber dann würden sie in anderen Spielen über das Ziel hinausschießen und das möchte ich vermeiden.

weitere Beispiele:

Was bringen sie mir also? Als Graph nicht viel...eventuell eine besse Übersicht, wenn man mehrere Graphen mit vielen Mikroschwankungen zusammen darstellen möchte. Den Durchschnitt der eff FT als statistische Messgröße(avg eff FT) kann man angeben. Er ist meiner Meinung nach eine bessere Angabe als der klassische Durchschnitt, aber sicherlich problematisch, weil keine allgemeine Definition dahinter steht.

Für mich, war der prozentuale Unterschied zwischen den avg FT und den avg eff FT, ein guter Indikator für das Maß an Mikroschwankungen. Unter 5% Abweichung ist dabei noch gut und ab 10% wird es schlecht.

Später hinzugenommen habe ich noch die 95% low, 99% low und 0.1% low Werte. Diese stellen den Mittelwert der Frametimes dar, die z.B. schlechter sind als der 95 Perzentil Wert.

So werden die Ausreißer sicher erfasst und das mit einer allgemeingültigeren Form als bei den Grenzwertüberschreitungen.

Die 0.1% low Werte unterliegen oft einer schlechten Reproduzierbarkeit, aber die 1% low Werte sind für mich inzwischen die beste Möglichkeit um das Spielgefühl einer Testsequenz zu beschreiben.

So bleibt bei der Erfassung der Frametimes die Möglichkeit der graphischen Darstellung und der statistischen Auswertung. Beides hat Vor- und Nachteile....und für diese zu sensibilisieren war ein großes Ziel dieses Themas.

Das soll es erstmal gewesen sein....eventuell fällt mir später noch was ein.

Was meint ihr dazu? Fallen euch weitere Punkte ein?

Zuletzt bearbeitet: