raychan schrieb:

Warum wird PCIe 4.0/5.0 so extrem warm und DDR4/DDR5 Ram ist wesentlich schneller aber hat nicht solche Temperatur Probleme.

Das sind zwei komplett unterschiedliche Technologien. DRAM sind super vereinfacht erstmal nur die Speicherzellen (die auch anders aufgebaut ist als NAND Flash) und soviel weitere Logik ist dann da nicht drauf auf den Riegeln. Der eigentliche Controller um die anzusprechen befindet sich in der CPU.

SSDs sind wesentlich komplizierter. Da ist sowohl der Controller drauf als auf der NAND Flash drauf. Warum neuere SSDs wärmer werden als ältere Exemplare liegt an mindestens 3 Effekten.

Der Flash wird schneller. Vor noch nicht all zu langer Zeit noch mit 800, 1200 MT/s ist man mittlerweile bei Richtung 2000MT/s. Heißt die Frequenz steigt auf dem Flashbus, damit der Stromverbrauch und damit die Verlustwärme.

Ähnlich beim Interface Richtung Host. Bisher haben sich bei jeder PCIe Generation die Frequenzen verdoppelt. Gen 3 waren es noch 4 GHz, Gen 4 dann 8 GHz und Gen 5 nun 16 Ghz (Gen 6 bleibt dann bei 16 Ghz aber anders moduliert). Daher hier das selbe wie beim Flash. Allein um den elektrischen Link aufrecht zu erhalten wird im Vergleich zu früher wesentlich mehr Energie benötigt.

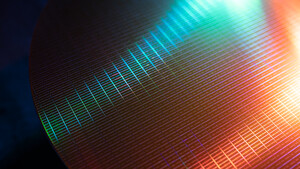

Und als drittes verbrauchen moderne Controller an sich mehr Strom. Wenn Flash und Hostinterface schneller werden, müssen diese erstmal die gleichen Aufgaben wie früher schneller erledigen. Ganz vereinfacht gesagt , muss nen Gen 4 Controller mit 7 GB/s halt doppelt so schnell alles machen wie nen Gen 3 Controller der "nur" 3,5 GB/s schafft. Dazu kommt, dass die Aufgaben sich geändert haben mit der Zeit und immer mehr werden, da der Flash schlechter wurde mit den neueren Technologien. Mit TLC und QLC sind viel mehr Bitfehler üblich als bei SLC und MLC und selbst schon bei den älteren Technologien gibt es einen Unterschied ob planarer NAND oder 3D NAND verwendet wird, da bei 3D NAND ganz neue Defektklassen hinzugekommen sind da Fehler im Silizium sich halt nicht nur in eine Richtung sondern mehrere auswirken. Früher haben einfache Algorithmen gereicht um die vereinzelten Bitfehler zu erkennen, heute sind interne Raids üblich mit ganzen Blöcken als Parity. Das ganze Fehlerhandling dürfte mit der Hauptverursacher beim Stromverbrauch sein. Selbst "einfache" Controller haben als Rechenwerk Mehrkern CPUs und die fetten Datacenter Controller haben mittlerweile 8 Kerne.

Mit verkleinern der Strukturbreiten der CPUs schafft man es auch bei Controllern, dass diese ihre Aufgaben effizienter erledigen. Ist komplett analog zur Entwicklung der eigentlichen CPU im PC.