V

Vietcong

Gast

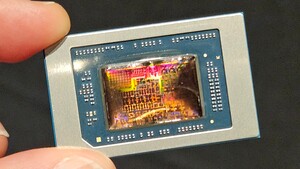

Wie ich glaub, schon oft genug gesagt habe, ist AMD &ATi durch ihre Verschmelzung zu ein leistungsstarker und innovatives Unternehmen geworden, so tragt die Firma auch zu jegliche Fortschritte bei die man auf dem Computermarkt sieht. Deswegen hat sich auch HP für die APUs mit FirePro-Einheit entschieden, da sie perfekt für den Desktop-Remotebereich sind und in jeder Weise den Intel-Einheiten in diesen Segment voraus sind, da bringen die neuen Intel HD 5xxx Garnichts. Sprich AMD&ATi sind anpassungsfähig und bieten für fast jede Situation den Endbenutzer oder Käufer die beste Lösung, bei Intel kann man ziemlich lange auf Maßschneiderungen warten, die dann bereits veraltet sind.

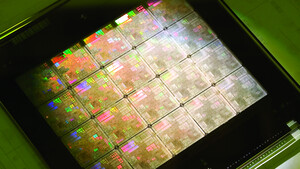

Dazu wird sich AMD vom letzten Jahr höchstwahrscheinlich gut erholen, da die ATi-Karten hoch im Kurs sind und jegliche Preisklasse bzw. Leistungsklasse abgedeckt ist. (7730-7990, jede Leistungsklasse ist dabei) Es ist auch eine riesige neue Einnahme-Quelle aufgetan worden durch dem Deal mit Microsoft, Sony, Valve und Nintendo und lässt auf noch bessere Optimierung der Engines von Spielehersteller auf AMD/ATI erhoffen. Da jetzt im Bereich von DirectX11, Steamsoftware-Cooperation, Crytek, FrostBite und ähnliches die Hardware-Plattformen von AMD ausschlaggebend sind und somit Nvidia an Attraktivität für Optimierung verloren hat!

Ein Thema das ich auch hart umkämpft habe ist die Situation im Desktopbereich und im Konsolenbereich, während AMD seine FX und APUs schon mit 8-Kerne ausgestattet hat, lässt sich Intel ziemlich viel Zeit und ist in keinem Falle auf die Situation von Multithreading vorbereitet, wie sich teils bei Crysis 3 gezeigt hat und wahrscheinlich auch bei Battelfield 4. Zurzeit arbeiten die meisten Engines mit nur 4 Kerne, somit ist viel Potenzial dahin, wenn dieses Potenzial das nächste Jahr durch die Entwicklererfahrung mit den 8-Core APUs summiert wird zur jetzigen Leistung, kann auch keiner mehr behaupten die CPUs sind nur gut fürs Rendern und Arbeiten aber nicht fürs Zocken.

Bei Youtube war auch ein Kommentar denn ich zustimmen kann:

Dazu wird sich AMD vom letzten Jahr höchstwahrscheinlich gut erholen, da die ATi-Karten hoch im Kurs sind und jegliche Preisklasse bzw. Leistungsklasse abgedeckt ist. (7730-7990, jede Leistungsklasse ist dabei) Es ist auch eine riesige neue Einnahme-Quelle aufgetan worden durch dem Deal mit Microsoft, Sony, Valve und Nintendo und lässt auf noch bessere Optimierung der Engines von Spielehersteller auf AMD/ATI erhoffen. Da jetzt im Bereich von DirectX11, Steamsoftware-Cooperation, Crytek, FrostBite und ähnliches die Hardware-Plattformen von AMD ausschlaggebend sind und somit Nvidia an Attraktivität für Optimierung verloren hat!

Ein Thema das ich auch hart umkämpft habe ist die Situation im Desktopbereich und im Konsolenbereich, während AMD seine FX und APUs schon mit 8-Kerne ausgestattet hat, lässt sich Intel ziemlich viel Zeit und ist in keinem Falle auf die Situation von Multithreading vorbereitet, wie sich teils bei Crysis 3 gezeigt hat und wahrscheinlich auch bei Battelfield 4. Zurzeit arbeiten die meisten Engines mit nur 4 Kerne, somit ist viel Potenzial dahin, wenn dieses Potenzial das nächste Jahr durch die Entwicklererfahrung mit den 8-Core APUs summiert wird zur jetzigen Leistung, kann auch keiner mehr behaupten die CPUs sind nur gut fürs Rendern und Arbeiten aber nicht fürs Zocken.

Bei Youtube war auch ein Kommentar denn ich zustimmen kann:

, AMD/ATI war technologisch schon immer einen Schritt voraus. Vektorarchitektur, frühere Unterstützung von DirectX Standards, FP64, Tessellation, kleinere Fertigungsstrukturen usw. Und HSA ist ein neuer Meilenstein. von @avynian