AMINDIA schrieb:

Intel Quartalszahlenbericht:

16.10.12 22:51 Uhr - 05:00 Uhr, 20 Beiträge

AMD Quartalszahlenbericht

18.10.12 22:50 Uhr - 05:00 Uhr, 59 Beiträge.

Man muss dabei klar hervorheben. Diejenigen die andere als AMD Fanboys bezeichnen sind genau die User, die sich zu jeder AMD News in Höchstleistung schreiben. Da liegt nach meinem Verständnis das Fanboytum wohl eher bei diesen Menschen

So ist es.

Intel & Nvidia-Technik wurde immer schon hochgejubelt.

Der Optimus-Konkurrent Enduro wurde nichteinmal in der CB-News erwähnt.

Faszinierend ist aber, dass AMD mit Ontario & Thaiti-Ghz trotzdem die Performance-Krone in ihren Märkten hat und es doch logisch sehen, dass AMD in diesen Märkten keine Mega-Gewinne macht, und das obwohl die Performance-Krone die entscheidende Erklärung ist, warum Bulldozer ja ein Mega-Flop sein soll.

Mr_Tee schrieb:

Stimmt, das habe ich sogar vergessen.

Die Chance, dass AMD 10-15% mehr Performance über 10-15% Mehr Stromverbrauch erkauft, ist somit geringer geworden.

Interessant, dass Intel bei Haswell hingegen zu Sandy-Bridge & Ive-Bridge keine Chinebench IPC oder Performnace (IPC + Takt) Angaben macht. Aber die diese bei den letzten gering ausgefallen sind, würde ich die Steigung sogar deutlich über diesen beiden für Möglich halten, was dann statt 10-15% eigentlich +20-30% MehrPerformance bedeuten kann.

MrEisbaer schrieb:

AMD sollte das selbe machen, wie Intel bei ihren Core 2 x Modellen.

Dort hat Intel ja die "alte" Pentium-M Technologie (die wiederum auf der stark modifizierten PIII Technologie basiert) genommen und extrem aufgebohrt.

Der Fehler in dieser Denkweise ist, dass der Pentium III damals 50-100% Effizienter war als der K7, weil dieser 35-50% weniger Strom verbrauchte.

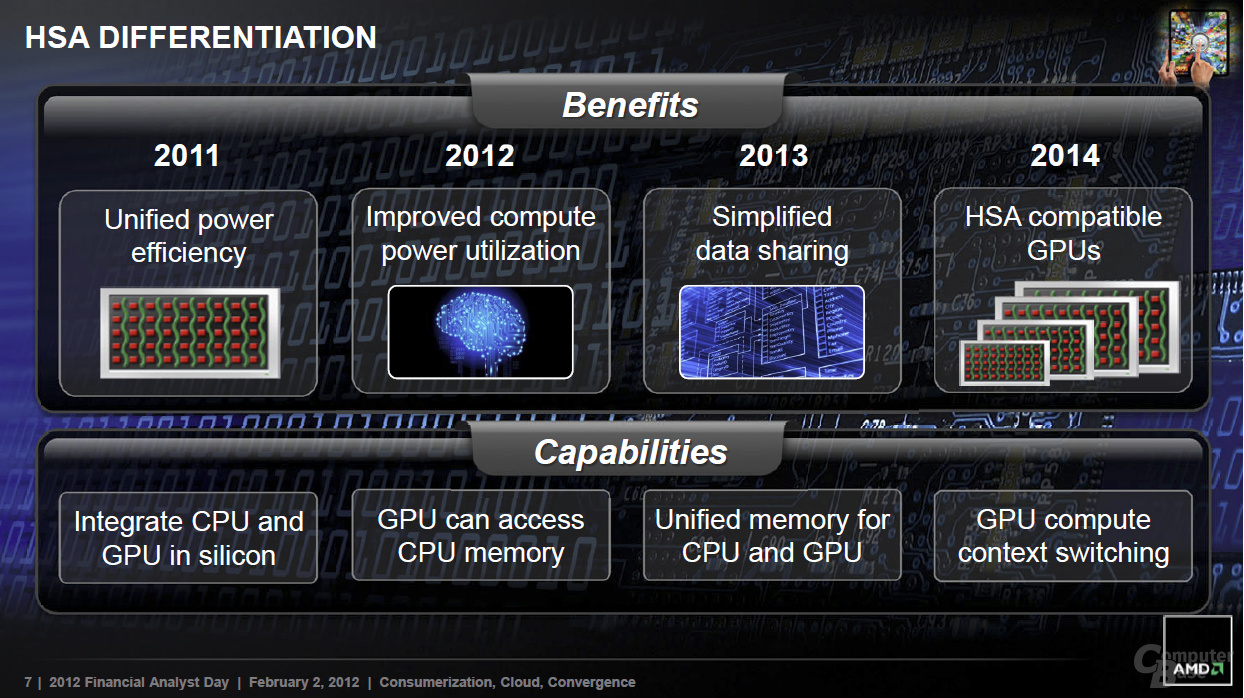

Zweiter Denkfehler ist die HSA-Zukunft des Bulldozers.

AMD braucht nicht den K10 mit 3fachfrontend & 3 ALUs wiederbeleben, wenn sie bald schon Steamroller ein 2x4 Fach -Front-End verpassen.

Anstatt einen alten K10 von 3 auf 4-Fach Front-End & ALU upzudaten, kann AMD genauso den Bulldozer von 2x2 Front-End und 2x2 ALUS auf 2x4 Front-End

R600 verdamals in viele Augen auch ein Flop.

Aber damals verstand keiner (ich genauso), dass das R600 Front-End mit nur 4-SIMD viel zu überdimensioniert war und im R600 sehr viel Zukunftstechnik drinnensteckte. Heute ist dieses R600-Architektur viel effizienter, weil in einem Front-End (mit je einem Rasterizer & Gemetrie Unit & Assambler) heute nicht 4 sondern bis zu 16 CUs versorgen können.

Dieses Problem steckt auch in Bulldozer. Wir wissen einfach nicht, wie viele Vorbereitungen heute im Bulldozer drinnstecken und somit wie hoch das heutige Potential ist.

Es kann eben sein, dass in 5-10 Jahren im Bulldozer-Modul 4-Integer-Cores, 2-FPU-Cores und 1 CU (GCN) drinnen steckt (oder 2 CUs und 1 Big-FPU).

Deshalb ist Bulldozer technisch sehr interessant.