GerryB

Rear Admiral

- Registriert

- Sep. 2016

- Beiträge

- 5.159

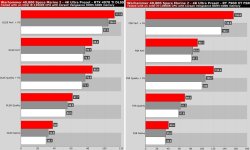

Welche?pacifico schrieb:... CB hat eine Interessante Schwäche bei dieser Karte aufgedeckt.

Das man die große Graka in FHD@XeSS nicht auslastet.

Würde dann sofort alle 4090 wegwerfen.

oder

CB macht sich bitte beim nächsten Test mehr Gedanken und schaut mal, was Intel so für sinnvoll hält.

Von Intel gabs glaube nur Folien zu WQHD@XeSS+FG.

Nach Möglichkeit Beides nutzen!

Wie skalieren Grakas mit Upsampler+Framegeneration in WQHD+ ? (z.Bsp. siehe Anhang dort in 4k)

Wo ist der Vergleich bei CB?

Es gibt zwar jetzt erstmal nur F1 24, aber da hätte man auch mal die Konkurrenz mit dazunehmen können.

Und das man im Launchreview da nur 1080p im XeSS-Test genommen hat = ???

Warum macht man nicht die Nagelprobe in 1440p um die Intel-Folien nachzustellen?

Anhänge

Zuletzt bearbeitet: