Clapinoson

Cadet 3rd Year

- Registriert

- Jan. 2022

- Beiträge

- 35

Hi,

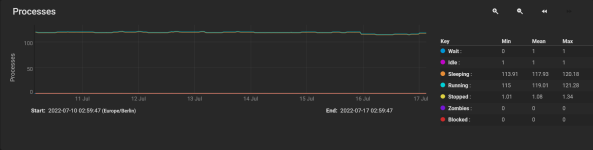

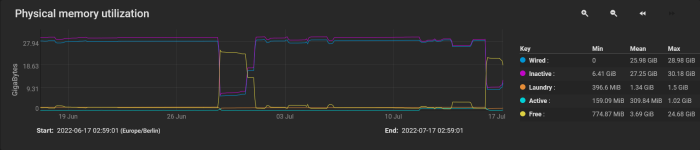

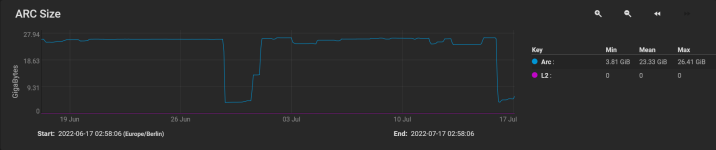

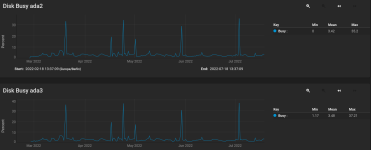

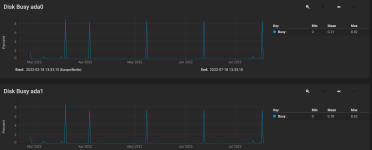

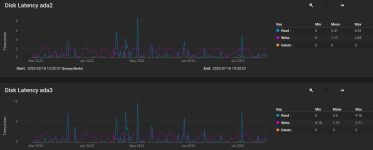

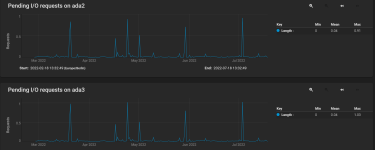

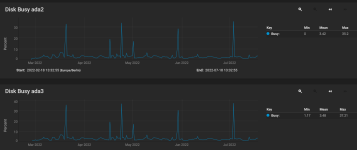

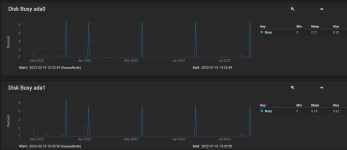

ich habe seit einiger Zeit TrueNAS am Laufen und bin eigentlich ziemlich zufrieden damit. Allerdings kommt es hin und wieder zu Performance-Einbrüchen bei Kopiervorgängen, die ich mir so nicht wirklich erklären kann. Meistens hilft dann ein Neustart. Ist ein etwas älterer Intel CPU mit 3,2 GHZ und 4 Kernen und 32 GB RAM.

Soweit ich das gesehen habe, lief auch kein Scrubs im Hintergrund während des Kopiervorgangs. Wo und wie könnte ich mit der Fehlersuche anfangen, Hardware scheint in Ordnung zu sein, RAM habe ich getestet mittels MEMTEST, die Festplatten sind neu und auch noch gut laut S.M.A.R.T. Test.

Vielleicht hat jemand mehr Erfahrung als ich mit TrueNAS oder schon ähnliche Probleme gehabt. Würde mich über gute Ratschläge wirklich freuen.

Grüße

ich habe seit einiger Zeit TrueNAS am Laufen und bin eigentlich ziemlich zufrieden damit. Allerdings kommt es hin und wieder zu Performance-Einbrüchen bei Kopiervorgängen, die ich mir so nicht wirklich erklären kann. Meistens hilft dann ein Neustart. Ist ein etwas älterer Intel CPU mit 3,2 GHZ und 4 Kernen und 32 GB RAM.

Soweit ich das gesehen habe, lief auch kein Scrubs im Hintergrund während des Kopiervorgangs. Wo und wie könnte ich mit der Fehlersuche anfangen, Hardware scheint in Ordnung zu sein, RAM habe ich getestet mittels MEMTEST, die Festplatten sind neu und auch noch gut laut S.M.A.R.T. Test.

Vielleicht hat jemand mehr Erfahrung als ich mit TrueNAS oder schon ähnliche Probleme gehabt. Würde mich über gute Ratschläge wirklich freuen.

Grüße