Ich komme mit meiner 3080 auf knapp 12700 Punkte und eine FE die ich in den Ergebnissen gefunden habe kommt auf ca. 13700 Punkte. Das sind nicht mal 10%, klar ist es vielleicht die langsamste, aber trotzdem ist die 3080 nicht 20% langsamer. Auch hier wird die 3070 mit 13700 Punkten angegeben. Ich hatte auch ein anderes m17 R4 mit UHD Display und dort kam die 3080 Stock auf 12900 Punkte, also noch weniger Unterschied.boonstyle schrieb:Eher so 20% wenn man von der 3070 FE als Basiswert ausgeht und damit liegt die dann irgendwo zwischen der 2080 Super und der 2080.

Wenn man dann die 1080ti als Maß´stab nimmt dann kommt das also ziemlich gut hin, denn das ist ungefähr das Niveau.

Nur hat CB nie die maximale TGP getestet, du schreibst aber von maximaler TGP. Die maximale TGP ist mit dem Dynamic Boost 2.0 165 Watt. Wie oben geschrieben ist der Unterschied zwischen einer FE und der 3080 nicht mal 10 %..Klever schrieb:Indem ich bei CB auf das Leistungsrating schaue, in FullHD liegt eine mobile 3080 unter hinter Desktop GPU wie der 5700 XT/Radeon VII und der 1080 Ti. In UltraHD ist die mobile 3080 mit max TGP dann auf dem Level der 1080 Ti, aber nur mit max TGP.

Das Problem beim Vergleich zwischen Desktop und Notebook ist nicht nur die GPU sondern auch die CPU, deswegen Vergleiche ich lieber mit Timyspy, weil da die CPU kaum Einfluss auf das Grafikergebniss hat. Es macht schon einen Unterschied ob die CPU nur 45 Watt verbrauchen darf oder ob sie 100+ Watt verbraucht. Dazu kommt noch, ist die Kühlung vom Notebook schlecht sind es die Ergebnisse auch.Klever schrieb:so lassen sich dazu direkte Tests finden wie das von Gamestar. Dort ist die 1080 Ti schneller als die 2080 Mobile in zwei von drei Spielen (Assassin's Creed: Origins wo die 2080 Mobile von einer 2060 Desktop eingeholt wird, und Total War: Warhammer 2), Wolfenstein wo die 2080 Mobil etwas schneller ist als die 1080 Ti, ist ein Vulkan Spiel, das generell Turing viel besser liegt als Pascal.

Wie man es dreht und wendet, in der Regel sind Desktopkarten auch über eine oder gar paar Generation noch schneller, als TGP- und templimitierte Karten von Notebooks, die nötige Stromaufnahme und das wegschaffen von Abwärme kommt ja nicht aus dem Nichts.

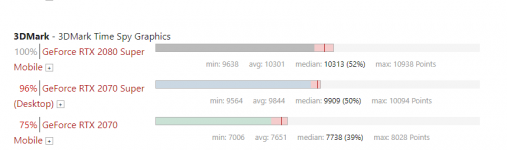

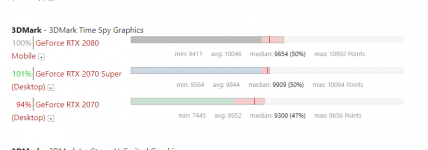

Hier mal von Notebookcheck die Ergebnisse zu den Grafikkarten. Zum Vergleich mein Area-51m hatte 10570 Punkte im Grafikscore, also noch mehr als die avg. von den beiden anderen.