1) Balken benutzen. Nicht jeder Pixel da vorhanden ist, muss auch zwingend leuchten damit man glücklich ist.

2) Hängt von Deiner Software + Settings ab und was Du unter "ausreichend" verstehst bzw. was Dir genügt. Wie Leidensfähig Du bist.

Software

Und Settings

-Die Auflösung fordert Leistung von der Grafikkarte. Je mehr Pixel dargestellt werden müssen, desto mehr Daten muss die Graka abackern jede Sekunde.

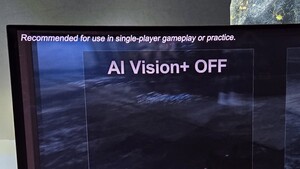

-Die Features fordern Leistung von der Grafikkarte. Je mehr Post-Prozessing-Filter, je mehr Eigenverschattung, je mehr Antialiasing-Filter Du zuschaltest, desto mehr muss die Graka arbeiten.

- Du hast Einsteller in jedem Game um die Leistung der vorhandenen Hardware an Deine Vorstellungen von FPS und Bildqualität anzupassen. Man kann auch ohne Ultra-Settings sehr gut klarkommen. Meistens sind die Unterschiede mit der Lupe zu suchen.

Hier mal der Vergleich. Cryisis3 in 2560 und Ultra und in 4K und High. FPS gehen sich aus. Unterschiede suchen bitte.

3) Kommt drauf an was Du unter "Problemlos" verstehst. Natürlich kann jeder 4K-Monitor auch 1080P darstellen (zur Not über die Graka runtergerechnet). Aber das Bild verliert dadurch an Schärfe. Es sei denn Du betreibst ihn Pixelgenau. Also mit schwarzen Balken um das Bild herum. Aber da kommen wir wieder zu 1)

Man kann ja den 4K-Monitor z.b. Pixelgenau in 3820x1648 betreiben. Das ist 21:9 und sehr populär zur Zeit. Spart 25% Pixel und entsprechend gibt es mehr FPS.

Ich würde (persönliche Meinung) eher Features aufgeben als Auflösung. Als zweites, wenn der 21:9-Trick nicht hilft, oder die Software kein 21:9 anbietet.

Anti-Aliasing braucht man weniger, das fliegt als erstes raus. Dann schalte ich die Eigenverschattung etwas runter, dann ein paar Post-Prozessing-Features. Dann die Schatten. Und damit gibt es schon (in meiner Software-Library, mit meinen Ansprüchen an FPS und meiner Hardware) kein Game das FPS-Probleme macht von der Graka-Seite aus. Da sieht es von der CPU-Seite viel schlimmer aus^^

Aber das muss jeder mit sich selbst abmachen. Es wird keine pauschal für alle richtige Antwort geben.

Und als letztes: Macht euch klar wie schnell heutige Graka sind.

3xUHD mit 100 FPS? Nein?

In Assetto-Corsa (interner Benchmark) kein Problem mit einer Grafikkarte.

Ach so... Assetto Corsa ist keine Grafik-Hure?

Na dann 3xUHD in GTA5. 60 FPS und ich kann nebebei ein Video aufnehmen.

https://www.youtube.com/watch?v=QoZdpHGrpPU

Oder gleich 8K?

CSGO mit über 100 FPS

GTA5 mit immer noch 50 FPS auf einer Graka