In der verhältnismäßig kurzen Zeit, in der Computer existieren, gab es immer wieder Projekte, die eingestellt wurden. Diese Serie behandelt in loser Abfolge die GPUs, die entweder nie in Produktion gegangen sind oder am Markt floppten, obwohl der Ansatz vielversprechend aussah. Auch ein Marktführer liegt nicht immer richtig.

Teil 1: Die Bitboys

Teil als Artikel Update: intels i740, Timna und AIMM

Teil 2: nVidias nv1

Einleitung

In den ersten Teilen wurden die Bitboys und Ihre Pyramid3D und Glaze3D beleuchtet.

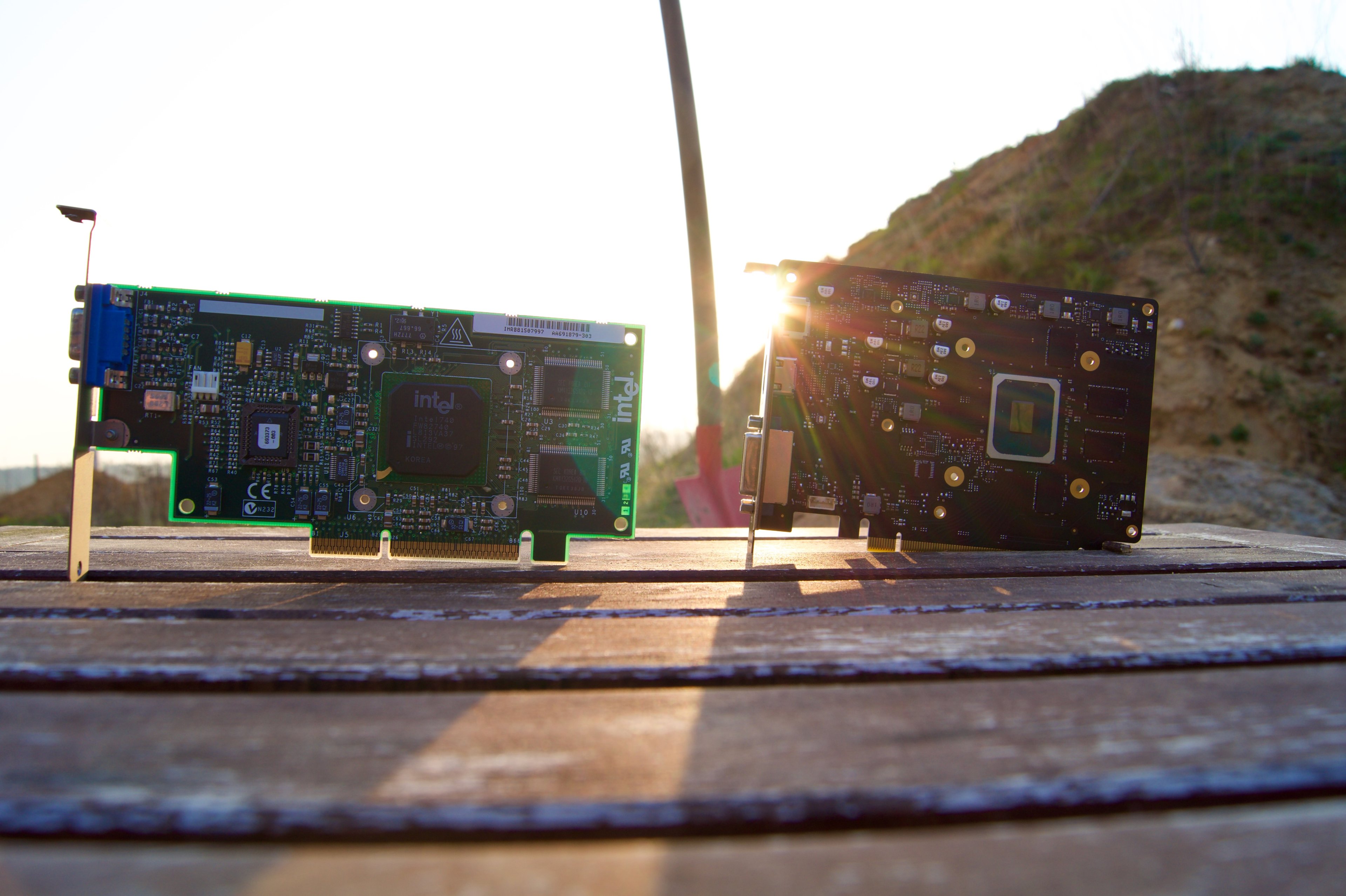

Sowie intels i740, der antrat, 3dfx und nVidia herauszufordern und leider komplett gescheitert ist. Immerhin kamen 50 verschiedene Designs auf den Markt, mehr als bei der aktuellen DG1 und DG2 Generation:

Foto @kryzs

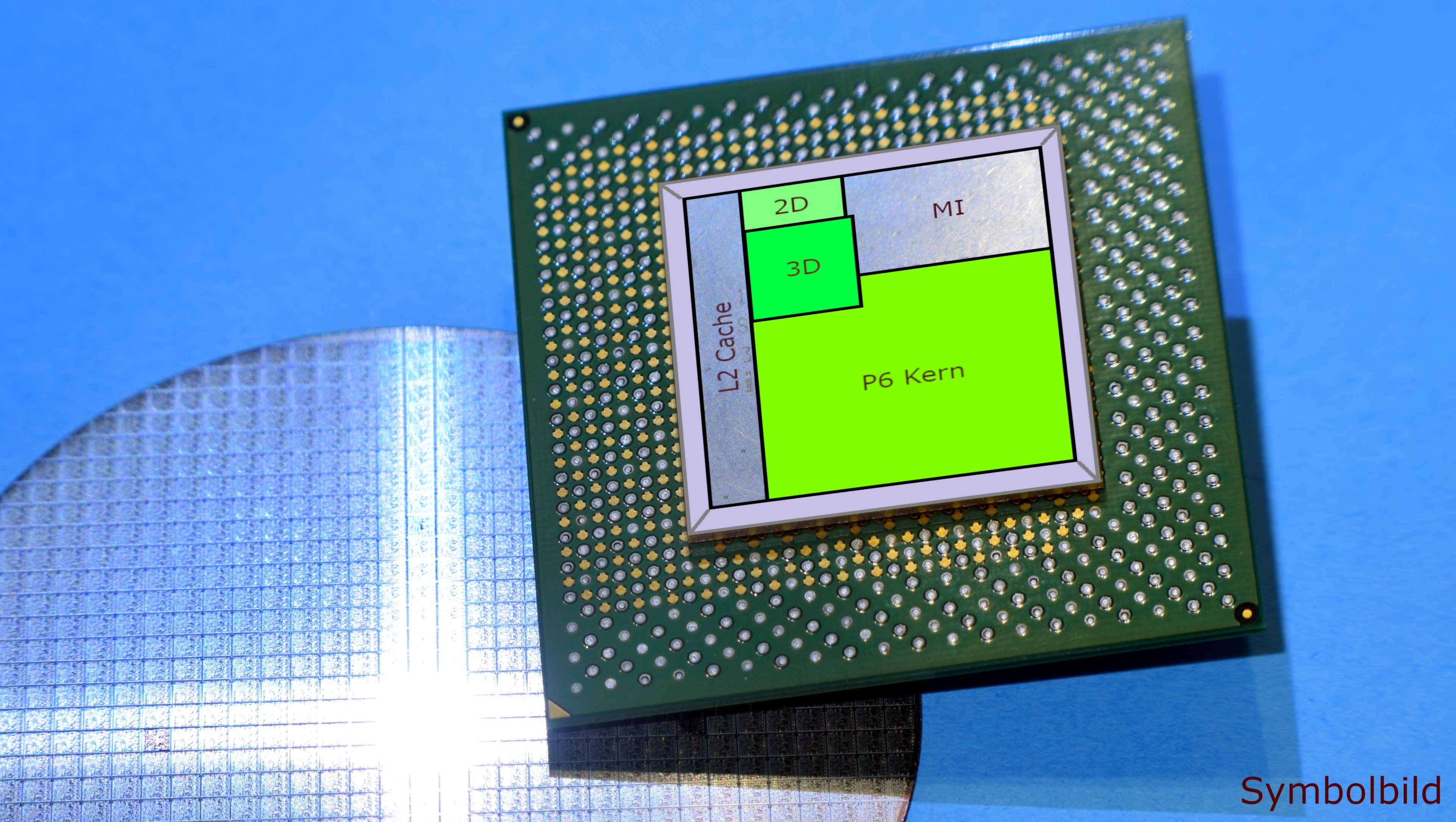

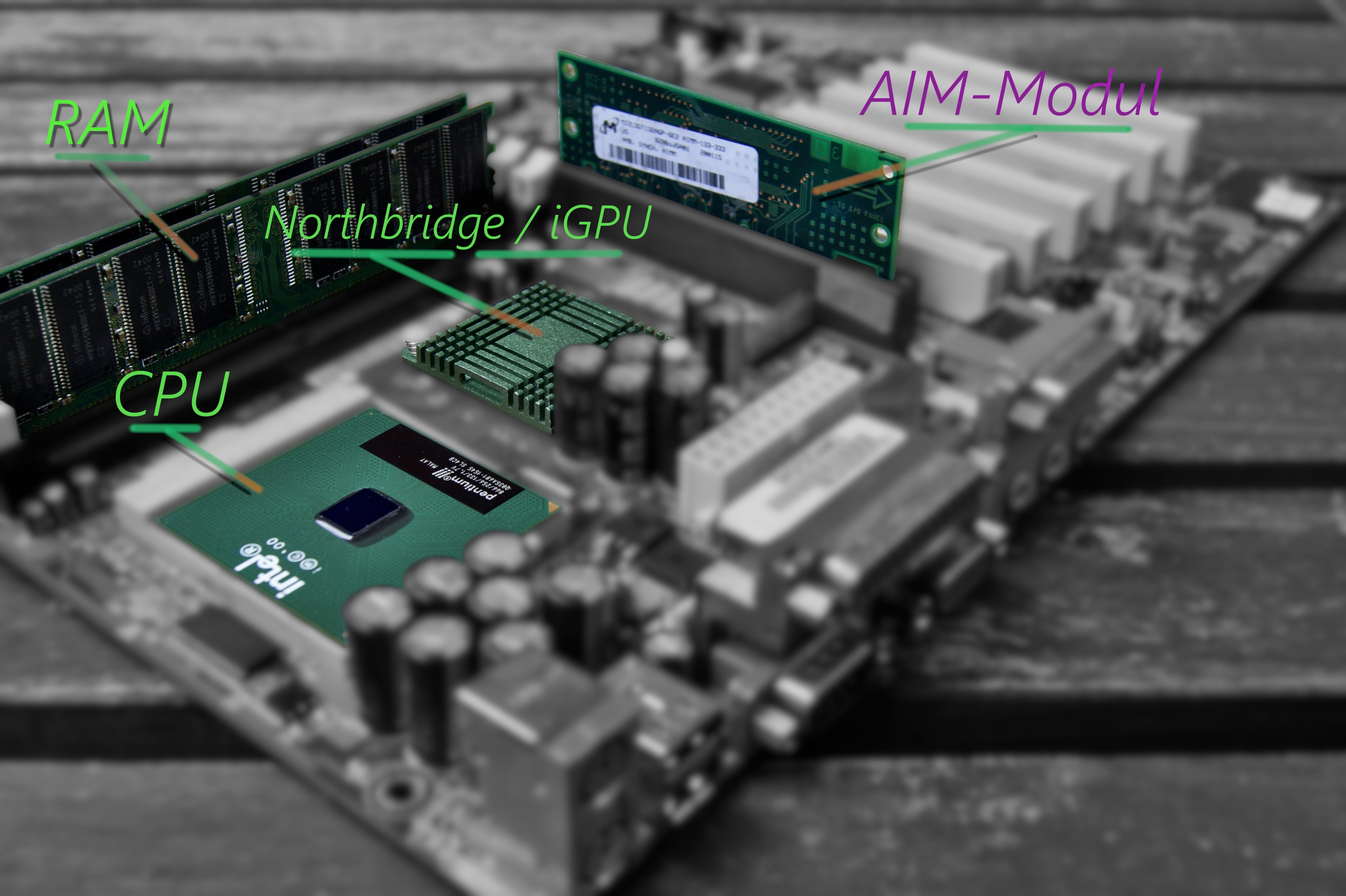

Intels Timna war dann ein Versuch, einen Celeron SoC in den Lowcost Markt zu bringen, der aber noch vor der Markteinführung gestrichen wurde.

Das AIMM war dann ein 4 MB Modul, welches in den AGP Steckplatz eingesetzt wurde, um der in die Northbridge integrierten Grafik mehr Speicher für den Z-Buffer zur Verfügung zu stellen.

Nach dem nv1 machen wir mit dem nv30 weiter, aka der Föhn.

Nvidias nv30

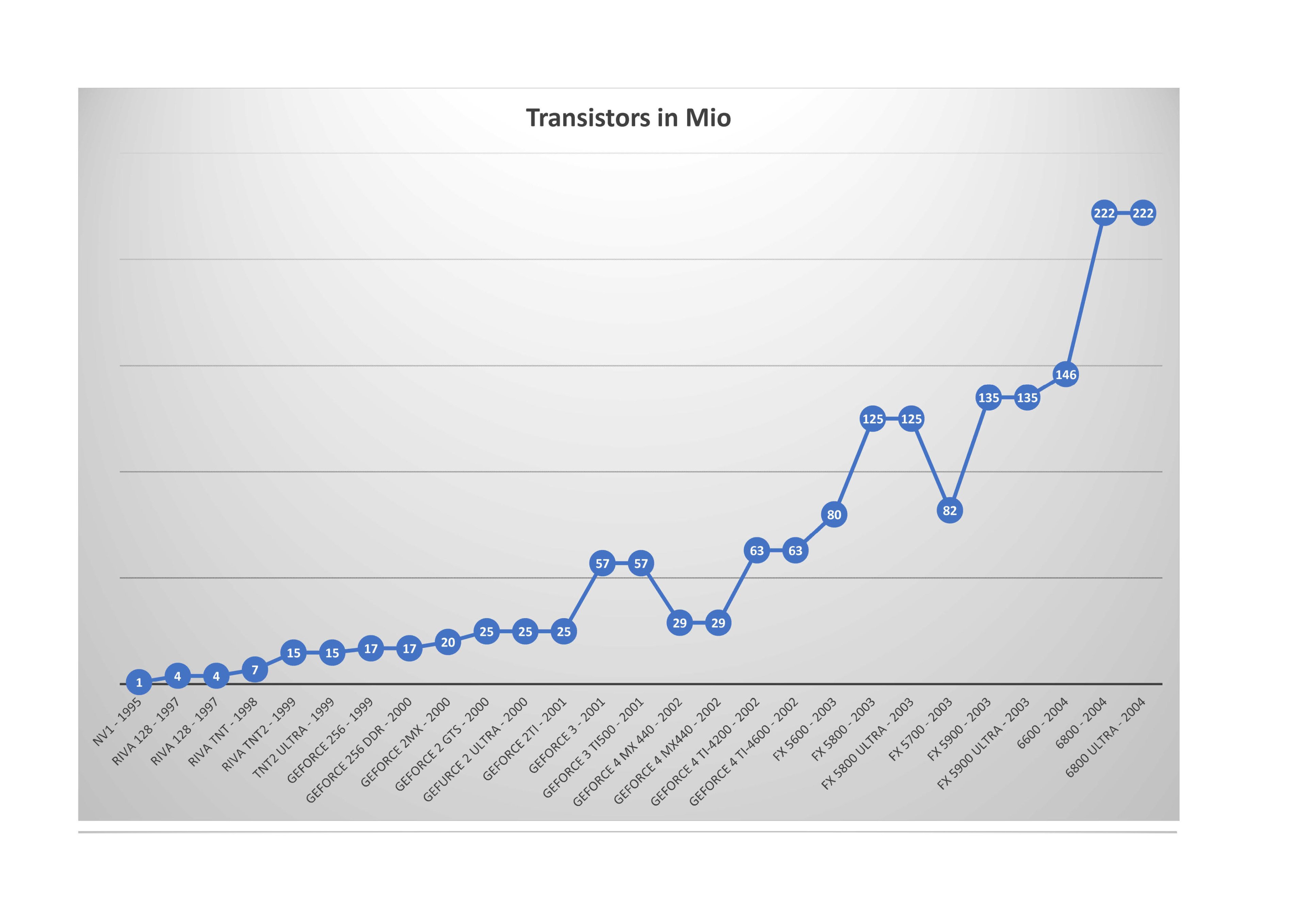

Während die ersten Geforce Karten noch eine Festverdrahtete Pipeline sowie T&L Einheit nutzten, kam mit der 3er Serie und DirectX 8 programmierbare Pixel und Vertex Shader auf. Mit der Geforce 4 Ti Reihe setzte nVidia dann lange den Defakto Standard bei der Geschwindigkeit, dem sich ATi und Matrox unterordnen mussten. Einstige "Größen" wie 3dfx, S3 und Imagination mit den Kyro Chips waren da bereits fast verschwunden.

Der erste Dx9 Grafikchip aus diesem Hause sollte Kinofeeling nach Hause bringen, was auch der Namenszusatz FX = Effekte suggerierte, dazu arbeitete ein ehemaliges 3dfx Team an diesem Boliden.

Enorme 400 MHz wollten die eigene Geforce 4 Ti Reihe hinter sich lassen, verpackt im modernsten Fertigungsprozess und doppelter Transistorzahl, zusammen mit DDR2.

Hausgemachte Probleme

Doch ATi kam dazwischen und warf die Pläne Nvidias gehörig über den Haufen. Die Radeon 9700 Pro schlug ein, wie zuletzt der Voodoo Graphics und deklassierte die eigenen Vorgänger, wie auch die der Konkurrenz von Nvidia und Matrox.

Um der Laage wieder Herr zu werden, steigerten die Ingenieure beim nv30 den Chip- und Speichertakt um 100 MHz. Jedoch war die Yield bei TSMC gering und es kam immer wieder zu Verzögerungen, bedingt durch den neuen 0,13 µm Prozess in Verbindung mit Kupfer Layern, dem hohen Takt von 500 MHz und die Transistor Anzahl von 125 Millionen.

Das Kühlkonzept

Das Kühlkonzept geriet ebenfalls an seine Grenzen, und machte die Geforce FX zur ersten Consumer Karte mit einem Dual-Slot Design. Schon bei 400 MHz Speichertakt konnte der User sich an den Modulen die Finger verbrennen, trotz Kühlblech. Und der Radiallüfter gehörte nicht zur leisen Sorte, bei geringer Last lief er hochfrequent und bei steigender Temperatur ging es immer mehr Richtung Flugzeugturbine.

Angenehmes Spielen funktionierte im Test nur mit Headset und aufgedrehter Lautstärke. Die kleine Radeon 9700 war zwar hörbar, aber das ging damals in der Geräuschkulisse unter (beide Grafikkarten waren zu Testzwecken im selben System verbaut).

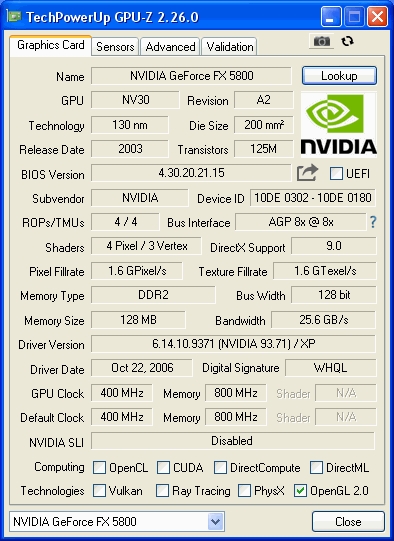

Die Speicherbandbreite ist nur halb so hoch, GPU-Z gibt hier falsche Werte aus.

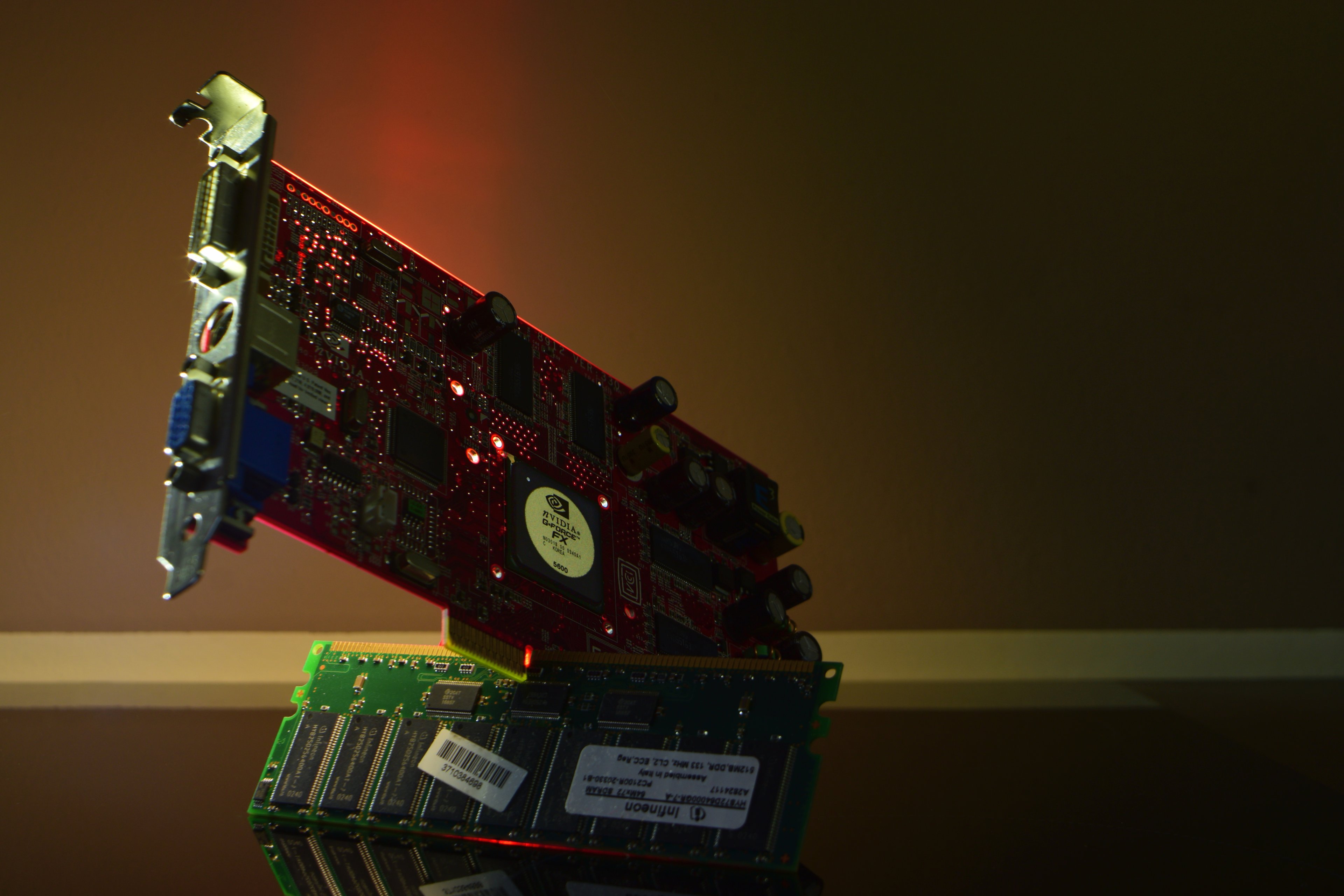

Beide Bilder sind von @wickedgonewild

Selbst die CB Redaktion glaubte nicht, das dieses Kühlkonzept Schule macht:

So wurde aus der Ultra und dem Dual-Slot Kühler FlowFX „der Föhn“, das heißt aber nicht, das die Non-Ultra Variante sich hinter dieser verstecken musste. Auf der kleinen Version FX 5600 zeigten sich wiederum die Vorteile des modernen Fertigungsprozesses. So galt die MSI Karte als leise und angenehm, obwohl gegenüber dem Vorgänger 17 Millionen zusätzliche Transistoren verbaut waren und auch der Chiptakt um 75 MHz höher ausfiel. Dadurch konnte MSI das gleiche Kühlsystem wie auf der Geforce 4 Ti 4200 nutzen.

Die Kosten

Stolze 400 Mio. $ kostete Nvidia die Entwicklung, inklusive Verspätungen und Anpassungen am Design, ATi fuhr mit 300 Mio. günstiger und auch erfolgreicher. Trotz dieser hohen Summe und dem Fortschrittlichen Design mussten die Techniker Kompromisse eingehen, um die Leistung der Vorgänger zu erreichen. So wurde einer der Pixel Prozessoren gestrichen und durch Register Combiner ersetzt, um die Leistung einer Geforce 4 Ti zu erreichen. Und Microsofts Entscheidung, das sich Dx9 an ATi’s Chip orientiert, trug nicht gerade bei, den nv30 optimal auszunutzen. Während der R300 FP24 bot, was der Mindeststandard des neuen DirectX wurde, konnte der nv30 nur FP16 oder FP32. Ob Microsoft diese Entscheidung wegen dem unprofitablen XBox Deal tat, wurde von selbigen bestritten.

So lief dann Halo, ein eigentlich auf Nvidia Chips zugeschnittenes Spiel auch auf der Radeon 9700 flüssiger, immerhin das Vorzeigeprojekt für die XBox, mit ihrem Geforce 3 GPU Kern.

Alt gegen Neu

Neu gegen Alt

Optisch wurde Halo erst viele Jahre später aufgefrischt und läuft mittlerweile auf den meisten iGPUs problemlos.

Das Erbe

Nvidia verbesserte den Chip und schob den nv35 rasch nach. Den nv30 dagegen konnten Interessierte nur kurz kaufen und dann auch nur im Referenz Design, Hersteller eigene Varianten sind nicht weiter bekannt. Der nv35, aka FX 5900, wurde jetzt mit einem 256 Bit Speicherinterface ausgestattet und damit der Größte Flaschenhals der Architektur beseitigt. Techniken, wie die Vertex Shader, die mit 1024 Befehlsslots sehr viel boten, waren aber immer noch eher für das Offline-Rendering gedacht und nicht für die Ausgabe in Realtime, wie es Games nun einmal benötigen. Es sollte dann bis zum nv40 dauern, bis die Radeons wieder in Schlagdistanz lagen.

GeForce FX (archive.org) Ein Kommentar von Carsten Spille zum nv30: Ist CineFX ein Fehlschlag oder gar Fiasko?

Teil 1: Die Bitboys

Teil als Artikel Update: intels i740, Timna und AIMM

Teil 2: nVidias nv1

Einleitung

In den ersten Teilen wurden die Bitboys und Ihre Pyramid3D und Glaze3D beleuchtet.

Sowie intels i740, der antrat, 3dfx und nVidia herauszufordern und leider komplett gescheitert ist. Immerhin kamen 50 verschiedene Designs auf den Markt, mehr als bei der aktuellen DG1 und DG2 Generation:

Foto @kryzs

Das AIMM war dann ein 4 MB Modul, welches in den AGP Steckplatz eingesetzt wurde, um der in die Northbridge integrierten Grafik mehr Speicher für den Z-Buffer zur Verfügung zu stellen.

Nach dem nv1 machen wir mit dem nv30 weiter, aka der Föhn.

Nvidias nv30

Während die ersten Geforce Karten noch eine Festverdrahtete Pipeline sowie T&L Einheit nutzten, kam mit der 3er Serie und DirectX 8 programmierbare Pixel und Vertex Shader auf. Mit der Geforce 4 Ti Reihe setzte nVidia dann lange den Defakto Standard bei der Geschwindigkeit, dem sich ATi und Matrox unterordnen mussten. Einstige "Größen" wie 3dfx, S3 und Imagination mit den Kyro Chips waren da bereits fast verschwunden.

Der erste Dx9 Grafikchip aus diesem Hause sollte Kinofeeling nach Hause bringen, was auch der Namenszusatz FX = Effekte suggerierte, dazu arbeitete ein ehemaliges 3dfx Team an diesem Boliden.

Enorme 400 MHz wollten die eigene Geforce 4 Ti Reihe hinter sich lassen, verpackt im modernsten Fertigungsprozess und doppelter Transistorzahl, zusammen mit DDR2.

Hausgemachte Probleme

Doch ATi kam dazwischen und warf die Pläne Nvidias gehörig über den Haufen. Die Radeon 9700 Pro schlug ein, wie zuletzt der Voodoo Graphics und deklassierte die eigenen Vorgänger, wie auch die der Konkurrenz von Nvidia und Matrox.

Um der Laage wieder Herr zu werden, steigerten die Ingenieure beim nv30 den Chip- und Speichertakt um 100 MHz. Jedoch war die Yield bei TSMC gering und es kam immer wieder zu Verzögerungen, bedingt durch den neuen 0,13 µm Prozess in Verbindung mit Kupfer Layern, dem hohen Takt von 500 MHz und die Transistor Anzahl von 125 Millionen.

Das Kühlkonzept

Das Kühlkonzept geriet ebenfalls an seine Grenzen, und machte die Geforce FX zur ersten Consumer Karte mit einem Dual-Slot Design. Schon bei 400 MHz Speichertakt konnte der User sich an den Modulen die Finger verbrennen, trotz Kühlblech. Und der Radiallüfter gehörte nicht zur leisen Sorte, bei geringer Last lief er hochfrequent und bei steigender Temperatur ging es immer mehr Richtung Flugzeugturbine.

Angenehmes Spielen funktionierte im Test nur mit Headset und aufgedrehter Lautstärke. Die kleine Radeon 9700 war zwar hörbar, aber das ging damals in der Geräuschkulisse unter (beide Grafikkarten waren zu Testzwecken im selben System verbaut).

Die Speicherbandbreite ist nur halb so hoch, GPU-Z gibt hier falsche Werte aus.

Beide Bilder sind von @wickedgonewild

Selbst die CB Redaktion glaubte nicht, das dieses Kühlkonzept Schule macht:

Zitat Carsten Spille: Ob der Kühler auf der Referenzkarte so auch in der Serienfertigung zum Einsatz kommt, darf bezweifelt werden, da es solcherlei Dual-Slot-Karten bislang nur im professionellen Umfeld gab. Eher wahrscheinlich scheint dagegen, dass das Referenzsample noch aus Stabililtätsgründen mit so einem Monstrum betrieben werden musste.

So wurde aus der Ultra und dem Dual-Slot Kühler FlowFX „der Föhn“, das heißt aber nicht, das die Non-Ultra Variante sich hinter dieser verstecken musste. Auf der kleinen Version FX 5600 zeigten sich wiederum die Vorteile des modernen Fertigungsprozesses. So galt die MSI Karte als leise und angenehm, obwohl gegenüber dem Vorgänger 17 Millionen zusätzliche Transistoren verbaut waren und auch der Chiptakt um 75 MHz höher ausfiel. Dadurch konnte MSI das gleiche Kühlsystem wie auf der Geforce 4 Ti 4200 nutzen.

Die Kosten

Stolze 400 Mio. $ kostete Nvidia die Entwicklung, inklusive Verspätungen und Anpassungen am Design, ATi fuhr mit 300 Mio. günstiger und auch erfolgreicher. Trotz dieser hohen Summe und dem Fortschrittlichen Design mussten die Techniker Kompromisse eingehen, um die Leistung der Vorgänger zu erreichen. So wurde einer der Pixel Prozessoren gestrichen und durch Register Combiner ersetzt, um die Leistung einer Geforce 4 Ti zu erreichen. Und Microsofts Entscheidung, das sich Dx9 an ATi’s Chip orientiert, trug nicht gerade bei, den nv30 optimal auszunutzen. Während der R300 FP24 bot, was der Mindeststandard des neuen DirectX wurde, konnte der nv30 nur FP16 oder FP32. Ob Microsoft diese Entscheidung wegen dem unprofitablen XBox Deal tat, wurde von selbigen bestritten.

So lief dann Halo, ein eigentlich auf Nvidia Chips zugeschnittenes Spiel auch auf der Radeon 9700 flüssiger, immerhin das Vorzeigeprojekt für die XBox, mit ihrem Geforce 3 GPU Kern.

Alt gegen Neu

Neu gegen Alt

Optisch wurde Halo erst viele Jahre später aufgefrischt und läuft mittlerweile auf den meisten iGPUs problemlos.

Das Erbe

Nvidia verbesserte den Chip und schob den nv35 rasch nach. Den nv30 dagegen konnten Interessierte nur kurz kaufen und dann auch nur im Referenz Design, Hersteller eigene Varianten sind nicht weiter bekannt. Der nv35, aka FX 5900, wurde jetzt mit einem 256 Bit Speicherinterface ausgestattet und damit der Größte Flaschenhals der Architektur beseitigt. Techniken, wie die Vertex Shader, die mit 1024 Befehlsslots sehr viel boten, waren aber immer noch eher für das Offline-Rendering gedacht und nicht für die Ausgabe in Realtime, wie es Games nun einmal benötigen. Es sollte dann bis zum nv40 dauern, bis die Radeons wieder in Schlagdistanz lagen.

GeForce FX (archive.org) Ein Kommentar von Carsten Spille zum nv30: Ist CineFX ein Fehlschlag oder gar Fiasko?